Die Fähigkeit, den Ort eines Fotos oder Bildes allein anhand visueller Hinweise korrekt zu bestimmen, stellt seit jeher eine herausfordernde Aufgabe dar. Besonders in Bereichen wie der investigativen Recherche, der Kriminalistik oder im Journalismus ist die Geolokalisierung von großem Wert, um Herkunft und Kontext von Bildern zu verifizieren. Große Sprachmodelle (Large Language Models, kurz LLMs) wie ChatGPT, Gemini oder Claude entwickeln sich rasant weiter, doch stellen sich viele die Frage: Haben diese Modelle die Geolokalisierung bereits gemeistert? Ein aktueller Vergleichstest gibt hierzu aufschlussreiche Antworten. Eine umfangreiche Untersuchung von Bellingcat im Jahr 2025 stellte insgesamt 20 verschiedene LLMs von Anbietern wie OpenAI, Google, Anthropic, Mistral und xAI auf die Probe. Dabei wurden 25 Bilder verwendet, die aus unterschiedlichen Umgebungen und Kontinenten stammten, von urbanen Szenen bis hin zu ländlichen Landschaften.

Besonders wichtig war dabei, dass die Fotos unveröffentlicht und frei von Metadaten waren, um eine echte Herausforderung für die Modelle zu gewährleisten. Die Ergebnisse sind differenziert. Während einige LLMs bei bestimmten Bildern herausragende Leistungen zeigten, auch über traditionelle Werkzeuge wie Google Lens hinaus, zeigten andere Schwierigkeiten und sogar Fehlinterpretationen. Die größte Überraschung war, dass nicht alle LLMs besser als klassische Bildersuchdienste aufgestellt waren. Besonders die Modelle von OpenAI, vor allem Versionen von ChatGPT, schnitten im Test am besten ab und konnten oft Details erkennen, die anderen Modellen entgingen.

Eines der Schlüsselexemplare war ein Foto von einer verschneiten Gebirgsstraße in Japan. Hier zeigte sich, wie wichtig es ist, kleine visuelle Hinweise wie Architektur, Beschilderung oder Straßengestaltung zu analysieren. Während Googles Modell Gemini 2.5 Pro nur vage Vermutungen äußerte und mehrere Kontinente nannte, gelang es ChatGPT o3, den Bildort auf eine Region in Zentral-Honshu, Japan, einzugrenzen – eine extrem präzise Leistung, die auf der Erkennung japanischer Schriftzeichen und typischer Straßenbarrieren basierte. Eine andere Szene, ein unspektakuläres Feld auf der Schweizer Platte nahe Zürich, stellte eine besondere Herausforderung dar, da kaum markante Anhaltspunkte vorhanden waren.

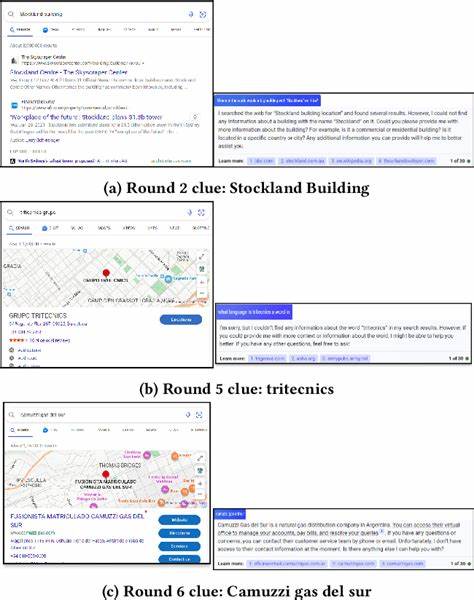

Auch hier erreichten Varianten von ChatGPT exzellente Resultate und konnten die Jura-Voralpen identifizieren, während andere Modelle sich mit breiten, ungenauen Angaben zufriedengaben. Interessanterweise führte die Assoziation von Benutzerinformationen in manchen Fällen zu falschen Rückschlüssen. So vermutete ein Modell (Grok DeepSearch) eine niederländische Herkunft aufgrund des Namens des Quellenkontos, obwohl das Bild klar in der Schweiz aufgenommen wurde. Städtische Szenen zeigten besonders eindrucksvoll, wie gut LLMs subtile Details aufgreifen können; ein enger Singapurer Hinterhof etwa wurde von ChatGPT nicht nur als Standort erkannt, sondern das Modell konnte sogar eine genaue Adresse aus kleinsten Elementen wie Beschriftungen auf Briefkästen herauslesen. Google Lens dagegen lieferte oft vielfältige Ergebnisse, die zwar das Land oder die Stadt trafen, aber selten die exakte Adresse.

Andere Modelle scheiterten teils am Entziffern von Schriftzeichen oder interpretierten diese falsch und verwiesen auf Thailand oder Malaysia. Schwieriger waren Fotos, die temporäre Elemente oder weniger bekannte Ortschaften zeigten. Ein Bild von Playa Longosta an der Pazifikküste Costa Ricas wurde von den meisten Modellen nur ungefähr lokalisiert, wobei einige entweder gänzlich richtungslos blieben oder falsche Kontinente angaben. ChatGPT und xAI's Grok konnten hier relativ nahe an den exakten Ort herankommen, während Google und Anthropic-Modelle oft scheiterten. Die Analyse offenbart eine weitere Herausforderung: Die Modelle neigen zu sogenannten Halluzinationen, d.

h. sie liefern überzeugend klingende, aber falsche oder erfundene Ortsangaben. Dieses Problem tritt verstärkt bei vielfältigen, sich ändernden oder wenig dokumentierten Landschaften auf. Ein Beispiel war ein Foto mit einem saisonal aufgestellten Riesenrad an einem Strand, das von manchen Modellen fälschlich mit einem ähnlichen, aber dauerhaft installierten Riesenrad an einem anderen Strand verwechselt wurde. Hier zeigt sich, dass aktuelle LLMs oft auf bekannte, hinterlegte Referenzmuster zurückgreifen und Schwierigkeiten haben, frischere oder temporäre Elemente korrekt zu interpretieren.

Ein weiteres interessantes Erkenntnisfeld betrifft die Nutzung von erweiterten Denkmodi wie „Deep Research“ oder „Extended Thinking“. Erwartungsgemäß führen solche Funktionen nicht zwangsläufig zu besseren Geolokalisierungsergebnissen. Im Gegenteil: Bei Modellen wie Claude und ChatGPT waren diese Modi teilweise sogar kontraproduktiv und resultierten in ungenaueren oder vorsichtigeren Antworten. Generell zeigte sich, dass es beim Geolokalisieren auf eine klare, fokussierte Analyse ankommt und zu viel „Nachdenken“ ohne zusätzlichen Kontext eher irritierend wirkt. Ein nicht zu unterschätzender Vorteil von LLMs im Vergleich zu klassischen Bildersuchmaschinen ist die Fähigkeit, mehrsprachige Informationen zu verarbeiten und zwischen verschiedenen kulturellen und geografischen Kontexten zu wechseln.

Dadurch können Modelle Hinweise in fremden Alphabeten, Vegetationsmustern oder architektonischen Stilen interpretieren, die für reine Suchalgorithmen schwer zugänglich sind. Dennoch bleibt die Geolokalisierung via LLM kein Allheilmittel. Die Modelle benötigen sichtbare, erkennbare Details und scheitern häufig, wenn ein Bild zu allgemein oder generisch ist. Lagerbedingungen wie schlechte Bildqualität, fehlende Kontextelemente oder veränderte Landschaften erschweren die Lokalisierung zusätzlich. Wichtig für reale Anwendungen ist daher der Einsatz von LLMs als Ergänzung zu traditionellen Methoden und menschlichem Expertenwissen.

Zukünftige Entwicklungen versprechen, die Fähigkeiten von LLMs in der Geolokalisierung weiter zu verbessern. Mittlerweile arbeiten viele Entwickler an multimodalen Modellen, die neben Bildern auch Videos und andere Datenformate analysieren können. Videoeingaben beispielsweise enthalten oft deutlich mehr kontextuelle Informationen, die helfen könnten, Bewegungen, Zeitpunkte und spezifische Orte genauer zu bestimmen. Die Herausforderungen bei der Umsetzung liegen allerdings noch in der Integration der Bild- und Textverarbeitung in Echtzeit sowie in der präzisen Erfassung von Koordinaten. Angesichts der Geschwindigkeit, mit der neue Modelle veröffentlicht werden, ist davon auszugehen, dass sich die Leistungsfähigkeit von LLMs bei geographischen Zuordnungen bald nochmals deutlich verbessert.

Die Tatsache, dass bereits heute Modelle wie ChatGPT und Grok teilweise Google Lens übertreffen können, zeigt erhebliche Fortschritte. Für den professionellen Einsatz, beispielsweise in der investigativen Recherche, bleiben weiterhin eine Kombination unterschiedlicher Tools und eine kritische Prüfung der Ergebnisse unerlässlich. Trotz der Limitationen stärken LLMs Forscher laut den Ergebnissen darin, kleinere Details schneller zu erkennen und mit ihrer Sprachkompetenz Hintergrundwissen einzubeziehen. Dadurch lassen sich „versteckte“ Hinweise identifizieren, die menschlichen Nutzern oder traditionellen Suchmaschinen entgehen würden. So kann beispielsweise das Erkennen einer Firmenaufschrift auf einem Lebensretterwesten flussaufwärts zur Identifikation eines Bootsunternehmens und damit zum genauen Standort führen.

Zum Schluss ist auch die Frage der Bias und der Verfügbarkeit von Daten relevant. Die Modelle reagieren oft auf beobachtete Nutzerinformationen, frühere Konversationen oder Social-Media-Daten, was zu einer Verzerrung oder Voreingenommenheit führen kann. Vorsicht ist deshalb geboten, wenn das Modell Rückschlüsse aus Nutzerhistorie zieht oder auf externe Quellen ohne explizite Abfrage zugreift. Zusammenfassend lässt sich sagen, dass große Sprachmodelle die Geolokalisierung zwar noch nicht vollständig gemeistert haben, aber bereits heute ein spannendes Werkzeug darstellen, das traditionelle Bildsuchverfahren sinnvoll ergänzt. Je mehr Kontext und visuelle Details verfügbar sind, desto präziser werden die Ergebnisse.

Während derzeitige und frühere Versionen hinsichtlich Genauigkeit und Zuverlässigkeit variieren, zeigen neuere Modelle wie ChatGPT o3 und o4-mini eine beeindruckende Fähigkeit, subtile Hinweise auszuwerten und genaue Standortbestimmungen abzugeben. Die Zukunft der Geolokalisierung liegt sicherlich in der Kombination von KI-Technologien, menschlichem Fachwissen und multimodalen Analysen.