In der heutigen datengetriebenen Welt stehen Unternehmen vor der Herausforderung, immer größere Datenmengen effizient zu verwalten und abzurufen. Data Lakehouses sind als hybride Architektur entstanden, die die Flexibilität von Data Lakes mit den Verwaltungs- und Optimierungsfunktionen klassischer Data Warehouses verbindet. Doch gerade bei wachsendem Datenvolumen wird die Organisation der Daten zu einem kritischen Faktor für Performance, Skalierbarkeit und Kosteneffizienz. Genau hier setzt Dremio mit seiner Integration von Apache Iceberg Clustering an – einer revolutionären Methode zur Datenanordnung, die das Beste aus beiden Welten ermöglicht. Die grundlegende Problematik vieler traditioneller Ansätze liegt in der Datenpartitionierung.

Partitionierte Tabellen teilen Daten physisch anhand von bestimmten Spalten auf, etwa nach Datum oder Region. Diese Methode ermöglicht Abfrageoptimierungen durch sogenanntes Pruning, bei dem nicht relevante Datenbereiche übersprungen werden können. Trotz dieser Vorteile bringt Partitionierung aber auch Nachteile mit sich – die Granularitätskontrolle ist schwierig und bei zu feingliedriger Partitionierung entstehen zahlreiche kleine Dateien, die das Metadatenmanagement belasten und Performance-Einbußen verursachen. Grobe Partitionierung kann hingegen zu ungleich verteilten Datenmengen führen, bekannt als Daten-Skew, die parallelisierbare Verarbeitung erschwert. In der Praxis ist es daher oft nahezu unmöglich, eine perfekte Partitionierungsstrategie zu entwerfen.

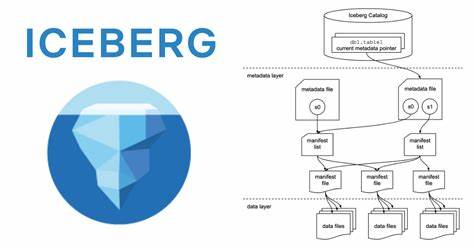

Hier kommt das Konzept des Clusterings ins Spiel, das eine flexible Alternative bietet. Im Gegensatz zur Partitionierung trennt Clustering die Daten nicht physisch in separate Bereiche, sondern ordnet Zeilen basierend auf Ähnlichkeiten der Werte in bestimmten Spalten logisch an. Die Idee ist, ähnliche Daten „nahe beieinander“ zu speichern, sodass Abfragen auch bei fehlender Partitionierung schnell auf relevante Datensätze zugreifen können. Dremios Clustering basiert auf dem Apache Iceberg-Format und nutzt neuartige Algorithmen mathematischer Raumfüllkurven. Insbesondere die sogenannte Z-Ordnung spielt eine zentrale Rolle.

Diese Bit-Zopf-Technik verwebt die Binärdarstellungen mehrerer Spaltenwerte zu einem einzigen Index, der die räumliche Nähe der Werte bestmöglich abbildet. Vergleichbar mit einem Linienzug auf einer Stadtkarte, der Nachbarschaften logisch zusammenhält, sorgen diese Kurven dafür, dass verwandte Daten in nahegelegenen Dateien zusammengefasst werden. Das Ergebnis ist eine Datenanordnung, die traditionelle Probleme wie Partitionsexplosion elegant umgeht. Ohne für jede Wertkombination physische Grenzen setzen zu müssen, lässt sich durch Clustering eine effiziente Datenpruning-Strategie realisieren, die auch bei stark variablen oder ungleich verteilten Daten skaliert. Beispielsweise kann bei saisonalen Spitzen im Verkaufsdatensatz oder sporadischen Ereignissen in Sensordaten der Clustering-Algorithmus die Daten dynamisch so organisieren, dass Belastungsspitzen besser abgesichert werden.

Interessanterweise unterstützt Dremio Clustering derzeit ausschließlich für nicht partitionierte Tabellen. Dies liegt daran, dass Partitionen eine strikte Datenaufteilung vorgeben und innerhalb einer Partition Clustering nicht die gleichen Vorteile bietet wie bei unpartitionierten Daten. Bei starken Daten-Skews empfiehlt sich daher statt einer starren Partitionierung ganz bewusst der Wechsel zu Clustering, um eine gleichmäßigere und effizientere Datenverteilung zu erreichen. Zur Messung der Qualität der Datenorganisation führt Dremio das Konzept der Clustering-Tiefe ein. Diese Kennzahl beschreibt im Wesentlichen, wie stark die Daten in unterschiedlichen Dateien überschneiden.

Je geringer die Überschneidungen und damit die Clustering-Tiefe, desto weniger Dateien müssen bei einer Abfrage gelesen werden – was Performance und Ressourceneffizienz steigert. Besteht Überschneidung, werden betroffene Dateien sukzessive neu organisiert. Der eigentliche Clustering-Prozess läuft dabei inkrementell ab, um Systemressourcen zu schonen. Statt alle Daten auf einmal umzustrukturieren, identifiziert Dremio gezielt jene Bereiche mit hoher Überschneidung und bearbeitet diese Schritt für Schritt. Dabei werden Clustergrößen so angepasst, dass eine optimale Balance zwischen Dateigröße, Verarbeitungslast und Datenlokalität gewahrt bleibt.

Das verhindert Überlastungen und sorgt für eine skalierbare Datenpflege selbst bei Petabyte-großen Datenbeständen. Durch die intelligente Speicherstruktur erhöht sich auch die Effizienz beim Schreiben erheblich. Klassische Partitionierung produziert häufig zu viele kleine Dateien, was nicht nur Speicher, sondern auch das Dateimanagement belastet. Dremios Ansatz gruppiert die Daten stattdessen dynamisch in ähnlich großen Clustern, die sich gut parallel verarbeiten lassen. So sind sowohl Schreib- als auch Leseoperationen optimal verteilt und skaliert.

Auf der Leseseite profitieren Anwendungen unmittelbar von der geordneten Datenstruktur. Bereits vor der eigentlichen Datenabfrage nutzt Dremio Manifest-Dateien, um ganze Datenbereiche schnell auszuschließen. Konkret bedeutet das, dass bei einer Abfrage beispielsweise nach Bestellungen eines bestimmten Jahres nur die Dateien geöffnet werden, die dieses Jahr enthalten. Darüber hinaus wird innerhalb der Parquet-Dateien auf Row-Group-Ebene geprunt – also bereits auf kleinste Datenschichten zugegriffen, um unnötige I/O-Operationen zu vermeiden. Dies führt zu deutlich beschleunigten Abfragen und reduziertem Ressourcenverbrauch.

Doch wann lohnt sich der Einsatz von Dremios Clustering? Grundsätzlich entfaltet die Technologie ihr volles Potenzial vor allem bei großen, leseintensiven Datensätzen, bei denen immer wieder ähnliche Filterkriterien angewandt werden. Perfekt geeignet sind Szenarien, in denen Abfragen häufig auf wenige Spalten zugreifen, wie etwa Jahr, Region oder Kundennummer. In solchen Fällen ermöglicht Clustering eine signifikante Reduktion der gescannten Datenmengen und damit eine enorme Performancesteigerung. Bei stark write-intensiven Workloads und sich ständig ändernden Daten ist jedoch Vorsicht geboten. Clustering-Layouts können im Laufe der Zeit degradieren, womit die Vorteile verloren gehen.

Regelmäßiges Reclustering ist notwendig, um die optimierte Datenstruktur zu erhalten. Dremios inkrementelle Strategie minimiert zwar den Pflegeaufwand, doch sollten Nutzer die Kosten von Reclustering gegen die Gewinne abwägen. Die Auswahl der richtigen Clustering-Spalten ist ein weiteres zentrales Element für Erfolg. Dabei sollten vor allem Spalten gewählt werden, die häufig in WHERE-Bedingungen oder für Join-Operationen verwendet werden. Wichtig ist es zudem, die Kardinalität der Spalten im Blick zu behalten: Zu wenige unterschiedliche Werte bieten kaum Filtervorteile, zu viele können die Breite der Datenstruktur dominieren.

Die ideale Wahl sind stabile, häufig gefilterte Spalten mit moderater bis hoher Vielfalt, wie etwa Kunden-IDs oder Zeitstempelbereiche. Dremio empfiehlt, sich auf maximal drei Clustering-Schlüssel zu konzentrieren, um Komplexität zu reduzieren und die Performance zu maximieren. Da die Abfrageprofile sich mit der Zeit ändern können, ist ein regelmäßiges Monitoring und Anpassen der Clustering-Strategie unerlässlich, um langfristig Höchstleistungen zu sichern. Dank dieser durchdachten technologischen Fundamente positioniert sich Dremios Apache Iceberg Clustering als leistungsstarkes Werkzeug im modernen Datenmanagement. Es ermöglicht Unternehmen, riesige Datensätze effizient, flexibel und kostengünstig zu organisieren – ohne die typischen Zwänge traditioneller Partitionierungen.

Die Kombination aus innovativen Algorithmen, intelligentem inkrementellen Prozess und Fokus auf Datenlokalität sorgt für ein robustes Ökosystem, das sich hervorragend in skalierbare Lakehouse-Plattformen einfügt. Unternehmen, die großen Wert auf schnelle, zuverlässige Datenabfragen legen, profitieren von diesem Ansatz erheblich. Durch reduzierte Abfragezeiten und geringeren Ressourcenverbrauch werden nicht nur Kosten gesenkt, sondern die Agilität im Umgang mit Daten erheblich gesteigert. Gleichzeitig schafft Dremio die Voraussetzungen, auch in Zukunft mit weiter wachsenden Datenmengen performant umzugehen. Zusammenfassend lässt sich sagen, dass Dremios Apache Iceberg Clustering eine innovative Antwort auf die Herausforderungen moderner Datenarchitekturen ist.

Es revolutioniert die Art und Weise, wie große Datenmengen logisch strukturiert und verarbeitet werden, indem es die Vorteile von Partitionierung und Flexibilität des Clustering vereint. Für Organisationen, die ihr Data Lakehouse fit für die Zukunft machen wollen, stellt diese Technologie einen entscheidenden Wettbewerbsvorteil dar.