Künstliche Intelligenz entwickelt sich rasant und beeinflusst nahezu alle Branchen. Besonders im Bereich der großen Sprachmodelle (Large Language Models, LLMs) entstehen täglich Millionen von Anfragen und Prompts, die enorme Kosten verursachen und gleichzeitig Risiken in Sachen Compliance mit sich bringen. Angesichts der sich schnell verändernden Landschaft sind Unternehmen und Entwickler gefordert, effiziente Lösungen zu finden, die nicht nur die Kosten für den Einsatz von KI reduzieren, sondern auch die Qualität der erzeugten Antworten verbessern und zugleich rechtliche sowie ethische Anforderungen erfüllen. Eine revolutionäre Antwort auf diese Herausforderung ist die Entwicklung einer umfassenden Full-Stack LLM Prompt Efficiency Suite, die genau diese Bedürfnisse adressiert und AI-Entwickler bei der Steuerung und Optimierung ihrer Prompts unterstützt. Der zunehmende Gebrauch von KI-Anwendungen wie Chatbots, automatischen Zusammenfassern, Code-Assistenten und virtuellen Agenten bedeutet, dass Organisationen tagtäglich riesige Mengen an Text generieren.

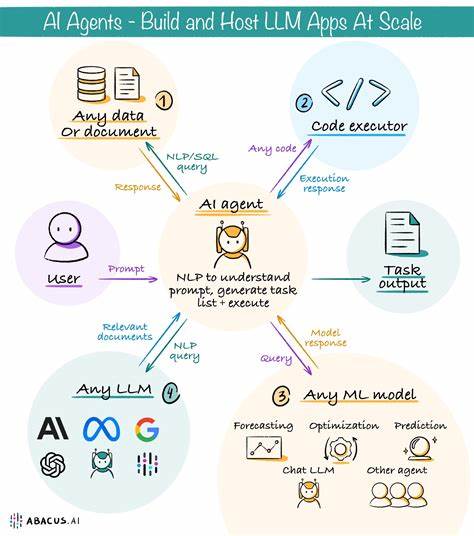

Jede zusätzliche, nicht effiziente Textzeile treibt die Token-Kosten in die Höhe und führt zu einem schnell wachsenden Overhead, der langfristig die Budgets strapaziert. Die Bedeutung von optimierten Prompts wird somit von bloßer Effizienz zu einem strategischen Faktor, der den Erfolg ganzer KI-Projekte maßgeblich beeinflusst. Die Full-Stack LLM Prompt Efficiency Suite setzt genau an diesem Punkt an. Sie fungiert als Plattform, die nicht nur Prompts analysiert und optimiert, sondern diese auch verwaltet, transformiert und validiert. Entwickler können so durch umfassende Funktionen die Token-Nutzung reduzieren, ohne dabei an Qualität einzubüßen.

Die Suite ist darauf ausgelegt, verschiedene KI-Modelle und APIs zu unterstützen und übermittelt die erforderlichen Optimierungen automatisch – ein wichtiger Vorteil in einer Zeit, in der Multi-Modell-Workflows zunehmend an Bedeutung gewinnen. Ein besonderes Highlight der Suite ist der Domain-aware Trimmer, der mithilfe weitreichender Textanalyseverfahren wie TF-IDF-Bewertung und benutzerdefinierten Wörterbüchern präzise irrelevante Inhalte entfernt und dabei sicherstellt, dass wichtige Begriffe und korrekter Syntax erhalten bleiben. Diese gezielte Komprimierung reduziert nicht nur unnötige Token, sondern verbessert auch die Reaktionsgeschwindigkeit der Modelle. Darüber hinaus stehen Werkzeuge zur Verfügung, die nahtlos in CI/CD-Pipelines integriert werden können. Diese ermöglichen es, bereits während der Entwicklungsphase Token-Budgets zu überprüfen und sicherzustellen, dass für jeden Prompt Compliance-Anforderungen eingehalten werden.

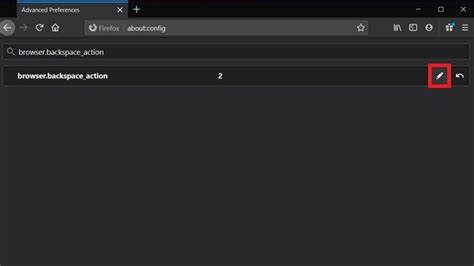

Pull-Request-Hooks und CLI-Plugins bieten automatisierte Prüfungen mit übersichtlich aufbereiteten Differenzberichten, was den Arbeitsablauf erheblich erleichtert und Fehlerquellen minimiert. Ein weiteres innovatives Feature ist das Echtzeit-Tracking der Token-Nutzung. Eingebettete Hooks sammeln Metriken direkt bei jedem API-Aufruf und alarmieren die Verantwortlichen bei Schwellenüberschreitungen oder plötzlichen Nutzungsanstiegen. Die Integration mit Monitoring-Tools wie Prometheus sorgt dafür, dass Verantwortliche jederzeit den Überblick behalten und schnell reagieren können. Dies trägt entscheidend dazu bei, Kostenexplosionen durch unvorhergesehene Nutzungsspitzen zu vermeiden.

Auf organisatorischer Ebene unterstützt die Suite auch großflächige Optimierungen. Mit dem Batch & Bulk Optimizer lassen sich komplette Repositorys durchsuchen, um redundante Phrasen zu erkennen und durch Makros zu ersetzen. Diese zentral verwalteten Makros fördern eine konsistente Nutzung von Begriffen und Formulierungen, was nicht nur die Qualität der Prompts erhöht, sondern auch die Wartbarkeit von KI-Anwendungen verbessert. Die Kompatibilität mit verschiedenen KI-Modellen ist ein weiterer wichtiger Aspekt. Die Cross-model Prompt Translator-Funktion ermöglicht eine automatische Anpassung von Prompts an unterschiedliche LLM-APIs, wobei parameterabhängige Änderungen und leichte Kürzungen berücksichtigt werden.

Dies erleichtert den Umstieg von einem Modell zum anderen und fördert die Flexibilität bei der Modellauswahl – ein entscheidender Vorteil im hart umkämpften Markt der KI-Entwicklung. Eine adaptive Schicht für die Orchestrierung erlaubt es, Prompts dynamisch auf Basis von Kosten, Latenzzeiten und Genauigkeit zu routen. Dabei werden Regeln oder selbstlernende Politiken angewandt, die durch kontinuierlich gesammelte Telemetriedaten unterstützt werden. Diese Intelligenz stellt sicher, dass optimale Ergebnisse erzielt und Ressourcen bestmöglich genutzt werden. Nicht zu vergessen ist die Integration von Telemetrie-Möglichkeiten, die Metriken wie Token-Nutzung, Latenz und Qualität der erzeugten Antworten erfassen.

Die gesammelten Daten speisen ein Benchmarking-System, das erfolgreiche Prompts identifiziert und eine Art Bestenliste erstellt. So können Entwickler gezielt von den effektivsten Formulierungen lernen und ihre eigene Arbeit kontinuierlich verbessern. Neben all diesen technischen Innovationen legt die Suite besonderen Wert auf Zugänglichkeit und Flexibilität. API-Zugänge sowie Command-Line-Interface-Tools erlauben eine einfache Integration in bestehende Entwicklungs- und Deployment-Prozesse. Entwickler können die Suite sowohl lokal im Team nutzen als auch in großem Umfang im Unternehmen implementieren, wodurch sich die Suite als strategisches Instrument etabliert, das Effizienz, Skalierbarkeit und Governance vereint.

Die Bedeutung einer solchen Plattform darf im Kontext eines Milliardenmarktes für KI-Lösungen nicht unterschätzt werden. Unternehmen, die den Umgang mit Prompts als entscheidendes Asset begreifen, können bis zu 60 Prozent bei den LLM-Nutzungskosten einsparen, Risiken im Compliance-Bereich minimieren und durch schnellere Entwicklungszyklen Wettbewerbsvorteile gewinnen. Die Prompt Efficiency Suite bietet hierfür ein einzigartiges Lösungspaket, das Prompt Engineering von einer Nebenaufgabe zu einem zentralen Baustein moderner KI-Projekte macht. Für Entwickler bedeutet dies, dass sie sich nicht mehr mit ineffizienten oder inkonsistenten Prompts herumschlagen müssen, sondern über ein intelligentes Tool verfügen, das sie bei jedem Schritt unterstützt. Die Kombination aus Analyse, Optimierung, Verwaltung und übersichtlicher Visualisierung schafft einen Überblick, der bisher so nicht möglich war.

Im Endeffekt trägt diese Lösung dazu bei, die Zukunft der KI praxisnah und nachhaltig zu gestalten. Angesichts der ständig steigenden Bedeutung von KI-Anwendungen ist es unabdingbar, die zugrundeliegenden Ressourcen bestmöglich einzusetzen. Die Full-Stack LLM Prompt Efficiency Suite zeigt eindrucksvoll, wie technologische Innovation und unternehmerisches Denken zusammenkommen, um neue Standards in der KI-Entwicklung zu setzen und dabei Mensch und Maschine gleichermaßen voranzubringen.