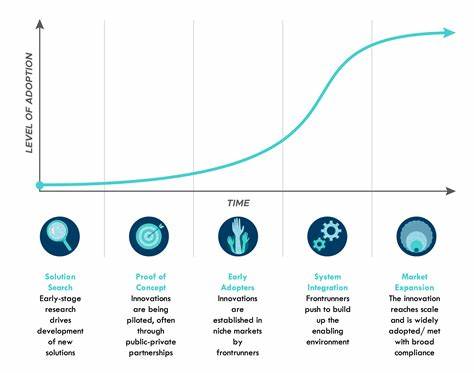

Die Entwicklung der künstlichen Intelligenz (KI) verläuft nicht in einem geradlinigen Fortschritt, sondern folgt einem charakteristischen Muster, das man als S-Kurve bezeichnet. Die sogenannte bittere Lektion, ein Begriff geprägt von Richard Sutton, beschreibt die Erkenntnis, dass der größte Fortschritt in der KI durch den Einsatz immer größerer Rechenleistung erzielt wird, anstatt durch das Einbringen menschlichen Wissens. Diese Prinzipien prägen die Dynamik von Innovationen und bieten Einblicke, wie wir in den kommenden Jahren mit der Weiterentwicklung von KI rechnen können. Die S-Kurve ist ein bekanntes Werkzeug, um den Verlauf technologischer Revolutionsschübe zu beschreiben. In der Anfangsphase erfolgt nur ein langsames Wachstum, weil die Möglichkeiten erst verstanden und erschlossen werden müssen.

Steigt die Reife einer Technologie, vollzieht sich eine Phase der rasanten Verbesserung und des exponentiellen Fortschritts. Schließlich erreicht die Entwicklung aber einen Punkt, an dem die Geschwindigkeit abnimmt und sich eine Plateauphase einstellt. Genau dieses Muster begegnet uns immer wieder, wenn wir den Fortschritt von Technologien analysieren – von Transistoren über Flugtechnologie bis hin zu KI-Modellen. In der Welt der KI ist momentan die Phase der schnellen Expansion durch den Einsatz immer größerer Rechenressourcen dominant. Die bittere Lektion zeigt, dass Technologien, die allgemeine und rechenintensive Methoden nutzen, langfristig meist erfolgreicher sind, als jene, die versuchen, menschliches Wissen direkt zu kodieren.

Dies hängt eng mit der fortwährenden Verbesserung der Rechenleistung zusammen, die durch Moore's Gesetz und dessen moderne Interpretationen angetrieben wird. Anstatt spezifische Domänenexpertisen mühselig einzubauen, ermöglicht das Hinzufügen von mehr und effizienterer Rechenkapazität den Algorithmen, selbständig Muster und Zusammenhänge zu erkennen. Die Skalierungsgesetze für neuronale Sprachmodelle belegen diese Entwicklung eindrucksvoll. Studien zeigen, dass durch die Vergrößerung von Modellen, die Erhöhung der Datengrößen und die Verlängerung der Trainingszeit Verbesserungen erreicht werden, die einem robusten Potenzgesetz folgen. Allerdings ist die Beziehung nicht linear – etwa eine Verzehnfachung der Rechenkapazität führt ungefähr zu eineinhalb bis fast zweifachen Leistungsverbesserungen.

Trotz dieser verhältnismäßig kleinen Steigerungen in den Verlustmetriken können kleine numerische Fortschritte zu sprunghaften qualitativen Verbesserungen führen, wie etwa im Bereich der mehrsprachigen Sprachverarbeitung oder im komplexen Dialogverstehen. Dieser mathematische Zusammenhang beschreibt, warum KI-Forscher oft das Gefühl haben, auf einer sich gut verstandenen Kurve zu wandern, obwohl viele Beispiele zeigen, dass die Effekte manchmal überraschend sind. Manche Innovationen entstehen unerwartet, während andere Fortschritte trotz großer Anstrengungen minimal erscheinen. Doch es zeigen sich auch Grenzen – physikalische und ökonomische Barrieren zeichnen sich bereits ab, welche die aktuelle Methodik der Exponentialsteigerung dringend herausfordern. Energetische Grenzen sind eine der größten Herausforderungen.

Moderne GPUs verbrauchen bereits heute deutlich mehr Energie pro Operation als das theoretisch mögliche Minimum, das durch das Landauer-Limit definiert wird. Dieses physikalische Prinzip beschreibt den minimalen Wärmeverlust, der bei irreversiblen Rechenoperationen entsteht. Auch wenn unser heutiges Equipment noch weit vom theoretischen Optimum entfernt ist, ist der Weg zu diesen Effizienzen lang und bietet keine einfachen Lösungen. Zusätzlich wachsen Kosten für Stromversorgung, Kühlung und Vernetzung der Systeme überproportional mit der Rechenleistung – was selbst im wirtschaftlichen Sinne an eine Wand stößt. Auf wirtschaftlicher Ebene mehren sich die Warnsignale.

Um die nächste Generation von KI-Modellen zu trainieren, werden sich Kosten in Milliardenhöhe ansammeln, verbunden mit einem enormen Energiebedarf, der selbst für große Konzerne oder staatliche Institutionen eine gewaltige Herausforderung darstellt. Parallel dazu ist die Herstellung der notwendigen Hardware zunehmend limitiert. Neue Fertigungstechnologien erfordern langwierige Entwicklungszyklen und riesige Kapitalinvestitionen, die nicht beliebig skaliert werden können. Dies bedeutet, dass trotz technischer Verbesserungen und Kostenreduktionen der Expansionsdrang irgendwann durch reale physische und ökonomische Grenzen eingeholt wird. Die Geschichte der Technologieentwicklung zeigt jedoch, dass auf solche Plateaus oft fundamentale Umbrüche folgen.

Beispiele aus der Vergangenheit verdeutlichen, wie scheinbar perfektionierte technische Systeme durch radikale Innovationen abgelöst werden können. Die Ablösung der Röhren durch Transistoren löste eine Revolution in der Elektronik aus, und Plattenschaufel-Flugzeuge verschwanden rasch nach der Erfindung von Strahltriebwerken. Auch in der Fotografie verdrängte die Digitalisierung das klassische Filmmaterial erfolgreich. In der KI könnte der nächste Umbruch genauso disruptiv sein, allerdings vermutlich weniger durch exotische physikalische Entdeckungen, sondern durch algorithmische und architektonische Innovationen. Beispielsweise könnten ganz neue neuronale Netzwerktopologien die heute dominierenden Transformermodelle in den Schatten stellen oder Effizienzsteigerungen durch smartere Lernmethodik, adaptive Sparsamkeit bei der Datenverarbeitung und innovative Selbst-Verbesserungstechniken entstehen.

Darüber hinaus könnte sich die zugrundeliegende Infrastruktur grundlegend wandeln. Optische Computer oder 3D-gestapelte Chips könnten extreme Energieeffizienz und hohe Rechengeschwindigkeiten ermöglichen, die das Skalierungsspiel verändern. Oder es entstehen autonome Forschungsagenten – sogenannte Personoide –, die rund um die Uhr parallel arbeiten und den Entdeckungsprozess dramatisch beschleunigen. Diese autonomen Systeme könnten neue Wege der Innovation erschließen, die unseren menschlichen Maßstäben weit voraus sind. Trotz der Verheißungen einer explosionartigen Intelligenzsteigerung mahnen fundierte physikalische und ökonomische Restriktionen zur Vorsicht.

Die menschliche Intelligenz operiert auf einem energetisch unfassbar effizienten Niveau – weit unterhalb der aktuellen Technologien. Chip-Herstellung bleibt ein aufwendiger Prozess, der durch Investitionszyklen, regulatorische Rahmen und Infrastruktur begrenzt ist. Zudem existieren fundamentale algorithmische Schranken, wie das NP-vollständige Problem, die unvermeidbar bleiben und den Fortschritt bremsen. Wachstum bleibt daher ein Prozess von Sprüngen und Pausen, nicht eine lineare Verteifung ohne Grenzen. Ein virtueller Ausblick auf das Jahr 2032 veranschaulicht die Situation: Ein milliardenschwerer Trainingslauf erbringt lediglich moderate Leistungssteigerungen, während ein autonom arbeitender Forscheragent bislang unbekannte Architekturparadigmen entwickelt, die mit Bruchteilen des Ressourcenaufwands vergleichbare Resultate erzielen.

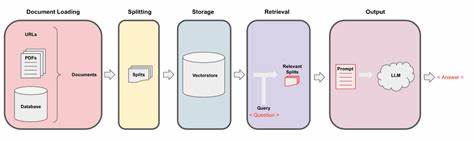

Diese Art von punctuated equilibria, einem Begriff aus der Evolutionsbiologie, veranschaulicht, wie Fortschritt nicht stetig, sondern durch sprunghafte Veränderungen voranschreitet. Für Unternehmen und Entwickler bedeutet dies vor allem, flexibel zu bleiben und nicht ausschließlich auf eine technologische Richtung zu setzen. Anlage von Infrastruktur und Entwicklung von Systemen sollten modular und anpassungsfähig sein, um neue Paradigmen schnell zu integrieren und von plötzlichen Effizienz- oder Leistungsgewinnen profitieren zu können. Dies inkludiert plattformunabhängige Ausführungsumgebungen, Speichertechnologien, die von Vektor- zu Graph- oder Gewichtsräumen wechseln können, sowie hybride Modelle hinsichtlich Regulierung und Skalierung. Die Zukunft der KI wird durch das Ineinandergreifen mehrerer Intelligenzen geprägt sein, nicht durch den Aufstieg eines einzelnen Supercomputers oder einer einzelnen Methode.

S-Kurven bieten ein Rahmenwerk, um diese Veränderungen zu verstehen. Jedes Plateau bietet eine Atempause, in der das mögliche Potenzial für den nächsten Schritt reift. Die bittere Lektion lehrt, dass wir nicht allein auf menschliches Wissen oder lineares Wachstum setzen können, sondern auf den kombinierten Effekt von steigender Rechenleistung, algorithmischen Innovationen und nachhaltiger Infrastrukturentwicklung. Insgesamt stehen wir vor einer spannenden Ära der Technologieentwicklung, in der Wachstum und Grenzen untrennbar verbunden sind. Der Schlüssel zum Erfolg liegt darin, diese Dynamik zu akzeptieren und die Möglichkeit zur Neudefinition von Möglichkeiten rechtzeitig zu erkennen und zu nutzen.

Das Grau in der Mitte der S-Kurve, wie symbolisch in Josef Albers’ Hommage au Carré dargestellt, steht für das Potenzial in der Pause – und repräsentiert die kreative Kraft, die den nächsten Sprung herbeiführen wird.

![Eidophor: 1950's space age video projection technology. [video]](/images/355D98C7-1AE8-4227-A4D4-95C22C5923EB)