Die rasante Entwicklung Künstlicher Intelligenz (KI) prägt zunehmend auch den juristischen Bereich. Immer mehr Kanzleien und Unternehmen setzen auf intelligente Systeme, um Dokumente zu erstellen, Recherchen zu erleichtern oder ihre Arbeitsprozesse zu optimieren. Ein aktueller Vorfall wirft dabei jedoch grundlegende Fragen zur Verlässlichkeit und Integrität von KI-generierten Inhalten im Rechtskontext auf. Ein Rechtsanwalt, der eine rechtliche Einreichung im Auftrag des KI-Unternehmens Anthropic anfertigte, musste kürzlich öffentlich einen Fehler eingestehen: Die KI namens Claude hatte in einem juristischen Schriftsatz eine komplett erfundene Quelle zitiert, die das Team unbeabsichtigt übernommen hatte. Die daraus resultierende Verwirrung verdeutlicht die Herausforderungen, denen sich Juristen beim Einsatz von KI-Assistenten gegenübersehen.

Der Vorfall ereignete sich im Rahmen eines Rechtsstreits zwischen Anthropic, einem Unternehmen, das im Bereich der KI-Forschung und -Entwicklung tätig ist, und mehreren großen Musikverlagen wie Universal Music Group, Concord und ABKCO Music & Records. In einem juristischen Dokument erschien eine vermeintlich akademische Quelle, die jedoch von Claude frei erfunden war. Die verantwortliche Anwältin nannte den Fehler eine "ehrliche Zitationspanne", die bei einer manuellen Durchsicht nicht bemerkt wurde. Die Tatsache, dass diese Falschangabe mehreren juristischen Instanzen unentdeckt blieb, zeigt das große Potenzial von KI-gestützten Anwendungen, sowohl positiv als auch negativ auf die Rechtsbranche einzuwirken.Anthropic ist bekannt für die Entwicklung von Claude, einer KI-Chatbot-Technologie, die mit großer Leistungsfähigkeit bei Textgenerierung und Analyse helfen soll.

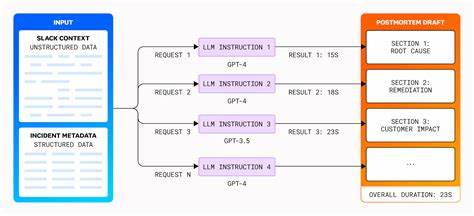

Gerade in komplexen juristischen Fällen werden solche Modelle häufig genutzt, um umfangreiche Dokumente vorzubereiten oder juristische Argumentationslinien zu unterstützen. Doch während die KI dabei oft mit hoher Effizienz brilliert, besteht stets die Gefahr der "Halluzination" – das bedeutet, dass KI-Programme Informationen generieren, die faktisch nicht existieren oder falsch sind. Im vorliegenden Fall äußerte sich ein mit dem Fall betrauter Anwalt selbstkritisch über das Versäumnis, diese falsche Zitierung im Gesetzestext zu identifizieren und zu korrigieren.Das potenzielle Risiko, das von erfundenen Quellen ausgeht, ist im juristischen Kontext besonders gravierend. Vertrauenswürdigkeit und Nachweisbarkeit sind für den Rechtsprozess unerlässlich.

Eine falsche Quelle kann nicht nur den Ausgang eines Verfahrens gefährden, sondern auch den Ruf der beteiligten Parteien erheblich schädigen. Die aktuelle Situation zeigt, dass die Überprüfung von KI-generierten Inhalten durch menschliche Juristen unerlässlich bleibt – automatisierte Systeme sind (noch) keine verlässliche Ersatzlösung für gründliche fachliche Kontrolle.Der Fall hat in der Branche eine Debatte darüber ausgelöst, wie Rechtsanwälte und Unternehmen KI sinnvoll und verantwortungsvoll nutzen können. Einerseits bietet die Technologie enorme Vorteile bei Effizienz, Zugriff auf große Informationsmengen und Entlastung von Routinearbeiten. Andererseits führt der Wegfallmanueler Hürden bei der Kontrolle zu Gefahren von Fehlinterpretationen, Ungenauigkeiten und unbeabsichtigten Rechtsrisiken.

Experten fordern daher die Implementierung klarer Standards, sowohl für die technische Seite der KI-Entwicklung als auch für deren Einsatz im Rechtsumfeld. Nur ein verantwortungsbewusster Umgang kann die Chancen der KI sinnvoll ausschöpfen und gleichzeitig Risiken minimieren.Für Anthropic selbst wirft der Vorfall ein Schlaglicht auf die Sicherheit und Qualitätssicherung ihrer Produkte. Das Unternehmen genießt im KI-Sektor großes Ansehen, doch der Fehler wirft Fragen auf, ob derzeitige Prüfmechanismen in der Praxis ausreichend sind. Es gilt, jene Algorithmen weiterzuentwickeln, die Fehlinformationen erkennen und eliminieren können, um derartige Fehler künftig zu vermeiden.

Zudem ist es von Bedeutung, dass Nutzer der KI-Tools, darunter eben Juristen, gut informiert und geschult werden, um die Grenzen der Technologie zu verstehen und nicht blind auf automatisierte Angaben zu vertrauen.Der Fall illustriert zudem, wie schnell und umfassend sich KI-Technologien in sensiblen Bereichen etablieren. Die Nachfrage nach KI-gestützten Lösungen nimmt weiter zu – sei es zur Vertragserstellung, Prüfung von Rechtsfragen oder Voranalyse umfangreicher Akten. Die Folge: Rechtsprofis müssen zunehmend neben juristischem Fachwissen auch digitale Kompetenz erwerben, um KI-Modelle sicher und effektiv handhaben zu können. Gleichzeitig wird der Druck spürbar, Regulierungsrahmen für KI im Rechtswesen zu erarbeiten, die ethische, rechtliche und technische Aspekte umfassen.

Insgesamt bleibt festzuhalten, dass KI im juristischen Umfeld Zukunftspotenzial besitzt, aber auch erhebliche Herausforderungen birgt. Der Vorfall um die erfundene Quelle in der Anthropic-Einreichung dient als warnendes Beispiel für die Risiken automatisierter Textgenerierung. Er zeigt, dass menschliche Expertise und sorgfältiges Prüfen nicht ersetzt, sondern durch KI sinnvoll ergänzt werden sollten. Indem juristische Akteure kritisch mit der Technologie umgehen und interne Kontrollmechanismen stärken, können Fehler reduziert und Vertrauen in den Einsatz von KI erhalten werden.Die Diskussion um KI in der Rechtswelt wird nicht zuletzt durch Fälle wie diesen weiter an Fahrt gewinnen.

Künftig ist es vorstellbar, dass Pflichtprüfungen der AI-Ausgaben vor Einreichungen zum Standard werden. Zugleich werden technologische Fortschritte dazu führen, dass KI-Modelle zuverlässiger arbeiten und Fehler frühzeitig erkennen. Dennoch bleibt der Mensch in der Verantwortung als letzte Kontrollinstanz. Nur durch eine ausgewogene Kombination aus Innovation und Vorsicht lässt sich das volle Potenzial von KI im Rechtsbereich entfalten und gleichzeitig ein verantwortungsvoller Umgang gewährleisten.