In den letzten Jahren hat die Entwicklung und Verbreitung generativer Modelle im Bereich des maschinellen Lernens eine bemerkenswerte Dynamik erfahren. Anwendungen von Text-zu-Bild-Generatoren, Sprachmodellen und vielen weiteren KI-Systemen haben dazu geführt, dass immer mehr Modelle auf Daten trainiert werden, welche teilweise oder vollständig von vorherigen Generationen synthetisch erstellt wurden. Dieser Prozess hat eine komplexe Rückkopplungsschleife erzeugt, die das traditionelle Verständnis von Datenverteilung und Trainingsqualität herausfordert. Insbesondere ist das Phänomen des sogenannten Modellkollapses in den Fokus der Forschung gerückt: Damit ist eine kritische Verschlechterung der Modellleistung gemeint, die durch die wiederholte Schulung auf synthetischen Daten entsteht. Diese Sorge betrifft nicht nur die praktische Nutzbarkeit von KI-Systemen, sondern auch die theoretischen Grundlagen der Lernverfahren, etwa im Hinblick auf die Konsistenz von Schätzmethoden wie der Maximum-Likelihood-Schätzung (MLE).

Das Thema ist von größtem Interesse, denn es stellt sich die Frage, ob Modelle, die iterativ auf selbst generierten Daten trainiert werden, letztendlich an Qualität verlieren oder ob bestimmte Bedingungen einen solchen Kollaps verhindern können. Generative Modelle und die Rolle synthetischer Daten Generative Modelle dienen dazu, neue Datenproben zu erzeugen, die einer Trainingsdatenverteilung ähneln. Beispielsweise erzeugen Sprachmodelle plausible Texte, Bildgeneratoren erstellen realistische Bilder, und weitere Modelle produzieren vielfältige synthetische Informationsquellen. Durch die rasante Verbesserung dieser Modelle entstehen immer größere Mengen synthetischer Daten, welche ihrerseits als Trainingsinput für nachfolgende Modelle genutzt werden können. Dies kann einerseits die Menge des verfügbaren Trainingsdatensatzes erweitern und so das Lernen verbessern.

Andererseits birgt es die Gefahr, dass Rekursivität und Wiederholungen im Datensatz zu einem Verlust der Diversität und Qualität führen. Das Konzept des Modellkollapses Der Begriff „Modellkollaps“ beschreibt ein Szenario, in dem die Modelle nach mehreren Trainingsrunden mit synthetischen Daten zunehmend schlechter werden. Hierbei kann das Modell anfangen, sich selbst zu reproduzieren oder Fehler und Verzerrungen der Vorgängermodelle zu verstärken. Dies führt oft zu einer schleichenden, dann abrupten Verschlechterung der Qualität – die generierten Daten entfernen sich zunehmend von der realen Welt, und das Modell verliert sowohl hinsichtlich Genauigkeit als auch Generalisierungsfähigkeit an Wert. In der Literatur gibt es unterschiedliche Einschätzungen, wie gravierend dieses Problem tatsächlich ist.

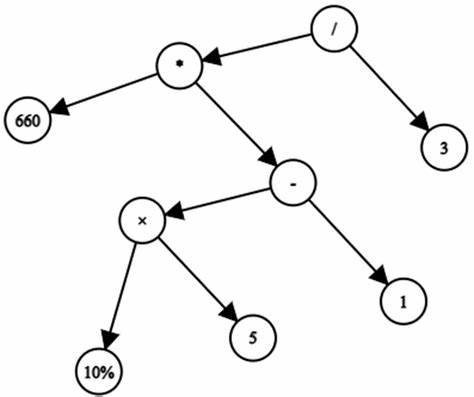

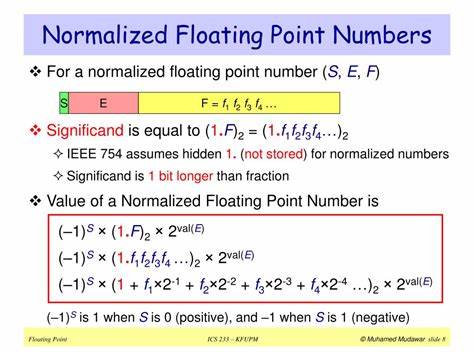

Einige empirische Studien deuten darauf hin, dass Modellkollaps in der Praxis schnell auftreten kann, während andere theoretische Analysen zeigen, dass es unter bestimmten Bedingungen durchaus zu vernachlässigen ist. Deshalb ist die Untersuchung von Modellkollaps in Verbindung mit iterativer Maximum-Likelihood-Schätzung von hoher Bedeutung. Maximum-Likelihood-Schätzung (MLE) und ihre Bedeutung Die Maximum-Likelihood-Schätzung ist eine zentrale Methode in der Statistik und im maschinellen Lernen, um Parameter eines Modells anhand verfügbarer Daten zu bestimmen. Dabei wird die Wahrscheinlichkeitsfunktion maximiert, die beschreibt, mit welcher Wahrscheinlichkeit das Modell die beobachteten Daten erzeugt. Unter geeigneten Voraussetzungen gewährleistet MLE die Konsistenz der Parameter, das heißt, mit hinreichend vielen Daten nähert sich die Schätzung den wahren Modellparametern an.

Iterative MLE in der Praxis bedeutet, dass ein Modell nicht nur einmal, sondern mehrfach nacheinander auf neu generierten oder kombinierter realer und synthetischer Daten trainiert wird. Kritisch dabei ist, wie sich die Schätzungen nach mehreren Iterationen verhalten – bleibt die Schätzung stabil und präzise oder führt die Iteration zu einem Verlust der Modellqualität? Neue theoretische Einblicke in die Konsistenz iterativer MLE Die jüngste Studie, verfasst von Daniel Barzilai und Ohad Shamir, liefert bedeutende Beiträge zur Frage der Stabilität von generativen Modellen bei iterativen Trainingsrunden. Sie untersuchen einen praxisnahen Rahmen, in dem synthetische Daten schrittweise zu einem ursprünglichen Datensatz hinzugefügt werden. Dabei setzen sie auf Annahmen, welche den klassischen asymptotischen Eigenschaften der MLE ähnlich sind, wie zum Beispiel die Existenz eines zugrundeliegenden wahren Verteilungsmodells und die unabhängige Stichprobenannahme. Ein zentrales Ergebnis ihrer Arbeit sind nicht-asymptotische Schranken, die zeigen, dass ein Modellkollaps vermieden werden kann, selbst wenn der Anteil der echten Daten im Mischdatensatz immer kleiner wird und letztlich gegen Null tendiert.

Das bedeutet praktisch, dass die iterative Anwendung von MLE unter gewissen Bedingungen keine schleichende Verschlechterung der Modellqualität verursacht, sondern das Modell weiterhin konsistent bleibt. Allerdings heben die Autoren auch hervor, dass gewisse Voraussetzungen essentiell sind. Ohne diese kann das Modell sehr schnell kollabieren, sogar wenn ursprüngliche echte Daten weiterhin im Trainingsprozess beteiligt sind. Dies widerspricht der weitläufigen Annahme, dass das bloße Vorhandensein echter Daten einen Kollaps verhindern würde. Die Studie liefert damit die ersten rigorosen Beispiele, wie und warum iterative generative Modelle mit akkumulierten synthetischen Daten schnell an Leistungsfähigkeit verlieren können.

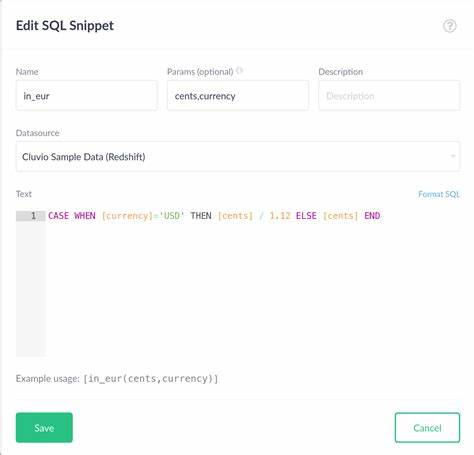

Praktische Implikationen für Forschung und Entwicklung Diese theoretischen Erkenntnisse haben weitreichende Konsequenzen für die Praxis des maschinellen Lernens. Unternehmen und Forschungseinrichtungen, die Generative Adversarial Networks (GANs), Variational Autoencoders (VAEs) oder Transformer-basierte Modelle trainieren und iterativ verbessern wollen, müssen bei der Integration synthetischer Daten in den Trainingsprozess vorsichtig vorgehen. Es reicht nicht aus, synthetische Daten simpel zu generieren und naiv in den Trainingsdatensatz einfließen zu lassen. Stattdessen sollten Bedingungen überprüft werden, die die Konsistenz sicherstellen, etwa die Erhaltung einer ausreichend hohen Diversität und die Kontrolle der Datenqualität. Möglicherweise ist eine strategische Kombination von echten und synthetischen Daten in einem ausgewogenen Mengenverhältnis notwendig, um Modellkollaps zu vermeiden.

Darüber hinaus zeigt die Forschung, dass standardmäßige MLE-basierte Trainingsverfahren nicht unbegrenzt robust gegenüber selbstverstärkenden Fehlern sind. Es kann nötig sein, zusätzliche Regularisierungsmechanismen oder Bewertungsmetriken zu entwickeln, die speziell auf iterative Lernprozesse zugeschnitten sind. Zukunftsperspektiven und Forschungsbedarf Die vorliegenden Ergebnisse bilden einen wichtigen Meilenstein, doch viele Fragen bleiben offen. Es gilt, die Bedingungen, die zur Wahrung der Konsistenz und Vermeidung des Modellkollapses nötig sind, noch genauer zu charakterisieren. Insbesondere ist die Untersuchung verschiedener Modellklassen und komplexerer Szenarien mit Abhängigkeiten zwischen synthetischen und realen Daten essenziell.

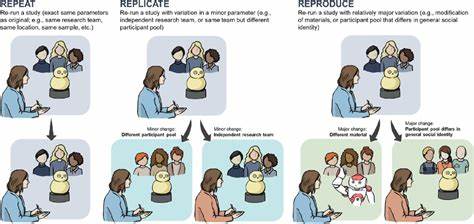

Ferner kann die Verbindung zu anderen Trainingsparadigmen wie selbstüberwachtem Lernen, Transfer Learning oder Reinforcement Learning neue Erkenntnisse bringen. Ebenso sind praktische Experimentreihen notwendig, um die theoretischen Befunde zu validieren und in konkrete Handlungsempfehlungen für Entwickler und Anwender zu übersetzen. Schlussbetrachtung Die iterative Maximum-Likelihood-Schätzung stellt eine vielversprechende Methode dar, um generative Modelle kontinuierlich zu verbessern und an neue Anforderungen anzupassen. Die Angst vor Modellkollaps ist zwar gerechtfertigt, aber nicht zwangsläufig ein unvermeidliches Schicksal. Unter geeigneten Voraussetzungen und mit sorgfältiger Beachtung der Trainingsdatenqualität lässt sich verhindern, dass sich Modelle durch wiederholtes Training auf synthetische Daten selbst destruktiv verändern.

Die Forschung von Barzilai und Shamir zeigt eindrucksvoll, dass eine fundierte theoretische Fundierung notwendig ist, um sichere und leistungsfähige KI-Systeme zu entwickeln, die auch im Angesicht komplexer Trainingseffekte stabil bleiben. Für Praktiker bedeutet dies, dass ein tieferes Verständnis der mathematischen Grundlagen und der Datenflüsse unverzichtbar ist, um zukunftsfähige Lösungen in der generativen Modellierung zu schaffen.