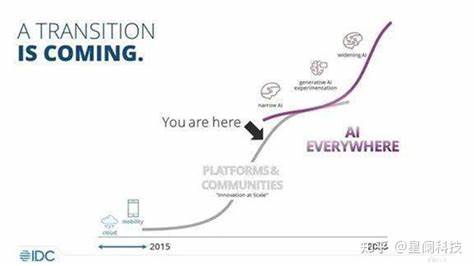

Im Jahr 2025 hat sich die Künstliche Intelligenz in nahezu allen Bereichen unseres Lebens etabliert. Von der automatischen Bildbearbeitung über Sprachassistenten bis hin zu personalisierten Empfehlungen – KI hilft uns, Informationen effizienter aufzubereiten und zu verarbeiten. Dennoch überrascht es viele, dass das automatische Zusammenfassen von Podcasts trotz aller verfügbaren Technologien immer noch nicht flächendeckend perfekt funktioniert oder allgemein zugänglich ist. Warum ist das so? Was sind die technischen, fachlichen und ökonomischen Gründe hierfür? Ein tieferer Blick in diese Thematik zeigt, wie komplex das Problem tatsächlich ist und woran Entwickler und Unternehmen noch arbeiten müssen, damit Podcast-Zusammenfassungen wirklich zur Realität werden können. Podcasts gehören mittlerweile zu den beliebtesten Medienformaten weltweit.

Die Vielfalt an Themen – von Wissenschaft über Politik bis hin zu Unterhaltung – zieht täglich Millionen von Hörern an. Doch die meisten Podcasts sind lang und erfordern eine spürbare Zeitinvestition. Die Nachfrage nach prägnanten Zusammenfassungen wächst permanent, denn nicht jeder hat die Zeit oder Geduld, stundenlange Audioformate komplett anzuhören. Theoretisch bietet sich hier Künstliche Intelligenz als ideale Lösung an, denn moderne Sprachmodelle können den Inhalt transkribieren, analysieren und wesentliche Punkte extrahieren. Allerdings ist diese Idealisierung mit mehreren Herausforderungen konfrontiert.

Zum einen ist die Audioqualität von Podcasts äußerst variabel. Viele Formate werden von Amateuren oder kleinen Teams produziert, die nicht immer eine professionelle Studioausrüstung verwenden. Hintergrundgeräusche, unterschiedlich starke Lautstärken, Akzente, Sprechgeschwindigkeiten und Übersprechungen erschweren die automatische Spracherkennung. Auch bei moderner Spracherkennungssoftware geraten diese Faktoren oft an Grenzen, was ungenaue oder fehlerhafte Transkriptionen nach sich zieht. Ohne eine präzise Grundlage kann natürlich auch keine verlässliche Zusammenfassung erstellt werden.

Ein weiterer wichtiger Aspekt ist die Länge und Struktur eines Podcasts. Podcasts sind nicht immer linear, manche springen zwischen Themen hin und her, nutzen Unterbrechungen, stellen rhetorische Fragen oder arbeiten mit humorvollen Abschweifungen. Dadurch ist es für Algorithmen schwieriger, den Kerninhalt zu erkennen und sinnvoll zu extrahieren. Obwohl KI-Sprachmodelle enorm fortschrittlich sind, fehlt es ihnen oft noch an einem tiefen Verständnis für Kontext, Nuancen und Absicht, die in einem Gespräch mitschwingen. Besonders ironische oder komplex verschachtelte Inhalte werden von KI noch nicht zuverlässig erkannt.

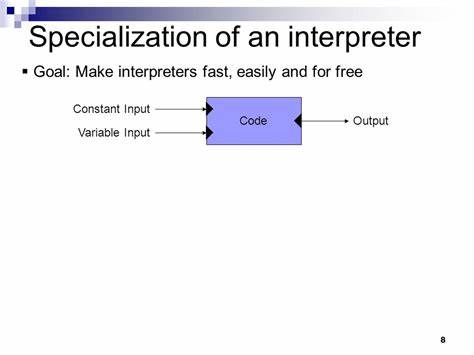

Dazu kommt die Herausforderung der Zusammenfassung selbst. Es gibt verschiedene Arten, Inhalte zusammenzufassen: Extraktive Summaries greifen lediglich einzelne Sätze oder Passagen heraus, während abstraktive Zusammenfassungen den Text in eigenen Worten neu formulieren. Abstraktive Modelle sind deutlich anspruchsvoller und brauchen enorme Rechenleistung sowie große Trainingsdaten, um nicht nur den Inhalt, sondern auch dessen Relevanz und Kausalität richtig zu erfassen. Da Podcasts eine orale und oft informelle Kommunikationsform sind, fehlen standardisierte Strukturen, die das Training dieser Modelle erleichtern würden. Auch Datenschutz und Lizenzfragen spielen eine Rolle.

Viele Podcasts unterliegen Urheberrechten, und Betreiber sind oft vorsichtig, ihre Inhalte automatisch zu transkribieren oder zu analysieren, insbesondere wenn sie für kommerzielle Zwecke genutzt werden sollen. Dies erschwert die Entwicklung und den Einsatz skalierbarer Podcast-Summarizing-Tools, die auf alle Plattformen und Formate zugreifen können. Auf der positiven Seite gibt es bereits eine Reihe von Tools und Projekten, die das Problem adressieren. Dienste wie Notegpt, Snipcast oder Screenapp bieten automatische Podcast-Zusammenfassungen an. Viele dieser Lösungen nutzen Open-Source-Modelle wie Whisper für die Transkription und trainierte Sprachmodelle für die Zusammenfassung.

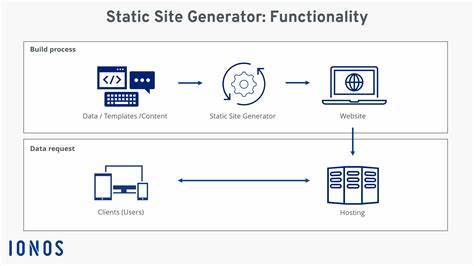

Allerdings sind diese Tools häufig kostenpflichtig, nur eingeschränkt verfügbar oder in ihrer Genauigkeit noch verbesserungswürdig. In der DIY-Community arbeiten Nutzer mit lokal ausführbaren Modellen, die auch offline funktionieren, um Datenschutzbedenken zu umgehen. Dabei werden Systeme wie Silero VAD zur Segmentierung, Whisper für die Transkription und BART oder ähnliche Modelle zur Zusammenfassung kombiniert. Solche Ansätze sind vielversprechend, aber technisch noch nicht für jedermann zugänglich. Die technische Umsetzung erfolgt meist in mehreren Schritten.

Zuerst wird die Audioaufnahme segmentiert, um längere Podcasts in verdauliche Teile zu zerlegen. Danach erfolgt die Spracherkennung, die das gesprochene Wort in Text umwandelt. Im Anschluss wird der Text von einem Sprachmodell ausgewertet und die wichtigsten Passagen ermittelt oder ein zusammenhängender Text verfasst. Jeder dieser Schritte bringt eigene Fehlerquellen und Herausforderungen mit sich, was die Qualität der finalen Zusammenfassung beeinflusst. Trotz aller bisheriger Entwicklungen ist das Potential für Verbesserungen enorm.

KI-Modelle werden mit jeder Generation leistungsfähiger, können besser mit Kontext umgehen und sind zunehmend fähig, multimodale Eingaben – etwa Audio plus Bild oder begleitende Transkripte – zu verarbeiten. Außerdem werden Rechenressourcen günstiger und zugänglicher, was die Anwendung komplexer Algorithmen erleichtert. Künftig könnten völlig automatisierte Podcast-Zusammenfassungen personalisiert auf die Interessen des Hörers zugeschnitten werden, inklusive emotionalem oder thematischem Fokus. Zusammenfassend zeigt sich, dass das Zusammenfassen von Podcasts eine komplexe Herausforderung ist, die technische Hürden, inhaltliche Besonderheiten und rechtliche Rahmenbedingungen vereint. Die Vision eines All-in-One-Tools, das Ihnen alle Podcasts per Knopfdruck in prägnante Zusammenfassungen verwandelt, ist zwar greifbar, aber aktuell noch nicht universell verfügbar.

Jedoch sind die Fortschritte der letzten Jahre vielversprechend, und es ist sehr wahrscheinlich, dass wir in den kommenden Jahren eine neue Generation an KI-gesteuerten Podcast-Analysewerkzeugen erleben werden, die das Hören mit effizienten Zusammenfassungen revolutionieren. Bis dahin ist die Kombination aus moderner Spracherkennung, leistungsfähigen Summarizern und dem menschlichen Faktor der beste Ansatz, um Podcasts zeitsparend zu erfassen. Hörer sollten gespannt bleiben, wie sich dieser Bereich weiterentwickelt – denn in einer Welt, die immer schneller und informationsreicher wird, bleibt die Fähigkeit, das Wesentliche schnell zu erfassen, ein wichtiger Schlüssel zum erfolgreichen Umgang mit Medien.