Datenbanken sind die unsichtbaren Motoren, die den Großteil der heutigen Software zum Laufen bringen. Obwohl Anwender nur einfache Eingabefelder oder Suchfunktionen sehen, verbirgt sich dahinter eine komplexe Welt aus Verbindungen, Datenabfragen, Optimierungen und Speichermechanismen. Gerade bei Anwendungen, die auf PostgreSQL als Datenbank und Django als Webframework basieren, wird deutlich, wie vielschichtig eine scheinbar einfache Datenbankoperation tatsächlich ist. Sich diesen komplexen Vorgang zu erschließen, eröffnet nicht nur neue Perspektiven in puncto Performance, sondern auch Möglichkeiten, Fehlerquellen frühzeitig zu erkennen und zu beheben. Zunächst muss man sich klarmachen, dass das Grundprinzip vieler Datenbanksysteme dem klassischen Client-Server-Modell folgt.

Bei einer typischen Webanwendung agiert Django als Client, der Anfragen an den Datenbankserver sendet. Dieser empfängt die Anfrage, führt die gewünschte Operation aus und sendet die Ergebnisse zurück. Für Entwickler wirkt dies oft wie eine einzige Aktion, tatsächlich passiert jedoch im Hintergrund eine Reihe von orchestrierten Schritten. Der Beginn einer Datenbankoperation liegt in der Kommunikation zwischen der Applikation und der Datenbank. In Django wird häufig der sogenannte ORM (Object-Relational Mapper) genutzt, der es Entwicklern erlaubt, Datenbankanfragen auf einer höheren Abstraktionsebene zu formulieren, ohne direkt SQL schreiben zu müssen.

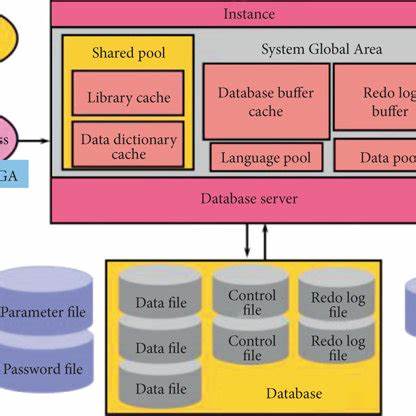

Wenn beispielsweise auf einer Webseite eine Liste von Biersorten angezeigt werden soll, generiert der ORM eine SQL-Abfrage, um die entsprechenden Informationen aus der Tabelle zu holen. Diese SQL-Anweisung wird dann an die PostgreSQL-Datenbank weitergeleitet. Bevor die Anfrage verarbeitet wird, benötigt der ORM eine aktive Datenbankverbindung. PostgreSQL verwaltet die Verbindungen mithilfe eines Prozesses, der auf einem bestimmten Port (standardmäßig 5432) lauscht. Wenn eine neue Verbindung hereinkommt, spaltet dieser sogenannte Hauptprozess einen Kindprozess ab, der sich ausschließlich um die Kommunikation mit diesem Client kümmert.

Somit entstehen für mehrere gleichzeitige Nutzer separate Sessions, die unabhängig voneinander Daten abfragen oder verändern können. Es ist wichtig zu erwähnen, dass eine hohe Zahl gleichzeitiger Verbindungen die Systemressourcen stark beanspruchen kann. Die Steuerung dieser Verbindungen erfolgt meist über Connection Pooling, was bedeutet, dass bestehende Verbindungen wiederverwendet werden, statt sie ständig neu aufzubauen und zu zerstören. Tools wie PgBouncer sind dabei hilfreich, um eine effiziente Verbindungspflege sicherzustellen. Sobald die Verbindung steht, beginnt PostgreSQL mit der eigentlichen Ausführung der Abfrage.

Dabei geht das System mehrere Schritte durch, um sicherzustellen, dass die Anfrage korrekt interpretiert und optimiert wird. Zunächst erfolgt die Analyse (Parsing) des SQL-Statements. Hierbei überprüft PostgreSQL die Syntax, ob Tabellen und Spalten existieren und ob der aufrufende Nutzer die notwendigen Zugriffsrechte besitzt. Fehler wie beispielsweise falsch geschriebene Tabellen oder fehlende Rechte führen an dieser Stelle zu einer Fehlermeldung. Nach dem Parsing findet die Transformation und Umschreibung der Anfrage statt.

In diesem Schritt werden beispielsweise komplexere Konstrukte wie Views aufgelöst oder Regelwerke wie Row-Level-Security berücksichtigt. Dies ermöglicht PostgreSQL, die ursprüngliche Anfrage in eine für die Ausführung verständliche Form zu bringen. Das Herzstück einer effizienten Datenbankoperation ist der Abfrageplan (Execution Plan). Das deklarative SQL sagt lediglich, was gewünscht ist, nicht aber wie es zu erreichen ist. PostgreSQL übernimmt die Entscheidung, wie die Daten am schnellsten und ressourcenschonendsten geliefert werden können.

Dabei wählt die Datenbank aus verschiedenen Zugriffswegen, entscheidet, ob beispielsweise ein Index genutzt oder ein vollständiger Tabellenscan durchgeführt wird, und bestimmt die Art der Joins bei mehreren Tabellen. Ein detaillierter Blick auf den Execution Plan kann für Entwickler anfangs komplex erscheinen, doch ein grundlegendes Verständnis kann die Performance von Abfragen wesentlich verbessern. Tools wie EXPLAIN oder EXPLAIN ANALYZE erlauben es, den Plan einzusehen und zu analysieren, wie viel Zeit in einzelnen Schritten verbraucht wird, wie viele Zeilen verarbeitet wurden und welche Ressourcen beansprucht wurden. Diese Einsichten helfen, kritische Flaschenhälse zu erkennen und beispielsweise Indizes gezielt aufzubauen oder Abfragen umzugestalten. Ein typisches Beispiel ist die Verwendung eines sequential scans (vollständiger Tabellenscan).

Obwohl oft als ineffizient betrachtet, kann dieser bei kleinen Tabellen der schnellste Weg sein, da die Indizierung selbst auch Overhead erzeugt. Bei größeren Datenmengen sind dagegen Bitmap-Index-Scans oder andere Indexmethoden in Kombination mit gezielten Filtern effizienter. Beim Zugriff auf die Daten werden diese in 8 Kilobyte großen Seiten gespeichert. Dieses Prinzip ermöglicht eine effiziente Verwaltung des Datenträgers und erleichtert das Puffern der Daten im RAM. PostgreSQL arbeitet mit einer Heap-Tabelle, was bedeutet, dass Datenzeilen bewusst ohne spezifische Ordnung gespeichert sind, wodurch Insertionen und Updates zügig durchgeführt werden können.

Wenn nicht nur Daten gelesen, sondern auch eingefügt, aktualisiert oder gelöscht werden, nutzt PostgreSQL das Konzept des sogenannten MVCC (Multiversion Concurrency Control). Dadurch sind mehrere Versionen derselben Datenzeile möglich, was konkurrierende Zugriffe mit höchster Isolationsstufe erlaubt. Bei einem Update wird nicht einfach der Datensatz überschrieben – stattdessen wird ein neuer Datensatz mit den Änderungen eingefügt, während die alte Version als inaktiv markiert bleibt. Dadurch können Lesetransaktionen weiterhin konsistente Daten sehen, ohne von aktiven Schreibvorgängen blockiert zu werden. Solche tote Datensätze, sogenannte „Dead Tuples“, werden von der Datenbank später per VACUUM-Prozess entfernt, um Speicherplatz freizugeben und die Performance zu erhalten.

Entwickler sollten dies im Hinterkopf behalten und regelmäßig Wartungsroutinen einplanen, um ein Aufblähen der Tabellen zu verhindern. Nachdem PostgreSQL die Abfrage ausgeführt und die Daten gesammelt hat, werden die Ergebnisse an den Client zurückgeschickt. In Django heißt das, dass die Anwendung die Daten empfangen und in einer für Nutzer verständlichen Form darstellen kann. Es ist aus Performancegesichtspunkten ratsam, nur die tatsächlich benötigten Daten abzurufen, um unnötigen Netzwerktraffic zu vermeiden und die Anzeige beschleunigt zu gestalten. Autocommit ist bei vielen PostgreSQL-Clients standardmäßig aktiviert, sodass jede Einzelabfrage automatisch als eigene Transaktion behandelt wird.

Für komplexere Operationen oder Abhängigkeiten zwischen mehreren SQL-Statements bietet PostgreSQL jedoch die Möglichkeit, explizite Transaktionen zu verwenden, die mit BEGIN starten und mit COMMIT oder ROLLBACK beendet werden. Eine durchdachte Konfiguration der PostgreSQL-Serverparameter kann die Performance und das Debugging deutlich verbessern. So erlauben Logging-Optionen wie log_min_duration_statement die Erfassung besonders langlaufender Queries, was bei der Optimierung unerwünschter Performanceeinbrüche hilft. Weitere Einstellungen passen das Logformat an, um neben Zeitstempel auch Nutzerinformationen und Verbindungsdetails auszugeben. Für Entwickler, die tiefer in SQL und den PostgreSQL-Stack einsteigen möchten, sind praktische Tools von großer Bedeutung.

Online-Plattformen wie der Crunchy Data PostgreSQL Playground bieten einfache Zugänge, um SQL-Abfragen direkt im Browser auszuprobieren und kennenzulernen. Schließlich ist es für jeden, der produktive Webanwendungen baut, essenziell, die volle „Anatomie“ einer Datenbankoperation zu verstehen. Erfolgreiche Performanceoptimierung beginnt mit dem Wissen, wie Daten abgefragt, wie Pläne erstellt und umgesetzt werden, und wie Änderungen an den Daten nachhaltig und sicher verarbeitet werden. Nur durch dieses tiefgehende Verständnis lassen sich Anwendungen zuverlässig skalieren, Ressourcen intelligent nutzen und letztlich zufriedene Nutzer schaffen. Durch die enge Verzahnung von Django und PostgreSQL profitieren Entwickler von einem mächtigen Ökosystem, das nicht nur einfache Datenbankoperationen ermöglicht, sondern auch komplexe Anforderungen wie Transaktionen, Indizierung und Sicherungen einfach handhabbar macht.

Wer sich mit der inneren Funktionsweise beschäftigt, gewinnt einen wertvollen Vorteil – eine Datenbank wird so zum aktiven Partner und nicht mehr nur zum passiven Speicherort.

![Solutions for PV Cyber Risks to Grid Stability [pdf]](/images/A9B25FB8-7447-4F91-B049-783D156A2F33)

![Can an English Fish Merchant Turn a Profit in Asia's Largest Market? [video]](/images/37896F36-5D0C-4F52-A624-A1436C2D81B8)