In der heutigen Ära der Künstlichen Intelligenz (KI) erleben wir eine rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs), die komplexe menschliche Sprache verstehen und verarbeiten können. Während diese Modelle ursprünglich nicht speziell für naturwissenschaftliche Disziplinen wie die Chemie entwickelt wurden, zeigt sich zunehmend, dass sie erhebliche Potenziale besitzen, chemisches Wissen zu erfassen und sogar chemisches Denken bis zu einem gewissen Grad nachzuahmen. Doch wie genau schlagen sich diese KI-gestützten Systeme im Vergleich zur Expertise erfahrener Chemiker? Und welche Chancen und Herausforderungen ergeben sich daraus für Forschung, Lehre und Praxis in den chemischen Wissenschaften? Diese Fragen bilden den Kern einer jüngst veröffentlichten, umfassenden Studie, die die Fähigkeiten moderner LLMs im Bereich der Chemie systematisch evaluiert und ihre Leistung mit der von Fachleuten vergleicht. Die Etablierung großer Sprachmodelle hat in den letzten Jahren die Art und Weise, wie wir mit maschineller Intelligenz interagieren, revolutioniert. Basierend auf riesigen Textmengen lernen diese Modelle, sinnvolle Zusammenhänge zu erfassen und komplexe Aufgaben zu erfüllen, ohne explizit darauf trainiert worden zu sein.

In der Medizin beispielsweise konnten solche Modelle inzwischen Prüfungen wie das US Medical Licensing Examination bestehen, was bereits einen Meilenstein im Bereich KI-gestützter Fachkompetenz darstellt. Übertragen auf die Chemie bedeutet dies, dass LLMs potenziell Antworten auf Fragestellungen geben, Syntheserouten vorschlagen oder Materialeigenschaften vorhersagen können – stets mit Zugriff auf ein erheblich größeres Wissensspektrum als ein Mensch es je erlernen könnte. Die zugrundeliegende Studie hat ein spezielles Evaluierungsframework namens ChemBench entwickelt, das über 2700 sorgfältig kuratierte Frage-Antwort-Paare aus verschiedensten Chemiethemen beinhaltet. Diese Fragen reichen von grundlegenden Kenntnissen über komplexe Rechenaufgaben bis hin zu anspruchsvollen logischen Schlussfolgerungen und Einschätzungen hinsichtlich chemischer Intuition. Ein Teil der Fragen basiert auf realen Prüfungsunterlagen, andere wurden halbautomatisch generiert, um die Breite des Fachgebiets abzubilden.

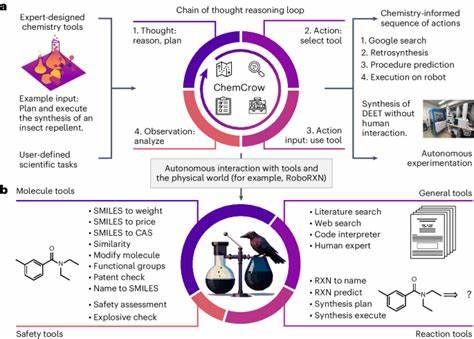

Damit schafft ChemBench eine bislang einzigartige Grundlage, um künstliche Intelligenz im direkten Vergleich mit menschlichen Chemieexperten zu bewerten. Die Ergebnisse überraschen in vielerlei Hinsicht. Das leistungsfähigste untersuchte Sprachmodell, genannt o1-preview, erzielte im Durchschnitt fast doppelt so viele korrekte Antworten wie die besten menschlichen Teilnehmer der Studie. Offenbar können moderne LLMs in vielen Teilgebieten der Chemie fachlich fundierte und korrekte Auskünfte erteilen – selbst wenn diese komplexe Zusammenhänge betreffen, für deren Verständnis ein Chemiker lange ausgebildet werden muss. Darüber hinaus konnten sowohl proprietäre als auch neue Open-Source-Modelle hohe Leistungsniveaus erreichen und teilweise vergleichbare Ergebnisse erzielen, was die Zugänglichkeit moderner KI-Anwendungen für Forschende weltweit verbessert.

Doch trotz dieses beachtlichen Fortschritts gibt es signifikante Einschränkungen. Insbesondere bei fragilen oder wissensintensiven Aufgaben offenbaren die Modelle Schwächen, etwa wenn es um Sicherheitseinschätzungen oder detaillierte Kenntnisse aus spezialisierten Datenbanken geht. Hier zeigt sich, dass LLMs zwar große Textmengen verdauen können, jedoch nicht unbedingt verlässlich auf hochpräzises Spezialwissen zugreifen, wenn dieses nicht in den Trainingsdaten enthalten oder durch externe Ressourcen augmentiert wird. Selbst komplexe chemische Strukturaufgaben, beispielsweise die Vorhersage der Anzahl unterschiedlicher Signalsignale im Kernspinresonanzspektrum, stellen für KI eine große Herausforderung dar. Diese Aufgaben erfordern eine tiefgehende molekulare Modellierung und Raumvorstellung, die heute noch hauptsächlich humaner Intuition und Erfahrung vorbehalten sind.

Ein weiterer kritischer Aspekt betrifft das Selbstvertrauen der Modelle. Die Untersuchung ergab, dass viele Sprachmodelle ihre eigene Unsicherheit nicht zuverlässig einschätzen können, was bedeutet, dass sie mitunter falsche Antworten mit hoher Sicherheit liefern – ein Umstand, der insbesondere im Umgang mit sicherheitsrelevanten chemischen Informationen gefährlich sein kann. Für den professionellen Einsatz von KI in der Chemie ist deshalb eine verbesserte Kalibrierung von Vertrauen und Unsicherheit essenziell, um eine verantwortungsvolle und sichere Anwendung zu gewährleisten. Die Integration spezialisierter Datenbanken und Werkzeuge in die KI-Systeme kann hier einen entscheidenden Fortschritt bewirken. Die Studie weist außerdem darauf hin, dass traditionelle Prüfungsaufgaben und Standardtests möglicherweise nicht ausreichend sind, um die wahre Leistungsfähigkeit moderner KI-Modelle oder auch von Menschen zu messen.

Während LLMs bei üblichen Lehrbuchfragen häufig sehr gut abschneiden, verlieren sie bei originären, praxisnahen Herausforderungen an Leistungsfähigkeit. Dies lässt darauf schließen, dass die Chemieausbildung stärker auf kritisches Denken und strukturierte Problemlösung ausgerichtet werden sollte, anstatt auf reines Auswendiglernen von Fakten. Die Kombination von menschlichem Fachwissen und KI-gestützter Datenanalyse könnte so zu einem Synergieeffekt führen, der die Grenzen beider erweitert. Neben dem Einsatz für reine Wissensabfragen bieten die KI-Modelle auch Potenzial bei der Bewertung von chemischen Präferenzen oder Intuition, etwa in der Wirkstoffentwicklung. Hier zeigte sich jedoch, dass gegenwärtige Modelle Schwierigkeiten haben, menschliche Präferenzen genau zu reproduzieren oder zu antizipieren.

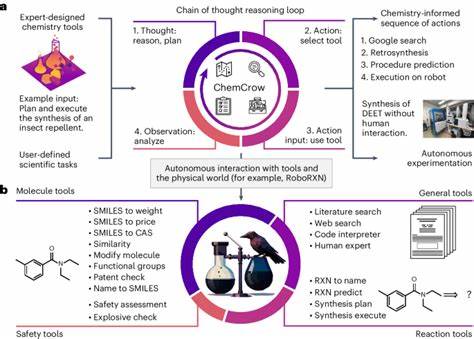

Dies unterstreicht den Bedarf, KI-Systeme für subjektive und kreative Entscheidungsprozesse weiter zu optimieren und etwa auf Lernen aus menschlicher Rückmeldung zu setzen. Darüber hinaus verdeutlichen die Resultate, dass die Größe und Komplexität eines Modells häufig mit seiner Leistungsfähigkeit korrelieren. Dies legt nahe, dass durch weiteres Hochskalieren der Modelle und gezielte Einpflege von Fachwissen noch erhebliche Verbesserungen möglich sind. Zugleich ist klar, dass reine Größensteigerung allein nicht ausreicht, sondern auch strukturierte Datenintegration, spezialisierte Trainingsansätze sowie hybride Systeme, die LLMs mit externen Tools kombinieren, entscheidend sind. Die Fortschritte im Bereich der chemischen LLMs eröffnen vielversprechende Anwendungsmöglichkeiten.

Beispielsweise könnten zukünftige digitale Assistenten Chemikern als Copiloten dienen, indem sie bei der Recherche, Analyse und Planung von Experimenten unterstützen. Sie könnten aktuelle Forschungsdaten in Echtzeit verarbeiten und relevante Erkenntnisse extrahieren, was die Innovationsgeschwindigkeit deutlich beschleunigt. Da das meiste Chemiewissen in wissenschaftlichen Texten vorliegt, bieten LLMs mit ihrer einzigartigen Textverarbeitungskapazität genau den richtigen Zugang, um dieses Wissen nutzbar zu machen. Nicht zu vernachlässigen sind jedoch die ethischen und sicherheitstechnischen Herausforderungen. Die dual-use Problematik, bei der Technologien sowohl für friedliche als auch potenziell missbräuchliche Zwecke genutzt werden können, ist auch im Bereich der chemischen Künstlichen Intelligenz präsent.

LLMs könnten theoretisch dazu verwendet werden, gefährliche oder toxische Substanzen zu konzipieren, auch wenn deren reale Synthese weiterhin Fachwissen und zugängliche Laborausstattung erfordert. Daher ist ein verantwortungsvoller Umgang, die Einbindung von Kontrollmechanismen und die Sensibilisierung der Nutzer unerlässlich. Insgesamt zeigt die aktuelle Forschung, dass große Sprachmodelle das Potenzial besitzen, die Chemie grundlegend zu verändern. Sie ergänzen das menschliche Wissen, bieten schnell zugängliche Expertise und ermöglichen neue Denkansätze. Dennoch ersetzt KI die menschliche Erfahrung, kritisches Urteilsvermögen und kreatives Denken nicht vollständig.

Stattdessen wird die Zukunft wahrscheinlich in der symbiotischen Zusammenarbeit zwischen Mensch und Maschine liegen, bei der die Stärken beider optimal kombiniert werden. Die gewonnenen Erkenntnisse fordern auch die Chemieausbildung heraus. Wenn KI-Modelle Faktenwissen und einfache Rechenaufgaben mühelos bewältigen können, müssen Studierende verstärkt dazu befähigt werden, komplexe Probleme selbstständig zu analytisch zu bearbeiten und die Grenzen der maschinellen Unterstützung zu erkennen. Lehrpläne sollten kritisches Denken, Modellbewertung sowie ethische Aspekte der KI-Nutzung in den Vordergrund rücken. Zur weiteren Stärkung dieses Forschungsfeldes ist das Bereitstellen offener und standardisierter Evaluationsframeworks wie ChemBench von großer Bedeutung.