Objektspeicher erfreuen sich in der IT-Welt wachsender Beliebtheit, da sie eine kosteneffiziente, skalierbare und langlebige Speicherung von Daten ermöglichen. Von Cloud-Anbietern über große Datenplattformen bis hin zu IoT-Architekturen bilden Object Storages eine wichtige Komponente. Trotz dieser Vorteile birgt die Verwaltung großer Datenmengen in solchen Speichersystemen zahlreiche Herausforderungen, insbesondere beim Löschen von Dateien, die nicht mehr benötigt werden. Die sogenannte Garbage Collection, also das Entfernen von Objekten, die entweder gelöscht oder veraltet sind, ist eine essenzielle Aufgabe, um Speicherplatz freizugeben und Kosten zu minimieren. Im Folgenden werden verschiedene Aspekte der Garbage Collection in Object Storages erläutert und wie diese im großen Maßstab bewältigt werden können.

Der fachliche Fokus liegt dabei auf hochskalierbaren, verteilten Systemen wie WarpStream, die komplexe Anforderungen an Datenhaltung und -löschung stellen. Ein zentraler Punkt bei der Garbage Collection ist, wie und wann Objekte aus dem Speicher gelöscht werden. Auf den ersten Blick scheint es naheliegend, einfach vorhandene Löschmechanismen innerhalb des Object Storages, etwa Bucket-Policies mit TTL (Time To Live), zu nutzen. Solche automatischen Regeln sind für einfache Anwendungsfälle eine solide Lösung. Beispielsweise kann man eine Regel definieren, die alle Dateien löscht, die älter als sieben Tage sind.

Doch sobald unterschiedliche Daten mit individuell variierenden Lebenszeiten in einem System gespeichert sind, stößt diese Methode schnell an Grenzen. Der Grund liegt darin, dass eine solche Policy nur für den längsten Retentionszeitraum aller Objekte konfiguriert werden kann. Dies führt dazu, dass viele Dateien mit kürzerer Haltbarkeit unnötig lange gespeichert werden, was Speicher- und somit Kostenverschwendung bedeutet. Darüber hinaus können komplexe Workloads wie kompaktierte Topics aus dem Kafka-Protokoll nicht durch einfache Bucket-Regeln angemessen abgebildet werden, da dort Nachrichten nicht unmittelbar altersbasiert gelöscht werden, sondern durch Überschreiben von Schlüsselwerten – ein feinkörnigeres Löschverhalten. Eine weitere naheliegende Strategie ist die sogenannte synchrone Löschung.

Sobald eine Datei in der Metadatenschicht als gelöscht markiert wird, soll sie unmittelbar im Object Storage gelöscht werden, um Konsistenz zu gewährleisten. Theoretisch klingt dieser zweistufige Prozess – zuerst die Metadaten löschen, dann die Datei – sinnvoll. In der Praxis führen jedoch Netzwerkfehler, Abstürze oder andere Ausfälle häufig dazu, dass eine der beiden Aktionen scheitert. Besonders fatal ist es, wenn die Datei zwar in den Metadaten als gelöscht gilt, aber physisch noch im Speicher vorhanden ist. Solche sogenannten „verwaisten Dateien“ belegen unnötig Speicherplatz und verursachen Kosten, ohne vom System verwendet zu werden.

Eine weitere Herausforderung hierbei ist die Behandlung sogenannter in-flight Abfragen. Wenn eine Datei gelöscht wird, während sie noch von einer laufenden Abfrage genutzt wird, scheitert diese, da die referenzierte Datei nicht mehr existiert. Dieses Problem ist im Kontext verteilter Systeme mit Cache- und Leseoperationen besonders schwerwiegend und beeinträchtigt die Systemperformance und Zuverlässigkeit. Um diese Herausforderungen zu meistern, hat sich über die Jahre ein effektives Mittel namens „verzögerte Warteschlange“ (Delayed Queue) als praktikable Lösung etabliert. Dabei wird eine sofortige physische Löschung nach der logischen Löschung vermieden.

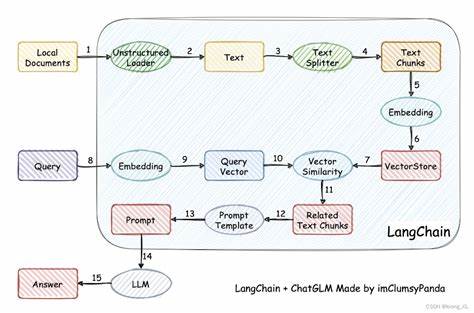

Stattdessen werden Dateien zunächst in eine wartende Queue eingereiht und erst nach einer festgelegten Verzögerung gelöscht. Dies gibt dem System ausreichend Zeit, laufende Abfragen abzuschließen, ohne dass dabei auf Performance und Verfügbarkeit verzichtet werden muss. Ein wichtiger Vorteil dieses Ansatzes ist, dass die Manipulation der Metadaten und das Enqueueing in der wartenden Löschwarteschlange in einer transaktionalen Operation erfolgen kann. Somit wird sichergestellt, dass entweder beides passiert oder nichts, was das Risiko von verwaisten Dateien minimiert. In Systemen mit stark konsistenten Metadatenbanken, wie WarpStream, ist dieses Verfahren besonders effektiv.

Doch selbst mit verzögerter Löschung können Fehler oder katastrophale Ereignisse zu verwaisten Dateien führen. Hier tritt ein zweiter wichtiger Lösungsansatz ins Spiel: die asynchrone Rekonsiliation. Dabei scannt das System den Object Storage regelmäßig und vergleicht die vorhandenen Dateien mit den Metadaten. Dateien, die nicht mehr in den Metadaten erfasst sind und deren Alter die vorgeschriebene Verzögerungszeit überschreitet, werden erkannt und sicher gelöscht. Dieses Verfahren gleicht einem traditionellen „Mark and Sweep“ Garbage Collector, der in der Programmierung für die automatische Speicherbereinigung eingesetzt wird.

Der Vorteil liegt in seiner Robustheit: auch in Fällen, in denen die verzögerte Löschwarteschlange ausfällt, werden verwaiste Dateien innerhalb einer vorhersagbaren Zeitspanne entfernt. Die Asynchrone Rekonsiliation ist allerdings ressourcenintensiv. Das Auffinden aller Dateien in einem großen Object Storage ist aufwändig, kostenintensiv und durch Rate-Limits der Cloud-Anbieter limitiert. Um diesen Herausforderungen zu begegnen, werden intelligente Techniken zur Lastverteilung und Anfrageoptimierung eingesetzt, etwa durch das Aufteilen der Scan-Vorgänge auf verschiedene Namensräume (Prefixes) und das automatische Anpassen der Scan-Frequenz an die Systemauslastung. Dadurch wird das Risiko von Ausfällen und Limitierungen minimiert und die Garbage Collection bleibt stabil.

In der Praxis zeigt sich, dass eine Kombination beider Methoden – die verzögerte Warteschlange gepaart mit regelmäßiger asynchroner Rekonsiliation – die beste Balance zwischen Performance, Kosten und Zuverlässigkeit bietet. In WarpStream zum Beispiel wurde ein hybrider Ansatz entwickelt, bei dem nach einer Kompaktierung Dateien zunächst in eine lokale optimistische Löschwarteschlange eingereiht werden. Ein Hintergrundprozess steuert die spätere physische Löschung. Diese optimistische Warteschlange ist kostengünstig, da sie lokal auf Agents läuft und nicht die Hauptmetadatenbank belastet. Gleichzeitig verhindert das nachgelagerte Rekonsiliationsverfahren, dass verwaiste Dateien über längere Zeit bestehen bleiben können.

Die Bedeutung der Garbage Collection in großen Object Storage Systemen geht weit über Speicheroptimierung hinaus. Sie ist ein kritischer Faktor für die Kostenkontrolle in Cloud-Umgebungen, die Einhaltung von Datenschutz- und Compliance-Vorgaben sowie für die Verfügbarkeit und Performance der Dienste. Ein fehlerhaftes oder ineffizientes Löschmanagement kann zu steigenden Betriebskosten führen, Dateninkonsistenzen verursachen und Nutzererfahrungen negativ beeinflussen. In der Praxis müssen Unternehmen sicherstellen, dass ihre Garbage Collection-Strategien an die individuellen Anforderungen und das Datenzugriffsverhalten angepasst sind. Gerade in Systemen mit hohen Durchsatzraten, unterschiedlichen Datenlebenszyklen und komplexen Benutzerzugriffsmustern ist die alleinige Verwendung einfacher TTL-Regeln oder synchroner Löschungen nicht ausreichend.

Die kombinierte Nutzung verzögerter Löschwarteschlangen und asynchroner Regeln sorgt für eine flexible, skalierbare und ausfallsichere Verwaltung. Die technologische Grundlage für effiziente Garbage Collection bildet dabei eine starke Konsistenz und Transaktionsfähigkeit der Metadaten. Sie ermöglicht korrekte und atomare Updates und damit ein zuverlässiges Tracking des Lebenszyklus jeder Datei. Parallele Prozesse zur Löschwarteschlange und Rekonsiliation gewährleisten Sicherheit gegen unbeabsichtigten Datenverlust und reduzieren das Risiko von verwaisten Dateien auf ein Minimum. Zukünftige Entwicklungen in der Object Storage Garbage Collection könnten einen noch stärkeren Fokus auf Automatisierung und Machine Learning legen.

Intelligente Systeme könnten erkennen, welche Dateien mit höherer Wahrscheinlichkeit bald gelöscht werden können, um Reinigungsprozesse noch gezielter und sparsamer zu planen. Zudem ist die Integration von Garbage Collection mit Disaster Recovery und Backup-Systemen ein wichtiger Fortschritt. So kann sichergestellt werden, dass im Fall einer Wiederherstellung keine Dateien fehlen, die in der Zwischenzeit gelöscht wurden, oder dass versehentliche Löschungen schnell rückgängig gemacht werden können. Für Betreiber großer Object Storage Systeme stellt die korrekte Implementierung der Garbage Collection einen Wettbewerbsvorteil dar. Sie senkt nicht nur die Betriebskosten nachhaltig, sondern steigert auch die Zuverlässigkeit und Nutzerzufriedenheit.

Die Wahl des richtigen Konzepts hängt dabei stark von der jeweiligen Systemarchitektur, den Workloads und den Compliance-Anforderungen ab. Abschließend lässt sich sagen, dass effiziente Garbage Collection in Object Storage Umgebungen eine komplexe, aber lösbare Herausforderung ist. Durch clevere Kombination bewährter Strategien, wie verzögerte Löschwarteschlangen und asynchrone Rekonsiliation, gepaart mit einem durchdachten Metadatentracking, können selbst Milliarden von Dateien sauber, performant und kosteneffizient verwaltet werden. Wenn diese Systeme korrekt implementiert sind, steht einer skalierbaren, stabilen und wirtschaftlichen Cloud-Datenhaltung nichts mehr im Wege.