In der Welt der Künstlichen Intelligenz (KI) nimmt das Verständnis von Daten eine immer größere Rolle ein. Insbesondere bei Texten, Bildern und anderen Informationen, die bisher vor allem als reine Zeichen- oder Pixelketten galten, geht der Trend hin zu einem tieferen, semantischen Verständnis. Kern dieser Entwicklung ist die Technologie der Embeddings – eine Methode, mit der Rohdaten in numerische, mathematische Formen verwandelt werden, die Computer effektiv analysieren und interpretieren können. Ohne Embeddings wären viele der heutigen Fortschritte in der natürlichen Sprachverarbeitung und darüber hinaus kaum denkbar. Embeddings ermöglichen es, die Bedeutung von Wörtern, Sätzen oder sogar Bildern so abzubilden, dass Maschinen nicht nur die exakte Form, sondern auch den Kontext und die zugrundeliegende Bedeutung erfassen können.

Im Gegensatz zu älteren Methoden, bei denen Ähnlichkeiten oft ausschließlich anhand von Wortübereinstimmungen oder einfachen Zeichenvergleichsverfahren wie der Levenshtein-Distanz gemessen wurden, geht es bei Embeddings um ein tiefgreifendes, kontextbasiertes Verständnis. Klassische Methoden wie die Wort-Überlappung zeigen schnell ihre Grenzen. Ein Beispiel: Die Sätze „Mein Hund liebt es zu essen“ und „Meine Oma liebt es Kuchen zu essen“ teilen viele Wörter, jedoch handelt es sich eindeutig um unterschiedliche Bedeutungen. Ähnlich verhält es sich bei der etwa auf edit-distance beruhenden Approximate-String-Matching-Methode, die zwar ermittelt, wie ähnlich zwei Wörter auf der Buchstabenebene sind, jedoch wenig mit deren semantischer Verwandtschaft zu tun hat. Embeddings treten genau dort an: Sie wandeln Worte, Sätze und andere Dateneinheiten in hochdimensionale Vektoren um, wobei diese Vektoren in einem mehrdimensionalen Raum positioniert werden.

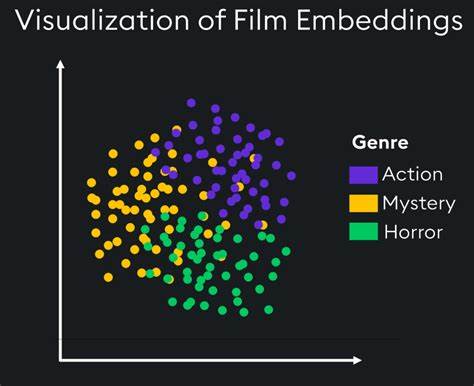

Wörter oder Sätze, die inhaltlich nahestehen, liegen in diesem Raum ebenfalls nah beieinander. Die mathematischen Operationen mit diesen Vektoren erlauben es Maschinen, Beziehungen, Ähnlichkeiten und Unterschiede zu erkennen, die weit über den Wortlaut hinausgehen. Etwa wird in einem Modell ein Vektor für „Katze“ und ein weiterer für „Kätzchen“ erzeugt, welche durch die gemeinsamen Kontextwörter wie „weiches Fell“, „spielen“ oder „Garn“ sehr nah beieinander liegen. Anders ausgedrückt: Das Modell lernt, dass diese zwei Begriffe semantisch verwandt sind, obwohl sie unterschiedliche Token darstellen. Embeddings basieren häufig auf der Zerlegung von Text in sogenannte Tokens, wobei diese nicht zwingend einzelne Wörter sind, sondern je nach Modellspezifikation auch Wortteile oder Kombinationen aus Buchstaben sein können.

Eine besondere Rolle spielt dabei das Kontextfenster, also der Ausschnitt an Tokens, der für einen Begriff gleichzeitig berücksichtigt wird. Die Wahl der Fenstergröße beeinflusst maßgeblich die Qualität der resultierenden Vektoren. Ein zu kleines Fenster führt dazu, dass das Modell nur sehr lokale Beziehungen erlernt, was bei syntaktischen Aufgaben nützlich ist. Andererseits kann ein zu großes Fenster globale Beziehungen verwässern und die Granularität verlieren. Daher sind Fenstergrößen zwischen zwei und fünf Tokens für viele Aufgaben ein guter Kompromiss, während bei Themenwie der Dokumentähnlichkeit oft größere Bereiche einbezogen werden.

Das grundlegende Ziel beim Training von Embeddings besteht darin, die Vektoren so anzupassen, dass jedes Wort möglichst gut seine typischen Umfelder vorhersagt. Hierbei werden anfänglich zufällig gewählte Vektoren kontinuierlich optimiert, sodass Wörter mit ähnlichen Kontexten ihre Vektoren im sogenannten Vektorraums näher zusammenrücken. Diese Ähnlichkeiten können anschließend mittels Maßzahlen wie der Kosinus-Ähnlichkeit quantitativ bewertet werden. Werte nahe bei eins zeigen dabei eine hohe semantische Übereinstimmung an, während Werte nahe null oder sogar negativ ausdrücken, dass Begriffe kaum oder gar nicht verwandt sind. Embeddings sind längst nicht nur auf Texte beschränkt.

In multimodalen Modellen finden sie ebenso Anwendungen bei Bildern, Tönen oder anderen Datenformen. So können beispielsweise Bildinhalte in Vektoren überführt und mit Textvektoren verbunden werden, um Bildbeschreibungen automatisch zu generieren oder Bildinhalte besser zu durchsuchen. Dies ist ein wesentlicher Baustein moderner KI-Anwendungen, von Suchmaschinen über Sprachassistenten bis hin zu Empfehlungssystemen. Die Effizienz, mit der Embeddings Bedeutung erfassen, erlaubt es auch, eine Fülle an Anwendungsmöglichkeiten erst möglich zu machen. Automatisierte Zusammenfassungen, semantische Suche, Chatbots mit besserem Kontextverständnis und sogar kreative Anwendungen wie das Generieren von Texten, die stilistisch und inhaltlich zusammenpassen, profitieren davon.

Zur Entfaltung der vollen Leistungsfähigkeit von Embeddings bedarf es jedoch auch hochwertiger Trainingsdaten und leistungsfähiger Modelle, da der Lernprozess komplex und rechnerisch intensiv sein kann. Hier gelangen vortrainierte Embeddings oft zum Einsatz, die auf riesigen Korpora gelernt wurden und dann als Basis für weitere spezifische Aufgaben dienen. Die Forschung im Bereich der Embeddings ist dynamisch und entwickelt sich ständig weiter. Adaption an neue Datenarten, Optimierung der Trainingsalgorithmen und die Verknüpfung verschiedener Modalitäten prägen die Zukunft dieser Technologie. Auch ethische und gesellschaftliche Fragestellungen spielen eine Rolle, insbesondere wenn es darum geht, Verzerrungen in Trainingsdaten zu vermeiden oder Transparenz im Umgang mit KI-Systemen zu gewährleisten.

Zusammenfassend lässt sich sagen, dass Embeddings eine fundamentale Rolle im Fortschritt der Künstlichen Intelligenz einnehmen. Sie bilden die Brücke zwischen rohen Daten und verständnisbasierten Anwendungen, ermöglichen Maschinen ein flexibles und tiefgreifendes Erfassen der Welt und sind damit ein Herzstück moderner Technologien. Für alle, die sich mit KI, Sprachverarbeitung oder Computer Vision beschäftigen, lohnt es sich, dieses Thema detailliert zu verstehen und weiter zu verfolgen, da Embeddings auch künftig intensiv im Zentrum zahlreicher Innovationen stehen werden.

![François-René Rideau: Orthogonal Persistence, the Model [video]](/images/E9E4D447-7D09-4097-B3C0-4C081A123C54)