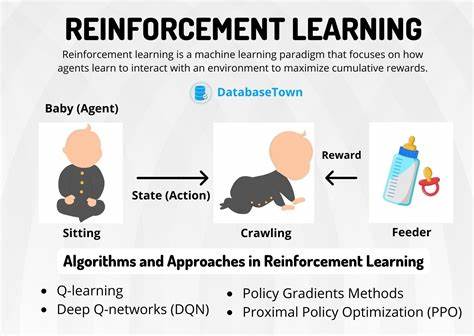

Die rasante Entwicklung von Sprachmodellen hat in den letzten Jahren neue Maßstäbe in der künstlichen Intelligenz gesetzt. Insbesondere in Bereichen wie dem mathematischen Denken oder beim Programmieren stoßen klassische Ansätze häufig an ihre Grenzen. Um die Fähigkeiten von Sprachmodellen zu verbessern, wird verstärkt auf Reinforcement Learning (RL) gesetzt – eine Methode, die ursprünglich aus der Robotik stammt. Diese Technik ermöglicht es Modellen, durch Belohnungen und Bestrafungen selbständig bessere Strategien zu erlernen und so komplexe Aufgaben effektiver zu bewältigen. Allerdings unterscheiden sich die Anforderungen zwischen typischen Robotikanwendungen und Sprachverarbeitungsaufgaben erheblich.

Dies führt dazu, dass herkömmliche RL-Algorithmen für Sprachmodelle nicht optimal geeignet sind und speziell angepasst werden müssen. Ein zentrales Thema bei der Entwicklung solcher Algorithmen ist die Balance zwischen Genauigkeit und Rechenaufwand. Besonders bei kleineren Modellen, die durch begrenzte Ressourcen charakterisiert sind, spielt die effiziente Nutzung der Rechenkapazitäten eine wesentliche Rolle. Studien zeigen, dass on-policy RL-Methoden, bei denen das Modell direkt aus den Ergebnissen seiner aktuellen Strategien lernt, der klassischen überwachten Feinabstimmung deutlich überlegen sind. Dieser Ansatz steigert die Fähigkeiten von Sprachmodellen, komplexe Probleme autonom zu lösen, ohne dass sie allein auf vorgegebene Trainingsdaten angewiesen sind.

Interessanterweise hat sich herausgestellt, dass eine Variante namens Proximal Policy Optimization (PPO), die üblicherweise zur Reduzierung der Varianz bei Lernprozessen eingesetzt wird, in Wirklichkeit die Genauigkeit der Modelle erhöht, statt nur die Stabilität zu verbessern. Diese Erkenntnis ist besonders wichtig, da sie traditionelle Annahmen über den Nutzen von PPO in Frage stellt und neue Möglichkeiten für die Optimierung von RL-Ansätzen in der Sprachverarbeitung eröffnet. Ein weiterer bedeutender Faktor ist die Rolle der Kullback-Leibler-Divergenz (KL-Divergenz), die in vielen RL-Algorithmusdesigns verwendet wird, um das Verhalten des Modells im Lernprozess zu regulieren. Überraschenderweise kann das Entfernen dieser Regulierung dazu führen, dass Sprachmodelle prägnanter und gleichzeitig genauer antworten. Dies deutet darauf hin, dass zu strenge Beschränkungen die Kreativität und Effektivität der Modelle einschränken können und ein flexiblerer Umgang mit solchen Parametern lohnenswert ist.

Neben algorithmischen Anpassungen ist die effiziente Ressourcennutzung eine der größten Herausforderungen. Die optimale Batch-Größe für die Inferenz, also die Generierung von Texten oder Lösungen, unterscheidet sich stark von der für das Backpropagation-Training, bei dem das Modell seine Parameter anpasst. Diese Diskrepanz führt oft zu suboptimaler Nutzung der verfügbaren Hardware und verlängert die Trainingszeiten erheblich. Um dieses Problem zu lösen, wurde der innovative Algorithmus DASH entwickelt. Er kombiniert Preemptive Sampling mit Gradient Filtering, wodurch große Datensätze vorab gesammelt werden, aber die anschließenden Aktualisierungen in kleineren, effizienteren Schritten erfolgen.

Dabei werden zudem Muster verworfen, die keine signifikanten Verbesserungswerte haben, was die Rechenzeit drastisch reduziert. Tests zeigten, dass DASH die Trainingsdauer um beeindruckende 83 Prozent verkürzt, ohne dabei Einbußen bei der Genauigkeit hinzunehmen. Diese Fortschritte zeigen, wie durch clevere Algorithmen sowohl Leistungsfähigkeit als auch Effizienz von Sprachmodellen gleichzeitig gesteigert werden können. Die Bedeutung dieser Entwicklungen geht weit über einzelne Anwendungsfälle hinaus. Sprachmodelle mit verbessertem Denkvermögen können in Zukunft komplexe Aufgaben in Wissenschaft, Technik und Bildung übernehmen, die heute noch als zu schwierig gelten.

Verbesserte mathematische Problemlösung, zuverlässige Codegenerierung und tiefgreifendes Verständnis natürlicher Sprache könnten so auf eine neue Ebene gehoben werden. Darüber hinaus eröffnet die Erforschung effektiver RL-Methoden wichtige Perspektiven für ethische und sichere KI-Systeme. Effizientere Lernverfahren ermöglichen eine bessere Kontrolle und Anpassung der Modelle an menschliche Werte und Anforderungen. Dies ist besonders relevant in Zeiten, in denen KI immer stärker in das tägliche Leben integriert wird. Zusammenfassend lässt sich sagen, dass die Anpassung von Reinforcement Learning an den speziellen Kontext von Sprachmodellen erhebliche Vorteile mit sich bringt.

Die Kombination aus verbesserten Algorithmen, neuer Herangehensweise bei der Regulierung und innovativen Trainingsmethoden wie DASH markiert einen entscheidenden Schritt in der Weiterentwicklung künstlicher Intelligenz. Diese Entwicklungen versprechen nicht nur beeindruckende Fortschritte in der Funktionalität, sondern auch eine nachhaltige und effiziente Nutzung der verfügbaren Ressourcen. Für Experten wie auch Anwender öffnet sich damit ein spannendes Forschungsfeld, das fortlaufend neue Möglichkeiten für kreative und leistungsfähige KI-Anwendungen bereithält. Die Zukunft von Sprachmodellen wird maßgeblich davon geprägt sein, wie konsequent solche innovativen Lernstrategien umgesetzt und weiterentwickelt werden.