In der schnelllebigen Welt der Softwareentwicklung ist die Fähigkeit, sich rasch auf neue Technologien einzustellen, entscheidend. Große Sprachmodelle (LLMs), die heute in unzähligen KI-Coding-Assistenten zum Einsatz kommen, sind beeindruckende Werkzeuge, doch sie stoßen häufig an Grenzen – vor allem wenn es darum geht, mit brandneuen Bibliotheken, internen SDKs oder komplexen Migrationen umzugehen. Ein oft vernachlässigter Faktor ist dabei die veraltete Wissensbasis solcher Modelle. Diese basiert meist auf statischen Datensätzen und ist daher nicht in der Lage, sich dynamisch an den sich ständig wandelnden Softwarestack anzupassen. Wenn diese Diskrepanz nicht überwunden wird, führt das zu häufigen Fehlern, Missverständnissen und unnötigem Zeitaufwand bei der Nutzung von KI-basierten Code-Generatoren.

Doch es gibt einen vielversprechenden Lösungsansatz, der genau hier ansetzt: die gezielte Kontextstrategie. Der Kern dieses Ansatzes ist einfach und doch revolutionär. Statt sich blind auf die voreingestellten, statischen Kenntnisse eines LLM zu verlassen, wird dem Modell genau das Wissen zur Verfügung gestellt, das es für die spezifische Aufgabe benötigt. Dieses „kontextuelle Futter“ kann in Form von Dokumentationen, Standardspezifikationen oder firmenspezifischen Codesammlungen erfolgen. Dadurch verwandelt sich das Werkzeug von einem raten-den, aber gelegentlich fehlerhaften Assistenten zu einem wirklich informierten Partner, der auf Basis relevanter und aktueller Informationen arbeitet.

Ein prägnantes Beispiel aus der Praxis zeigt, wie wirkungsvoll diese Strategie ist. Bei MadKudu stand das Team vor der Herausforderung einer technischen Migration ihres Model Context Protocol (MCP) von einem älteren STDIO-basierten Setup auf einen modernen Server-Sent Events (SSE) HTTP-Server. Ein klassisches Szenario, das ideale Voraussetzungen für KI-gestütztes Coden bot. Dennoch versagte der eingesetzte KI-Coder zunächst kläglich: Die KI lieferte veraltete, ungenaue Vorschläge, die einige Zeit an Nacharbeit und Debugging erforderten. Dieser Moment der Ernüchterung führte jedoch zu einer Erkenntnis – das Modell fehlte der momentane, relevante Kontext.

Durch die Integration des Tools Context7, das es erlaubt, spezifische Dokumentationen direkt für das LLM bereitzustellen, änderte sich die Situation dramatisch. MadKudu übergab der KI die präzisen technischen Spezifikationen und die SSE-Dokumentation, die für die Migration relevant waren. Das Resultat war verblüffend: Die Codevorschläge stimmten sofort, die Fehlerquote sank signifikant. Es war, als hätte das KI-Modell einen entscheidenden Anstieg an „Verständnis“ erhalten und konnte die Aufgabenstellung passgenau umsetzen. Diese Art von 10-fachem Produktivitätsschub ist kein Einzelfall, sondern ein Beispiel für das enorme Potenzial kontextgesteuerter KI.

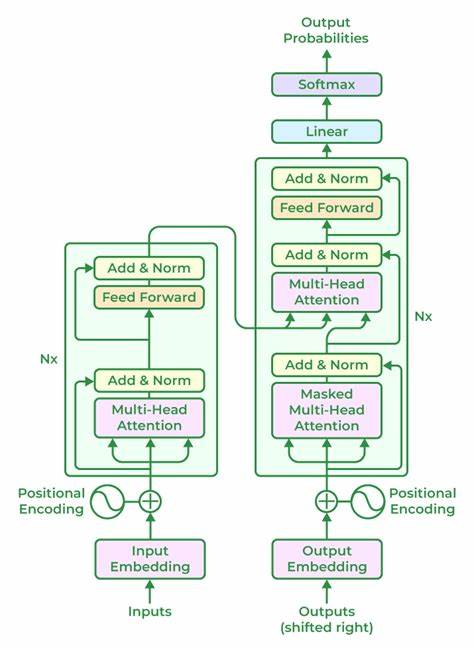

Warum funktioniert dieser Ansatz so gut? LLMs sind darauf ausgelegt, Wissen aus enormen Textkorpora zu extrahieren, doch dieses Wissen ist nicht immer auf dem neuesten Stand oder spezialisiert genug, um bei innovativen Entwicklungen oder unternehmensspezifischen Anforderungen präzise zu helfen. Ohne den passenden Kontext tendieren diese Modelle dazu, Inhalte zu erraten – was zu sogenannten Halluzinationen führt, also erfundenen, aber plausibel klingenden Antworten. Gerade bei komplexen technischen Fragen ist diese Inkonsistenz besonders problematisch und führt zu Frustration. Die gezielte Kontextbereitstellung wirkt dem entgegen, indem sie die Informationsbasis des Modells nicht nur erweitert, sondern auch fokussiert. Indem das Modell mit einem konzentrierten, relevanten „Wissensschwerpunkt“ versorgt wird, wird die Suche nach der „Nadel im Heuhaufen“ erleichtert.

Das Risiko, sich in irrelevanten Details zu verlieren oder spekulative Vorschläge zu machen, reduziert sich nachweislich. Weil der Kontext maßgeschneidert ist, kann die KI ihre generativen Fähigkeiten gezielter einsetzen und präzisere Ergebnisse liefern. Für Entwickler bedeutet das weniger Korrekturschleifen, geringere Kosten für API-Anfragen und eine deutlich höhere Qualität in den KI-erstellten Codes. Technisch gesehen wirken sogenannte „Context Injector“-Tools wie Context7 oder GitMCP hier als Brücke zwischen den großen, statischen Sprachmodellen und der dynamischen Realität des Entwicklungsalltags. Sie ermöglichen es, bestimmte URLs, internen Wikis oder GitHub-Repo-Dokumentationen in eine für die KI lesbare Form zu übersetzen und über spezialisierte Server-Architekturen zugänglich zu machen.

So wird nicht das gesamte irrelevante Wissen der Welt in eine Abfrage eingebracht, sondern konzentrierte Expertise zu genau dem Thema, das im Moment gefragt ist. Die meisten dieser Tools bieten zudem die Möglichkeit, den Kontext selbst zu hosten, was gerade für Unternehmen mit hohen Anforderungen an Datenschutz und Vertraulichkeit entscheidend ist. So können interne Informationen ohne Risiko an die KI weitergegeben werden, ohne dass sensible Daten an Drittanbieter gelangen. Dies schafft zusätzliches Vertrauen in den Einsatz solcher Systeme und fördert eine breitere Akzeptanz im professionellen Umfeld. Wo liegen nun die größten Vorteile einer konsequenten Kontextstrategie? Sie entfalten ihre Wirkung besonders dort, wo neue Bibliotheken oder SDKs gerade erst auf den Markt gekommen sind und daher nicht im Trainingsdatensatz des LLM enthalten sein können.

Auch bei proprietären, firmenspezifischen Frameworks und APIs ist der Vorteil deutlich spürbar. Zudem ist der Einsatz bei komplexen technologische Migrationen und umfangreichen Refactorings ein Game-Changer, da die KI anhand klarer, aktueller Vorgaben präzise unterstützt. Zusätzlich wird so die typische „Halluzinationsmüdigkeit“ der KI reduziert, was Entwickler wertvolle Zeit spart und die Produktivität erhöht. Nicht zuletzt ermöglicht diese Strategie auch eine bessere Balance zwischen Explorations- und Präzisionsarbeit. Während beim sogenannten „Vibe Coding“, also kreativem Herumprobieren mit weniger konkreten Vorstellungen, umfangreiche oder breit angelegte Kontext-Tools sinnvoll sein können, zeigt sich bei zielgerichtetem Arbeiten mit klar definierten Anforderungen die Überlegenheit hocheffizienter, fokussierter Kontextinjektionen.

Entsprechend erspart man sich einen großen Mehraufwand und eine erhöhte Fehleranfälligkeit. Was bedeutet das für Entwickler, Unternehmen und die Zukunft der KI-gestützten Softwareentwicklung? Zunächst einmal müssen technische Teams sich dieser Limitation der Sprachmodelle bewusst werden und Werkzeuge erproben, die den Kontext dynamisch und kontrolliert erweitern können. Es ist kein klassisches „Set and Forget“-System, sondern ein kollaborativer Prozess, bei dem der Mensch dem Modell den richtigen Prospekt in die Hände gibt. Dabei ist es ratsam, die verschiedenen verfügbaren Tools zu testen, um die für das jeweilige Projekt und den individuellen Workflow effektivste Lösung zu finden. Auf Unternehmensebene eröffnet die Kontextstrategie neue Wege, interne Wissensbestände nutzbar zu machen und dadurch Innovationszyklen zu beschleunigen.

Unternehmen, die ihre KI-Assistenz mit eigenen, aktuellen Dokumentationen und Custom-Code-Bibliotheken füttern, verschaffen sich einen deutlichen Wettbewerbsvorteil. Die verbesserte Genauigkeit der generierten Codevorschläge reduziert gleichzeitig potenzielle Bugs und damit verbundene Risiken. Eine der spannendsten Entwicklungen ist, dass diese kontextgetriebene Methode völlig unabhängig vom eigentlichen LLM ist. Ob OpenAI, Google, Cohere oder andere Anbieter – mit einem geeigneten Context Injector lassen sich sämtliche Modelle gezielt pimpen. Damit wird die ständig wachsendes Ökosystem von KI-Code-Assistenten flexibler und leistungsfähiger.

Für Entwickler bedeutet das auch, dass sie in Zukunft weniger Angst vor veraltetem KI-Wissen haben müssen und stattdessen effektiv mit ihren digitalen Kollegen zusammenarbeiten können. Dennoch ist klar, dass die Technik noch nicht perfekt ist. Nicht jeder Kontext ist auf Anhieb optimal aufbereitet oder relevant. Eine gewisse Pflege, Auswertung und Optimierung der zugeführten Informationen bleibt notwendig. Auch müssen Entwickler lernen, den richtigen Mittelweg zu finden zwischen zu viel und zu wenig Kontext.

Dennoch ist die Richtung eindeutig – KI wird immer intelligenter, je besser wir sie mit dem für die jeweilige Aufgabe relevanten Wissen unterstützen. Abschließend betrachtet zeigt die Kontextstrategie klar, wie man durch gezielte Informationseinspielung die Defizite veralteter Wissensbasis bei LLMs überwinden kann. Von der Integration spezifischer Dokumentation bis zur Nutzung spezialisierter Tools wie Context7 oder GitMCP ergeben sich deutliche Vorteile in Effizienz, Genauigkeit und Zuverlässigkeit. Wer seine KI-Assistenten heute aufrüstet und mit maßgeschneidertem Kontext füttert, profitiert morgen von deutlich produktiveren Workflows sowie einem quasi unerschöpflichen Pool an stets aktuellem Wissen – und das ohne auf ein potenziell veraltetes Lernmodell zu setzen. Dies ist eine wichtige Erkenntnis in einer Ära, in der technologische Veränderungen immer schneller voranschreiten und die Anforderungen an Software-Entwicklung enorm wachsen.

Wer als Entwickler oder Unternehmen seine KI-Werkzeuge clever mit aktuellem Kontext kombiniert, gestaltet den entscheidenden Unterschied bei der erfolgreichen Automatisierung und digitalen Transformation.

![Measurement Data (1996) [pdf]](/images/F7F053AE-4BCC-4012-9A42-8ABC37C8A8B4)