Im Jahr 2024 könnte man leicht den Eindruck gewinnen, dass erfolgreiche Softwareentwicklung nur mit einem riesigen Technologiestapel und Milliarden von Nutzern funktioniert. Begriffe wie Microservices, Kubernetes, Kafka, ElasticSearch, Lastenausgleich, sharded Datenbanken und Redis-Caching sind in aller Munde und gelten als unverzichtbare Bestandteile moderner Anwendungen. Doch wie oft wird dabei übersehen, dass nur die wenigsten Projekte überhaupt eine solche Skalierung benötigen? Die Realität sieht oft völlig anders aus: Viele Anwendungen werden nie mit Hunderttausenden oder gar Millionen von Nutzern konfrontiert, geschweige denn mit Milliarden. Stattdessen sind sie Side Projects, MVPs oder kleine Dienste, die sich allzu oft mit Technologien überladen, die schlichtweg unnötig sind. Die zentrale Fragestellung lautet deshalb: Brauchen wir diese ausgefeilten Systeme tatsächlich? Oder sollten wir uns vielmehr auf das konzentrieren, was in der Praxis meistens viel sinnvoller und effizienter ist – das Skalieren nach unten, auch als vertikales Skalieren bekannt? Vertikales Skalieren bedeutet, die Leistung und Kapazität einer einzigen Maschine zu erhöhen, beispielsweise durch mehr CPUs, mehr Arbeitsspeicher oder schnellere SSDs.

In den letzten Jahren haben sich diese Ressourcen enorm verbessert. CPUs werden immer schneller, RAM ist erschwinglich und SSDs bieten blitzschnelle Zugriffszeiten. In vielen Fällen passt die gesamte Datenbank sogar in den Arbeitsspeicher, was Abfragen unglaublich beschleunigt. Noch bis vor ein paar Jahren liefen ganze Unternehmen auf nur einem einzigen Server. Warum also sollte ein kleines Projekt mit wenigen Tausend Nutzern auf einem Cluster von mehreren Knoten laufen? Oft steckt hinter solchen Entscheidungen das Streben nach vermeintlicher Zukunftssicherheit, nach einem System, das schon heute für einen Erfolg an der Spitze gewappnet sein soll.

Das führt unweigerlich zu sogenannter „vorzeitiger Optimierung“ – also dazu, dass Entwickler und Unternehmen Ressourcen und Zeit in Komponenten investieren, die aktuell noch gar nicht gebraucht werden. Die Konsequenzen sind vielfältig. Erstens entsteht eine unnötige Komplexität, die den Entwicklungsprozess verlangsamt, Fehlerquellen vermehrt und die Wartung erschwert. Zweitens steigen die Kosten exponentiell an, was bei kleinen Teams und privaten Projekten schnell zur Größte Hürde wird. Drittens leidet die Fähigkeit, schnell iterative Verbesserungen vorzunehmen, da Deployment-Prozesse durch Cluster-Management und Orchestrierung enorm aufwändig werden.

Dabei ist Skalieren an sich nicht falsch oder gar überflüssig. Im Gegenteil: wenn eine Applikation tatsächlich wächst und der Bedarf besteht, sollte man skalieren. Aber eben dann, wenn es notwendig ist und nicht schon im Vorhinein, ohne realen Grund. Ein Ansatz, der zunehmend an Bedeutung gewinnt, ist das bewusste „Skalieren nach unten“ beziehungsweise das Konzentrieren auf einfache, überschaubare Systeme, die leicht auf einem einzelnen Server oder sogar auf dem Laptop laufen können. Die Vorteile dieser Herangehensweise sind vielfältig.

Das Deployment wird kinderleicht: ein einzelner Server, ein virtuelles privates Server (VPS) oder sogar das eigene Notebook genügt. Dadurch entfallen aufwendige Cluster-Konfigurationen und Orchestrierungs-Tools. Die Entwicklungs- und Produktionsumgebung gleichen sich oft zu hundert Prozent, was Fehler im Betrieb minimiert. Auch die kognitive Belastung für Entwickler sinkt erheblich. Weniger bewegliche Teile bedeuten weniger potenzielle Probleme und weniger Grenzen, die bedacht werden müssen.

Die Debugbarkeit verbessert sich deutlich, denn ein einzelner Service produziert eine einzelne Stack Trace – keine Notwendigkeit für Distributed Tracing oder die Überwachung komplexer Netzwerkpartitionen. Als Nebeneffekt reduziert sich auch der finanzielle Aufwand beträchtlich. Kleinere Server sind günstig, weniger Infrastrukturkosten bedeuten mehr Geld für andere sinnvolle Investitionen. Nicht zuletzt verbessert sich auch die Agilität. Der typische Ablauf gestaltet sich deutlich schlanker: Code ändern, deployen und fertig.

Keine umständlichen Pipelines oder lange Wartezeiten. Eine solche Denkweise fordert Entwickler dazu auf, beim nächsten Mal, wenn die Frage „Skaliert es?“ auftaucht, genauer hinzuschauen und zu klären, in welche Richtung überhaupt skaliert werden soll – nach oben oder nach unten? Ein ausgezeichnetes Beispiel für den Erfolg dieser Herangehensweise liefert das Tool Bugsink, eine selbstgehostete Fehlerverfolgungslösung. Entwickler Klaas van Schelven zeigt eindrucksvoll, dass Bugsink Millionen von Fehlern pro Tag auf einem einzigen, preiswerten Server verarbeiten kann. Dies beweist, dass es nicht immer ein gigantisches Setup braucht, um leistungsfähig zu sein. Zudem ist das Konzept des „Majestic Monolith“ eine wichtige Gegenposition zu den zerklüfteten Microservices.

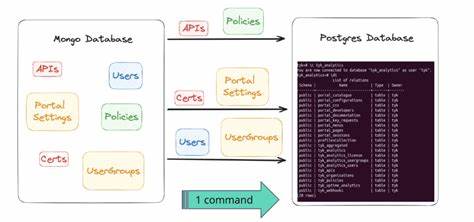

Monolithische Anwendungen, richtig gebaut, können ebenso leistungsstark, wartbar und skalierbar sein – und zwar mit deutlich weniger Overhead. Studien und Erfahrungsberichte bekräftigen, dass viele Datenbanken vollständig im Arbeitsspeicher gehalten werden können, was Abfragen deutlich beschleunigt und die gesamte Architektur vereinfacht. MongoDB zum Beispiel propagiert klar: „Your data fits in RAM“ und nutzt das als Vorteil für performantere Systeme. Natürlich gibt es Ausnahmen und Szenarien, in denen horizontales Skalieren unausweichlich ist. Projekte, die Millionen bis Milliarden von Nutzern bedienen, große Datenmengen in Echtzeit verarbeiten oder extrem hohe Ausfallsicherheit bieten müssen, benötigen komplexe verteilte Systeme.

Doch diese Fälle sind nicht die häufige Norm, sondern eher die Ausnahme. Wer frühzeitig auf Horizontal Scaling setzt – also das Verteilen der Last auf viele kleine Instanzen – stellt sich vielen Herausforderungen: Komplexe Netzwerkkommunikation, Konsistenzprobleme, Latenzen, Synchronisation und vieles mehr. Insbesondere kleine Teams oder Solo-Entwickler profitieren enorm davon, zunächst auf ein kleines Setup zu setzen, das leicht verständlich, günstig, wartbar und agil ist und das Wachstum Schritt für Schritt nachvollzieht. Ein weiterer Aspekt ist die Geschwindigkeit, mit der Ideen umgesetzt und getestet werden können. Bei großen, komplexen Systemen vergehen oft Tage oder Wochen von der Entwicklung bis zur produktiven Nutzung.

Beim Skalieren nach unten reicht manchmal ein einfacher Neustart des Servers oder eine schnelle Aktualisierung der Anwendung. Dies fördert die Innovationskraft und kurze Feedbackzyklen – zwei Schlüsselelemente in modernen Entwicklungsprozessen. Letztlich lohnt es sich also, die hegemoniale Vorstellung vom Skalieren grundlegend zu hinterfragen und stattdessen die Vorzüge von kleinen, effizienten Systemen zu erkennen. Der Fokus sollte auf einem simplen Einstieg liegen. Das bedeutet, mit einem System zu starten, das auf wenigen Ressourcen läuft, überschaubar ist und die wesentlichen Funktionen einfach abbildet.