In der heutigen datengetriebenen Welt stehen Unternehmen vor der Herausforderung, extrem große Datenmengen nahezu in Echtzeit zu verarbeiten und gleichzeitig flexibel mit verschiedenartigen, sich schnell ändernden Datenstrukturen umzugehen. Besonders im Bereich des Nutzerdaten-Managements, bei dem Nutzerprofile und verhaltensbezogene Eigenschaften kontinuierlich aktualisiert werden, wird es schwierig, eine skalierbare und performant abrufbare Lösung zu finden. Hier setzen innovative Ansätze an, die die Stärken mehrerer Technologien kombinieren: Ein herausragendes Beispiel ist die Simulation von Bigtable in BigQuery mit einer Type 2 Slowly Changing Dimension (SCD) Modellierung, um enorme Mengen an Mutationsevents zu verarbeiten – teilweise über 100.000 Änderungen pro Sekunde – ohne an Performance einzubüßen. Dieser Ansatz eröffnet neue Möglichkeiten für Unternehmen, das Beste aus beiden Welten zu nutzen: die flexible, hochperformante Speicherung von Bigtable und die analytische Stärke von BigQuery.

Dabei adressiert die Verbindung dieser Technologien eine der zentralen Herausforderungen modernen Datenmanagements: wie kann eine Infrastruktur geschaffen werden, die sowohl schemafreie, heterogene Updates schnell und zuverlässig aufnimmt als auch diese Datenversionen in einer konsistenten und analytisch nutzbaren Form bereitstellt? Während Bigtable von Haus aus für hohe Durchsatzraten bei schemalosen, flexiblen Nutzerdaten prädestiniert ist, erfordert BigQuery im Gegensatz dazu ein strukturiertes Datenmodell. Dieser Gegensatz stellt Unternehmen vor einen komplexen Spagat, der mit traditioneller Architekturen oft nur mit großem Aufwand bewältigt werden kann. Um diese Barriere zu überwinden, haben Ingenieure bei Statsig einen neuartigen Daten-Pipeline-Ansatz entwickelt. Nutzer-Property-Updates, welche typischerweise aus verschiedenartigen Quellen kommen – von SDKs, die in Kundenanwendungen eingebettet sind, bis hin zu Bulk-Uploads über Web-Konsolen – werden zunächst in Bigtable erfasst. Bigtable glänzt dabei durch seine Fähigkeit, tausende unterschiedliche Eigenschaften pro Nutzer in flexiblen Spaltenfamilien zu speichern, ohne vom Nutzer festgelegtes Schema.

Die Zugriffszeiten bleiben dabei konstant niedrig, selbst bei Millionen von Schreiboperationen pro Sekunde, dank der Unterstützung von Cross-Region-Replikationen. Die wichtigste Komponente ist hierbei die Aktivierung von Change Streams, einer Art Änderungsprotokoll, das jede Mutation zeitlich geordnet aufzeichnet und somit eine Historie der Nutzerattribute ermöglicht. Im nächsten Schritt wird über Dataflow eine Streaming-Pipeline aufgebaut, die das Änderungsprotokoll von Bigtable aufgreift und auf BigQuery überträgt. Dabei verwendet das System eine Bigtable-zu-BigQuery-Streaming-Vorlage, die zuverlässig für Ordnungs- und Wiederholungs-Guarantees sorgt, ohne dass zusätzlich komplexe Pipeline-Logik implementiert werden muss. Ein entscheidender Vorteil dieser Lösung liegt in der niedrigen End-to-End-Latenz von nur wenigen Minuten, was es Kunden erlaubt, ihre Nutzerdaten nahezu in Echtzeit für Dashboards und Analysen einzusetzen.

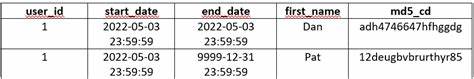

Auf BigQuery-Seite findet die Transformationsarbeit statt: Das Rohdaten-Change-Log wächst mit der Zeit enorm, weshalb eine Aggregationsstufe notwendig ist, um Daten in einer übersichtlichen, performanten Struktur verfügbar zu machen. Hier kommt das Type 2 Slowly Changing Dimension Datenmodell zum Einsatz, das alle Versionen jeder Nutzer-Eigenschaft chronologisch ablegt und gleichzeitig den jeweils „aktuellen“ Stand kenntlich macht. Diese SCD-Tabelle ist nach Inaktivierungsdatum partitioniert und nach Nutzer-ID, Eigenschaftsname sowie Einfügezeitpunkt geclustert. Diese Struktur optimiert sowohl zeitpunktgenaue historische Abfragen als auch schnelle Abfragen des aktiven Nutzerstatus. Der Kernvorgang besteht aus einer planmäßigen MERGE-Operation, die neue Mutationseinträge in die bestehende SCD-Tabelle integriert, wo sie anhand von Schlüsselfeldern eingefügt oder existierende Versionen entsprechend markiert werden, ohne jedoch Löschvorgänge zu unterstützen.

Durch diese aufwändige Verarbeitung entstehen keine doppelten Schreibwege und die Konsistenz bleibt gewahrt. Ein weiterer wesentlicher Performancehebel ergibt sich aus der Nutzung von fein granularem Data Manipulation Language (DML) in BigQuery, das derzeit noch in einer privaten Vorschauphase verfügbar ist. Statt jede Aktualisierung einzeln durchzuführen, können durch diese Funktion mehrere Mutationen gebündelt und effizient ausgeführt werden, was signifikante Kosteneinsparungen ermöglicht und die Slot-Auslastung deutlich reduziert. Für Unternehmen mit hohen Update-Raten ist dies von enormem Wert, da das bisherige Modell allein durch BigQuery-DML erheblich teuer und weniger performant gewesen wäre. Die flexible Modellierung mit Type 2 SCD bietet den Anwendern zudem die Möglichkeit, komplexe zeitbezogene Analysen durchzuführen.

So lassen sich zum Beispiel aktuelle Eigenschaften eines Nutzers ebenso abfragen wie der Zustand zu einem beliebigen historischen Zeitpunkt. Die Historienabfragen bieten detaillierte Einblicke in die Entwicklung einzelner Nutzermerkmale über Zeit, was für datenbasierte Produktoptimierung, Personalisierung oder auch A/B-Tests besonders relevant ist. Die Kombination aus Partitionierung und Clustering ermöglicht dabei eine effiziente Datenfilterung, sodass Abfragen trotz der großen Datenmengen rasch ausgeführt werden können. Diese Art der Architektur vereint die Stärken zweier Big-Data-Technologien auf geniale Weise und präsentiert sich als eine einzigartige Lösung, die sowohl Skalierbarkeit als auch Kosteneffizienz in großen throughput-intensiven Umgebungen ermöglicht. Sie überwindet typische Limitationen bestehender Systeme, wo entweder Flexibilität oder Performance zum Flaschenhals wird.

Für moderne Analytics-Anwendungen, die Echtzeitdaten aus vielfältigen und dynamischen Quellen integrieren möchten, ist dies ein wegweisender Fortschritt. Abschließend ist hervorzuheben, dass dieses Modell weit über reine technische Raffinessen hinausgeht. Es adressiert die wachsenden Bedürfnisse von Unternehmen, die in immer kürzeren Zyklen verzahnte, nutzerzentrierte Insights liefern müssen, ohne dabei Kompromisse hinsichtlich Datenintegrität oder Kosten einzugehen. Darüber hinaus ist die Lösung speziell durch die Kombination von Industriestandardprodukten innerhalb der Google Cloud Platform für Unternehmen verschiedener Branchen anwendbar – von B2B SaaS über E-Commerce bis hin zu Gaming. Mit der genannten Simulationsarchitektur aus Bigtable und BigQuery können Entwickler und Dateningenieure maßgeschneiderte Pipelines aufbauen, die flexibel auf neue Anforderungen reagieren, zugleich für stabile Betriebsabläufe sorgen und mit skalierbarer Performance überzeugen.

In einer Zeit rascher technischer Innovationen und sich stetig verändernder Nutzererwartungen ist diese Kombination ein robustes Fundament für die datengetriebene Produktentwicklung der Zukunft.