Die digitale Welt wird zunehmend geprägt von großen, verteilten Softwaresystemen, die eine hohe Flexibilität und Skalierbarkeit bieten. Mit diesen Vorteilen gehen jedoch auch neue Herausforderungen einher, insbesondere hinsichtlich der Zuverlässigkeit und Stabilität der Systeme im Produktiveinsatz. Komplexe Abhängigkeiten zwischen einzelnen Diensten und unvorhersehbare Wechselwirkungen können zu unerwarteten Ausfällen oder Performanceeinbrüchen führen. In diesem dynamischen Umfeld gewinnt Chaos Engineering als eine spezielle Disziplin zunehmend an Bedeutung, um die Belastbarkeit solcher Systeme gezielt zu testen und zu stärken. Chaos Engineering beschreibt die Kunst und Wissenschaft, gezielte Experimente auf produktiven Systemen durchzuführen, um zu prüfen, wie gut diese Systeme unter realen und oftmals turbulenten Bedingungen funktionieren.

Ziel ist es, Vertrauen in die Stabilität der Systeme zu schaffen, indem Schwachstellen frühzeitig identifiziert und adressiert werden. Dies geschieht, bevor diese Schwächen zu gravierenden Ausfällen oder negativen Kundenerfahrungen führen können. Eines der grundlegenden Merkmale verteilter Systeme ist, dass selbst wenn alle einzelnen Komponenten korrekt funktionieren, die Interaktionen zwischen ihren Teilen unvorhergesehene und störende Ergebnisse verursachen können. Dieses Verhalten trägt wesentlich zur inhärenten Unbeständigkeit und Komplexität moderner Softwarelandschaften bei. Zudem können seltene, aber verheerende Ereignisse wie Serverabstürze, Netzwerkunterbrechungen oder Überlastungen von Diensten die Systemstabilität massiv beeinträchtigen.

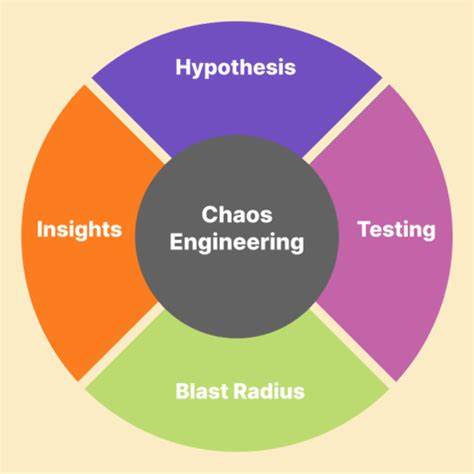

Um diesen Herausforderungen zu begegnen, sieht Chaos Engineering vor, genau solche Szenarien gezielt zu simulieren und systematisch zu testen. Der Prozess beginnt mit der Definition eines sogenannten „Steady State“, also eines messbaren Zustands, der das normale und erwartete Verhalten des Systems beschreibt. Dies kann beispielsweise die durchschnittliche Antwortzeit, der Durchsatz von Anfragen oder die Fehlerrate sein. Ausgehend von diesem Normalzustand wird eine Hypothese aufgestellt, dass das System diesen stabilen Zustand auch dann beibehält, wenn bestimmte Störungen auftreten. Im nächsten Schritt werden Variablen eingeführt, die echte Störfälle und Ausfälle in der Produktion simulieren.

Das können beispielsweise das gezielte Abschalten von Servern, das Verursachen von Netzwerkausfällen oder das Herausrufen von Verzögerungen in Datenbanken sein. Indem die Auswirkungen dieser Störungen auf den Steady State überwacht werden, wird versucht, die ursprüngliche Hypothese zu widerlegen. Gelingt es, den stabilen Zustand zu destabilisieren, hat das experimentelle Setup eine Schwäche des Systems aufgedeckt. Dies ist genau der Moment, in dem Entwickler und Betreiber gezielt Maßnahmen zur Verbesserung der Widerstandsfähigkeit ergreifen können. Die Anwendung von Chaos Engineering folgt mehreren zentralen Prinzipien, die einen besonders wirksamen Einsatz gewährleisten.

Zunächst liegt der Fokus auf messbaren Ergebnissen, die das Verhalten des gesamten Systems repräsentieren. Dies ist wichtig, da die interne Architektur, bestehend aus vielfältigen Services und Komponenten, sehr komplex und sich ständig wandelnd ist. Verlässlich ist die Betrachtung des Gesamtsystems nur durch objektive Kenngrößen wie Performance, Fehlerrate oder Latenzen, die in kurzer Zeit intervalle beobachtet werden. Nur so lässt sich sicherstellen, dass das System seine Funktion unter Belastung tatsächlich aufrechterhält. Ein weiterer wichtiger Aspekt ist die Ausgestaltung der zu testenden Variablen, die reale Ereignisse im Betrieb simulieren.

Hierbei sollten sowohl systembedingte Fehlerquellen, wie Hardwaredefekte oder Softwarefehler, als auch nicht fehlerhafte, aber stark belastende Situationen, etwa plötzliche Trafficspitzen oder Skalierungsvorgänge, berücksichtigt werden. Die Auswahl der zu testenden Szenarien orientiert sich nach deren möglichem Schadenspotenzial und der Häufigkeit ihres Auftretens in der Realität. Besonders hervorzuheben ist die Tatsache, dass Chaos Engineering bevorzugt direkt im produktiven Umfeld durchgeführt wird. Systeme können sich außerhalb der Produktion durch abweichende Datenflüsse oder Nutzerverhalten stark unterschiedlich verhalten. Nur im Live-Betrieb lassen sich daher verlässliche Erkenntnisse darüber gewinnen, wie Stabilität unter realen Bedingungen entsteht oder versagt.

Dies erhöht zwar das Risiko temporärer Störungen, aber gleichzeitig schafft es die authentischste Testumgebung für belastbare Ergebnisse. Um diesen Prozess effizient und skalierbar zu gestalten, werden Chaos-Experimente zunehmend automatisiert und kontinuierlich ausgeführt. Manuelle Eingriffe sind zeitlich und personell aufwändig und können die Häufigkeit von Tests begrenzen. Automatisierung ermöglicht regelmäßige Prüfungen, die bekannte Schwachstellen immer wieder gezielt herausfordern und das System dauerhaft überwachen. Damit einher geht das Prinzip der Minimierung der sogenannten „Blast Radius“.

Damit wird der potenzielle Umfang negativer Nebenwirkungen eines Experiments auf Kunden oder Systemeinsätze so gering wie möglich gehalten. Ziel ist es, das Risiko für Nutzer und Kernkomponenten durch eine Kombination aus sorgfältiger Planung, Bereitstellung von Kontrollmechanismen und gestaffelten Versuchen zu begrenzen. Die Bedeutung von Chaos Engineering wächst in der Softwareentwicklung stetig. Unternehmen, die ihre Systeme skalierbar und robust gestalten möchten, ohne dabei die Innovationsgeschwindigkeit zu beeinträchtigen, profitieren von einem strukturierten Ansatz zur Handhabung systemischer Unsicherheiten. Die immer komplexer werdenden Softwarelandschaften mit variierenden Nutzungsprofilen und externalen Faktoren benötigen neue Wege, um Ausfälle präventiv zu verhindern.

Chaos Engineering liefert hier das notwendige methodische Rüstzeug. Es unterstützt das technische Team dabei, eines der essenziellen Probleme moderner Software zu lösen: die Unvorhersehbarkeit von Fehlern in komplexen, verteilten Architekturen. Neben der technischen Umsetzung fördert Chaos Engineering auch eine Kultur der kontinuierlichen Verbesserung und Offenheit im Umgang mit Fehlern. Es setzt dort an, wo klassische Monitoring- und Teststrategien an ihre Grenzen stoßen und schafft ein besseres Verständnis dafür, wie ein System tatsächlich in produktiven Situationen performt. Große Technologiekonzerne und Cloud-Anbieter haben Chaos Engineering bereits intensiv in ihre Betriebsprozesse integriert und zeigen, dass sich damit Ausfallzeiten deutlich reduzieren und Kundenanfragen stabiler bewältigen lassen.

Für Organisationen, die eine moderne IT-Landschaft betreiben, ist es mittlerweile fast unverzichtbar, eine Form von Chaos Engineering zu implementieren. Dabei ist der Einstieg auch für kleinere Teams möglich, indem sukzessive mit wenigen, gut kontrollierten Simulationen begonnen wird. Über die Zeit lassen sich die Verfahren und Tools an die individuellen Anforderungen und technischen Gegebenheiten anpassen und erweitern. Chaos Engineering ist somit nicht nur ein technisches Instrument, sondern auch ein strategischer Hebel, um innovative Geschäftsmodelle auf zuverlässige Weise umzusetzen. Es schafft die notwendige Vertrauensbasis dafür, dass komplexe Systeme in dynamischen Umgebungen produktiv und stabil zugleich betrieben werden können.

Letztlich steht Chaos Engineering für eine neue Qualität in der resilienten Softwareentwicklung, die darauf abzielt, Unsicherheiten zu beherrschen und so die Basis für nachhaltigen Erfolg zu legen.