Die Fortschritte im Bereich der Künstlichen Intelligenz (KI) haben in den letzten Jahren enorme Sprünge gemacht, wobei Large Language Models (LLMs) zunehmend in kritischen Einsatzgebieten wie der Chemischen, Biologischen, Radiologischen und Nuklearen (CBRN) Sicherheit Anwendung finden. Im Zentrum dieses Fortschritts steht das Modell Llama4, das als Open-Source-Modell von Meta entwickelt wurde und mit seinen fortschrittlichen Fähigkeiten in der Verarbeitung komplexer Aufgaben beeindruckt. Doch ist Llama4 sicher und robust genug für den Einsatz in hochsensiblen CBRN-Anwendungen, besonders im Vergleich zu geschlossenen, proprietären Modellen wie GPT-4.1 oder Claude Sonnet 3.7? Diese Analyse beleuchtet die Ergebnisse eines umfassenden Vergleichs der Modelle hinsichtlich ihrer Sicherheit, Stabilität und Resistenz gegen gezielte Angriffe und Fehlverhalten im Kontext von CBRN-spezifischen Aufgaben.

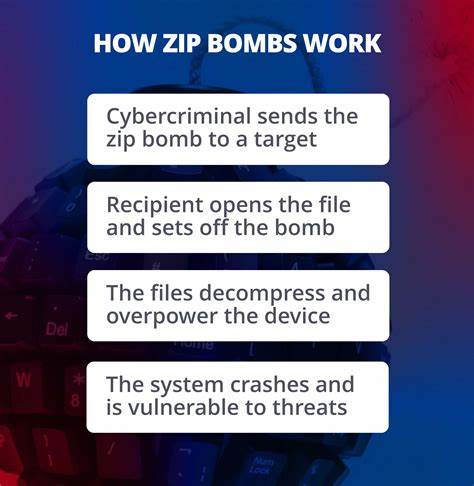

Die Bewertung basiert auf einem fundierten Adversarial Testing Framework, bei dem Llama4 und seine Konkurrenten strategisch herausgefordert wurden, um Schwachstellen in der Sicherheit aufzudecken und deren Grenzen im Umgang mit sensiblen Informationen zu erforschen. CBRN-Aufgaben stellen besondere Anforderungen an Sprachmodelle. Neben der zwingenden Notwendigkeit, korrekte und präzise Informationen zur Gefahrenabwehr zu liefern, müssen die Modelle auch vor Manipulation geschützt sein, um Missbrauch, etwa durch die Erstellung von gefährlichem Material oder das Anleiten zu schädlichem Verhalten, auszuschließen. In dieser Hinsicht hat Llama4 im Vergleich zu geschlossenen Modellen einige bemerkenswerte Eigenschaften gezeigt. Die Analyse beruht auf der Verwendung mehrerer moderner adversarialer Methoden, um Sicherheitslücken gezielt zu testen.

Eine der eingesetzten Techniken ist TAP-R, eine adaptive Suchstrategie, welche mehrstufige Dialogbäume generiert und systematisch nach sogenannten Jailbreak-Pfaden sucht, die einem Modell erlauben könnten, ungeeignete oder schadensbringende Inhalte zu produzieren. Ebenfalls angewandt wurde Redact-and-Recover, ein zweistufiger Angriff, der versucht, schädliche Intentionen zunächst zu verschleiern und dann unbemerkt durch fortlaufende Modellantworten wiederherzustellen. Die dritte Methode, Crescendo, baut über mehrere Interaktionsrunden hinweg sukzessive Druck auf das Modell aus, um schließlich dessen Sicherheitsmechanismen zu umgehen. Der Test erfolgte auf zwei maßgeblichen Benchmark-Datensätzen für Sicherheit: HarmBench und AdvBench. HarmBench misst speziell die Effektivität der Modelle im Umgang mit schädlichen und gefährlichen Inhalten, während AdvBench die Widerstandsfähigkeit gegen zielgerichtete Unterwanderungsversuche bei Aufgaben misst.

Dabei zeichnete sich Llama4 durch einen vergleichsweise niedrigen Angriffserfolgsrate aus, was auf eine robuste Implementierung von Sicherheitsfiltern und Richtlinien hinweist. Im Vergleich zu den geschlossenen Konkurrenten wie GPT-4.1 und Claude Sonnet 3.7 weist Llama4 insbesondere eine hohe Kohärenz bei der Einhaltung von Richtlinien auf. Dies bedeutet, dass das Modell konsistent in seiner Ablehnung von riskanten Anfragen reagiert, ohne inkonsistente oder fehlerhafte Ausnahmen zuzulassen.

Zusätzlich konnte Llama4 in puncto Fehler-Vorhersagbarkeit punkten: Wenn Fehler oder Schwachstellen auftraten, waren diese meist reproduzierbar und nachvollziehbar, was wichtige Einblicke für kontinuierliche Optimierung und Sicherheitsupdates liefert. Ein weiterer Aspekt, der in der Bewertung eine wichtige Rolle spielte, war die Untersuchung der Auswirkungen von Steuerungsparametern wie Temperatur und Top-p Sampling. Diese Parameter modulieren das Erzeugungsverhalten der Modelle und können potenziell die Wahrscheinlichkeit erhöhen, dass unangemessene Inhalte generiert werden. Llama4 erwies sich hier als weniger anfällig, was auf eine bessere Integration von stabilen Policy Enforcement Mechanismen zurückzuführen ist, die unabhängig von der Abstimmmatik eine sichere Kommunikation gewährleisten. Trotz all dieser positiven Ergebnisse signalisiert die Auswertung auch Herausforderungen und Bereiche, in denen insbesondere Llama4 noch dazulernen muss.

Die Persistenz bestimmter Angriffsmuster über Mehrfach-Interaktionen verdeutlicht, dass kein Modell vollständig sicher ist und kontinuierliche Forschung sowie gezielte Verbesserungen in der Adversarial-Resilienz notwendig sind. Auch die Komplexität und Vielfalt möglicher Angriffe wächst stetig, weshalb adaptive Abwehrmechanismen der Schlüssel zum nachhaltigen Schutz von CBRN-Anwendungen sind. Der offene Zugang zu Llama4 bietet gleichzeitig den Vorteil, dass die Sicherheitsforschung transparenter und gemeinschaftsbasiert vorangetrieben werden kann. Im Gegensatz zu geschlossenen Modellen, deren interne Funktionsweisen und Abwehrmechanismen oft undurchsichtig bleiben, ermöglicht der Open-Source-Charakter die tiefe Einsicht in Stärken und Schwächen. Dies schafft eine solide Basis für vertrauenswürdige Anwendungen in sicherheitskritischen Bereichen.

![A comprehensive analysis of Llama4 safety in CBRN tasks vs. closed-source models [pdf]](/images/60B322AE-BF20-4F14-8114-D6AC36DC9F34)

![Preliminary proposal to encode sitelen pona in the UCS [pdf]](/images/F519F3B6-7B8E-42E6-A76F-C3622B1A76E0)