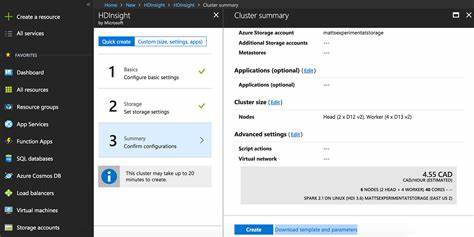

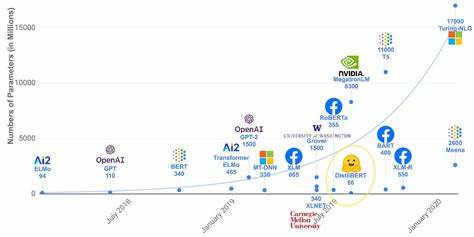

Mit der rasanten Entwicklung von Künstlicher Intelligenz (KI) und automatisierten Agenten steht die IT-Welt vor neuen Herausforderungen, insbesondere wenn es um den Zugriff auf sensible Cloud-Ressourcen wie Microsoft Azure geht. In vielen Unternehmen ist Microsoft Azure eine zentrale Plattform zur Verwaltung von Infrastruktur, Anwendungen und Daten. Die Überlegung, KI-Agenten den Zugriff auf Azure-Schlüsselbund oder Keychains zu ermöglichen, wirft wichtige Fragen hinsichtlich Sicherheit, Zugriffsrights und Vertrauen auf – die in diesem Beitrag eingehend beleuchtet werden. Autonome KI-Agenten gewinnen zunehmend an Bedeutung, indem sie Routineaufgaben übernehmen und komplexe Workflows automatisieren. So entstehen Effizienzgewinne, etwa wenn KI-Agenten im Hintergrund Lieferantenrechnungen abrufen, Systeme überwachen oder Konfigurationsänderungen vorschlagen.

Doch diese agentenbasierte Automation funktioniert nur, wenn die künstlichen Agenten sich sicher authentifizieren und autorisieren können. Hier stellt sich die Frage: Kann und sollte ein Unternehmen einem KI-Agenten Zugriff auf seinen Azure-Keychain gewähren? Ein Kernthema dabei ist die Agenten-Authentifizierung. Während traditionelle Anwendungen über strikt kontrollierte Zugangsdaten verfügen, ist die Situation bei autonomen Agenten komplizierter. Diese agieren in Abwesenheit von Menschen und benötigen daher eine Art vertrauenswürdigen Zugang, der jedoch nicht die Sicherheitsstandards wie mehrfach verifizierte Passwörter oder eine Zwei-Faktor-Authentifizierung außer Kraft setzen darf. Denn die Verteilung von Zugangsdaten an Programme birgt grundsätzlich Sicherheitsrisiken – das Missbrauchspotenzial steigt, wenn unzureichende Beschränkungen gelten.

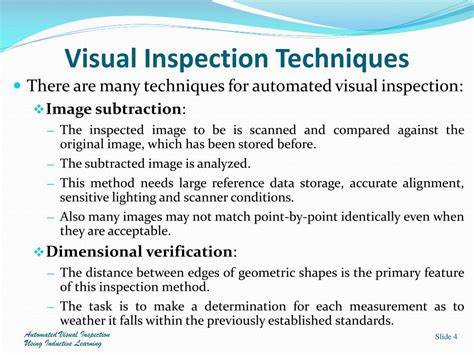

Aus Sicht moderner Sicherheitssysteme sollte der Zugriff auf den Azure-Keychain durch granulare, fein abgestufte Berechtigungen kontrolliert werden. Das bedeutet, dass ein Agent nicht pauschal „alles“ darf, sondern nur jene Aktionen, die für seine Funktion unbedingt notwendig sind. Wichtig sind hier Mechanismen, die Zugriffe zeitlich begrenzen, bestimmte Ressourcentypen freigeben oder Funktionen einschränken. Solche Zugriffsrechte könnten zum Beispiel über OAuth-Protokolle oder vergleichbare Identitäts- und Zugriffsmanagement-Systeme (IAM) erteilt und überwacht werden. Die Realität zeigt, dass viele KI-Agenten aktuell noch nicht über einen solchen differenzierten Berechtigungssatz verfügen.

Die Folge können ungewollte Zugriffe auf sensible Kontodaten oder Einstellungen sein, wenn Agenten etwa umfassende Azure-Accounts durchsuchen, anstatt nur Rechnungen zu sammeln oder Berichte zu generieren. Für Unternehmen bedeutet das ein erhebliches Risiko, denn ohne klare Grenzen drohen Datenschutzverstöße, Compliance-Probleme und im schlimmsten Fall finanzielle Schäden. Ein weiterer wesentlicher Aspekt betrifft das Konzept der Einwilligung und der Nachvollziehbarkeit der Aktionen. Wie kann man sicherstellen, dass ein Agent nur jene Funktionen nutzt, denen er ausdrücklich zugestimmt wurde? Anders als bei klassischen APIs, bei denen Nutzer bei jeder Zugriffserteilung explizit informieren und zustimmen, fehlen solche Standards bislang für autonome Agenten. Es bedarf neuer Modelle, die eine „Zustimmungsverwaltung“ für KI-Agenten ermöglichen.

Die Diskussion gipfelt in der Überlegung, ob die Sicherheit und Verwaltung der Zugangsdaten sowie der Berechtigungen in der Verantwortung der Agentenplattformen, der Cloud-Anbieter oder unabhängig davon bei spezialisierten Sicherungsdiensten wie Passwortmanagern liegen sollte. Passwortmanager bieten bereits Multi-Faktor-Zugriffe, zeitlich begrenzte Zugangsfreigaben und Protokollierungen, doch sie sind nicht automatisch darauf ausgelegt, Agenten-spezifische Zugriffskontrollen zu managen. Im technologischen Diskurs taucht auch die Idee eines Multi-Agenten-Kontrollprotokolls (MCP) auf, welches die Zusammenarbeit und Sicherheit mehrerer autonomer Agenten regeln könnte. Ein solches Protokoll würde erlauben, Rechte zentral zu definieren, Zugriffe zu protokollieren und Reaktionen bei Regelverstößen zu ermöglichen. Damit könnten Unternehmen die Sicherheit ihrer Cloud-Zugänge deutlich erhöhen und gleichzeitig die Vorteile intelligenter Automatisierung nutzen.

Unternehmen, die ihre Cloud-Ressourcen mit KI-Agenten managen, sollten zunächst sorgfältig analysieren, welche Zugriffsrechte unbedingt notwendig sind und wie die Agenten identifiziert und überprüft werden können. Zudem empfiehlt es sich, die Dauer der Zugriffsrechte zu limitieren und räumliche Beschränkungen oder IP-Whitelistings einzuführen. Regelmäßige Audits und das schnelle Widerrufen von Zugriffsrechten sind weitere Maßnahmen, um Missbrauch vorzubeugen. Transparenz und Protokollierung der Aktionen von KI-Agenten spielen eine zentrale Rolle für eine nachvollziehbare Governance. Nur wenn Unternehmen Einblick in die Vorgänge haben, lässt sich Vertrauen zu einer KI-basierten Automatisierung aufbauen.

Dies ist gerade in europäischen Datenschutzkontexten, etwa der DSGVO, von besonderer Bedeutung. Dabei müssen Entwickler und Anbieter von KI-Agenten eng mit Sicherheitsverantwortlichen zusammenarbeiten, um geeignete Authentifizierungs- und Autorisierungskonzepte zu entwerfen. Dabei stehen Technologien wie Zero Trust Security, rollenbasierte Zugriffsmodelle und sichere Schlüsselverwaltung im Fokus. Zugleich gilt es, die Benutzerfreundlichkeit und Effizienz nicht aus den Augen zu verlieren, damit Automatisierungslösungen eine breite Akzeptanz gewinnen. Parallel zur technischen Entwicklung beobachtet man auch regulatorische Tendenzen, die den Einsatz von KI-Agenten transparenter und sicherer gestalten wollen.

Datenschutzbehörden und Standardisierungsgremien könnten in Zukunft klare Vorgaben schaffen, Vertrauensmodelle definieren oder sogar spezialisierte Zertifizierungen für KI-Agentenzugriffe einführen. Zusammenfassend ist die Übertragung von Microsoft Azure Zugangsdaten an autonome KI-Agenten ein komplexes Thema, das sowohl Potenziale als auch Risiken birgt. Der Schlüssel zu einer sicheren und effizienten Nutzung liegt in der Umsetzung einer granularen, flexiblen und transparenten Zugriffskontrolle, die mit den Anforderungen moderner Sicherheitsarchitekturen kompatibel ist. Kreative neue Konzepte wie ein Multi-Agenten-Kontrollprotokoll könnten helfen, den nächsten Schritt in der sicheren Cloud-Automatisierung zu gehen. Die Zukunft zeigt, dass Unternehmen, die klare Strategien für den Umgang mit KI-Agenten-Zugangsdaten entwickeln, Wettbewerbsvorteile durch Prozessautomatisierung erzielen können, gleichzeitig jedoch den Schutz ihrer sensiblen Daten jederzeit gewährleisten müssen.

Nur so verankert sich das Vertrauen in automatisierte Systeme und schafft einen sicheren Rahmen für den digitalen Fortschritt.