In den letzten Jahren hat Künstliche Intelligenz (KI) einen enormen Einfluss auf verschiedene Bereiche unseres Lebens genommen. Während die Technologie viele Chancen eröffnet, zeigt sich zunehmend, dass sie auch als Werkzeug für verdeckte Operationen und gezielte Einflussnahmen dient. OpenAI, eines der weltweit führenden Forschungsunternehmen für KI, hat kürzlich eine Reihe von verdeckten Operationen aufgedeckt und gestoppt, die eng mit China sowie anderen Staaten verbunden sind. Diese Enthüllungen geben neue Einblicke, wie KI-basierte Tools wie ChatGPT in großem Umfang missbraucht werden, um Meinungen zu manipulieren, Desinformationen zu verbreiten und sogar interne Dokumente und Berichte für illegale Zwecke zu generieren. Die Verwendung von KI durch staatlich unterstützte Akteure ist keine neue Erscheinung, aber die Raffinesse und Vielfalt der Taktiken, die in den letzten Monaten sichtbar wurden, sind bemerkenswert.

Besonders China wird in dem Bericht von OpenAI als ein zentraler Akteur genannt, der eine Bandbreite an verdeckten Operationen steuert, die von der Generierung von Social-Media-Inhalten bis hin zu komplexen Überwachungs- und Spionagetätigkeiten reichen. Die Forschungsteams von OpenAI identifizierten allein in einem Zeitraum von drei Monaten ganze zehn derartige Operationen und sorgten für die Sperrung der entsprechenden Konten. Vier dieser Operationen wurden wahrscheinlich in China orchestriert, konnten jedoch Länder über alle Kontinente hinweg anvisieren. Eines der am ausführlichsten untersuchten Beispiele ist die sogenannte Operation „Sneer Review“. Diese wurde von OpenAI als eine komplexe Einflusskampagne beschrieben, bei der ChatGPT für die Erstellung kurzer Kommentare in verschiedenen Sprachen eingesetzt wurde – darunter Englisch, Chinesisch und Urdu.

Diese Kommentare wurden auf populären Plattformen wie TikTok, X (ehemals Twitter), Reddit oder Facebook veröffentlicht. Die thematische Bandbreite der Posts umfasste unter anderem Kritik, aber auch Lobeshymnen zum politischen Kurs der Trump-Administration im Kontext der Auflösung der US-Entwicklungsagentur USAID. Interessanterweise wurden auch Gaming-Inhalte gezielt angegriffen, vor allem ein taiwanesisches Strategiespiel, das Spieler dazu ermutigt, die Kommunistische Partei Chinas herauszufordern. Die Social-Media-Strategie von Sneer Review ging jedoch weit über das bloße Veröffentlichen von Beiträgen hinaus. So generierte die Operation Kommentare nicht nur als einzelne Meinungsäußerungen, sondern auch als Gesprächsverläufe mit sich selbst.

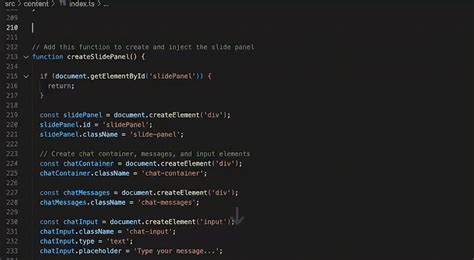

Diese künstlich erzeugte Interaktion hatte das Ziel, Authentizität und organische Engagement vorzutäuschen – ein klassisches Mittel in der Desinformationsstrategie, um den Eindruck einer breiten und spontanen Zustimmung oder Ablehnung zu erwecken. Zusätzlich wurde ein langer Artikel erstellt, der eine vermeintlich breite Ablehnung des besagten taiwanesischen Spiels ausführlich darlegte, obwohl diese Reaktion künstlich konstruiert war. Ein besonders brisantes Detail ist, dass die Akteure hinter diesem Netzwerk ChatGPT nicht nur für die Erstellung öffentlicher Inhalte nutzten, sondern auch für interne Zwecke wie das Schreiben von detaillierten Leistungsbeurteilungen, die dokumentierten, wie die Operation organisiert und durchgeführt wurde. Diese Transparenz, die unbeabsichtigt durch interne Dokumente entstand, half den Forschern von OpenAI, die gesichteten Social-Media-Aktivitäten konkret mit den dokumentierten Abläufen zu verknüpfen und die Echtheit der Beobachtungen zu bestätigen. Neben Einfluss- und Meinungsmanipulationen wurde KI auch im Rahmen umfangreicher Spionageaktivitäten angewendet.

Dabei ging es unter anderem um eine Operation, bei der sich die Verantwortlichen als Journalisten und geopolitische Analysten ausgaben. Mittels ChatGPT wurden Biografien für Fake-Accounts auf sozialen Plattformen wie X erstellt, ebenso wie Übersetzungen von Nachrichten und E-Mails – beispielsweise von Chinesisch ins Englische – vorgenommen. Darüber hinaus unterstützte die KI die Analyse von Daten, darunter auch Korrespondenz, die angeblich an einen US-Senator gerichtet war und sich mit der Nominierung eines Regierungsbeamten beschäftigte. Zwar konnte OpenAI diese spezifische Nachricht nicht unabhängig verifizieren, doch die Tatsache, dass solche sensible Kommunikation ins Visier genommen wurde, verdeutlicht die Ernsthaftigkeit der Bedrohung. Eine weitere interessante Facette betraf das Erstellen von Marketingmaterialien, die offen behaupteten, soziale Medien für fingierte Kampagnen und zur gezielten Spionage zu nutzen.

Diese Selbstdarstellung stimmte mit den tatsächlichen Aktivitäten überein und illustriert, wie geschickt die Akteure versuchen, ihre Operationen zu verschleiern oder gar mit falschen Narrativen zu untermauern. Bereits in früheren Berichten hatte OpenAI ähnliche Überwachungsoperationen entlarvt, etwa von einer chinesischen Quelle, die angeblich soziale Protestbewegungen im Westen observierte und diese Informationen an chinesische Sicherheitsdienste weiterleitete. Die KI wurde dort nicht nur zur Datenauswertung, sondern sogar zum Debuggen von Code verwendet – ein Hinweis darauf, wie tief KI-Integration in solche Aktivitäten mittlerweile reicht. Die Maßnahmen von OpenAI erstrecken sich allerdings nicht nur auf China. Die neueste Berichterstattung erwähnt auch verdeckte Einflussoperationen, die mit Russland und Iran in Verbindung gebracht werden.

Daneben wurden kommerzielle Spam-Aktionen aus den Philippinen, Rekrutierungsschwindel aus Kambodscha und manipulative Jobangebote mit nordkoreanischem Hintergrund aufgedeckt. Diese Vielfalt zeigt, dass taktische KI-Nutzung für zweifelhafte Zwecke ein globales Problem darstellt und nicht nur auf einzelne Staaten beschränkt ist. OpenAIs Principal Investigator für Intelligenz und Ermittlungen, Ben Nimmo, betont auf einer Pressekonferenz die Bandbreite und Vielschichtigkeit der eingesetzten Taktiken und Plattformen. Obwohl die meisten der operativen Netzwerke früh entdeckt und abgeschnitten wurden, bevor sie große echte Publikumsgruppen erreichten, ist die angelegte Methodik besorgniserregend. Nimmo verweist zudem darauf, dass die Verwendung von KI nicht zwangsläufig zu mehr Engagement führt.

Effizientere Tools verbessern nicht automatisch die Erfolgsrate solcher Einflussoperationen. Diese Erkenntnisse werfen ein grelles Licht auf die Sicherheitsrisiken, die neben der technologischen Innovation durch KI entstehen. Für Plattformbetreiber, Nutzer und Regulierungsbehörden ergeben sich wichtige Herausforderungen: Wie können Missbrauchsformen rechtzeitig erkannt und gestoppt werden? Welche Maßnahmen sind nachhaltig, ohne legitime Nutzung von KI zu behindern? Und wie lässt sich die Öffentlichkeit für die Risiken von Desinformation durch technisch unterstützte Einflussnahme sensibilisieren? Die Bemühungen von OpenAI sind ein bedeutender Schritt in diese Richtung. Das Aufdecken und Zerschlagen der beschriebenen Kampagnen zeigt, dass es möglich ist, KI-gestützten Missbrauch einzudämmen, wenn Unternehmen und Forschungseinrichtungen aktiv gegen derartige Aktivitäten vorgehen. Dabei ist die Zusammenarbeit zwischen Technologieanbietern, Regierungen und internationalen Institutionen unerlässlich, um die Integrität digitaler Räume zu schützen.

Gleichzeitig verdeutlicht die Situation auch, wie aggressiv und zielgerichtet Staaten und andere Akteure digitale Plattformen als Schlachtfeld der Informationskriege nutzen. Während KI neue Chancen für Kommunikation und Analyse bietet, eröffnet sie auch neue Angriffsflächen, die es zu verstehen und zu verteidigen gilt. Insgesamt muss die Gesellschaft ein Bewusstsein dafür entwickeln, wie Technologien der nächsten Generation nicht nur das Leben bereichern, sondern auch das Gefüge globaler Machtverhältnisse beeinflussen. OpenAIs Arbeit und die öffentlich zugänglichen Berichte sind dabei wertvolle Ressourcen, um die Dynamiken hinter verdeckten Operationen zu entschlüsseln und fundierte Antworten auf die Herausforderungen der digitalen Zukunft zu finden.