Die rasante Weiterentwicklung künstlicher Intelligenz hat in den letzten Jahren zahlreiche Bereiche revolutioniert – von der Sprachverarbeitung über Bildgenerierung bis hin zu kreativer Musikproduktion. Eine der bemerkenswertesten Innovationen kommt aktuell aus dem Hause Google DeepMind mit der Lyria RealTime API. Dieses KI-basierte System steht für einen entscheidenden Schritt in Richtung interaktiver, generativer Musikmodelle, die in Echtzeit reagieren und von Nutzern gesteuert werden können. Damit eröffnet sich ein völlig neuer kreativer Raum für Musiker, Entwickler und Künstler weltweit. Lyria RealTime ist mehr als nur ein Algorithmus, der Musik komponiert.

Es steht für ein fortschrittliches Modell, das sogenannte „Live Music Models“ integriert. Diese Modelle ermöglichen eine direkte und unmittelbare Interaktion mit der generierten Musik. Das bedeutet, Nutzer können die musikalische Produktion live beeinflussen und anpassen, ähnlich wie bei der Bedienung eines traditionellen Musikinstruments. Die API schafft damit eine Brücke zwischen der künstlichen Intelligenz und der ursprünglichen künstlerischen Intuition. Der Kern der Technologie basiert auf der Anpassung der bewährten MusicLM-Architektur.

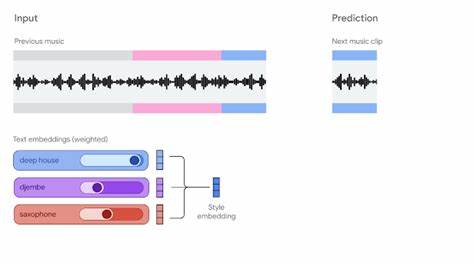

Anders als herkömmliche text-zu-Musik-Generatoren, die oft zeitverzögert arbeiten und deren Ergebnisse eher statisch sind, arbeitet Lyria RealTime mit Blockautoregresseion. Hierbei werden Musikstücke in aufeinanderfolgenden, kurzen Abschnitten generiert, wobei jeder Abschnitt vom vorherigen abhängt. Dieses Prinzip sorgt für eine kontinuierliche, fließende Musikausgabe, die sich dynamisch an die Steuerung der Nutzer anpasst. Besonders beeindruckend ist die niedrige Latenz, die Lyria RealTime bietet. Ein Maximum von zwei Sekunden Verzögerung zwischen der Eingabe eines Steuerbefehls und der musikalischen Umsetzung garantiert eine nahezu unmittelbare Rückkopplung.

Diese Echtzeitfähigkeit ist essenziell für musikalische Improvisationen und Live-Performances, in denen jede Sekunde zählt – genau wie bei der Interaktion mit einem traditionellen Instrument. Die Steuerbarkeit der API eröffnet ein breites Spektrum musikalischer Eingriffe. Anwender können Tempo, Tonart, dichte der Notenanschläge und die Präsenz einzelner Instrumentengruppen wie Schlagzeug oder Bass einstellen. Weitere Parameter wie spektrale Helligkeit oder die Einstellung von Sampling-Temperatur und Top-k-Parametern ermöglichen eine gezielte Kontrolle über die kreative Variabilität der generierten Musik. So kann die Musik genau an den gewünschten Stil, die Stimmung oder das Klangbild angepasst werden.

Mit dieser Flexibilität eignet sich die Lyria RealTime API nicht nur für Musiker, sondern auch für Entwickler von Anwendungen im Bereich der digitalen Audio-Workstations. Ein Beispiel dafür ist das von DeepMind entwickelte VST-Plugin „The Infinite Crate“, das die Integration von Lyria RealTime in professionelle Produktionsumgebungen ermöglicht. Dadurch wird die KI-gestützte Musikgenerierung nahtlos Teil bereits etablierter Produktionsprozesse. Darüber hinaus stehen im Google AI Studio mehrere Open-Source-Demos zur Verfügung, die als Ausgangspunkt für eigene Projekte dienen können. Unter den bekanntesten Interfaces finden sich verschiedene Varianten von PromptDJ, bei denen Prompts kombiniert und mittels Reglern in Echtzeit gesteuert werden können.

Diese Tools laden nicht nur Entwickler ein, eigene Kreativtools zu entwickeln, sondern bieten auch Musikliebhabern die Möglichkeit, sich spielerisch mit KI-Musik auseinanderzusetzen. Ein besonderer Fokus der Lyria RealTime API liegt auf der Interaktivität und dem „Mensch-im-Loop“-Ansatz. Anders als viele textbasierte Musikgeneratoren, bei denen das Endprodukt im Vordergrund steht, ist hier der kreative Prozess und die unmittelbare Rückmeldung in den Vordergrund gerückt. Jede Eingabe und sogar jede Unterlassung des Nutzers beeinflusst unmittelbar den musikalischen Verlauf, was zu einzigartigen und sehr persönlichen Kompositionen führt. Die API kann darüber hinaus als Instrument für Performance und experimentelle Musik genutzt werden.

Bei Google I/O 2025 demonstrierte der bekannte Musiker Toro y Moi live auf der Bühne die beeindruckenden Möglichkeiten des Systems. Sein Spiel mit einer MIDI-Controller-gestützten Oberfläche zeigte, wie Lyria RealTime als echtes Instrument zur Improvisation dienen kann, das Publikum mit aufregenden, spontanen musikalischen Momenten begeistert und den Künstler selbst inspiriert. Neben der Live-Performance eignet sich die Technologie auch hervorragend für die Schaffung interaktiver Klanglandschaften in physischen oder virtuellen Räumen. Anwendungen etwa in Kunstinstallationen, Videospielen oder immersiven Medienprojekten profitieren von der Fähigkeit, auf Nutzerinteraktionen oder Umgebungsdaten in Echtzeit musikalisch zu reagieren. Technisch gesehen stellt die Realisierung einer solchen Echtzeitsystematik eine große Herausforderung dar.

Musikgenerierung erfordert enorme Rechenleistung, insbesondere bei hoher Audioqualität mit 48 kHz Stereo-Streams. Gleichzeitig muss die Berechnung kausal sein, also ohne zukünftigen Kontext auskommen, um online und in Echtzeit arbeiten zu können. Lyria RealTime meistert diese Aufgabe durch ausgeklügelte architektonische Anpassungen und effiziente Algorithmen. Die Arbeit an Lyria RealTime ist noch lange nicht abgeschlossen. Das DeepMind-Team arbeitet kontinuierlich an der nächsten Generation dieser Modelle mit dem Ziel, die Klangqualität zu verbessern, die Latenz weiter zu senken, die Interaktivität zu erhöhen und eine On-Device-Nutzung möglich zu machen.

Diese Fortschritte versprechen, KI-gestützte Musikmodelle noch zugänglicher und spielbarer zu machen, sodass Künstler und Hobbyisten gleichermaßen davon profitieren können. Die Lyria RealTime API steht im Kontext einer größeren Bewegung, die das Verhältnis von Musiker und Instrument neu definiert. Künstliche Intelligenz wird nicht mehr nur als Werkzeug verstanden, sondern als Partner in künstlerischen Prozessen. Mit dem Fokus auf Echtzeit-Kollaboration zwischen Mensch und Maschine entstehen neue Formen des musikalischen Ausdrucks, die tief in der Interaktivität verwurzelt sind. Für Entwickler eröffnet sich durch die offene API eine Vielzahl an Möglichkeiten, eigene Anwendungen, Instrumente oder Performancetools zu kreieren.