Im Zentrum eines juristischen Skandals steht derzeit der Anwalt des bekannten MyPillow-Gründers Mike Lindell, der sich nicht nur als ein glühender Unterstützer von Donald Trumps Wahlkampf, sondern auch als eine umstrittene Figur im Zusammenhang mit den Wahlergebnissen der US-Präsidentenwahl 2020 hervorgetan hat. Lindell sieht sich einer Verleumdungsklage gegenüber, eingereicht von Eric Coomer, einem ehemaligen Mitarbeiter von Dominion Voting Systems. Coomer wirft Lindell vor, ihn durch seine öffentlich geäußerten Behauptungen über angeblichen Wahlbetrug diffamiert zu haben. Doch obwohl die Ausgangslage bereits angespannt und komplex ist, hat sich die Situation durch das jüngst bekannt gewordene Verhalten von Lindells Anwalt dramatisch verschärft. In einem Gerichtsverfahren in Denver wurde enthüllt, dass Anwalt Christopher Kachouroff ein Schriftsatz vorgelegt hat, der mithilfe eines Chatbots erstellt wurde und der ungewöhnlich viele Fehler enthält – insbesondere fast 30 erfundene und nicht existierende juristische Zitate.

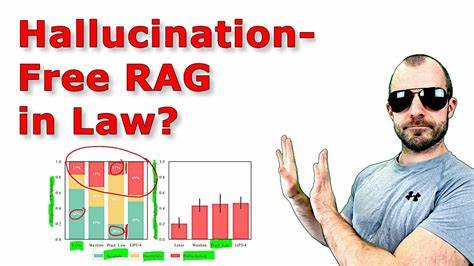

Diese entpuppen sich als massive Verstöße gegen die beruflichen Standards in der Rechtswissenschaft und werfen grundsätzliche Fragen darüber auf, wie künstliche Intelligenz (KI) in der Rechtsprechung eingesetzt werden sollte. Die Enthüllung erfolgte im Rahmen einer Anfrage von Bezirksrichterin Nina Wang, die den Hintergrund dieser pikanten Fehlinformationen aufdecken möchte. Trotz mehrfachen Nachfragens weigerte sich Anwalt Kachouroff zunächst, zu erklären, wie der Schriftsatz in dieser Form entstehen konnte. Erst nach wiederholtem Nachhaken gab er zu, dass die wesentlichen Fehler darauf zurückzuführen seien, dass er generative KI zum Erstellen des Dokuments verwendet habe, ohne die verwendeten Quellen und Zitate anschließend sorgfältig zu überprüfen. Das wirft nicht nur ein schlechtes Licht auf die Sorgfaltspflichten des Anwalts, sondern auch auf die wachsenden Herausforderungen beim Einsatz neuer Technologien im juristischen Bereich.

Der Einsatz von KI-Systemen, die automatisch Texte generieren, ist zwar in verschiedensten Branchen mittlerweile üblich, doch im rechtlichen Kontext kann ein falscher oder gefälschter Verweis auf eine juristische Autorität weitreichende Folgen haben – etwa indem die Glaubwürdigkeit der eingereichten Schriftsätze infrage gestellt wird oder die Rechtsprechung durch Fehlinformationen beeinträchtigt wird. Die Debatte um Ethik und Verantwortung im Umgang mit KI ist deshalb in der Justiz besonders relevant und dringend. Seitdem dieser Fall publik wurde, hat Richterin Wang den Anwälten Kachouroff und Jennifer DeMaster eine Frist bis zum 5. Mai gesetzt, um zu erklären, wie diese gravierenden Fehler hätten passieren können. Sollte die Erklärung nicht zufriedenstellend sein, drohen den beiden Juristen Disziplinarmaßnahmen aufgrund von Verstößen gegen die berufsrechtlichen Pflichten.

Der Fall verdeutlicht eindrücklich, dass eine unkritische Nutzung von künstlicher Intelligenz in Rechtsangelegenheiten nicht nur fatal sein kann, sondern auch schnell das Vertrauen in das Rechtssystem untergräbt. Die Verantwortlichen sind offensichtlich dem zunehmenden Druck durch hohe Arbeitsbelastung und die Verlockungen durch automatisierte Tools erlegen, die versprechen, den bürokratischen Aufwand zu reduzieren und schneller Ergebnisse zu liefern. Doch ohne die nötige Kontrolle und manuelle Prüfung können solche Werkzeuge zur Quelle von Fehlinformationen werden. Die öffentliche Aufmerksamkeit auf diesen Fall reflektiert eine breitere Besorgnis über den zunehmenden Einfluss von KI-Technologien auf traditionelle Berufsbereiche, die auf Präzision und verlässliche Quellen angewiesen sind. Juristisch gesehen muss die Integrität eines Schriftsatzes uneingeschränkt gegeben sein – Fehler in Zitaten, Erfindungen von Fällen oder unsaubere Quellenangaben sind nicht nur nachlässig, sondern können auch der Manipulation gleichkommen.

In den USA und vielen anderen Rechtssystemen gelten strenge Regeln zur Zitation, die ein grundlegendes Element der Professionalität und Glaubwürdigkeit darstellen. Die offensichtliche Nachlässigkeit von Lindells Anwalt wirft daher die Frage auf, wie oft ähnliche Fehlentwicklungen im Zuge des KI-Booms bereits unbemerkt geblieben sind. Neben dem juristischen Aspekt wirft dieser Vorfall auch ethische und gesellschaftliche Fragen auf. Wie stark darf sich die Justiz auf automatisierte Systeme verlassen? Können juristische Fachkräfte und Gerichte in Zukunft darauf bauen, dass mittels KI erstellte Schriftsätze korrekt und überprüfbar sind? Die Antwort darauf ist offenbar nicht einfach und besteht aktuell aus einem Spannungsfeld zwischen Effizienzsteigerung und dem Erhalt von Qualitätssicherung. Der Fall MyPillow-Gründer mag exemplarisch sein, aber er mahnt zugleich zu großer Vorsicht und einer kritischen Haltung gegenüber dem Einsatz von KI im rechtlichen Umfeld.

Juristische Experten und Wissenschaftler diskutieren mittlerweile aktiv, wie der Umgang mit KI-Tools an Mandanten, Anwälte und Gerichte geregelt werden sollte, um Missbrauch zu verhindern. Dabei geht es auch um klar definierte Standards zur Verifizierung von Inhalten sowie um Schulungsmaßnahmen, damit Juristen die technischen Grenzen der Systeme besser verstehen und entsprechende Kontrollmechanismen einführen. Die Nutzung von KI ist nicht per se problematisch; sie bietet auch große Chancen für die Analyse komplexer Rechtslagen, schnellere Literaturrecherche und Automatisierung wiederkehrender Aufgaben. Doch solange ein menschliches Kontrollorgan stets sicherstellt, dass alle zitierten Informationen korrekt und nachvollziehbar sind, kann KI eine wertvolle Ergänzung sein. Ohne angemessene Kontrolle kann der Einsatz solcher Technologien jedoch katastrophale Folgen nach sich ziehen – so wie es im Lindell-Fall passiert ist.

Die Justizbehörden beobachten nun genau, wie diese Angelegenheit ausgeht, denn sie hat das Potenzial, als Präzedenzfall zu dienen. Darüber hinaus reflektiert der Vorfall auch die gesamtgesellschaftlichen Herausforderungen, die mit der digitalen Transformation einhergehen: Wie geht man mit neuen Technologien um, die zwar enorme Möglichkeiten eröffnen, aber auch Risiken für Qualität, Fairness und Transparenz mit sich bringen? Für Experten steht fest, dass die Akzeptanz von KI in sensiblen Bereichen wie der Rechtsprechung niemals auf Kosten von Standards und Verantwortung gehen darf. Der Fall des MyPillow-Gründers Mike Lindell und seines Anwalts Christopher Kachouroff bietet deshalb nicht nur eine spannende juristische Auseinandersetzung, sondern wird auch als Weckruf für die gesamte Rechtswelt verstanden. Es bleibt zu hoffen, dass aus diesem Debakel Konsequenzen gezogen werden, die den sinnvollen und zugleich sicheren Einsatz von KI-Tools im Rechtswesen fördern und für klare Regeln sorgen, die sowohl den Schutz der Mandanten als auch die Integrität der Gerichte gewährleisten. Gemeinsam mit einer ethischen Leitlinie kann der intelligenten Automatisierung somit der Weg geebnet werden, ohne dass sich Fehler wie falsche oder erfundene Zitate wiederholen.

Insgesamt zeigt dieser Vorfall, dass menschliches Urteilsvermögen und die unverzichtbare Prüfung jeder Information durch Fachleute auch im Zeitalter der KI nicht ersetzt werden können. Im Gegenteil: Sie sind wichtiger denn je. Nur so kann der Rechtsstaat seine Glaubwürdigkeit und Stabilität bewahren – auch in einer Welt, in der Technologien immer mächtiger und allgegenwärtiger werden.