Am 17. Juni 2025 erlebte GitHub, die führende Plattform für Software-Entwicklung und Versionsverwaltung, eine bedeutende Störung, die mehrere seiner zentralen Dienste betraf. Zwischen 19:32 UTC und 20:03 UTC kam es infolge eines internen Deployments einer Routingpolicy zu erheblichen Erreichbarkeitsproblemen bei einzelnen Netzwerkadressen innerhalb der eigenen Rechenzentren. Diese Störung führte zu Fehlerquoten und Leistungseinbußen, die sowohl authentifizierte als auch nicht authentifizierte Nutzer beeinträchtigten. Die folgende Analyse betrachtet die Ursachen, den Verlauf, die Nutzungsauswirkungen und die Maßnahmen, die GitHub in Reaktion auf das Ereignis ergriffen hat, und gibt einen Ausblick auf präventive Strategien zur Vermeidung ähnlicher Vorfälle in der Zukunft.

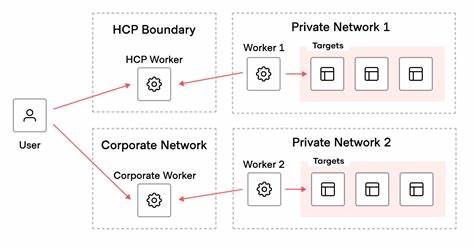

Die Ursachen und der technische Hintergrund des Ausfalls liegen im Bereich der Netzwerkinfrastruktur. Konkret wurde eine Routingpolicy auf einem Teil der Netzwerkgeräte ausgerollt, die dazu führte, dass bestimmte Netzwerkadressblöcke innerhalb der Rechenzentren nicht mehr zuverlässig erreichbar waren. Dies führte zu Fehlern bei der Datenübertragung und Zugriffsproblemen auf diverse Dienste der Plattform. Während des Ereignisses erfuhren authentifizierte Benutzer der GitHub-Weboberfläche moderate Fehlerquoten von drei bis vier Prozent. API-Aufrufe von authentifizierten Nutzern waren sogar von einer Fehlerquote von etwa 40 % betroffen.

Nicht authentifizierte Zugriffe auf UI und API litten am stärksten und erreichten nahezu hundertprozentige Fehlerquoten während der Störungszeit. Die Auswirkungen auf die einzelnen Dienste bestätigten die weitreichende Betroffenheit des Vorfalls. Der Actions-Service, der sich um die Automatisierung von Entwicklungsprozessen wie Continuous Integration und Continuous Deployment kümmert, verzeichnete Verzögerungen bei rund zweieinhalb Prozent der durchgeführten Läufe mit durchschnittlichen fünf- bis achtminütigen Verzögerungen. Zusätzlich schlugen etwa drei Prozent der Läufe fehl. GitHub Large File Storage (LFS), der für die Handhabung großer Binärdateien zuständig ist, verzeichnete ebenfalls Fehler, wenn auch in geringerem Umfang bei etwa 0,978 Prozent.

Bereits wenige Minuten nach dem Auftreten der Probleme reagierte GitHub, indem das fehlerhafte Routingpolicy-Deployment um 19:54 Uhr UTC zurückgerollt wurde. Die Netzwerkanbindung zu den betroffenen Systemen konnte dadurch sukzessive wiederhergestellt werden. Die vollständige Wiederherstellung der Dienste und der Normalbetrieb wurden um 20:03 UTC verkündet. Dies zeigt eine effiziente Reaktionsfähigkeit seitens der Betreiber, die durch Monitoring-Systeme und Incident-Response-Prozesse unterstützt werden. Im Verlauf der Störung gab es zahlreiche Statusupdates von GitHub, die transparent über den Zustand der einzelnen Dienste informierten.

Dienste wie Pull Requests, Issues, Pages und Copilot sowie Webhooks waren zunächst entweder von stark beeinträchtigter Verfügbarkeit oder von Leistungseinbußen betroffen. Einige Dienste besserten sich bereits kurz nach der Rücknahme der problematischen Routingänderung. So meldeten einige Komponenten bereits gegen 20:10 UTC oder kurz danach wieder normale Betriebszustände. Besonders betroffen waren Dienste wie Copilot, die KI-gestützte Codeassistenz, sowie API Requests und Codespaces, die alle erhebliche Leistungseinbußen oder Verfügbarkeitsprobleme vermeldeten. Die Störung hat sehr deutlich gemacht, wie eng verzahnt und komplex die Infrastruktur hinter Plattformen wie GitHub ist, und wie Fehler in der Infrastruktur sich schnell und breit auswirken können.

Das Ereignis veranschaulicht aber auch, dass eine durchdachte Fehlererkennung und Rückgriffsmöglichkeiten bei Deployments essenziell sind, um Folgen so gering wie möglich zu halten. Die schnelle Reaktion mit der Rückrollaktion des Routing-Deployments war entscheidend dafür, dass die Ausfallzeit auf nur etwa 30 Minuten begrenzt werden konnte. Vor dem Hintergrund dieses Vorfalls hat GitHub angekündigt, den Validierungsprozess für Routingpolicy-Änderungen zu erweitern und zu verbessern, um ähnliche Probleme in der Zukunft zu vermeiden. Dies beinhaltet sehr wahrscheinlich strengere Prüfungen bei internen Netzwerkkonfigurationen, höhere Testabdeckung sowie möglicherweise den Einsatz von Canary-Deployments mit schrittweiser und überwachten Ausleitung der Änderungen. Die Sensibilität bezüglich solcher infrastruktureller Eingriffe steigt somit nachvollziehbar.

Für Entwickler, Administratoren und DevOps-Teams zeigt der Vorfall exemplarisch, wie kritisch eine robuste und redundante Netzwerkinfrastruktur für die Stabilität und Verfügbarkeit moderner SaaS-Plattformen ist. Auch wenn GitHub in der Regel eine sehr hohe Verfügbarkeit gewährleistet, sind Störungen durch menschliche Fehler oder technische Probleme nie vollkommen auszuschließen. Gleichzeitig macht diese Episode die Bedeutung transparenter Kommunikation in Krisen deutlich. Die regelmäßigen und detaillierten Statusupdates durch GitHub trugen maßgeblich dazu bei, das Vertrauen der Nutzer zu erhalten und ihnen Informationen zur Lage und zum Fortschritt der Behebung zu liefern. Eine offene Fehlerkommunikation ist somit ein wesentlicher Baustein für professionelles Incident-Management.

Ausblickend wird sich die Plattform weiterhin darauf konzentrieren, ihre Infrastruktur widerstandsfähiger und ausfallsicherer zu gestalten. Das Thema Netzwerksicherheit und Netzwerkmanagement wird hierbei eine zentrale Rolle spielen. Parallel sind technische Weiterentwicklungen im Bereich der Automatisierung von Validierung und Deploymentprozessen entscheidend, um die Komplexität kontrollierbar zu halten und menschliche Fehlerquellen zu minimieren. Zusammenfassend stellt der Juni-Ausfall bei GitHub einen bedeutenden Vorfall dar, der exemplarisch für die Herausforderungen moderner Cloud-Infrastrukturen steht. Er zeigt den Einfluss von Netzwerkproblemen auf eine Vielzahl integrierter Dienste und macht die Wichtigkeit von schnellem Handeln, umfassender Überwachung, sowie transparenter Kommunikation eindeutig.

Für Anwender bleibt zu hoffen, dass die getroffenen Verbesserungen tatsächlich zu noch stabileren und zuverlässigeren Betriebsbedingungen führen, damit künftige Entwicklungsprojekte störungsfrei realisiert werden können. Die intensive Auseinandersetzung mit technischen Ursachen und Reaktionsmaßnahmen versetzt GitHub in eine gute Ausgangslage, um solche Ereignisse künftig noch besser zu meistern.