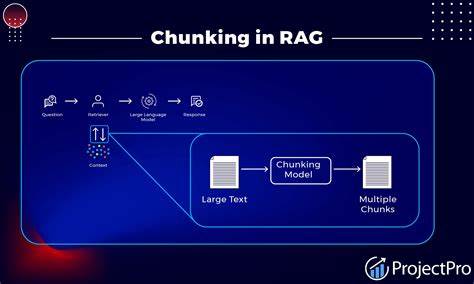

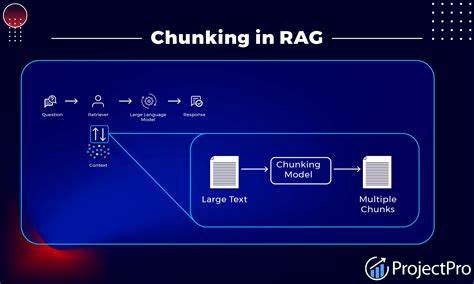

Retrieval-Augmented Generation, kurz RAG, hat in den letzten Jahren erheblich an Bedeutung gewonnen. Es vereint die Leistungsfähigkeit großer Sprachmodelle mit der Fähigkeit, Informationen aus externen Datenquellen abzurufen, um fundierte und kontextgetriebene Antworten zu generieren. Eine der entscheidenden Komponenten in einem RAG-System ist das sogenannte Chunking, also die Zerlegung großer Dokumente in handhabbare Textabschnitte oder „Chunks“. Ohne eine effektive Chunking-Strategie leidet die Qualität der Informationsbeschaffung, die Antwortgenauigkeit und schließlich auch die Benutzererfahrung. Doch wie bewertet man unterschiedliche Chunking-Methoden zuverlässig und effizient? Diese Frage ist zentral für Entwickler und Forscher, die RAG-Systeme optimieren wollen.

Der Schlüssel liegt in einem methodischen, datengetriebenen Ansatz, der Kosten, Zeit und Qualität berücksichtigt. Zunächst ist es wichtig, den Wert von Chunking im RAG-Kontext zu verstehen. Große Textmengen sind für ein Sprachmodell oft zu umfangreich, um sie in einem Kontextfenster unterzubringen. Zudem verhindert Chunking, dass irrelevante oder fehlgeleitete Informationen in den Antwortprozess einfließen. Die Aufteilung muss dabei sorgfältig erfolgen, um semantisch sinnvolle und inhaltlich zusammenhängende Abschnitte zu gewährleisten.

Es gibt verschiedenste Methoden, darunter rekursive Zeichenteilung, semantisches Chunking oder agentisches Chunking, welche jeweils ihre Vor- und Nachteile besitzen. Allerdings bewährt sich keine Methode universell in jedem Anwendungsfall. Die Auswahl erfordert daher fundierte Evaluation. Ein nachvollziehbarer Evaluationsprozess beginnt stets mit der Stichprobenbildung. Aufgrund der oft gigantischen Datenmengen in Produktionsumgebungen ist es unmöglich, alle Dokumente vollumfänglich zu analysieren.

Stattdessen wählt man eine repräsentative Teilmenge aus, die die Vielfalt der Daten abbildet. Beispielsweise sollten unterschiedliche Dokumenttypen wie Präsentationen, Case Studies und Gesprächsprotokolle proportional berücksichtigt werden. So kann sichergestellt werden, dass die Evaluation aussagekräftig und übertragbar ist. Nach der Datenauswahl folgt die Erstellung eines Bewertungssets in Form von Testfragen. Diese Fragen dienen dazu, die Retrieval- und Antwortqualität eines RAG-Systems zu prüfen.

Idealerweise entwickelt ein fachkundiger Mensch diese Fragen, wobei das jedoch oft zeit- und ressourcenintensiv ist. Mit modernen Sprachmodellen kann dieses Problem teilweise elegant gelöst werden, indem sie zur Fragegenerierung eingesetzt werden. Für diese Aufgabe ist ein leistungsfähiges Modell mit ausgeprägter logischer und semantischer Kompetenz empfehlenswert. Durch gezieltes Prompting entstehen vielfältige und anspruchsvolle Fragen, die eine differenzierte Beurteilung erlauben. Das Herzstück der Evaluation bildet das automatisierte Testen der Chunking-Strategien innerhalb eines vollständigen RAG-Setups.

Hierfür werden die ausgewählten Dokumente gemäß der jeweiligen Strategie segmentiert, die daraus entstehenden Chunks in einem Vektor-Datenbanksystem abgelegt und für die Retrieval-Phase verwendet. Typischerweise kommt eine leicht handhabbare Vektor-DB wie Chroma zum Einsatz, wobei die Wahl der Datenbank auch vom spezifischen Use Case und den technischen Gegebenheiten abhängt. Das System generiert anschließend auf Basis der abgerufenen Kontextinformationen Antworten auf die zuvor erstellten Testfragen. Bewertungstools wie RAGAS helfen dabei, die Antworten hinsichtlich mehrerer qualitativer Metriken zu analysieren. Dazu gehören Antwortrelevanz, Glaubwürdigkeit der Antwort (Faithfulness), Präzision und Recall des Kontextes sowie die Korrektheit der Antwort.

Diese Dimensionen geben Aufschluss darüber, wie gut die Chunking-Strategie die wesentlichen Informationen erfasst und an das Sprachmodell weitergibt. Zusätzlich fließen Laufzeitdaten wie Generierungs- und Abrufzeiten in die Beurteilung ein, denn Effizienz ist ein nicht zu vernachlässigender Aspekt in produktiven Umgebungen. Im Anschluss an die Datensammlung erfolgt die Auswertung mittels statistischer Methoden und Visualisierungen. Bar-Charts, Radar-Diagramme oder Leistungsvergleiche ermöglichen es, Stärken und Schwächen einzelner Strategien aufzuzeigen. Dabei zeigt sich häufig, dass einige Strategien zwar in bestimmten Metriken glänzen, dafür aber in anderen Bereichen einschränken, etwa durch längere Antwortverzögerungen oder einen höheren Verwaltungsaufwand.

Entscheidend ist, Prioritäten entsprechend dem Anwendungsszenario zu setzen. So benötigen Echtzeit-Anwendungen oft eine kürzere Reaktionszeit, während bei fachlichen Analysen vielleicht Genauigkeit und Glaubwürdigkeit Vorrang haben. Die Praxis belegt, dass hybride Ansätze gut funktionieren. Beispielsweise kann eine Rekursive Segmentierung in kleinen Einheiten zusammen mit einer nachgelagerten Re-Ranking-Methode für die Antwortgenerierung eine gute Balance zwischen Präzision und Geschwindigkeit bieten. Feste Chunkgrößen sind oft einfacher zu implementieren, leiden jedoch gelegentlich unter semantischer Inkohärenz der Einheiten.

Semantisches Chunking wiederum ist vielversprechend, aber dazu oft aufwändiger und zeitintensiver in der Vorverarbeitung, was nicht immer praktikabel ist. Neben der systematischen technischen Bewertung sollten Entwickler auch darauf achten, die Chunking-Strategien im Kontext der Nutzerbedürfnisse und der gesamten Architektur zu betrachten. Ein gut abgestimmter Workflow berücksichtigt nicht nur die Raw-Performance, sondern auch Faktoren wie Skalierbarkeit, Wartbarkeit und Kosten. Gerade bei Cloud-basierten Systemen können API-Aufrufe und Rechenzeiten schnell teuer werden, weshalb eine effiziente Chunking-Strategie auch wirtschaftliche Vorteile bringt. Ein weiterer kritischer Punkt ist die ständige Überwachung und iterative Verbesserung der ausgewählten Chunking-Methode.

RAG-Systeme sind dynamisch und können sich mit veränderten Daten oder neuen Anforderungen unterschiedlich verhalten. Daher sollten regelmäßige Tests und Anpassungen Teil des Betriebsprozesses sein, um langfristig optimale Ergebnisse zu sichern. Dies gilt insbesondere auch für die zugrundeliegenden Modelle und die Qualität der Embeddings, da deren Fortschritte Einfluss auf den Chunking-Erfolg haben können. Zusammenfassend lässt sich festhalten, dass eine fundierte Evaluierung von Chunking-Strategien im RAG-Umfeld nicht improvisiert, sondern geplant erfolgen sollte. Das Vorgehen umfasst eine sorgfältige Stichprobenbildung, die Erstellung eines validen Fragekatalogs, automatisierte Performance-Messungen anhand von vielseitigen Metriken sowie eine Analyse der gewonnenen Daten durch aussagekräftige Visualisierungen.

Durch die Kombination technischer Kennzahlen mit Real-World-Anforderungen entsteht ein solides Fundament, um die bestgeeignete Chunking-Methode für individuelle RAG-Anwendungen zu identifizieren. Die Investition in diesen Prozess zahlt sich langfristig aus, denn sie führt zu qualitativ besseren Ergebnissen, reibungsloseren Abläufen und einer optimierten Nutzung von Ressourcen. Letztlich ermöglicht eine gezielte Chunking-Bewertung, das volle Potenzial von Retrieval-Augmented Generation auszuschöpfen, sei es in der Kundenberatung, im Wissensmanagement oder in komplexen Analyseaufgaben.