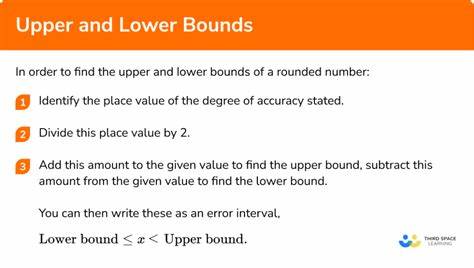

Im Bereich verteilter Systeme stellt der Konsens die zentrale Herausforderung dar, um eine einheitliche Entscheidung zwischen mehreren Prozessen zu erreichen, die sich zudem ausfallen oder Nachrichten verlieren können. Traditionelle Theorien, insbesondere basierend auf Lamports grundlegenden Arbeiten, definierten klare Mindestanforderungen an die Anzahl der Prozesse, um einen schnellen Konsens zu ermöglichen, der in nur zwei Kommunikationsschritten erreicht wird. Diese sogenannten untere Schranken bestimmen, wie viele Prozesse mindestens benötigt werden, um sowohl Fehlertoleranz als auch Effizienz zu gewährleisten. Die klassische Sichtweise formuliert, dass mindestens \max\{2e+f+1, 2f+1\} Prozesse notwendig sind, um eine zweistufige Konsensentscheidung zu treffen, wobei f die maximal tolerierten Prozessausfälle beschreibt und e eine Untermenge dieser Fehler, für die die Entscheidung besonders schnell erfolgen soll. Das Fast Paxos-Protokoll, ein Pionier für schnellen Konsens, erreicht tatsächlich diese Untergrenze, was seine Bedeutung in der Theorie und Praxis unterstreicht.

In den letzten Jahren haben jedoch praktische Protokolle wie das Egalitarian Paxos auf sich aufmerksam gemacht, indem sie ebenfalls in zwei Kommunikationsschritten einen Konsens herbeiführen, aber mit weniger Prozessen als die klassische untere Schranke angibt. Dies führte zunächst zu einer scheinbaren Diskrepanz zwischen Theorie und Praxis, die die Forschungscommunity vor Rätsel stellte und zur Neuinterpretation der zugrunde liegenden Annahmen einlud. Neuere Untersuchungen zeigen auf, dass der traditionelle untere Schranken-Mechanismus tatsächlich auf sehr allgemeinen und weitreichenden Szenarien beruht, die in vielen praktischen Anwendungen nicht unbedingt vollständig relevant sind. Durch die Beschränkung auf praxisnähere Bedingungen lassen sich somit differenziertere und oftmals niedrigere Anforderungen an die Prozessanzahl formulieren. Dies ist von großer Bedeutung, denn geringere Prozessanzahlen erlauben effizientere und skalierbarere verteilte Systeme, was insbesondere in Cloud-Computing-Umgebungen und verteilten Datenbanken einen erheblichen Mehrwert darstellt.

Ein zentraler Aspekt bei der Neubewertung der unteren Schranken ist die Art der Konsensimplementierung. Unterschieden wird zwischen der Umsetzung als atomare Datenobjekte, also praktisch als wiederverwendbare Komponenten, und der Realisierung als einmalige Entscheidungsaufgabe beziehungsweise Task. Für atomare Objekte ergaben sich in der jüngsten Forschung geringfügig niedrigere Anforderungen als für Aufgaben: Die benötigte Prozessanzahl liegt bei \max\{2e+f-1, 2f+1\}, während für die Aufgabe weiterhin \max\{2e+f, 2f+1\} gilt. Diese Differenz mag auf den ersten Blick klein erscheinen, spiegelt jedoch fundamentale Unterschiede in der Systemstruktur und den Erwartungen an Wiederverwendbarkeit und Konsistenz wider. Die praktischen Implikationen dieser Resultate sind vielschichtig.

Zum einen eröffnen sie Designern von verteilten Protokollen den Spielraum, Systeme mit weniger Prozessen auszustatten, ohne die Sicherheit und Performance zu beeinträchtigen. Dies senkt Kosten und Komplexität, fördert eine schnellere Entscheidungsfindung und reduziert Nachrichtenaufkommen. Zum anderen wird die theoretische Fundierung moderner schneller Konsensprotokolle gestärkt, da sie nun in einem kohärenten Rahmen mit bewährten unteren Schranken stehen. Ein weiterer interessanter Punkt ist die Frage, wie sich die Fehlertoleranz konkret auf die Prozesszahl auswirkt. Die Parameter f und e beschreiben jeweils die maximal tolerierten Fehler insgesamt und die Fehleranzahl, unter denen die Entscheidung schnell getroffen wird.

In herkömmlichen Modellen wurden diese Parameter häufig nur isoliert betrachtet oder als überlappend, ohne die genaueren praktischen Bedingungen zu reflektieren. Durch die differenzierte Analyse wird nun klar, dass die schnelle Entscheidung in zwei Schritten nicht generell unter allen Fehlerkonstellationen gefordert sein muss, sondern zielgerichtet für relevante Fälle, was die Prozessanforderungen maßgeblich beeinflusst. Aus technologischer Perspektive bedeutet das, dass Systeme wie Blockchain-Netzwerke, verteilte Datenbanken oder Echtzeit-Anwendungen, die stark auf schnelle und fehlerresistente Konsensmechanismen angewiesen sind, von diesen neuen Erkenntnissen profitieren können. Die optimale Ausgestaltung ihrer Konsensprotokolle kann ressourcenschonender und gleichzeitig robust sein, indem sie genau jene Prozessanzahl einsetzen, die die neuen unteren Schranken als notwendig und ausreichend identifizieren. Die Arbeit von Ryabinin, Gotsman und Sutra trägt somit nicht nur zur theoretischen Verfeinerung bei, sondern legt auch eine Brücke zur praktischen Anwendbarkeit, die bei der Implementierung verteilter Systeme von zentraler Bedeutung ist.