Die Landschaft der Softwareentwicklung verändert sich kontinuierlich, besonders mit dem Vormarsch von Microservice-Architekturen, die komplexe Anwendungen in viele kleine, eigenständige Dienste zerlegen. Ein eindrucksvolles Beispiel dafür liefert DoorDash: Eine einzelne Seite auf der Plattform kann mehr als 1000 gRPC-Aufrufe tätigen. Diese unglaubliche Zahl wirft viele Fragen auf, sowohl zu den Herausforderungen als auch zu den Vorteilen dieser Architektur. Microservices sind seit einiger Zeit ein heiß diskutiertes Thema in der IT-Branche. Die Idee dahinter ist eine klare Aufteilung von Diensten, zusammen mit der Möglichkeit, diese unabhängig voneinander zu entwickeln, zu skalieren und zu deployen.

Prinzipiell verspricht das eine größere Agilität und eine effizientere Zusammenarbeit verschiedener Entwicklerteams. Doch diese Vorteile gehen oft mit einem erhöhten Managementaufwand und neuen technischen Herausforderungen einher. Die hohe Anzahl von gRPC-Aufrufen bei DoorDash illustriert unmittelbar eine Seitenauswirkung der Microservice-Ausrichtung: die Explosion der Netzwerkkommunikation. Über 1000 Aufrufe sind eine enorme Belastung für Latenzzeiten und erhöhen gleichzeitig die Komplexität des Monitorings, Debuggings und des Deployment-Prozesses. Auf den ersten Blick erscheint dies ineffizient, doch eine nähere Betrachtung offenbart, dass dies Teil eines bewussten Kompromisses ist, der dem Skalierbarkeits- und Entwicklungsbedarf von großen Softwareprojekten geschuldet ist.

Die Vorteile der Microservice-Architektur liegen vor allem in der Möglichkeit, einzelne Dienste unabhängig voneinander zu skalieren. Statt die gesamte Anwendung zu vergrößern, kann gezielt dort skaliert werden, wo der Bedarf besteht, was Ressourcen spart. Darüber hinaus sind heute Rechenleistung, Bandbreite und Caching so günstig und leistungsfähig, dass die durch die vielen Netzwerkaufrufe entstehende Latenz leicht kompensiert werden kann. Darüber hinaus ist die Softwareentwicklung häufig der kostenintensivste Teil eines Projekts. Microservices können hier sinnvoll sein, weil sie es ermöglichen, Teams auf klar umrissene Geschäftsbereiche zu fokussieren und so die Produktivität zu steigern.

Die Abgrenzung von Verantwortlichkeiten erleichtert nicht nur die Verwaltung, sondern unterstützt auch eine parallele, weniger konfliktträchtige Arbeitsweise, indem Entwickler an separaten Diensten arbeiten und sich nicht gegenseitig behindern. Dennoch gibt es einige fundamentale Herausforderungen. Der Wunsch nach vollständiger Entkopplung einzelner Dienste, um sie als „Black Boxen“ zu behandeln, stößt häufig an Grenzen. Insbesondere die Datenkonsistenz wird zum Problem, wenn Dienste ihre eigenen isolierten Datenhaltungssysteme besitzen und kein gemeinsames Repository nutzen. Viele Unternehmen benötigen gemeinsame Infrastrukturkomponenten wie Datenbanken, um effizient zu sein.

Moderne cloud-native Technologien wie verteilte Datenbanken helfen zwar, diese Gräben ein Stück weit zu überbrücken, doch die Architektur bleibt komplex und erfordert sorgfältiges Design. Ein weiterer Aspekt ist die organisatorische Seite des Microservices-Entwicklungsprozesses. Kleine Teams, die jeweils einen Dienst verantworten, müssen ein breites technisches Verständnis über alle Schichten des Stacks besitzen – von Datenbank bis Frontend. Diese Notwendigkeit, Fachwissen zu bündeln, macht die Einführung von Microservices nicht immer zum Allheilmittel. Kleinere Teams profitieren oft von der vertieften Expertise, die klassische Aufteilungen nach technologischen Schichten, also etwa separates Frontend- und Backend-Entwicklungsteam, fördern.

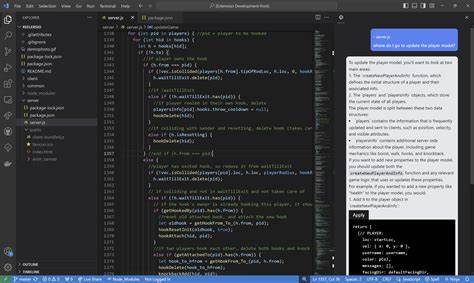

Ein interessantes Konzept in diesem Zusammenhang ist die Monorepo-Strategie, also die Nutzung eines einzigen Code-Repositories für alle Microservices. Diese Vorgehensweise erlaubt es, einheitliche Standards zu etablieren, Abhängigkeiten genau nachzuvollziehen und Code-Wiederverwendung zu fördern, ohne den modularen Charakter der Microservices aufzugeben. Gerade bei großen Firmen wie Google oder Amazon werden solche Mischformen erfolgreich genutzt. Ein zentraler technischer Vorteil besteht darin, dass Funktionaufrufe innerhalb eines Systems deutlich effizienter sind als Netzwerkaufrufe. Sie vermeiden Latenzen, reduzieren potentielle Fehlerquellen durch Netzwerke und ermöglichen einfachere Kompatibilitätsprüfungen.

Gleichzeitig ist gRPC als Protokoll ein hochtechnisiertes Werkzeug, das die Effizienz der Netzwerkkommunikation so weit wie möglich optimiert und durch klare Schnittstellenbeschreibungen die Wartbarkeit unterstützt. Die Komplexität einer solch stark verteilten Anwendung spiegelt sich auch in der Release-Strategie wider. Kleinere, häufigere Releases erlauben eine bessere Fehlerlokalisierung und schnellere Reaktionen. Doch das setzt voraus, dass das gesamte Ökosystem – von der Infrastruktur bis zu den abhängigen Diensten – entsprechend vorbereitet ist. Bei DoorDash und ähnlichen Plattformen wird daher oft ein sorgfältiger Kompromiss gefunden, der Geschwindigkeit und Zuverlässigkeit in Einklang bringt.

Zusammenfassend lässt sich sagen, dass die Zahl von über 1000 gRPC-Aufrufen auf einer einzigen DoorDash-Seite ein anschauliches Beispiel für die Komplexität moderner Microservice-Architekturen ist. Trotz einiger inhärenter Nachteile bietet diese Architektur erhebliche Vorteile, insbesondere in Bezug auf Skalierbarkeit, Ressourcenoptimierung und Entwicklungsproduktivität. Die Kunst liegt darin, die richtigen Balancepunkte zu finden, um sowohl technische als auch organisatorische Herausforderungen zu meistern. In Zukunft wird die Weiterentwicklung von Infrastrukturtechnologien, automatisierten Monitoring- und Debugging-Tools sowie optimierten Deployment-Verfahren die Handhabung solcher komplexen Systeme weiter verbessern. Gleichzeitig wird die Kombination aus technischer Tiefe und fachlicher Spezialisierung in den Teams weiterhin ein entscheidender Erfolgsfaktor bleiben.

Wer sich mit der Entwicklung großer, skalierbarer Software beschäftigt, sollte die Funktionsweise und die Implikationen von Microservices genau verstehen. Das Beispiel DoorDash zeigt eindrucksvoll, wie ein modernes, hochverteiltes System aufgebaut sein kann und welche Denkansätze und Kompromisse dabei eine Rolle spielen. Nur so lassen sich die Herausforderungen meistern und die Potenziale dieser Architektur voll ausschöpfen.