Die rasante Entwicklung von Künstlicher Intelligenz, insbesondere großer Sprachmodelle (Large Language Models, LLMs), verändert zahlreiche Fachbereiche grundlegend. Auch in der Chemie sind diese Modelle auf dem Vormarsch und werfen dabei spannende Fragen auf: Können LLMs das Fachwissen von erfahrenen Chemikerinnen und Chemikern übertreffen? Wo liegen die Stärken dieser Technologien, und welche Herausforderungen bleiben bestehen? Die Beantwortung dieser Fragen ist essenziell, um das Potenzial von KI in der chemischen Forschung sinnvoll zu nutzen und gleichzeitig Risiken zu minimieren. Große Sprachmodelle sind komplexe maschinelle Systeme, die auf enormen Textmengen trainiert werden, um menschliche Sprache zu verstehen und zu generieren. Sie basieren auf neuronalen Netzen, deren Fähigkeiten stark mit der Größe und Vielfalt ihrer Trainingsdaten wachsen. In der Medizin, Rechtswissenschaft oder Technik haben sie bereits beeindruckende Leistungen gezeigt, indem sie etwa Zulassungsprüfungen bestanden oder Expertenwissen simulierten.

Die Chemie stellt jedoch durch ihre spezifische Fachsprache, komplexe Strukturformeln und die Notwendigkeit tiefgreifender logischer Schlussfolgerungen eine besondere Herausforderung dar. Die wissenschaftliche Gemeinschaft hat daher einen Bedarf erkannt, die Fähigkeiten von LLMs im chemischen Kontext systematisch zu evaluieren. Im Jahr 2025 wurde mit ChemBench ein neuartiges Framework vorgestellt, das über 2700 Frage-Antwort-Paare aus verschiedenen Chemie-Disziplinen umfasst. Es dient dazu, die Leistungen führender großer und kleiner Sprachmodelle objektiv mit dem Wissen und der Problemlösungskompetenz menschlicher Chemiker zu vergleichen. Hierbei zeigte sich überraschend, dass die besten Modelle in vielen Bereichen selbst erfahrene Chemiker übertrafen, obwohl sie bei manchen grundlegenden Aufgaben weiterhin Schwierigkeiten hatten und dazu neigten, ihre Antworten übermäßig sicher zu präsentieren.

ChemBench stellt dabei nicht nur Multiple-Choice-Fragen bereit, wie es in bisherigen Prüfungen üblich war, sondern umfasst vor allem offene Fragestellungen, die echtes tieferes Verständnis, Berechnungen und chemische Intuition erfordern. Diese Vielschichtigkeit bildet die Realität der chemischen Forschung besser ab, in der Kreativität und fundiertes Nachdenken unerlässlich sind. Gerade bei Fragestellungen, die über die reine Wissensabfrage hinausgehen, sind LLMs jedoch noch nicht fehlerfrei. Besonders anspruchsvoll bleiben für die Modelle Bereiche wie Toxizität, Sicherheit und analytische Chemie, etwa wenn es um die Interpretation von Spektren oder Isomerbestimmung geht. Dort spielen nicht nur reine Faktenkenntnisse eine Rolle, sondern komplexe räumliche und strukturelle Überlegungen.

Eine wichtige Erkenntnis der Analysen ist die festzustellen, dass das scheinbare Wissen der Modelle oft nicht aus echtem Verstehen resultiert, sondern aus der statistischen Wahrscheinlichkeit, welche Textsequenzen beim Training am häufigsten zu bestimmten Ausdrücken passen. Das führt dazu, dass LLMs molekulare Strukturen nicht wirklich in ihrer Tiefe „begreifen“, sondern eher in Relation zu bereits gelernten Beispielen beurteilen. Dies lässt sich durch die fehlende Korrelation ihrer Leistung mit der molekularen Komplexität belegen. Menschen hingegen arbeiten oft mit mentalen Modellen, die chemische Eigenschaften, räumliche Anordnungen und dynamische Prozesse umfassen. Dieser Unterschied stellt eine fundamentale Limitation heutiger Sprachmodelle dar.

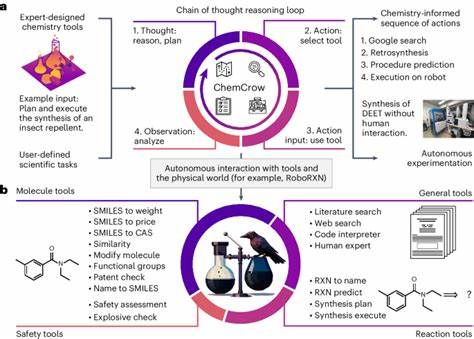

Gleichzeitig bestehen im Handling von Chemie-spezifischen Notationen Fortschritte. Spezielle Kodierungen, wie die Kennzeichnung von Molekülstrukturen durch SMILES-Strings oder die Einbettung von chemischen Gleichungen, helfen Modellen, die wissenschaftliche Sprache zielgerichteter zu bearbeiten. Dadurch können sie präziser antworten und sogar als Assistenten in synthetischen Prozessen oder der Datenextraktion aus Fachliteratur fungieren – ein Bereich mit großem Anwendungspotenzial. Die Ergebnisse von ChemBench und ähnlichen Evaluierungen legen nahe, dass LLMs bereits heute als wertvolle Werkzeuge in der chemischen Forschung und Lehre dienen können. Sie eröffnen Möglichkeiten, den Zugang zu chemischem Wissen zu demokratisieren, indem komplexe Fragen, für deren Beantwortung normalerweise Experten nötig sind, automatisiert beantwortet werden können.

Für Studierende etwa können diese Modelle bei der Wissensvermittlung und Übung Unterstützung bieten. Dennoch mahnt die Forschung zur Vorsicht: Modelle sind derzeit nicht für den alleinigen Einsatz in sicherheitskritischen oder toxikologischen Bewertungen geeignet, da ihre Einschätzungen oft übertrieben sicher wirken können, ohne tatsächlich korrekt zu sein. Fehlinterpretationen solcher Ausgaben könnten ernsthafte Folgen haben – etwa wenn Laien sich auf KI-Ergebnisse verlassen, ohne über das nötige Hintergrundwissen zu verfügen. Deshalb ist eine menschliche Kontrolle und kritische Reflexion unerlässlich. Die Erkenntnisse aus den aktuellen Studien fordern auch ein Umdenken in der Chemieausbildung.

Wenn KI-gestützte Systeme Faktenwissen leicht zugänglich machen und Routineaufgaben erledigen, müssen Ausbildungsinhalte stärker auf kritisches Denken, komplexe Problemlösung und den kreativen Umgang mitchemischen Fragestellungen ausgerichtet sein – eben jene Fähigkeiten, mit denen Menschen den Maschinen nach wie vor voraus sind. Auch im Bereich der Vorhersage von menschlichen Präferenzen bei der Bewertung chemischer Verbindungen zeigen LLMs bislang noch Schwächen. Obwohl solche Präferenzurteile in der Entwicklung neuer Arzneimittel und Materialien entscheidend sind, konnten die Modelle nicht zuverlässig mit den Entscheidungen erfahrener Chemikerinnen und Chemiker konkurrieren. Dies eröffnet Forschungsfelder zur Verfeinerung von KI-Systemen mittels Präferenzlernen und besserer Modellierungen menschlicher Intuition. Angesichts der bisherigen Erfolge und Limitationen wird erwartet, dass die weitere Entwicklung von LLMs insbesondere durch die Integration spezialisierter chemischer Datenbanken und durch das Training auf wissenschaftlich validierten Datensätzen weiteren Qualitätssprung erfahren wird.

Eine höhere Modellgröße und die Nutzung von Tools zur gezielten Wissensabrufung ergänzen diesen Fortschritt. Zudem sind neue Evaluationsframeworks wie ChemBench unabdingbar, um den Fortschritt objektiv zu messen und die Modelle besser zu verstehen. Sie tragen dazu bei, verantwortungsvolle Anwendungen zu fördern, bei denen die Modelle als unterstützende Werkzeuge Chemikerinnen und Chemiker entlasten, aber nicht ersetzen. Schließlich verdeutlichen die Forschungen, dass eine enge Zusammenarbeit zwischen KI-Entwicklerteams und Chemieexperten essentiell ist. Nur so können die Modelle auf realistische Fragestellungen zugeschnitten und potenzielle Fehlanwendungen frühzeitig erkannt werden.

Sicherheitsaspekte, etwa beim Schutz vor dual-use-Anwendungen chemischen Wissens, sind dabei besonders relevant. In Summe zeigt sich, dass große Sprachmodelle die Chemie revolutionieren können, indem sie den Wissenszugang erweitern und neue Innovationsmöglichkeiten schaffen. Dem gegenüber stehen Herausforderungen in Bezug auf Zuverlässigkeit, kritische Bewertung der Antworten und ethischen Einsatz. Die Zukunft der Chemie wird daher maßgeblich davon abhängen, wie Mensch und Maschine zusammenarbeiten, um gegenseitige Stärken auszuspielen und Schwächen zu kompensieren.