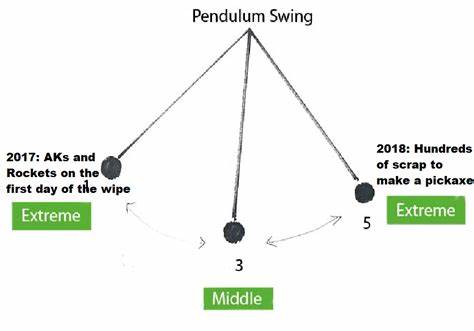

In der Welt der Softwareentwicklung spielen Datenbanken eine zentrale Rolle. Sie speichern, verwalten und liefern die Informationen, auf denen fast jede Anwendung aufbaut. Dennoch zeigen sich immer wieder Fälle, in denen der Umgang mit Datenbanken mehr Schaden als Nutzen bringt. Besonders wenn Entscheidungsträger und Architekten von einer Extremsituation in die andere wechseln – wenn das Pendel also zu weit ausschlägt –, entstehen gravierende Probleme. Diese Fehlentwicklungen wirken sich nicht nur auf die Performance und die Stabilität der Systeme aus, sondern können auch langfristige finanzielle Auswirkungen für Unternehmen haben.

Ein genauer Blick auf typische Fehler, die bei der Nutzung von Datenbanken gemacht werden, offenbart überraschende Erkenntnisse und Warnsignale, die sich durch scheinbar rationale Beweggründe eingeschlichen haben. Eine oft unterschätzte Ursache für Schwierigkeiten im Datenbankmanagement ist die Überlastung von geschäftskritischer Logik auf der Datenbankebene. In einigen Organisationen – insbesondere wenn komplexe, stark verzahnte Unternehmensprozesse abgebildet werden – findet man Datenbanken, die unzählige Seiten an gespeicherten Prozeduren enthalten. Diese tiefverschachtelten Stored Procedures steuern nicht nur die Datenmanipulation, sondern auch essentielle Geschäftsprozesse. Die Motivation hierfür reicht von pragmatischen Gründen, beispielsweise der Wunsch, nach einer langen und zeitintensiven Buildphase der Anwendung schneller Anpassungen vorzunehmen, bis hin zu technischen Restriktionen.

Doch das Resultat zeigt oft negative Auswirkungen: CPU-Ressourcen der Datenbankserver sind überlastet, viele API-Aufrufe verbringen ihre wichtigste Zeit in der Datenbankabfrage, und die gesamte Pipeline wird anfällig für Deadlocks und Timeout-Probleme. Die komplexen Abhängigkeiten innerhalb der Stored Procedures führen dazu, dass minimale Veränderungen unerwartete Auswirkungen auf die Query-Optimierung haben und damit Performanceeinbrüche und Instabilitäten hervorrufen. Ein weiterer schwerwiegender Aspekt ist häufig die Architektur der Datenmodelle. Häufig sind diese trotz der offensichtlichen Komplexität des Geschäftsbereichs durchaus sinnvoll gestaltet. Daten werden meist normalisiert und relational aufgebaut.

Gerade in komplexen Domänen gelingt es erfahrenen Architekten, ein balanciertes Schema zu entwerfen, das die Geschäftsobjekte adäquat abbildet. Die Herausforderung liegt weniger in der Modellierung an sich, als vielmehr in der Implementierung und Ausführung auf den Datenbanksystemen. Alte Technologien, abgenutzte Infrastruktur und fehlende Updates führen dazu, dass selbst ein gut strukturiertes Modell nicht die gewünschte Performance und Zuverlässigkeit liefern kann. Um den Problemen mit der monolithischen und stark verknüpften Datenbank entgegenzuwirken, entscheiden sich viele Teams für sogenannte Rewrites oder Paradigmenwechsel. Dabei schwenkt der Fokus häufig von relationalen Systemen auf neuartige Technologien wie Key-Value-Stores oder dokumentenbasierte Datenbanken.

Diese Systeme versprechen schlanke, einfache Schnittstellen mit wenigen Operationen, die im Idealfall extrem skalierbar und performant arbeiten. Doch genau an dieser Stelle schlägt das Pendel oft zu weit aus. Die simplifizierten Operationen in Key-Value-Stores – meist auf das Lesen, Einfügen, Aktualisieren und Löschen eines einzelnen Schlüssels beschränkt – sind für stark relationale Datenmodelle, wie man sie in komplexen Unternehmenssystemen benötigt, oft ungeeignet. Die vermeintliche Vereinfachung führt in der Praxis zu erheblichen Schwierigkeiten. Das Szenario wird noch komplexer, wenn die vorhandene Datenstruktur in großen verschachtelten Dokumenten abgebildet wird und als JSON-String innerhalb des Key-Value-Stores abgelegt ist.

Solche Dokumente nehmen schnell mehrere Kilobyte oder mehr Speicherplatz ein. Fehlende Unterstützung für partielle Updates innerhalb der Dokumente zwingt die Entwickler dazu, bei jeder kleinen Änderung den gesamten JSON-Datensatz zu lesen, zu entpacken, zu modifizieren und anschließend komplett wieder zu schreiben. Diese Ineffizienz steigert nicht nur den Input/Output-Verkehr massiv, sondern belastet auch die Systemlatenz erheblich. Der Versuch, das Problem durch Komprimierungstechniken wie Gzip zu mildern erzeugt gleichzeitig neue Herausforderungen. Die Dateninspektion und -analyse wird erschwert, weshalb neue spezialisierte Tools entwickelt werden müssen, um den komprimierten Datenbestand überhaupt verständlich zu machen.

Darüber hinaus bringt die Abwesenheit von atomaren Transaktionen oder Batching-Mechanismen in solchen Key-Value-Systemen weitere Schwierigkeiten mit sich. In relationalen Datenbanken sind Transaktionen essenziell, um konsistente und fehlerresistente Mehrschrittoperationen zu gewährleisten. Fehlen diese, müssen Entwickler aufwendigere Mechanismen implementieren, um inkonsistente Zustände zu verhindern – beispielsweise durch Checkpoint- und Idempotenzsysteme. Diese ersetzen zwar das klassische Transaktionsmodell, erhöhen aber die Komplexität und die Anzahl der erforderlichen Schreib- und Leseoperationen deutlich. Statt einer klaren Lösung entsteht somit ein Netz aus zusätzlicher Logik, die interne Konsistenz gewährleisten soll, aber gleichzeitig neue Performance- und Wartbarkeitsprobleme erzeugt.

All dies bedeutet, dass eine anfängliche Entscheidung, aus Angst vor toten Sperren oder schlecht performenden Abfragen herkömmliche relationale Datenbanken zu meiden, langfristig neue Probleme schafft, die schwerer wiegen als die ursprünglichen. Das Pendel zwischen zwei Extremen – komplette Abhängigkeit von komplexen Stored Procedures auf der einen Seite und die radikale Vereinfachung auf Key-Value-Stores auf der anderen – offenbart sich als schädliches Muster. Für Unternehmen mit kritischen, stark vernetzten Geschäftsdaten und hoher Last bedeutet dies häufig, dass weder das alte noch das neue Modell dauerhaft überzeugen kann. Im Rückblick zeigt sich, dass der Erfolg immer von einer wohldurchdachten Balance abhängt. Die Kombination aus einer angemessenen relationalen Modellierung, der Nutzung moderner und effizienter Datenbanktechnologien sowie der Implementierung geeigneter architektonischer Muster ist unerlässlich.

Das Wissen um traditionelle Probleme wie Deadlocks, langsame Queries oder Monolithen ist zwar wichtig, doch die Lösung kann nicht in einer vollständigen Verwerfung bewährter Technologien liegen. Auch ist es entscheidend, dass die gewählte Datenbankinfrastruktur zur Komplexität der Anwendungsdomäne passt. Nur wenige Anwendungen profitieren tatsächlich von einem ausschließlich primitiven Key-Value-Zugriff. Dokumentenorientierte Datenbanken oder NoSQL-Systeme sind mächtig, wenn sie richtig eingesetzt werden, zum Beispiel in unstrukturierten oder schemalosen Umgebungen. Doch bei stark relationalen Daten sind Systeme mit Unterstützung für komplexe Abfragen, Transaktionen und optimierter Indizierung oftmals unerlässlich.

Zudem sollten Implementierungen darauf achten, dass die Entwicklung, Wartung und Skalierung nicht unnötig erschwert wird. Ein weiterer interessanter Aspekt betrifft den Entwicklungsprozess selbst. In den beschriebenen Fällen ist auffällig, dass aufwändige Builds und komplexe Dev-Setups zu einer Atmosphäre geführt haben, in der schnelle Hotfixes in Stored Procedures oder andere kurzfristige Lösungen bevorzugt wurden. Diese Pragmatik kann kurzfristig Schmerzen lindern, bindet aber Ressourcen in Ineffizienzen und technischen Schulden, die später teuer werden. Eine solide Toolchain, automatisierte Tests und Moderation der Komplexität im Quellcode sind somit nicht nur Nice-to-Have, sondern elementar für nachhaltigen Erfolg.

Schließlich bleibt als wichtigste Lektion zu erwähnen, dass man sich nicht von Angst oder frustrierenden Erfahrungen zu radikalen Entscheidungen verleiten lassen sollte. Ein tiefgehendes Verständnis von Datenmodellen, Systemanforderungen und Datenbankeigenschaften ist unerlässlich, bevor man eine Technologieentscheidung trifft. Der gesunde Mittelweg – das Pendel in der Mitte halten – schont langfristig Ressourcen, erhöht die Stabilität und sorgt für verbesserte Wartbarkeit und Performance. Zusammengefasst gibt es also gleich mehrere Warnungen: die Verlagerung von wichtiger Business-Logik in umfangreiche Stored Procedures bringt Lastprobleme und erhöhte Komplexität mit sich. Ein blinder Wechsel zu stark vereinfachten Key-Value-Systemen ohne Unterstützung für Transaktionen und partielle Updates schafft neue Herausforderungen in IO-Performance und Datenkonsistenz.

Zudem können zusätzliche Mechanismen wie Checkpoints und Kompressionsverfahren zwar helfen, führen aber meist nicht zu einem grundsätzlichen Lösungsansatz. Vielmehr benötigen Unternehmen ein wohlüberlegtes Datenbankkonzept, das sowohl die technischen Rahmenbedingungen als auch die geschäftlichen Anforderungen berücksichtigt und pragmatisch mit der Komplexität umgeht. Die Erfahrung zeigt, dass der Weg zu stabilen und performanten datenbankbasierten Systemen ein Prozess mit kontinuierlichem Lernen und Anpassung ist. Erfolgreiche Architekturen entstehen durch die Kombination von technischen Innovationen mit erprobten Prinzipien. Dabei ist es wichtig, Lehren aus vergangenen Fehlentwicklungen zu ziehen und nicht in andere Extreme zu verfallen.

Ein entsprechendes Bewusstsein kann Entwickler, Teams und Unternehmen ermutigen, neue Wege zu beschreiten, die weder auf unkontrollierte Komplexität noch auf übermäßige Simplexität setzen – sondern auf Ausgewogenheit und Effizienz.