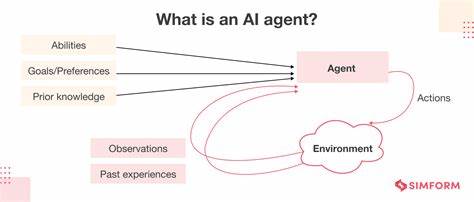

In der heutigen digitalen Welt sind APIs das Rückgrat moderner Anwendungen. Sie ermöglichen es Software, miteinander zu kommunizieren, Daten auszutauschen und Funktionalitäten zu integrieren. Mit dem Aufkommen von KI-gesteuerten Sprachmodellen und LLM-basierten Agenten steigt die Bedeutung einer klaren, verständlichen und gut gestalteten API-Dokumentation enorm. Wenn ein KI-Agent nicht versteht, wie Ihre API funktioniert, heißt das oft, dass auch menschliche Entwickler ähnliche Probleme haben – nur womöglich weniger geduldig und mit größerem Frust. Die Verbindung zwischen den Fähigkeiten von KI-Agenten und den Erwartungen an die Entwicklererfahrung (Developer Experience, DX) ist enger als je zuvor, und ein Blick auf diese Symbiose eröffnet neue Chancen für bessere API-Designs, die alle Nutzer einbeziehen.

LLM-Agenten wie LangChain, OpenAI Codex oder Claude Code fungieren als unermüdliche Junior-Entwickler. Sie durchlaufen systematisch die Prozesskette: Lesen der Dokumentation, Ausführen eines API-Aufrufs, Analysieren von Fehlermeldungen, Anpassen von Parametern und erneutes Versuchen – eine Endlosschleife, die darauf abzielt, schlussendlich funktionale Ergebnisse zu erzielen. Diese Persistenz ist beeindruckend, aber nicht unfehlbar. Sobald die API-Dokumentation unvollständig ist, Beispiele veraltet sind oder Fehlermeldungen zu vage bleiben, verliert der Agent schnell die Orientierung. Dieses Scheitern offenbart unmittelbare Schwachstellen im Entwicklererlebnis, denn ein KI-Agent ohne Frustration und mit unbegrenzter Geduld kann durchaus einen Fehler verzeihen, wenn er wenigstens über klare Hinweise verfügt.

Kann er nicht verstehen, was zu tun ist, wird der menschliche Entwickler, der unter Zeitdruck steht, wohl kaum mehr Erfolg haben. Ein wesentlicher Faktor, der sowohl KI-agenten als auch menschlichen Entwicklern Schwierigkeiten bereitet, sind diffuse oder inkonsistente Fehlermeldungen. Eine reine HTTP-Statuscode-Antwort ohne erklärenden Text, wie etwa ein 400 Bad Request, bietet kaum Handlungsorientierung. KI-Modelle können in Schleifen gefangen sein und endlos versuchen, durch Zufall die richtige Kombination von Parametern zu erraten. Ein häufiger Stolperstein ist das Fehlen von Hinweisen, welche Felder notwendig sind oder welches Format eingefordert wird.

Im Gegensatz dazu ermöglichen präzise Fehlertexte wie "fehlendes erforderliches Feld 'first_name'" dem Agenten sofortige Korrekturen und beschleunigen den Erfolg. Diese Klarheit reduziert nicht nur die Zeit bis zur Lösung, sondern verhindert auch Leerlauf und Verschwendung von Ressourcen. Für menschliche Entwickler bedeutet das weniger Frustration und schnellere Integration. Neben aussagekräftigen Fehlerantworten spielt eine konsistente und vorhersehbare API-Struktur eine zentrale Rolle. KI-Agenten sind exzellente Mustererkenner und können schnell lernen, wie Endpunkte benannt sind, wie Parameter genannt und strukturiert werden sowie welche Konventionen gelten.

Jedes inkonsistente Element – mal user_id, mal userId, unterschiedliche Pluralformen bei Collection-Routen – kann im Arbeitsfluss zu Verwirrung und Fehlern führen. Entwickler reagieren darauf, indem sie improvisieren oder Fehler ignorieren, was langfristig zu technischen Schulden führt. Für LLMs kann inkonsistente Namensgebung aber zum kompletten Ausschluss relevanter Daten führen und damit zu Fehlinterpretationen. Die Devise lautet: Einheitlichkeit ist König. Eine durchgehend stringente Gestaltung der API erhöht die Erlernbarkeit und Benutzerfreundlichkeit erheblich.

Die Dokumentation steht dabei im Zentrum jeglicher Bemühungen. Für KI-Agenten müssen Dokumente vollständig, aktuell und zentral erreichbar sein. Fragmentierte Informationen, verstreut zwischen Marketingseiten, veralteten Foreneinträgen oder in interne Changelogs verbannt, sind für Maschinen so gut wie unsichtbar. Auch menschliche Entwickler haben Schwierigkeiten, wenn essenzielle Angaben über mehrere Quellen hinweg zu suchen sind, nicht zu reden von Verwirrung, die dadurch entsteht. Es empfiehlt sich, eine zentrale, strukturierte Spezifikation etwa im OpenAPI-Format bereitzustellen, die viele Agenten direkt nutzen können, um API-Calls automatisiert zu generieren.

Inline-Beispiele sind unerlässlich: Sie dienen KI und Menschen als klarer Leitfaden und verhindern Fehleinschätzungen.Hierbei bedeutet Aktualität ein stetiges Pflegen und Entfernen veralteter Dokumente, da eine Diskrepanz zwischen API-Implementierung und Anleitung schnell zur Fehlfunktion führt. Weitere gute Praktiken umfassen die Bereitstellung offizieller Beispiele in verschiedenen Programmiersprachen. Zwar können LLMs cURL-Befehle automatisch konvertieren, doch vorgefertigte, getestete Code-Snippets in Python, JavaScript oder anderen populären Sprachen wegen reduzieren Interpretationsoffenheit und den Aufwand bei der Implementierung. Da sich APIs oft durch iterative Entwicklung verändern, sollten diese Beispiele über automatisierte Tests gegen Sandbox-Umgebungen validiert werden, um Brüche frühzeitig zu erkennen.

Ein ebenfalls wichtiger Aspekt ist die Einfachheit und natürliche Verwendung der API. Schritte, die für Menschen eventuell nur geringfügige Hürden darstellen – wie das abrufen einer ID über mehrere Aufrufe –, bringen KI-Agenten schnell zum Stillstand, wenn diese nicht in der Lage sind, Zusammenhänge selbst herzustellen oder komplexe Abfragen logisch zu verknüpfen. APIs, die Suchfunktionen, Bulk-Operationen oder Zusammenfassungsendpunkte anbieten, reduzieren die Komplexität für alle Beteiligten. Ein gut durchdachtes Granularitätsniveau in Antworten, Filtermechanismen und Paginierung minimieren Tokenverbrauch bei KI-Modellen und steigern die Effizienz. Betrachtet man die Rolle von KI-Agenten beim Testen der API-Integration, wird klar, dass sie als unerbittliche Tester fungieren können.

Das automatisierte Durchspielen von kritischen Pfaden, etwa vom Anlegen eines neuen Nutzers bis zum Login, ermöglicht es, regressionsanfällige Änderungen in der Pipeline früh zu erkennen. Mit gesteuerten Parametern für Determinismus und begrenzter Zahl an Versuchen lassen sich reproduzierbare Ergebnisse generieren. Die gesammelten Daten – Erfolg oder scheitern, Anzahl der Wiederholungen, Zeit bis zur erfolgreichen Ausführung – schaffen Transparenz und ermöglichen schnelle Rückschlüsse auf Schwachstellen. Die Kombination von DX (Developer Experience) und AX (Agent Experience) führt zu einer entscheidenden Wendung in der Entwicklung von APIs. Indem alle Interaktionspunkte, vom Onboarding über Dokumentation bis hin zu Fehlerbehandlung und Beispielcode, so gestaltet werden, dass sowohl Menschen als auch KI-Agenten sie problemlos nutzen können, entsteht eine Win-Win-Situation.

Frustrationsquellen, die bisher im Verborgenen lagen, werden sichtbar gemacht. Fehlende oder unklare Informationen schlagen sich direkt in den Logs der Agenten nieder. So lässt sich sehr konkret ermitteln, welche API-Bereiche überarbeitet werden müssen. Im Endeffekt sind KI-Agenten die Spiegel menschlicher Erfahrungen mit Ihren APIs. Was für einen Algorithmus mit unbegrenzter Geduld und Rechenleistung nicht lösbar ist, wird für Entwickler mit knappen Deadlines erst recht ein Dorn im Auge sein.

Die Erkenntnis daraus ist, dass eine API, die für Agenten gut funktioniert, automatisch eine bessere Nutzerfreundlichkeit für Entwickler bietet. Dies wirkt sich positiv aus: Die Anzahl der Supportanfragen sinkt, die Entwicklerzufriedenheit steigt, und die Wahrscheinlichkeit wächst, dass Ihr Produkt von modernen Auto-Coding-Tools oder Integrationsplattformen bevorzugt wird. Zusammenfassend lässt sich sagen, dass die Zukunft der API-Entwicklung tief mit dem Zusammenspiel zwischen menschlichen und KI-Agent-Nutzern verknüpft ist. Investitionen in klare, konsistente Dokumentation, aussagekräftige Fehlermeldungen, intuitive API-Designs und automatisierte Agenten-Tests zahlen sich mehrfach aus. Sie verhindern nicht nur technische Schwierigkeiten, sondern stärken auch das Vertrauen aller Nutzergruppen.

Wer heute seine API für KI-Agenten optimiert, macht sie gleichzeitig für alle Entwickler einfacher, schneller und zuverlässiger nutzbar. In einer Welt, die immer stärker auf Automatisierung und KI setzt, bleibt ein exzellentes Entwicklererlebnis der entscheidende Erfolgsfaktor – und es zahlt sich für alle aus.

![History of Diffusion – Sander Dieleman [video]](/images/A71755E7-29D7-4AAD-815E-0F218B193B4A)