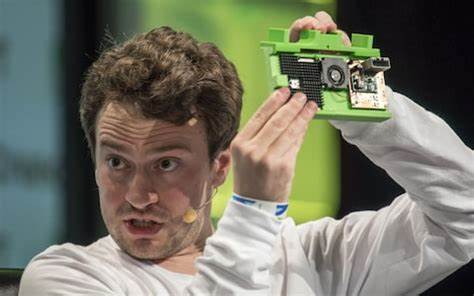

George Hotz, weithin bekannt durch seine bahnbrechenden Leistungen in der Technikwelt und als erfahrener Entwickler im Bereich Künstliche Intelligenz, hat kürzlich seine Meinung und Ratschläge bezüglich Tenstorrent geäußert – einem aufstrebenden Unternehmen, das sich auf KI-Computing spezialisiert hat. Seine Gedanken sind nicht nur eine ehrliche Bestandsaufnahme der derzeitigen Herausforderungen, sondern auch ein Leitfaden, wie Tenstorrent seine Strategie weiterentwickeln kann, um im äußerst wettbewerbsintensiven Markt der KI-Hardware und Software erfolgreich zu sein. Hotz‘ Empfehlungen sind besonders wertvoll, da sie auf tiefem technischem Verständnis basieren und zugleich ein Gespür für marktstrategische Bewegungen besitzen. Im Fokus steht dabei die Verbindung von Hardwareprogrammierbarkeit und Softwareinfrastruktur, die das Rückgrat moderner KI-Berechnungen bilden. Hotz beginnt seine stark formulierten Ausführungen mit einer deutlichen Warnung: Wer nur auf Übernahmen oder IP-Lizenzierung abzielt, wird von ihm keine Hilfe erwarten können.

Für ihn ist Tenstorrents Aufgabe klar definiert – der wahre Erfolg liegt im Sieg im Bereich KI-Compute, nicht in oberflächlichen Geschäftsmodellen oder schnellen finanziellen Lösungen. Er bestärkt Tenstorrent darin, sich von kurzfristigen Geschäftszielen zu lösen und stattdessen eine technisch fundierte und visionäre Herangehensweise einzunehmen. Ein zentrales Thema seiner Kritik ist der sogenannte „Stack“ – die Technologiehöhe, die ein Unternehmen entwickelt, um KI-Anwendungen zu unterstützen. Hotz nennt den siebten Stack von Tenstorrent „nicht ausreichend“ und drängt darauf, noch einen Schritt weiterzugehen, um wahre Stärke zu entfalten. Besonders kritisch sieht er die derzeitige Verwendung von Low-Level-Kerntreibern oder -Bibliotheken wie LLK (Low-Level Kernel) und bezeichnet diesen Ansatz als „falschen Weg“.

Statt auf eine instabile Grundlage – eine Metapher für ineffiziente technologische Infrastruktur – zu bauen, empfiehlt er, robuste und flexible Systeme zu schaffen, die eine hohe Programmierbarkeit ermöglichen. Programmierbarkeit ist für Hotz das eigentliche Alleinstellungsmerkmal von Tenstorrent gegenüber mächtigen Wettbewerbern wie NVIDIA und AMD. Während diese Giganten der Branche auf enorm starke IP-Deals und bewährte Hardware zurückgreifen können, muss Tenstorrent seine Nische durch mehr Anpassbarkeit und Offenheit gewinnen. Nur durch echte Programmierbarkeit kann die Hardware die Architektur von KI-Modellen aktiv formen und deren Performance optimieren. Hotz weist darauf hin, dass ein falsches Verharren auf bestimmten Algorithmen wie „sfpi_elu“ ein Fehler ist und einen Wettkampf auf Augenhöhe nicht ermöglichen wird.

Weiterhin thematisiert er die Rolle von Open Source in der Hardware- und Softwareentwicklung. Während Open-Source-Entwicklungen sicherlich Vorteile wie Bugfixes und neue Features bringen, sind sie laut Hotz nicht in der Lage, grundlegende Kernrefaktorisierungen oder tiefgreifende Innovationen zu schaffen. Deshalb rät er Tenstorrent, sich nicht allein auf open-source Projekte zu verlassen, sondern ambitionierte Eigenentwicklungen zu verfolgen, um die Kerntechnologie von Grund auf neu zu gestalten und weiterzuentwickeln. Hotz stellt zudem die Bedeutung eines schlanken, dreistufigen Software-Stacks vor, bei dem Frontend, Compiler und Runtime klar definiert sind. Er kritisiert komplexe Abstraktionsschichten, die gerade im KI-Bereich oft zu träge und unflexibel sind.

Für ihn ist ein datenflussbasierter Compiler der richtige Weg – eines, der sich auf die wirklich nötigen Schichten ohne überflüssigen Ballast konzentriert. Die Schichten gliedern sich laut Hotz auf in das Frontend mit Frameworks wie PyTorch oder ONNX, den Compiler und die Runtime beziehungsweise den Treiber. Besonders die Runtime sollte sich darauf beschränken, Hardware-Anbindung in einer anwendungsunabhängigen Weise anzubieten. An dieser Stelle rät Hotz, dass Tenstorrent von Ansätzen wie CUDA (dem bekannten NVIDIA-API) lernen und eine simple, leistungsfähige C-API für Hardwarezugriffe entwerfen sollte, die keine unnötige Komplexität einführt. Im Bereich des Programmiermodells spricht Hotz auch über Kernel-Fusion, die Speicherverwaltung und Operationen wie das „ELU“-Aktivierungsfunktionselement.

Laut ihm darf die Funktionsimplementierung von ELU in der Software nicht erwähnt oder in den Runtime-Code einfließen, da das die Modularität und Performance unnötig einschränkt. Die ELU-Funktion sollte auf derselben Performanzebene wie ReLU laufen. Und zwar bestmöglich über clevere Mathe-Optimierungen, die Hotz sogar direkt in Form eines Python-Codesketches vorschlägt. Besonders die Herausforderung, dass ELU schneller oder zumindest gleich effizient wie ReLU sein muss, verdeutlicht einen Fokus auf Mikro-Optimierungen, die den Unterschied bei KI-Berechnungen ausmachen können. Tenstorrent wird zudem ermutigt, den Compiler als eine wichtige Komponente zu sehen, welcher sich um Speicherplatzierung, Zeitplanung der Operationen und Kernel-Fusion kümmert und solche Aspekte von mathematischen Funktionen strikt trennt.

Dies ist ein Bereich, in dem wenig Kompromiss erlaubt ist, weshalb die Einbindung externer, schwergewichtiger bibliothekarischer Layers, wie sie oft bei MLIR oder LLVM vorkommen, zu vermeiden oder sorgfältig zu handhaben sind. Letztlich ruft Hotz dazu auf, bei Frontends kreativ und effizient zu sein. Wenn eine Aktivierungsfunktion trotz mathematischer Einfachheit nicht die nötige Performance erreicht, wird geraten, nochmals intern nachzubessern, bis die gleiche Leistung erreicht ist. Denn nur wer sein Wissen bis auf die Macro- und Mikroebene durchdringt, kann Hardware und Software so eng koppeln, dass enorme Effizienzsteigerungen im KI-Computing herauskommen. Die voreingestellten Hinweise, wie eine Aktivierungsfunktion implementiert sein sollte, reichen dabei nicht als Tipp, sondern werden als die eigentliche Code-Basis bezeichnet, womit Hotz den Fokus auf praktische Umsetzbarkeit und Innovationsgeist lenkt.