In der Welt der Computertechnik stellt Wärme sowohl ein ständiges Begleitphänomen als auch eine große Herausforderung dar. Die stetige Weiterentwicklung von Prozessoren, deren Komponentenanzahl sich gemäß Moores Gesetz alle zwei Jahre verdoppelt, geht unweigerlich mit einem höheren Wärmeaufkommen einher. Dies begrenzt zunehmend die Leistungsfähigkeit herkömmlicher Computer, da Wärme nicht nur die Stabilität beeinflusst, sondern auch die Lebensdauer der Bauteile stark verkürzt. Hersteller von Prozessoren stoßen deshalb an physikalische Grenzen, welche sie dazu bringen, Übertragungsgeschwindigkeiten zu drosseln, um ein Überhitzen zu verhindern – so liegt seit etwa 2005 die maximale Taktfrequenz bei circa 3 Gigahertz. Diese natürliche Schranke verhindert kurzfristig eine weitere Beschleunigung klassischer Schaltkreise und fordert neue Ansätze, wie Computer effizienter Arbeiten können, ohne dabei unkontrolliert Wärme abzugeben.

Ein vielversprechender Ansatz ist das Konzept der reversiblen Computer, die Berechnungen ermöglichen, ohne Informationseinheiten dauerhaft zu löschen und dadurch Energie zu verlieren. Die Idee ist faszinierend, da solche Systeme im Prinzip Berechnungen „rückwärts“ durchführen könnten, was klassische Computer nicht leisten können. Die Wurzel des Problems liegt in der Tatsache, dass herkömmliche Computer bei nahezu jedem logischen Vorgang Bits löschen oder irreversibel verändern. Während in Computerkreisen Informationsbits als Energiewellen interpretiert werden, führt das Verschwinden eines Bits zu einem Energieverlust, der sich zwangsläufig als Wärme zeigt und nicht ungenutzt bleibt. Der Physiker Rolf Landauer formulierte bereits 1961 ein fundamentales Gesetz, das den minimalen Energieverbrauch festlegt, der beim Löschen von Information anfällt.

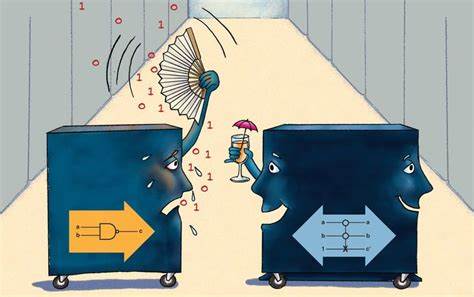

Dieser Energieverlust beträgt mindestens kT ln 2, wobei k die Boltzmann-Konstante ist, T die absolute Temperatur und ln 2 der natürliche Logarithmus von 2. Obwohl der Verlust pro Bit verschwindend gering erscheint, wird das skalierte Ausmaß bei modernen Computern mit Milliarden von Transistoren und Schaltvorgängen pro Sekunde schnell zu einem relevanten Faktor – die erzeugte Verlustleistung kann sich auf einige Kilowatt summieren. Diese wichtige Erkenntnis aus der Verbindung von Informationstheorie und Thermodynamik öffnete eine neue Denkweise, um Energieverluste beim Rechnen zu vermeiden. Der Schlüssel zur Lösung liegt im Prinzip der Reversibilität der Schaltkreise. Ein reversibler Schaltkreis besitzt die gleiche Anzahl an Ausgängen wie Eingängen, so dass jeder Ausgangszustand eindeutig auf einen Eingangszustand zurückgeführt werden kann.

Dies bedeutet, dass bei der Berechnung keine Informationen verloren gehen, und daher kein Energieverlust durch irreversible Bitveränderungen auftritt. In der Praxis bedeutet dies, dass es möglich ist, den Rechenvorgang auch rückwärts durchzuführen und frühere Systemzustände zu rekonstruieren. Diese Fähigkeit hat reversible Computer mit dem Spitznamen „Computer, die rückwärts laufen können“ versehen, da sie theoretisch in der Lage sind, Berechnungen umzudrehen und Fehler durch Rückkehr zu früheren Zuständen zu beheben. Historisch gesehen wurde die Idee der reversiblen Computer bereits in den 1950er Jahren erstmals studiert. Die Verbindung von Entropiebegriff in der Thermodynamik mit der Informationsentropie führte zur Erkenntnis, dass der Verlust von Information auch einen Anstieg der Entropie und damit Wärmeentwicklung zur Folge hat.

Doch erst in den 1970er Jahren unternahmen Forscher wie Charles Bennett und Richard Feynman bedeutende Schritte weiter. Bennett prägte den Begriff der „adiabatischen“ Berechnung, der aus der Thermodynamik stammt und eine energieabsorbierende, aber gleichzeitig keine Wärme abgebende Bewegung beschreibt. So könnte ein adiabatischer Computer theoretisch nahezu ohne Energieverlust operieren, wenn er einen umkehrbaren Rechenprozess verwendet. Feynman hingegen zeigte auf, dass der Einsatz reversibler Schaltungen keine fundamentale Mindestmenge an Energie für eine Berechnung erfordert, sofern die Geschwindigkeiten der Prozesse gegen Null tendieren. Ein wesentlicher Meilenstein im Bereich reversibler Logik war die Schaffung universeller reversibler Logikgatter durch Edward Fredkin und Tommaso Toffoli in den frühen 1980er Jahren.

Diese „Fredkin-Toffoli-Gatter“ erlauben es, normale logische Operationen auf reversibler Basis auszuführen, was für die Konzeption eines universellen Computers essenziell ist. Heutige Quantencomputer nutzen revolutionäre Technologien, die häufig mit reversiblen Prinzipien arbeiten, um Berechnungen mit Qubits durchzuführen. Dabei dienen Quanteneffekte wie Superposition und Verschränkung der Informationsspeicherung und Kommunikation, ohne die hitzeproduzierenden Probleme klassischer elektronischer Transistoren. Allerdings sind Quantencomputerschaltkreise äußerst empfindlich gegenüber Temperatur, weshalb sie in extrem gekühlten Umgebungen betrieben werden müssen, teilweise nahe am absoluten Nullpunkt. Trotz der theoretischen Möglichkeiten stehen reversible Computer noch vor erheblichen praktischen Herausforderungen.

Reversible Schaltungen müssen sehr langsam arbeiten, um den Verlust mechanischer oder kinetischer Energie beispielsweise durch Richtungswechsel von Elektronen zu reduzieren. Dies setzt bei herkömmlichen elektronischen Schaltungen eine Grenze. Photonenbasierte Systeme, wie sie in Quantencomputern vorkommen, unterliegen jedoch nicht denselben Beschränkungen, da Lichtteilchen masselos sind und beim Umschalten kaum Energie verlieren. Ein weiterer vielversprechender Forschungsbereich sind Quantenpunkte, nanoskalige Strukturen, die bestimmte Lichteigenschaften erzeugen und sich eventuell als Bausteine für aktive reversible Logikgatter bei Raumtemperatur eignen. Doch nicht alle Anwendungsfälle profitieren gleichermaßen von reversiblen Computern.

Beispielsweise benötigen Smartphones mehr Energie für Displays, GPS, Mobilfunk und weitere Peripheriegeräte als für die reine Datenverarbeitung. Anders sieht es in Hochleistungsrechenzentren aus, wo massenhafte Berechnungen im Vordergrund stehen. Dort könnten reversible Technologien signifikante Energieeinsparungen bringen und die Effizienz enorm steigern. Das Potenzial, den immensen Stromverbrauch großer Cloud-Infrastrukturen durch solche Innovationen zu senken, ist ein wesentlicher Antrieb für die Forschung. Auch auf der Ebene der Software besteht noch Anpassungsbedarf.

Viele Algorithmen sind derzeit irreversibel gestaltet, etwa durch bedingte Sprünge oder Funktionen, deren Ausführung nur vorwärts interpretiert werden kann. Forschungsgruppen, etwa am MIT, entwickeln deshalb Programmiersprachen und Compiler, die reversible Varianten dieser Algorithmen ermöglichen. Die Sprache EEL (Energy-Efficient Language) etwa beschränkt sich auf reversible Kontrollstrukturen und erlaubt damit eine Energie-ökonomischere Programmierung. Neben Energieeinsparungen verbessern reversible Algorithmen auch die Zuverlässigkeit von Computersystemen, weil sie Fehler leichter rückgängig machen können – ein interessanter Nebeneffekt aus Sicht der Systemstabilität. Zusammenfassend lässt sich sagen, dass reversible Computer einen vielversprechenden Weg darstellen, die technologischen Grenzen herkömmlicher Rechentechniken zu überwinden.

Sie können dabei helfen, den immer dringlicheren Bedarf nach energieeffizienter und nachhaltiger Informationsverarbeitung zu erfüllen. Zwar sind reversible Computer heute noch in weiten Teilen theoretisch und experimentell, doch Fortschritte bei Quantencomputing, Nanotechnologie und neuen Algorithmen geben Anlass zur Hoffnung, dass diese Konzepte in absehbarer Zeit praktischen Einsatz finden werden. Sie könnten nicht nur den Energieverbrauch von Rechenzentren drastisch reduzieren, sondern auch mit neuen Arbeitsweisen die Stabilität und Zuverlässigkeit von Software erhöhen. Die Zukunft der Computertechnik könnte somit in einem „rückwärts laufenden“ System liegen, das durch Reversibilität und Energieeffizienz neue Maßstäbe setzt und damit einen nachhaltigen Beitrag zu digitaler Innovation und Umweltschutz bietet.