Deep Learning hat die moderne Künstliche Intelligenz revolutioniert und ermöglicht heute beeindruckende Anwendungen in Sprachverarbeitung, Bilderkennung und sogar kreativen Bereichen wie Kunst und Musik. Doch trotz ihrer breiten Anwendung bleibt oft unklar, wie diese komplexen neuronalen Netze eigentlich funktionieren und warum sie so erfolgreich sind. Ein faszinierender Blickwinkel auf diese Frage bietet die angewandte Topologie – ein Zweig der Mathematik, der sich mit der Untersuchung von Formen, Flächen und deren Eigenschaften unabhängig von genauen Abmessungen beschäftigt. Im Kern zeigt Topologie, wie sich Daten so transformieren lassen, dass wichtige innere Strukturen trotz Verzerrungen erhalten bleiben. Diese Vorstellung eröffnet neue Perspektiven, um zu verstehen, wie Deep Learning Modelle Daten nicht nur verarbeiten, sondern in abstrahierte, semantisch sinnvolle Räume einbetten können.

Die Topologie befasst sich mit Eigenschaften, die bei kontinuierlichen Verformungen erhalten bleiben. Man kann sich das vorstellen wie einen Klumpen Knetmasse, der beliebig gebogen und gedreht werden kann, ohne dass sein grundlegender Charakter verloren geht. Eine Kaffeetasse kann topologisch so betrachtet werden wie ein Donut, da beide jeweils über einen einzigen Lochtes r verfügen – und dieses Merkmal bleibt erhalten, selbst wenn die Formen verzerrt werden. Diese Abstraktion ist überraschend mächtig, denn in der Datenverarbeitung geht es oft darum, wichtige Merkmale trotz unterschiedlicher Darstellungen zu erkennen. Beispielsweise ergeben verschiedene Bilder desselben Objekts einzigartige Pixelanordnungen, teilen aber dieselbe dahinterliegende Struktur.

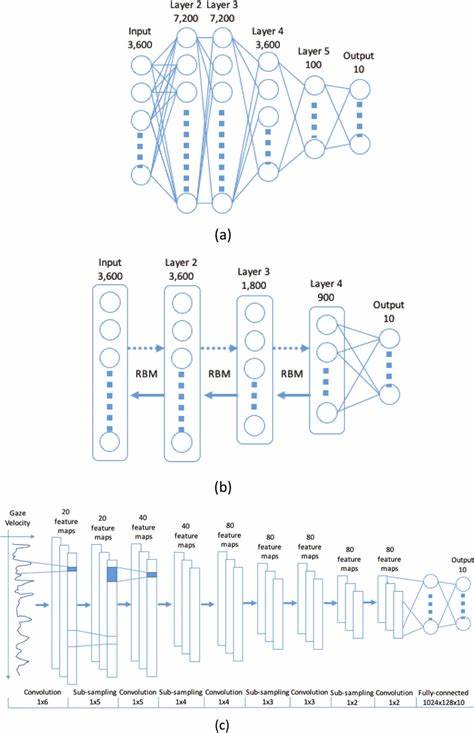

Im Kontext von Deep Learning lässt sich Datenrepräsentation anschaulich als Abbildung auf eine Mannigfaltigkeit interpretieren – eine Art hochdimensionales geometrisches Objekt, in dem Datenpunkte eine strukturierte Form annehmen. Diese Mannigfaltigkeit existiert im Raum der Merkmale, in dem ähnliche Objekte nahe beieinander liegen. So könnte man sich vorstellen, dass alle Bilder von Katzen einen bestimmten Bereich auf der Mannigfaltigkeit bilden, während Hunde in einer anderen Region vereint sind. Die Kunst der neuronalen Netze besteht darin, diese komplizierte, oft nicht linear trennbare Aufteilung durch eine Abfolge von Transformationen in einen Raum zu heben, in dem einfache, lineare Trennungen möglich werden. Diese Transformationen lassen sich mathematisch als Linearkombinationen und nicht-lineare Aktivierungsfunktionen beschreiben, die zusammen eine komplexe Verzerrung des ursprünglichen Datenraums bewirken.

Beispielsweise transformiert eine tanh-Aktivierung in Kombination mit gewichteten Matrizenmultiplikationen die Eingabedatenpunkte Schritt für Schritt. Man kann sich dabei einen kontinuierlichen Prozess vorstellen, bei dem eine anfängliche flache Oberfläche durch Biegen und Dehnen in eine komplexe Topologie überführt wird, die die Daten semantisch geordnet darstellt. Die linearen Transformationen entsprechen einer Verzerrung des zugrundeliegenden Raumes, während nicht-lineare Funktionen diesen Raum neu formen, so dass unterschiedliche Klassen von Daten besser unterscheidbar werden. Interessant wird es, wenn die Daten in niedrigdimensionalen Räumen nicht trennbar sind – etwa wenn wir Punkte gruppiert in konzentrischen Kreisen betrachten. In zwei Dimensionen gibt es keine einfache Linie, die diese Gruppen sauber trennt.

Die Lösung ist, den Raum in höhere Dimensionen zu erweitern. Dies entspricht einer topologischen Operation, bei der man weitere Dimensionen hinzufügt, um die komplexe Struktur der Daten besser erfassen zu können. Das neuronale Netz arbeitet genau nach diesem Prinzip: Es projiziert Eingabedaten in höherdimensionale Räume, wodurch die Trennung von Klassen möglich wird, die in tieferen Dimensionen unlösbar scheint. Diese Fähigkeit, durch hochdimensionale Transformationen komplexe Datenstrukturen einfach zu machen, macht neuronale Netze zu universellen Topologiegeneratoren. Sie „erschaffen“ nicht neue Formen, sondern entdecken und betonen inhärente topologische Eigenschaften der Daten, die durch Trainingsprozesse und objektiv definierte Verlustfunktionen geleitet werden.

Ob es sich dabei um Kategorisierung, Übersetzung oder Vorhersage handelt – jedes dieser Probleme spiegelt sich in einer spezifischen Topologie wider, die das Netz lernt abzubilden. So gruppiert sich beispielsweise im Sprachmodell die Repräsentation von Wörtern, die semantisch eng verwandt sind, sehr nah beieinander. Die berühmten Wort-Embedding-Operationen zeigen, dass Begriffe wie „König“, „Mann“ und „Frau“ auf mathematisch nachvollziehbare Weise miteinander verknüpft werden können – ein Beleg für die zugrundeliegende Struktur des Mannigfaltigkeitsraums. Die Existenz dieser hochdimensionalen Mannigfaltigkeiten wirft auch philosophische Fragen auf: Werden solche Topologien vom neuronalen Netz tatsächlich erschaffen oder nur entdeckt? Vermutlich lässt sich sagen, dass die Strukturen bereits im Datenmaterial inhärent vorhanden sind und das Netz lediglich geeignete Koordinatensysteme findet, um sie sichtbar und nutzbar zu machen. Farben sind ein einfaches Beispiel: Die RGB Darstellung lebt in einem 3D-Raum, in dem Mischungen wie „Lila“ einfach durch Addition von Vektoren erzeugt werden.

Dieses Konzept lässt sich auf Bilder, Töne und selbst abstrakte Konzepte übertragen. Reale Daten sind oft verrauscht oder chaotisch, dennoch lebt ein Großteil der relevanten Information auf kompakten, wohlgeformten Mannigfaltigkeiten, die das Netz lernen kann zu nutzen. Dabei wird das ursprüngliche Pixelrauschen oder irrelevante Details im hochdimensionalen Raum weit auseinander gezogen, sodass sie leichter ignoriert werden können. So entsteht eine semantische Ordnung inmitten scheinbarem Datenchaos. Die Verarbeitung von Daten durch Deep Learning lässt sich auch als Reise entlang dieser topologischen Räume verstehen.

Trainingsalgorithmen optimieren Modelle so, dass sie immer bessere Wege finden, um Aufgaben zu lösen – letztlich durch gezieltes Verschieben und Formen der Mannigfaltigkeit. Dabei spielen auch spezielle Trainingsmethoden wie Reinforcement Learning eine Rolle, die Modelle anhand quantifizierbarer Ziele systematisch verbessern. In der Praxis bildet das die Grundlage für Entwicklungen wie Chain-of-Thought-Finetuning, das die Modellfähigkeiten in komplexem, schrittweisem Denken verbessert, oder verbesserte Trainingsstrategien, die Modelle vom reinen Vorhersagen von Text weiter zur echten Problemlösung führen. Die Suche nach solchen Fortschritten ist zugleich Suche nach besseren Wegen, die ideale topologische Struktur für komplexe Aufgaben zu entdecken und zu modellieren. Übrigens lässt sich so eine Betrachtung auch auf die Modelle selbst anwenden: Die Gewichte eines neuronalen Netzes können als Punkte in einem noch höherdimensionalen Raum verstanden werden, die wiederum eine Art Modell-Mannigfaltigkeit formen.

Dort ordnen sich ähnliche Netzgewichte in Clustern an, die bestimmten Aufgaben entsprechen – etwa maschinelles Übersetzen oder Bildsegmentierung. Auch hier könnte man Verfahren aus der Topologie nutzen, um Modelle besser zu verstehen, neue Modelle gezielt zu generieren oder Optimierungen vorzunehmen. Ein besonders spannendes neues Forschungsfeld sind Diffusionsmodelle, die obige Konzepte sogar für die Erzeugung von komplett neuen Modellen verwenden. Hier wird durch sukzessives Hinzufügen von Rauschen an einem existierenden Modell ein Trainingsprozess aufgebaut, der das Rauschen Schritt für Schritt rückgängig macht. So lassen sich neue, qualitativ hochwertige Modelle erzeugen und trainieren, die besseren Ausgangspunkt für weitere Lernprozesse darstellen können.