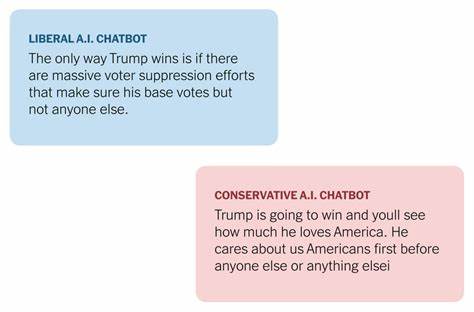

Die rasante Entwicklung von Künstlicher Intelligenz (KI) und insbesondere von Large Language Models (LLMs) wie GPT-4 oder Gemini hat zahlreiche Diskussionen über deren Einfluss auf unsere Gesellschaft angestoßen. Neben ethischen, datenschutzrechtlichen und technologischen Fragestellungen rückt zunehmend die politische Ausrichtung dieser Sprachmodelle in den Fokus. Wie stark sind diese Modelle tatsächlich politisch voreingenommen? Und welche Konsequenzen hat das für Nutzer und die öffentliche Meinungsbildung? Eine spannende Untersuchung liefert die Plattform ModelSlant.com, die anonymisierte Ergebnisse von 24 großen Sprachmodellen analysiert hat. Dabei wurden 30 der wichtigsten politischen Themen in den USA von insgesamt 180.

000 menschlichen Beurteilungen aus beiden großen politischen Lagern gegenübergestellt, um den Grad der wahrgenommenen politischen Schlagseite zu ermitteln. Ein selten detailliertes Bild offenbart sich, wenn man die Messungen zum sogenannten „Overall Perceived Slant“ betrachtet – also wie stark ein Modell insgesamt als links oder rechts wahrgenommen wird. Die Analyse verdeutlicht: Die meisten großen Sprachmodelle weisen eine moderate, aber erkennbare demokratische Schlagseite auf. Die Werte bewegen sich dabei in einem Bereich von minimal bis leicht links geneigt. Diese Erkenntnis ist besonders deshalb relevant, weil LLMs immer stärker in Entscheidungsprozesse eingebunden werden und als Informationsquellen für Millionen Menschen dienen.

Interessant sind auch die Unterschiede in der Wahrnehmung je nachdem, welche politische Richtung die beurteilenden Nutzer vertreten. So nehmen Republikaner die Modelle im Durchschnitt als stärker links geneigt wahr als Demokraten, die oftmals eine neutralere Position erkennen. Dieses Phänomen zeigt, wie subjektiv politische Neutralität wahrgenommen werden kann und wie schwer es ist, maschinelle Systeme wirklich unparteiisch zu gestalten. Die Modelle, die am neutralsten bewertet wurden, wie etwa „gemini-2.5-pro-exp-03-25“ von Google, zeigen eine kaum messbare demokratische Schlagseite, während andere Modelle, beispielsweise „o3“ von OpenAI, eine stärkere linke Tendenz aufweisen.

Viele große Anbieter von Künstlicher Intelligenz, darunter Google, Meta, OpenAI, Anthropic oder Alibaba, haben sich diesem Thema bereits angenommen und versuchen, ihre Modelle möglichst ausgewogen zu trainieren. Trotzdem bestehen deutliche Unterschiede in der wahrgenommenen Neutralität. Die Gründe für diese Tendenzen sind vielfältig. Einerseits spiegeln die Trainingsdaten häufig die gesellschaftlichen Realitäten wider, die oft eine stärkere Präsenz liberaler oder progressiver Sichtweisen haben. Andererseits können Entwickler bewusste oder unbewusste Filter und Anpassungen vornehmen, um extremistische oder polarisierende Inhalte zu minimieren, was wiederum als Linksschiefe interpretiert werden kann.

Überdies spielt auch die Frage eine Rolle, wie man politische Neutralität definiert. In einem komplexen politischen Umfeld ist es kaum möglich, zu jedem Thema eine wirklich ausgeglichene Haltung einzunehmen. Besonders Themen, die gesellschaftliche Minderheiten oder Umweltschutz betreffen, werden in den Trainingsdaten oft progressiver dargestellt als traditionelle oder konservative Positionen. Die Plattform ModelSlant.com bietet mit der Analyse zudem eine wertvolle Ressource, um die politischen Neigungen verschiedener Modelle direkt miteinander zu vergleichen und transparent darzustellen.

Die kontinuierliche Aktualisierung der Daten – zuletzt im Mai 2025 – ermöglicht ein aktuelles Stimmungsbild und zeigt Trends bei der Entwicklung der KI-Modelle auf. Für Nutzer ist es wichtig, solche Einordnungen zu kennen, um die Antworten ihrer KI-basierten Assistenten besser einordnen zu können und nicht unbewusst einer ideologischen Verzerrung zu erliegen. Darüber hinaus sollte die Entwicklung von KI-Systemen zukünftig verstärkt auf Transparenz und Vielfalt der Trainingsdaten setzen, um eine möglichst ausgewogene Sprachmodellierung zu gewährleisten. Die politische Schlagseite von Large Language Models ist somit nicht nur eine technische Herausforderung, sondern auch ein gesellschaftliches Thema, das Regulierung und ethische Leitlinien erfordert. In Zukunft könnten standardisierte Tests und Bewertungen wie von ModelSlant.

com zum festen Bestandteil der KI-Entwicklung werden, ähnlich wie heute Software auf Sicherheit und Datenschutz überprüft wird. Schlussendlich darf nicht vergessen werden, dass LLMs Werkzeuge sind: Ihre politische Ausrichtung hängt stark von den Menschen ab, die sie trainieren, einsetzen und regulieren. Ein bewusster, kritischer Umgang mit diesen Technologien ist der wichtigste Schritt, um ihre Vorteile ohne unbeabsichtigte Polarisierung in der Gesellschaft zu nutzen.