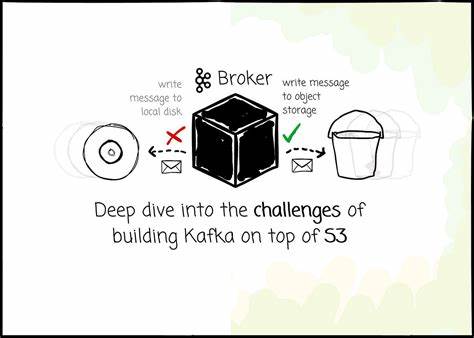

Apache Kafka hat sich seit seiner Open-Source-Veröffentlichung als führender Standard im Bereich verteilter Messaging-Systeme etabliert. Ursprünglich für lokale Rechenzentren konzipiert, steht Kafka heutzutage vor neuen Herausforderungen, wenn es um den Betrieb in cloudbasierten Umgebungen geht. Insbesondere das Zusammenspiel von Kafka mit objektspeicherbasierten Systemen wie Amazon S3 birgt ein großes Potenzial, aber auch komplexe technische Hürden. In dieser tiefgehenden Analyse werden die Herausforderungen beleuchtet, die mit dem Aufbau einer Kafka-ähnlichen Infrastruktur auf S3 verbunden sind, und potenzielle Lösungsansätze vorgestellt. Der Fokus liegt dabei nicht auf den Grundlagen von Kafka, sondern auf den Besonderheiten einer Cloud-nativen Architektur.

Die Motivation, Kafka-Daten in Objekt-Storage-Systeme auszulagern, liegt hauptsächlich in der Kostenoptimierung und der besseren Skalierbarkeit. Kafka koppelt in seiner klassischen Architektur Rechenleistung und Speicher eng miteinander, was eine unabhängige Skalierung erschwert und oft zu Ressourcenineffizienzen führt. Zudem erfordert die von Kafka eingesetzte Replikation eine aufwändige Synchronisation der Daten zwischen mehreren Broker-Knoten. In einer Cloud-Umgebung verursachen insbesondere die Datenübertragungen zwischen verschiedenen Verfügbarkeitszonen erhebliche Kosten. Amazon S3 bietet in diesem Zusammenhang den Vorteil eines kostengünstigen und hochverfügbaren Objektspeichers, der durch ausgereifte Mechanismen eigene Replikationen und Datensicherung übernimmt.

Ein zentrales Problem beim Betrieb von Kafka auf S3 ist die Latenz. Mit Latenzzeiten im Bereich von 15 Millisekunden bei GET-Anfragen liegt S3 deutlich hinter den beeindruckend schnellen NVMe-SSDs, die Mikrosekunden-Bereiche erreichen. Diese Latenzunterschiede beeinflussen besonders kritische Pfade wie das Schreiben von Nachrichten. Manche Anbieter akzeptieren diese höhere Latenz als Kompromiss, indem sie eine Bestätigung erst nach vollständiger Persistenz in S3 senden. AutoMQ, eine Open-Source-Lösung, verfolgt stattdessen einen hybriden Ansatz: Nachrichten werden zunächst in ein Write Ahead Log (WAL) geschrieben, das auf schnellen lokalen oder cloud-basierten Blockspeichern wie AWS EBS liegt.

Erst nach Bestätigung der WAL-Persistenz erfolgt die asynchrone Übertragung der Daten zu S3. So wird eine Schreiblatenz unter 10 Millisekunden realisiert, während gleichzeitig die Vorteile von S3 genutzt werden können. Die IOPS (Input/Output Operations Per Second) und damit verbundene Kosten stellen eine weitere Herausforderung dar. Direkte PUT-Operationen in S3 sind mit Kosten verbunden, die sich bei hoher Nachrichtenfrequenz schnell summieren. Dieses Problem wird durch das Batching von Nachrichten gemildert, wodurch mehrere Datenpunkte zu großen Objekten gebündelt werden.

In der Praxis entstehen verschiedene Objektarten: sogenannte Stream Set Objects enthalten Datenabschnitte von verschiedenen Partitionen, während Stream Objects Daten aus einzelnen Partitionen bündeln. Zusammengeführt durch einen Kompaktierungsprozess, wird so sichergestellt, dass Daten zusammenhängend gespeichert sind und die Anzahl der Objekte reduziert wird, um sowohl Kosten als auch Performance zu optimieren. Caching spielt eine entscheidende Rolle, um die Zugriffsperformance auf gespeicherte Daten zu verbessern und die Anzahl teurer S3-GET-Operationen zu minimieren. Lösungen wie AutoMQ implementieren differenzierte Cache-Ebenen, die zwischen Hot-Data-Caches für aktuelle Nachrichten und Block-Caches für historische Daten unterscheiden. Hierbei werden Techniken wie Prefetching und Batch-Reading genutzt, um Leselatenzen signifikant zu senken.

Ein effektives Cache-Management ist jedoch komplex, da Cache-Invalidierung zu den schwierigsten Herausforderungen in der Softwareentwicklung zählt. AutoMQ adressiert dies, indem es eine klare Partitionierung und Datenlokalität beibehält. Metadatenverwaltung auf S3 stellt ebenfalls eine besondere Herausforderung dar. Während Kafka beim lokalen Dateisystem einfache Verzeichnis-Scans zur Segmentverwaltung durchführt, sind vergleichbare LIST-Anfragen auf S3 teuer und langsam. Die erhöhte Anzahl von Objekten in S3 führt zu einer exponentiellen Steigerung der Metadatenverwaltungsaufwände.

Um dem entgegenzuwirken, nutzt AutoMQ die zuvor erwähnte Kompaktierung und verwaltet Meta-Informationen strukturiert in sogenannten Meta-Streams, welche gezielt Anfragen nach Branchendaten ermöglichen und teure S3-Operationen vermeiden. Zudem wird die Cluster-Metadatenverwaltung mit Kraft umgesetzt, wodurch zentrale Controller eine einheitliche und effiziente Verwaltung gewährleisten. Das Ziel einer Kafka-kompatiblen Lösung ist es, Anwendern einen reibungslosen Wechsel zu ermöglichen, ohne dass bestehende Clients angepasst werden müssen. Dies ist allerdings äußerst herausfordernd, weil Kafka tief in seiner Architektur auf die Annahme beruht, Daten auf lokalen Dateisystemen zu lagern. Objektspeicher hingegen erlauben keine einfachen Append-Operationen, sondern sind unveränderlich.

Während einige Wettbewerber das Kafka-Protokoll vollständig neu entwickeln, fokussiert sich AutoMQ darauf, allein die Speicher-Schicht so zu transformieren, dass der Rest der Kafka-Logik unverändert bleiben kann. Hierbei werden die Kern-Mechanismen von Kafka wie Partitionierung, Replikation und Indizierung mit neuen Abstraktionen wie „Streams“ überlagert, um den Objekt-Speicher effektiv zu nutzen. Die Architekturkonzepte vereinen bei AutoMQ die Vorteile von Shared-Nothing- und Shared-Disk-Ansätzen. Das klassische Kafka bindet Partitionen strikt an spezifische Broker (Shared-Nothing), während ein S3-basierter Speicher prinzipiell jedem Broker den Zugriff ermöglicht (Shared-Disk). Trotzdem hält AutoMQ an der Partition-Zuweisung zu bestimmten Brokern fest, um Datenlokalität und effiziente Cache-Nutzung sicherzustellen.

Dies reduziert den Netzwerkverkehr und verbessert die Performance. Die Netzwerkoptimierung ist kritisch, da die verschiedenen Arten von Datenverkehr – vom Schreiben über historische Konsumenten-Reads bis hin zu Hintergrundkompaktierung – sich gegenseitig behindern können. AutoMQ löst dieses Problem durch einen mehrstufigen asynchronen Rate-Limiter, der Netzwerkverkehr priorisiert und so Ressourcen gemäß ihrer Dringlichkeit zuweist. Dies garantiert, dass etwa Schreiboperationen nicht durch Hintergrundaufgaben ausgebremst werden. Ein besonders teurer Kostenfaktor im Cloud-Betrieb sind die grenzüberschreitenden Datenübertragungen zwischen unterschiedlichen Availability Zones.

Kafka verursacht hier auf zwei Wegen Kosten: durch das Schreiben des Producers zu einem Leader in einer anderen Zone sowie durch die Replikation des Leaders zu anderen Followern in verschiedenen Zonen. Während S3 die Datenreplikationen übernimmt und damit die zweite Ursache eliminiert, adressiert AutoMQ die erste Herausforderung durch ein intelligentes Broker-Mapping. Dabei wird der Produzent stets mit einem Broker in der gleichen Availability Zone verbunden, der die Nachrichten zunächst im lokalen WAL schreibt. Erst dann erfolgt eine asynchrone Übertragung und der eigentliche Broker-Partition-Leader wird informiert. Dieser Ansatz begrenzt die cross-AZ-Datenübertragung deutlich und spart Kosten.

Zusammenfassend zeigt die Integration von Apache Kafka mit einem Objekt-Speicher wie Amazon S3, wie vielschichtig die technischen Herausforderungen im Bereich Latenz, IOPS, konsistente Metadatenverwaltung, Cache-Handling und Netzwerkkosten sind. Die Balance zwischen Kostenersparnis und Leistung erfordert innovative Ansätze wie die Nutzung von Write Ahead Logs, intelligente Datenkompaktierung und hybride Speicherstrategien. Open-Source-Projekte wie AutoMQ demonstrieren, dass es möglich ist, Kafka-kompatible Lösungen zu entwickeln, die in der Cloud effizient, kosteneffektiv und kompatibel bleiben. Die Zukunft verteilter Streaming-Systeme wird stark von der Fähigkeit abhängen, die Vorteile von Cloud-Infrastrukturen optimal zu nutzen, ohne Abstriche bei der Performance und Zuverlässigkeit zu machen.