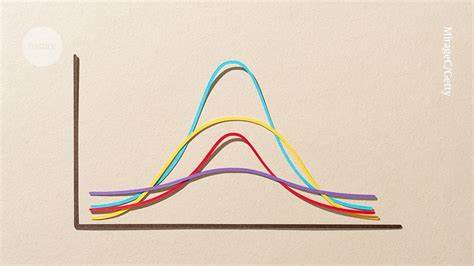

P-Hacking ist ein Phänomen, das in der wissenschaftlichen Forschung immer mehr Aufmerksamkeit erlangt. Es beschreibt Praktiken, bei denen Forscher Daten so analysieren oder auswählen, dass ein statistisch signifikantes Ergebnis erzielt wird, obwohl dieses Ergebnis möglicherweise nicht valide oder reproduzierbar ist. Das „P“ steht hierbei für den sogenannten P-Wert, der in der Statistik angibt, wie wahrscheinlich es ist, dass das gefundene Ergebnis durch Zufall entstanden ist. Ein Wert unter 0,05 gilt oft als Schwellenwert für „Signifikanz“. Doch die Lockung dieser Schwelle gelegentlich zu umgehen, führt zu verzerrten Studienergebnissen und schwächt somit die Glaubwürdigkeit der Wissenschaft.

Die Gefahr des P-Hackings ist insbesondere in Zeiten des hohen Publikationsdrucks und Wettbewerbs um Forschungsförderungen groß. Forscher stehen unter einem enormen Druck, Ergebnisse zu liefern, die neu, interessant und dringend veröffentlicht werden müssen. Daher wenden sie manchmal unbewusst Analysepraktiken an, die das Risiko von Falsch-Positiven erhöhen und die eigentliche Aussagekraft der Daten reduzieren. Eine typische Situation des P-Hackings beginnt, wenn Wissenschaftler vorzeitig in ihre Daten hineinschauen, noch bevor die Datenerhebung vollständig abgeschlossen ist. Das Verlangen, möglichst schnell ein signifikantes Ergebnis zu erhalten, verleitet viele dazu, den Status der Forschung so früh zu bewerten.

Wenn der P-Wert knapp über der Schwelle liegt, probieren sie leicht abgewandelte statistische Methoden aus oder bearbeiten das Datenmaterial so lange, bis der Wert unter 0,05 fällt. Doch genau diese Flexibilität in der Datenanalyse, die auf der einen Seite wissenschaftlich sinnvoll erscheinen mag, kann die Validität der Ergebnisse erheblich beeinträchtigen. Eine weitere Form des P-Hackings liegt in der Multiplen Testung ohne entsprechende Korrektur. Wenn Forscher viele verschiedene Hypothesen testen oder zahlreiche Variablen miteinander vergleichen, steigt automatisch die Wahrscheinlichkeit, mindestens einen als signifikant erscheinenden Befund rein zufällig zu finden. Ohne transparente Offenlegung der getesteten Modelle und ohne Anpassung der Signifikanzschwelle wird diese Tatsache oft übersehen, und Ergebnisse werden falsch interpretiert.

Auch das selektive Berichten von Ergebnissen trägt zum P-Hacking bei. Wenn nur die Ergebnisse publiziert werden, die statistisch signifikant sind, während „negative“ oder nicht signifikante Befunde verschwinden, entsteht ein verzerrtes Bild der Forschungslage. Dieses sogenannte „Publication Bias“ sorgt dafür, dass wissenschaftliche Veröffentlichungen häufiger positive Ergebnisse zeigen als tatsächlich vorhanden sind und führt insgesamt zu einer Überschätzung von Effekten. Wichtig ist außerdem der Umgang mit Ausreißern und fehlenden Daten. Manipulative oder inkonsistente Methoden beim Bereinigen und Auswählen von Daten können unbewusst zum P-Hacking beitragen.

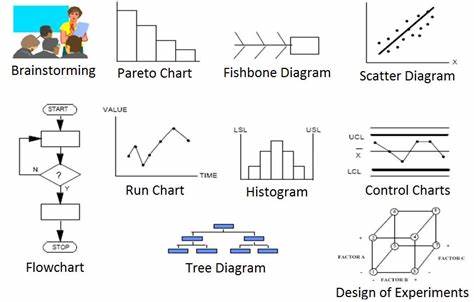

Wenn Forscher Ausreißer entfernen, um gewünschte Ergebnisse zu erreichen oder suboptimale Strategien zur Handhabung fehlender Werte einsetzen, wird die Aussagekraft der Statistik unzuverlässig. Um P-Hacking zu vermeiden, ist eine transparente und vorab festgelegte Analyseplanung essenziell. Die Registrierung von Studienprotokollen vor Beginn der Datenerhebung und das Festlegen der Haupt- und Nebenziele stellen sicher, dass Forscher ihre Hypothesen nicht im Nachhinein an die Daten anpassen. Open Science Praktiken fördern zudem die Nachvollziehbarkeit. Die gemeinsame Veröffentlichung von Rohdaten und Analysecode ermöglicht es anderen Wissenschaftlern, die Ergebnisse zu überprüfen und zu reproduzieren.

Ein besseres Bewusstsein für statistische Konzepte wie multiple Testkorrekturen, Effektstärken und Konfidenzintervalle sowie der Verzicht auf eine blinde Fixierung auf den P-Wert als alleinigen Maßstab für wissenschaftliche Relevanz sind weitere Schritte hin zu mehr Qualität. Außerdem kann der Einsatz moderner statistischer Methoden oder die Verwendung von ergänzenden bayesianischen Ansätzen die Aussagekraft von Studien verbessern. In der heutigen Forschungskultur sollte nicht ausschließlich die Signifikanz eines Ergebnisses zählen, sondern auch dessen praktische Relevanz, Robustheit und Übertragbarkeit. Fachgesellschaften, Forschungseinrichtungen und Verlage können durch klare Richtlinien und Schulungen zu verantwortungsvollem Umgang mit statistischen Daten das Risiko von P-Hacking reduzieren. Der gesellschaftliche Nutzen von Wissenschaft hängt maßgeblich davon ab, dass Forschungsergebnisse verlässlich sind und nicht durch methodische Fehltritte verfälscht werden.

Letztlich ist P-Hacking kein Zeichen von böser Absicht, sondern vor allem ein Problem mangelnder statistischer Bildung und inadäquater Forschungspraktiken. Sensibilisierung, bessere Ausbildung und strukturierte Peer-Review Prozesse sind deshalb entscheidend, um Wissenschaft transparent, glaubwürdig und nachhaltig zu gestalten. Forscher aller Disziplinen profitieren davon, wenn sie sich dieser Problematik bewusst werden und ihr methodisches Repertoire gezielt erweitern. Nur so kann wissenschaftliches Wissen objektiv wachsen und echten Fortschritt ermöglichen. Mit den zunehmenden Anforderungen an Reproduzierbarkeit und Offenheit bietet sich eine große Chance, P-Hacking als ernst zu nehmendes Risiko zu erkennen und langfristig aus der wissenschaftlichen Praxis zu verbannen.

Die Integrität und der Wert von Forschungsergebnissen stehen damit auf einem stabileren Fundament als je zuvor.