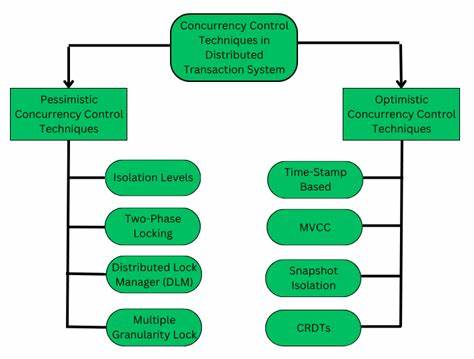

Die Konstruktion und Implementierung verteilter Systeme gehört zu den herausforderndsten Aufgaben in der Informatik. Komplexe dezentrale Architekturen, insbesondere solche, die auf Byzantine Fehlertoleranz setzen, stellen Entwickler und Forscher kontinuierlich vor komplexe Probleme. Eines der zentralen Themen bei der Gestaltung solcher Systeme ist der Umgang mit Nebenläufigkeit. Sie ist inhärent für verteilte Systeme, führt jedoch häufig zu schwer nachvollziehbarem, fehleranfälligem und kompliziertem Code. Ein innovativer Ansatz, der diese Herausforderung adressiert, ist die reversible deterministische Nebenläufigkeit, wie sie im Kontext des Replica_IO Frameworks entwickelt wird.

Diese Idee eröffnet neue Perspektiven zur Modellierung, Implementierung und Verifikation verteilter Protokolle auf einer soliden theoretischen Basis. Nebenläufigkeit ist ein Phänomen, bei dem mehrere Rechenoperationen gleichzeitig oder in einer nicht vorherbestimmten Reihenfolge ablaufen können. Traditionelle Modellierungen verteilter Systeme verwenden oft ungerichtete Ereignisabfolgen und asynchrone Kommunikation, was die Nachvollziehbarkeit stark erschwert. Probleme wie Deadlocks, Race Conditions und versteckte Datenflüsse treten häufig auf, wenn die Nebenläufigkeit nicht konsequent kontrolliert und beschrieben wird. Die reversible deterministische Nebenläufigkeit schlägt vor, alle Komponenten als deterministische Bausteine zu verstehen, die miteinander interagieren und deren Verhalten vollständig durch ihre Eingaben definiert werden.

Wichtiger noch: Diese Komponenten sollen reversibel sein, das heißt, aus den Ausgaben ist der ursprüngliche Zustand immer wiederherstellbar. Diese Rückführbarkeit garantiert nicht nur eindeutige Informationserhaltung, sondern ermöglicht auch eine umfassende Analyse und Rückverfolgung von Abläufen in komplexen Systemen. Durch diese Eigenschaft wird das Debuggen und die Verifikation erheblich erleichtert. Ein Modell, das den Informationsfluss in einer solchen Systeme explizit macht und streng deterministisch modelliert, schafft eine Grundlage für modulare und composable Programmierung, bei der einzelne Bausteine unabhängig voneinander betrachtet und korrekt zusammengesetzt werden können. Im Kern basiert die Idee darauf, Systeme als Zusammenfügungen von Komponenten zu verstehen, die jeweils über genau definierte Ein- und Ausgabeschnittstellen kommunizieren.

Diese Schnittstellen – sogenannte Interaktionslinien – sind streng typisiert und paarweise verbunden, sodass Daten nur entlang dieser Verbindungen fließen können. Damit entsteht ein graphenartiges Netzwerk, das den Informationsaustausch strikt regelt. Durch die Hierarchisierung der Komponenten in Basiskomponenten und zusammengesetzte Komponenten lassen sich komplexe Systeme bis auf atomare Operationen herunterbrechen oder modular aufbauen. Die Kommunikation zwischen Komponenten wird formal über Input-Output-Paare definiert, wobei jede Eingabe mit genau einer Ausgabe verbunden ist. Dadurch entstehen sogenannte Interaktionslinien, die Daten in Form von streng typisierten Objekten übertragen.

Diese Linien sind hochgradig nebenläufig: Sobald die notwendigen Eingaben vorliegen, können die Ausgaben erzeugt und weitergeleitet werden, unabhängig von zeitlichen Abläufen anderer Linien. Dieses Modell verbindet also Nebenläufigkeit implizit durch Datenverfügbarkeit und Struktur des Systems, anstatt explizit durch Kontrollflüsse oder Ereignissteuerungen. Ein bemerkenswerter Grundsatz dieser Methode ist, dass alle Berechnungen deterministisch und reversibel sind. Determinismus hier bedeutet, dass Ausgangswerte stets eindeutig durch die Eingaben bestimmt sind, unabhängig von der Reihenfolge ihres Eintreffens. Reversibilität gewährleistet die vollständige Rückgewinnung der ursprünglichen Eingaben aus den Ausgaben.

Zusammen gesprochen garantieren diese beiden Konzepte, dass keine „verborgenen“ Informationsflüsse stattfinden – der Prozess lässt sich jederzeit nachvollziehbar rückwärts durchlaufen. Aus der Perspektive moderner Informationstheorie und physikalischer Prinzipien impliziert dies eine Art Informationskonservierung, ähnlich wie sie in der Quanten- und reversiblen Berechnung vorgeschlagen wird. Eine einfache, aber illustrative Basiskomponente ist der sogenannte Sum-Komponent, der zwei Ganzzahlen verarbeitet. Ein Wert wird unverändert durchgeleitet, der andere ergibt sich als Summe beider Eingabewerte. Dieses Beispiel verdeutlicht, wie ein Baustein sowohl deterministisch arbeitet, als auch durch Umkehrung die ursprünglichen Werte rekonstruiert.

Ein weiteres Beispiel ist die kontrollierte Vertauschung (generalized controlled swap), inspiriert durch die Fredkin-Gatter aus der Quanteninformatik. Durch eine Steuerleitung entscheidet sie, ob zwei Werte vertauscht oder unverändert weitergegeben werden. Die Komponente ist selbstinvers, was die Reversibilität eindrucksvoll illustriert. Neben den einfachen Datenübertragungsmodellen definiert das Framework Mechanismen für Synchronisation und Kontrolle des Datenflusses. So können Synchronisationsbalken eingesetzt werden, die sicherstellen, dass mehrere Werte nur gemeinsam verfügbar werden, ohne dabei die Daten an sich zu verändern.

Signallinien, die nur Existenzinformation (keinen Wert) übertragen, ermöglichen Steuerungsinformationen mit minimaler Komplexität. Außerdem können Komponenten Verzögerungen repräsentieren, um zeitabhängiges Verhalten abzubilden, was für protokollseitige Timeouts oder Timer essentiell ist. Ein wichtiger Bestandteil solcher Systeme sind zudem Quellen für unbestimmte Werte (unspecified values). Anstatt zu jedem Zeitpunkt feste Werte zu fordern, erlauben diese Quellen eine Art „Superposition“ möglicher Werte, aus der während der Ausführung oder bei der Verifikation konkrete Werte gewählt beziehungsweise „festgelegt“ werden können. Diese Technik eröffnet eine elegante Möglichkeit, Non-Determinismus kontrolliert und explizit zu modellieren, wodurch sowohl Simulation als auch formale Verifikation vereinfacht werden.

Darüber hinaus werden komplexe adaptive Muster ebenfalls unterstützt. So lassen sich über Replikationsboxen sowie rekursive Strukturen Wiederholungen von Komponentenmodellen und Schleifen abbilden. Dies ist für die Modellierung von Protokollen mit mehrfachen Teilnehmern und iterativen Abläufen unverzichtbar. Der Ansatz stellt Domain-Abgrenzungen vor, bei denen Interaktionslinien in bestimmte systeminterne oder -externe „Orte“ eingeordnet werden. Damit lässt sich das Gesamtmodell eines verteilten Systems mittels Projektionen auf einzelne Knoten visualisieren und analysieren, was zu besseren Implementierungen und Debugging-Methoden auf Knotenebene führt.

Um die Tragfähigkeit der Methode zu demonstrieren, werden exemplarisch zwei bekannte verteilte Protokolle modelliert: Brachas zuverlässiger Broadcast und das Tendermint Konsensprotokoll. Brachas Protokoll dient als Basis für asynchrone Byzantine fehlerresistente Kommunikation. Es garantiert, dass eine Nachricht von einem Sender korrekt und einheitlich an alle empfangenden Parteien verbreitet wird, selbst wenn bis zu einem Drittel der Teilnehmer fehlerhaft oder böswillig agiert. Innerhalb des Models erfolgt die Nachbildung dieses Protokolls durch Aneinanderreihung von Komponenten für Punkt-zu-Punkt-Verbindungen, sogenannte Links, sowie Quorum-Komponenten, welche die Erreichung erforderlicher Mehrheiten modellieren. Die strikte Typisierung und Concurrency-Struktur ermöglichen eine klare Beschreibung dieser komplexen Kommunikationswege.

Das Modell beinhaltet auch Bausteine für sogenannte schwache und starke Quorums, die sich hinsichtlich ihrer Anforderungen an die Anzahl der Stimmen unterscheiden. Diese Quorums garantieren, dass eine ausreichende Anzahl an Knoten eine Nachricht oder Entscheidung bestätigt, um Fehlertoleranz und Konsistenz sicherzustellen. Zudem trägt eine Select-Komponente dazu bei, alternative Bedingungen für die Auslösung von Nachrichten zu abstrahieren und dynamisch zu entscheiden. Die Modellierung von Brachas Broadcast bringt eine saubere Abstraktion hervor, die sowohl den asynchronen Nachrichtenfluss als auch die inneren Protokollbedingungen unterstützt. Dies verhindert versteckte Nebenwirkungen oder unerwartete Interdependenzen und fördert damit nachweislich haltbare und überblickbare Systeme.

Beim Tendermint-Protokoll handelt es sich um einen sequenzbasierten Konsensalgorithmus, welcher neben der Byzantine Fehlerresistenz auch ein partiell synchrones Modell als Grundlage nutzt. Diese Partialsynchronität erlaubt es, dass zeitliche Annahmen gemacht werden, die jedoch nicht immer garantiert sind. Die Modellierung von Tendermint erfordert somit auch eine explizite Berücksichtigung von Zeit, Timeouts, und abortiven Verhaltensweisen, was durch Komponenten wie Delay und Signaling realisiert wird. Die komplexe Struktur von Tendermint mit seinen Höhen, Runden und verschiedenen Abstimmungsphasen – Proposal, Prevote und Precommit – wird durch geschachtelte Replikationen und modulare Komponenten dargestellt. Das Modell verwendet Gossip-Komponenten zur Abbildung von zuverlässiger Nachrichtenverteilung durch das Netzwerk.

Darüber hinaus illustriert das Modell, wie gemischte Quorums und Statusvariablen wie validValue und lockedValue innerhalb der Rundenkontrolle interagieren. Die Ausarbeitung der Round-Komponente zeigt, wie einzelne Protocol-Stages mit Fehlermanagement (Timeouts, Abbrüche) nahtlos eingebettet sind und mit den restlichen Protokollmodulen wie Commit- und Pacemaker-Komponenten zusammenspielen. Gerade die Wiederverwendbarkeit und Modulierbarkeit dieser Elemente demonstriert die Stärke des reversiblen, deterministischen Ansatzes. Insgesamt zeigt sich, dass reversible deterministische Nebenläufigkeit als strukturiertes Framework die Modellierung verteilter Systeme revolutionieren kann. Die Trennung von Informationsfluss, die explizite Behandlung von Nebenläufigkeit über Interaktionslinien und die Erhaltung von Information durch Reversibilität schaffen eine robuste Grundlage für bessere Modularität, Verifikation und Implementierung.

Diese Methode adressiert die typischen Herausforderungen verteilter Systeme, indem sie die Komplexität beherrschbar macht und den Grundstein für verbesserte Debugging-Techniken und Wissenstransparenz legt. Sie bietet gleichzeitig den Vorteil, dass bei der Projektion auf einzelne Knoten die lokale Logik klar verständlich bleibt, was bei realen Implementierungen von großem Nutzen ist. Damit befinden sich die Ideen noch in einem frühen Entwicklungsstadium. Zukünftige Arbeiten werden sich vor allem mit der formalen Ausgestaltung von Spezifikationen, der Entwicklung von Textnotationen für Systeme dieser Art sowie der Realisierung in Programmiersprachen wie Rust beschäftigen. Auch die praktische Evaluierung hinsichtlich Leistungsfähigkeit, Expressivität und Limitationen wird essenziell sein.

Die reversible deterministische Nebenläufigkeit verspricht einen Paradigmenwechsel für die Implementierung verteilter Systeme, indem sie reinere und berechenbare Modelle bereitstellt, die weniger fehleranfällig sind und mehr Vertrauen in komplexen Umgebungen schaffen. Als Grundlage für Frameworks wie Replica_IO öffnet sie den Weg zu neuartigen Softwarearchitekturen, die den Anforderungen moderner dezentrale Anwendungen gewachsen sind.

![What do you all think of the latest Apple paper on LLM capabilities? [pdf]](/images/F307C3F5-E4E6-4AF7-92AF-8EDA8CCD1308)