Die Wahl der richtigen Datenbanktechnologie ist für Unternehmen ein entscheidender Faktor, wenn es um Skalierbarkeit, Kosten und Performance geht. In den letzten Jahren hat sich PostgreSQL als eine der führenden relationalen Open-Source-Datenbanken etabliert, die zahlreiche Vorteile bietet und dabei nicht nur durch Stabilität, sondern auch durch Flexibilität und ein breites Ökosystem überzeugt. Während verteilte Datenbanken wie CockroachDB verlockende Eigenschaften mit horizontaler Skalierung und Multi-Region-Setups anbieten, zeigen sich in der Praxis oft unerwartete Nachteile, die viele Unternehmen zum Umdenken bewegen. Eine detaillierte Analyse eines Migrationsprojekts von CockroachDB zu PostgreSQL offenbart spannende Einblicke in die realen Herausforderungen sowie die beeindruckenden Vorteile, die ein Umstieg mit sich bringt. Ursprünglich entschieden sich einige Firmen für CockroachDB, um von der einfachen Horizontal-Skalierung und der hohen Verfügbarkeit zu profitieren.

Insbesondere die Möglichkeit, Daten regional zu lokalisieren und so Datenschutzanforderungen wie der DSGVO gerecht zu werden, war ein wichtiges Argument. Doch je größer die Datenbasis und je intensiver die Nutzung wurde, desto gravierender traten Performanceprobleme und hohe Betriebskosten zutage. Die Kostensteigerung war enorm: So verzeichnete ein Unternehmen einen fünfzehnfachen Anstieg der Ausgaben innerhalb kurzer Zeit mit CockroachDB. Dabei stellte sich zudem heraus, dass viele der Spezialfunktionen der verteilten Datenbank nicht einmal vollumfänglich genutzt wurden, da der Betrieb hauptsächlich in einer einzigen Region und mit einfachen, transaktionalen Abfragen vorgenommen wurde. Das warf die Frage auf, warum man die zusätzlichen Kosten einer verteilten Datenbank trägt, wenn die grundlegenden Anforderungen auch mit einer traditionellen relationalen Datenbank abgedeckt werden können.

Ein besonders kritischer Engpass zeigte sich bei Migrationen von Datenbankschemata. Gerade bei laufendem Betrieb werden solche Änderungen unweigerlich notwendig. Mit der ORM-Lösung Prisma gestaltete sich das Management von Migrationen unter CockroachDB zunehmend schwierig: Zeitüberschreitungen traten regelmäßig auf, sodass Entwickler auf manuelle Eingriffe angewiesen waren, die oftmals mehrere Stunden in Anspruch nahmen. Die Unzuverlässigkeit der Migrationsprozesse führte dazu, dass Entwickler systematisch versuchten, Operationen außerhalb der Datenbank zu realisieren, um Sperrungen und längere Downtimes zu vermeiden. Ebenso zeigten sich Probleme beim Einsatz von ETL-Tools, da es praktisch keine ausgereiften Lösungen gab, die CockroachDB zuverlässig unterstützten.

Von der einzigen verfügbaren Connector-Lösung, einem Airbyte-Plugin, das sich noch im Alphastadium befand, war kaum praktikabler Nutzen zu erwarten, da es regelmäßig zu Speicherlecks und Abbrüchen kam. Diese Unzulänglichkeiten behinderten die Datenintegration und erforderliche Datenflüsse für weitere Anwendungen oder Analyseprozesse spürbar. Interessanterweise sind bei der Performance von Abfragen unter CockroachDB und PostgreSQL gemischte Ergebnisse zu beobachten. Während manche komplexe Abfragen durch den speziellen Optimierer von CockroachDB beschleunigt wurden, zeigten viele Alltagsabfragen, insbesondere jene, die durch ORM-Frameworks wie Prisma generiert wurden, deutliche Schwächen bei der Verteilung der Anfragen auf mehrere Knoten. Oft wurde ein Full Table Scan ausgelöst und die Abfragezeiten lagen teils im Bereich des bis zu Zwanzigfachen im Vergleich zu PostgreSQL.

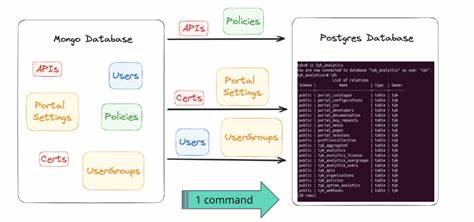

Zusätzlich erschwerten ungenutzte Indizes und fehlende intuitive Verwaltungsoberflächen die Arbeit der Entwicklerteams. Das Management von laufenden, teils ressourcenintensiven Abfragen gestaltete sich in CockroachDB zudem unkomfortabel, da ein einfaches Abbrechen lang laufender Queries nicht ohne den Zugang zur Cockroach-Konsole möglich war. Neben diesen technischen Hürden ergab sich auch eine unbefriedigende Support-Struktur, die langwierige Wartezeiten verursachte, und vor allen Dingen bei kritischen Fehlern wenig hilfreich war. Neben den technischen Herausforderungen bot PostgreSQL als etablierte Lösung ein Ökosystem an bewährten Tools zur Überwachung und Optimierung von Abfragen sowie eine leistungsstarke und zuverlässige Umgebung. Während die Migration selbst eine komplexe und kritische Aufgabe darstellt, zeigte sich, dass durch sorgfältige Planung, den Einsatz von skriptgestützten ETL-Prozessen und leistungsstarker Hardware die Umstellung innerhalb vergleichsweise kurzer Zeit möglich ist.

Die beschriebenen Migrationserfahrungen bestätigen das Potenzial von PostgreSQL für den produktiven Einsatz selbst in sehr datenintensiven Umgebungen. Das Projekt zeigte, dass die unterbrechungsfreie Übertragung von circa 100 Millionen Tabellenzeilen in einer produktiven Landschaft machbar ist und dass die Gesamt-Downtime unter einer Stunde, bei höchster Vorsicht gemanagt, gehalten wurde. Langfristig führte die Umstellung zu einer offensichtlichen Verbesserung der Reaktionszeiten der Anwendungen, messbar in einem signifikanten Rückgang der aggregierten Anfragelatenzen, und brachte neben Performance-Gewinnen auch deutliche Kosteneinsparungen mit sich. Diese Resultate veranlassten die Verantwortlichen abschließend dazu, PostgreSQL als die nachhaltigere, wartungsfreundlichere und wirtschaftlichere Lösung für ihre zukünftigen Anforderungen zu positionieren. Für Unternehmen, die sich aktuell mit der Wahl des richtigen Datenbanksystems auseinandersetzen, liefert diese Migration wertvolle Erkenntnisse.

Die Entscheidung für eine verteilte Datenbank sollte vor allem dann getroffen werden, wenn die Architektur wirklich von Multi-Region-Replikation, synchroner Verfügbarkeit und elastischer horizontaler Skalierung profitiert. Ist der Anwendungsfall jedoch geprägt von simplerer Abfrage- und Transaktionslogik, einer überschaubaren Anzahl von Regionen sowie einem Fokus auf Entwicklungs- und Betriebssicherheit, eröffnet PostgreSQL oftmals die effizientere und kostengünstigere Alternative. Darüber hinaus zeigt die Migration eindrücklich, wie wichtig es ist, die Datenbankanforderungen nicht nur aus technischer Sicht, sondern auch unter wirtschaftlichen Gesichtspunkten zu analysieren. Die Kosten für Cloud-Ressourcen, Support und Entwicklerzeit summieren sich schnell und beeinflussen die gesamte Infrastruktur nachhaltig. Ein transparenter und pragmatischer Ansatz bei Datenbankentscheidungen wirkt sich somit direkt auf den Erfolg eines Projekts aus.

Nicht zuletzt spielt das Ökosystem rund um PostgreSQL eine wichtige Rolle. Die Vielzahl an erweiterten Funktionen, die breite Community-Unterstützung sowie das reiche Angebot an Werkzeugen für Monitoring, Backup und Migration ermöglichen eine flexible Anpassung an individuelle Geschäftsbedürfnisse. Die offene Architektur von PostgreSQL fördert Innovationen und erleichtert die Integration in bestehende Umgebungen und moderne Entwicklungsprozesse. In Summe lässt sich festhalten, dass die Migration zu PostgreSQL für viele Firmen eine umsetzbare und gewinnbringende Strategie darstellt, um langfristig Kosten zu senken, die Systemperformance zu verbessern und operative Risiken zu reduzieren. Die Erfahrungen aus realen Migrationen liefern wertvolle Leitlinien für den Übergang und zeigen, dass selbst komplexe Datenlandschaften mit der richtigen Vorbereitung effizient transformiert werden können.

Damit Unternehmen in der heutigen datengetriebenen Welt agil, kosteneffizient und wettbewerbsfähig bleiben, ist die Auswahl der passenden Datenbanktechnologie von zentraler Bedeutung. Dabei erweisen sich klassische Lösungen wie PostgreSQL keinesfalls als veraltet – im Gegenteil, sie bieten eine stabile und skalierbare Basis, die durch kontinuierliche Weiterentwicklung mit den Anforderungen moderner Anwendungen Schritt hält. Die Migration zu PostgreSQL kann daher als eine zukunftsorientierte Entscheidung gewertet werden, die sowohl technische als auch monetäre Vorteile mit sich bringt, und somit einen unverzichtbaren Baustein in der IT-Strategie vieler Unternehmen bildet.