In der heutigen Ära der künstlichen Intelligenz (KI) gewinnen Sicherheitsmaßnahmen zunehmend an Bedeutung. Unternehmen und Organisationen setzen verstärkt auf sogenannte Red Teaming-Ansätze, um ihre KI-Systeme auf Schwachstellen zu testen und potenzielle Angriffe zu simulieren. Red Teaming beschreibt dabei eine Methode, bei der ein internes oder externes Team die KI wie ein potenzieller Angreifer analysiert, um Sicherheitslücken aufzudecken und diese zu beheben. Trotz der zunehmenden Relevanz und des breiten Einsatzes dieser Methode birgt das AI Red Teaming selbst eine trügerische Sicherheit, die in der Praxis oft unterschätzt wird.Der Kern des Problems liegt darin, dass Red Teaming zwar essentielle Einblicke in die Schwachstellen von KI-Systemen liefern kann, jedoch nie vollständig gegen alle Risiken und Angriffe immun macht.

Ein falsches Vertrauen in die Effektivität dieser Maßnahmen kann fatale Folgen haben. Es entsteht der Eindruck, dass die KI-Systeme durch erfolgreiches Red Teaming vollständig geschützt seien, was jedoch eine gefährliche Fehleinschätzung ist. Die Bedrohungslandschaft entwickelt sich ständig weiter, und Angreifer passen ihre Methoden kontinuierlich an. Somit ist ein einmal durchgeführtes Red Teaming nur eine Momentaufnahme, die nie den gesamten Sicherheitsbedarf abdecken kann.Ein weiterer Aspekt ist die Komplexität moderner KI-Modelle.

Deep Learning Systeme, insbesondere solche mit Millionen oder Milliarden von Parametern, sind hochgradig komplex und oft nicht transparent. Das macht es schwierig, alle Schwachstellen zu erkennen oder zu verstehen, wie ein Angriff im Detail ablaufen könnte. Red Teaming Tests basieren häufig auf bekannten Angriffsmethoden, doch neue oder unbekannte Angriffe können somit unentdeckt bleiben. Zudem können Red Teams in ihrer Analyse durch menschliche Faktoren limitiert sein, wie zum Beispiel durch begrenzte Kreativität, Zeitvorgaben oder mangelnde Ressourcen, was die Qualität der Tests beeinflusst.Die trügerische Sicherheit entsteht häufig auch aufgrund mangelnder Kommunikation und Transparenz.

Ergebnisse von Red Teaming Tests werden nicht immer umfassend an die Verantwortlichen weitergegeben, und die gewonnenen Erkenntnisse werden möglicherweise nicht nachhaltig in die Entwicklung oder den Betrieb der KI-Systeme eingebunden. Dies führt dazu, dass Sicherheitslücken trotz vorhandener Erkenntnisse nicht effektiv geschlossen werden und die Organisation weiterhin gefährdet bleibt. Ein durch Red Teaming erzeugtes Sicherheitsgefühl kann somit zu einer Nachlässigkeit führen, die Angreifern letztlich in die Karten spielt.Zudem darf nicht vergessen werden, dass das Red Teaming selbst eine Art Angriff simuliert und immer in einem definierten Rahmen abläuft. Es kann nur die Szenarien und Angriffsmöglichkeiten testen, die experimentell oder theoretisch bekannt sind.

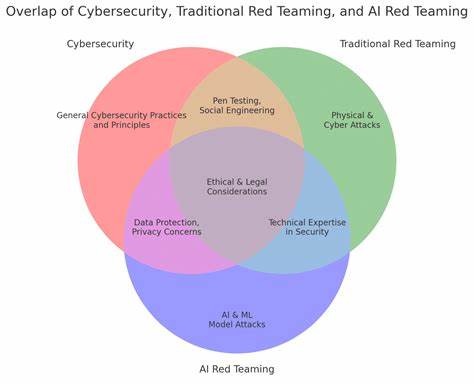

Insbesondere im Bereich der KI, wo Modelle oft auf Basis großer Datenmengen trainiert werden und hochdynamisch agieren, kann Red Teaming nur eine Teilmenge möglicher Angriffe erkennen. Exploits, die neue Lücken ausnutzen, unbekannte Biases in den Trainingsdaten oder manipulative Eingaben, die das System in unerwarteter Weise beeinflussen, lassen sich schwer fassen.Darüber hinaus sind ethische und rechtliche Fragestellungen nicht zu vernachlässigen. Wenn Red Teaming missverständlich eingesetzt oder die daraus gewonnenen Informationen nicht verantwortungsvoll gehandhabt werden, kann dies zu Datenschutzverletzungen oder falschen Sicherheitsbewertungen führen. Unternehmen müssen daher sicherstellen, dass ihre Red Teaming Maßnahmen nicht nur technisch effektiv sind, sondern auch ethisch vertretbar und rechtskonform durchgeführt werden.

Eine nachhaltige Absicherung von KI-Systemen erfordert daher einen ganzheitlichen Ansatz, der über das reine Red Teaming hinausgeht. Kontinuierliches Monitoring, Nutzerfeedback, die Integration von Sicherheitsexperten über den gesamten Entwicklungszyklus hinweg und die Implementierung adaptiver Sicherheitsmechanismen sind entscheidend. Ebenso wichtig ist die Bereitschaft, Sicherheitsvorkehrungen regelmäßig zu hinterfragen und zu aktualisieren, um mit der sich dynamisch verändernden Bedrohungslandschaft Schritt zu halten.Abschließend lässt sich festhalten, dass das Vertrauen auf KI Red Teaming als ultimative Sicherheitsmaßnahme ein Trugschluss sein kann. Während Red Teaming einen wichtigen Beitrag zur Absicherung von KI bietet, darf seine Rolle nicht überschätzt werden.

Nur durch eine Kombination aus verschiedenen Strategien und einem bewussten Umgang mit den Grenzen des Red Teamings ist es möglich, die tatsächliche Sicherheit von KI-Systemen signifikant zu erhöhen und eine fundierte, realistische Einschätzung der Risiken zu gewährleisten. Unternehmen sowie Entwickler sind daher gut beraten, das Thema mit der nötigen Vorsicht und Weitsicht anzugehen und die Illusion einer allumfassenden Sicherheit zu vermeiden.