In der heutigen Zeit erleben KI-Technologien eine explosionsartige Entwicklung, die neue und leistungsstarke Möglichkeiten für Unternehmen und Entwickler eröffnet. Besonders im Bereich der künstlichen Intelligenz rückt die effiziente Verarbeitung großer Datenmengen immer stärker in den Mittelpunkt. Async- und Batch-KI-Agenten sind dabei zentrale Werkzeuge, um komplexe KI-Workflows skalierbar, flexibel und ressourcenschonend zu gestalten. Ihre Fähigkeit, im Hintergrund sowie im Stapelbetrieb (Batch) große Mengen von Aufgaben automatisiert und parallel abzuarbeiten, macht sie für verschiedene Anwendungsbereiche unverzichtbar. Async- bzw.

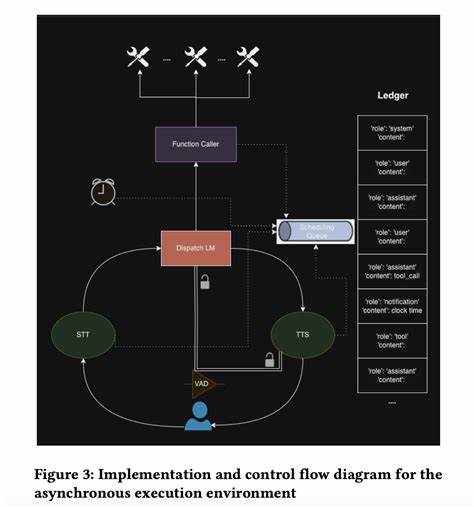

asynchrone Agenten erlauben es, KI-Inferenzprozesse nicht-blockierend auszuführen. Das bedeutet, dass komplexe Rechenoperationen, wie Bild- oder Spracherkennung, Verarbeitung natürlicher Sprache oder Vorhersagemodelle, im Hintergrund ablaufen, ohne die Hauptanwendung auszubremsen. Dies trägt entscheidend zu einer verbesserten Nutzererfahrung bei, denn Anfragen können sofort entgegengenommen und Antworten nach der Verarbeitung geliefert werden. Dieses Prinzip ist speziell dann nützlich, wenn die Datenmengen sehr groß sind, oder wenn AI-Aufgaben zeitintensiv sind und keine sofortige Rückmeldung erfordern. Batch-KI-Agenten hingegen bündeln Aufgaben in größeren Mengen und führen diese gesammelt aus.

Diese Methode ist besonders geeignet für Prozesse wie die Verarbeitung historischer Daten, Aggregation von Analyseergebnissen, regelmäßige Datenaktualisierungen oder das Training und Evaluieren von Modellen. Durch das Stapelverfahren können Ressourcen effizienter genutzt und Kosten reduziert werden, da Batch-Jobs zeitlich flexibel beispielsweise außerhalb der Spitzenlastzeiten ausgeführt werden können. Batch-Processing ist sehr gut skalierbar und passt sich leicht an schwankende Volumen von Anfragen oder Datenbeständen an. Die Kombination von Async- und Batch-Agenten stellt somit einen wichtigen Baustein dar, um KI-Systeme in der Praxis handhabbar und robust zu machen. Häufig werden beide Ansätze parallel eingesetzt: während die asynchronen Agenten für Echtzeit-Interaktionen und schnelle Reaktionen verantwortlich sind, übernehmen Batch-Prozesse die umfassende Datenverarbeitung im Hintergrund.

Bei der Umsetzung solcher KI-Agenten stellt sich immer die Frage nach der passenden Infrastruktur und den richtigen Werkzeugen zur Orchestrierung. Open Source Lösungen erfreuen sich großer Beliebtheit, da sie Flexibilität, Anpassbarkeit und Kostenersparnis bieten. Beispielsweise entwickelt die Plattform exosphere.host eine eigene Orchestrierungsengine namens Orbit, die speziell für das Management von Batch-KI-Agenten konzipiert ist. Diese Engine soll einfache Integration in bestehende Workflows ermöglichen und gleichzeitig die Verwaltung, Überwachung sowie Fehlerbehandlung automatisieren.

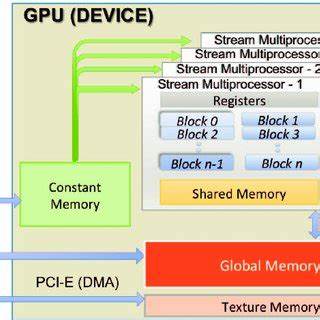

Ubergeordnete Orchestrierungssysteme müssen verschiedene Herausforderungen meistern. Dazu gehören die effektive Planung und Verteilung von Rechenjobs auf verfügbare Ressourcen, das Handling von Ausfällen, Wiederholungen bei Fehlern und die Überwachung der Systemleistung. Eine gute Orchestrierung sorgt dafür, dass Jobs rechtzeitig ausgeführt und mögliche Engpässe vermieden werden. Auch das Monitoring ist entscheidend, um Transparenz über den Zustand der laufenden Prozesse zu schaffen und eine schnelle Reaktion auf auftretende Probleme zu ermöglichen. In komplexen Umgebungen mit mehreren Cloud-Diensten, Datenbanken und Warteschlangen kommen so viele einzelne Komponenten zusammen, die zuverlässig koordiniert werden müssen.

Neben der technischen Infrastruktur sind auch konkrete Anwendungsfälle ausschlaggebend. Batch KI-Agenten werden häufig im Bereich Data Engineering, Business Intelligence und Marketing eingesetzt. Sie ermöglichen zum Beispiel die Analyse großer Kundenprofile, Verarbeitung von Nutzerverhalten oder Vorhersagen von Trends. In der Forschung unterstützen sie die Auswertung umfangreicher Datensätze, etwa für medizinische Studien oder Genomik. Gleichzeitig sind sie essenziell beim maschinellen Lernen, um Trainingsdaten zu verarbeiten oder Modell-Validierungen in kontrollierten Umgebungen durchzuführen.

Ein weiteres häufig diskutiertes Thema ist die Wahl zwischen Cloud-gehosteten oder selbstgehosteten Systemen zur Ausführung solcher KI-Agenten. Cloud-Lösungen bringen den Vorteil der sofortigen Skalierbarkeit, einfacher Verwaltung und oft moderner Sicherheitskonzepte. Sie sind besonders attraktiv für Unternehmen, die keine eigenen großen Rechenzentren betreiben wollen oder können. Andererseits sprechen Datenschutzbedenken und der Wunsch nach vollständiger Kontrolle manche Nutzer für selbstgehostete Lösungen. Hier müssen jedoch der Betrieb, Updates und Skalierung vom eigenen Team bewältigt werden – was mit einem höheren Aufwand einhergeht.

Die richtige Strategie hängt stark von den individuellen Anforderungen ab. Wer flexibel auf wechselnde Lasten reagieren muss und schnell initial starten möchte, profitiert eher von Cloud-Angeboten. Wenn hingegen Sicherheit, Anpassbarkeit und Unabhängigkeit im Vordergrund stehen, kann ein selbst gehostetes Orchestrierungssystem optimal sein. Im Idealfall bieten moderne Plattformen hybride Modelle an, um möglichst viele Szenarien abzudecken. Ein maßgeblicher Schmerzpunkt vieler Anwender bei der Skalierung von AI-Workflows ist der Umgang mit Fehlern und Wiederholungen.

Batch-Aufgaben können durch Hardwareausfälle, Netzwerkprobleme oder fehlerhafte Daten unterbrochen werden. Ohne ein durchdachtes Retry-Management verlieren Unternehmen wertvolle Rechenzeit und müssen Prozesse manuell neu starten. Automatisierte Überwachung in Kombination mit intelligentem Scheduling entlastet hier nachhaltig und sorgt für eine höhere Prozessstabilität. Ebenso wichtig ist die Integration in bestehende technische Ökosysteme. Daten müssen oft aus unterschiedlichen Quellen wie Datenbanken, Cloud-Storage-Diensten oder Messaging-Queues bezogen werden.

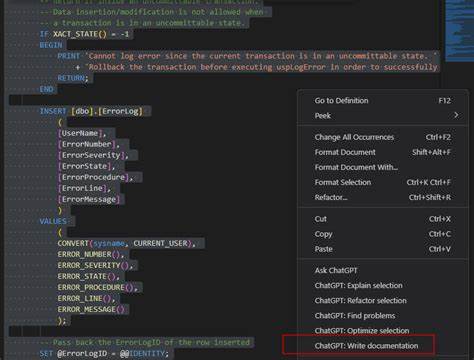

Gut gestaltete KI-Agenten sind modular aufgebaut und bieten Schnittstellen zu gängigen Technologien, um nahtlose Workflows zu schaffen. Offene Standards und APIs erleichtern die Kombination und den Austausch von Tools erheblich. Wenn Entwickler und Unternehmen sich fragen, was sie im eigenen KI-Pipeline verbessern könnten, fällt häufig das Thema Benutzerfreundlichkeit und Wartbarkeit. Komplexe Pipelines neigen dazu, schwer überschaubar und anfällig für Fehler zu sein. Eine intuitivere Steuerung, bessere Dokumentation der Abläufe und automatisierte Log-Analyse würden viele Arbeitsprozesse enorm verbessern.

Gleichzeitig soll Skalierung zunehmend ohne tiefes Expertenwissen möglich werden, um breitere Anwenderkreise zu erreichen. Abschließend lässt sich sagen, dass Async- und Batch-KI-Agenten fundamentale Bausteine moderner KI-Plattformen darstellen. Ihre Fähigkeit, große Datenmengen effizient zu verarbeiten, flexible Inferenzmodelle zu unterstützen und den Betrieb automatisierter Workflows zu gewährleisten, macht sie unerlässlich für den Erfolg von KI-Anwendungen. Wer seine KI-Workflows skalieren und stabil betreiben möchte, sollte nicht nur auf leistungsfähige Agenten setzen, sondern auch eine solide Orchestrierungsinfrastruktur mit Blick auf Monitoring, Fehlermanagement und Integration bereitstellen. Mit dem kontinuierlichen Fortschritt im Bereich KI und der Verfügbarkeit immer neuer Tools und Plattformen ergeben sich vielfältige Chancen für Unternehmen aller Branchen, ihre Prozesse intelligenter und effizienter zu gestalten.

Die Nutzung von Async- und Batch-KI-Agenten wird dabei zukünftig noch stärker an Bedeutung gewinnen und maßgeblich dazu beitragen, den Weg in eine automatisierte, datengetriebene Zukunft zu ebnen.