Die Wahl der richtigen Datenbanktechnologie ist für viele Unternehmen entscheidend, um Wachstum effektiv zu unterstützen und gleichzeitig die Betriebskosten im Griff zu behalten. Im Zuge des raschen Wachstums eines Tech-Unternehmens stellte sich früh die Frage, ob die bisher eingesetzte verteilte Datenbank CockroachDB zukünftig noch die beste Lösung für die Anforderungen ist. Diese Datenbank hatte ursprünglich mit ihren Fähigkeiten der horizontalen Skalierung, hohen Verfügbarkeit und ihrer SQL-Kompatibilität überzeugt. Doch die Praxis zeigte, dass mit zunehmendem Datenvolumen und steigender Nutzung auch die Herausforderungen und Kosten exponentiell anstiegen. Die Entscheidung zur Migration auf PostgreSQL fiel nicht über Nacht, sondern war das Ergebnis eingehender Analysen und Tests.

CockroachDB lag seit Anfang 2022 im Einsatz, vor allem aufgrund seiner Zuverlässigkeit im Multi-Region-Betrieb und der Erfüllung bestimmter regulatorischer Anforderungen wie der DSGVO. Gleichzeitig war die Sorge groß, ob eine traditionelle Lösung wie PostgreSQL mit ihren Grenzen bei Multi-Region-Setup und horizontaler Skalierung langfristig die Performance gewährleisten könne. Mit der Zeit jedoch erwiesen sich diese Bedenken als weniger relevant, da das Unternehmen weiterhin in einer einzigen Region agierte und der Fokus auf einfachen transaktionalen Abfragen lag. Trotz der fortschreitenden Nutzung verlangsamte sich das System spürbar, gleichzeitig kletterten die Cloud-Kosten für CockroachDB in die Höhe. Im Jahr 2024 waren die Ausgaben bereits fünffach so hoch wie zu Beginn, was das Gesamtbudget stark belastete.

Es stellte sich die Frage: Warum weiterhin für eine komplexere verteilte Architektur zahlen, wenn die Anforderungen aktuell keine solche Lösung erforderten? Ein wesentlicher Stolperstein war dabei das Management von Datenbankmigrationen über das ORM Prisma. Mit zunehmendem Umfang der Daten kam es immer wieder zu Timeouts beim Einspielen von Migrationen, was letztlich dazu führte, dass der Betrieb für Stunden blockiert war. Entwickler sahen sich gezwungen, manuell in die Datenbank einzugreifen und Migrationen Stück für Stück auszuführen. Solche temporären Eingriffe bergen Risiken, verzögern Updates und erschweren die Weiterentwicklung der Plattform. Um die Situation zu verbessern, wurden Vergleichstests zwischen CockroachDB und PostgreSQL durchgeführt.

Hier zeigte sich, dass eine Migration in PostgreSQL überraschend schnell vonstattengeht: Eine vergleichbare Migration, wie das Hinzufügen einer neuen Spalte, dauerte in einem kontrollierten Test in PostgreSQL nur Sekunden statt Stunden. Diese Performance-Unterschiede stärkten die Argumente für einen Wechsel. Auch im Bereich ETL-Prozesse wurde die Schwäche von CockroachDB sichtbar. Die Nutzung des ETL-Tools Airbyte offenbarte wiederkehrende Timeouts und Performance-Engpässe. Die Alpha-Version des Airbyte-Konnektors für CockroachDB litt sogar unter einem Speicherleck, das nur durch Workarounds vorübergehend behoben werden konnte.

Die Tatsache, dass es kaum ausgereifte Lösungen zur Replikation in CockroachDB gab, erschwerte Data-Engineering-Prozesse zusätzlich. Im täglichen Betrieb fielen zudem signifikante Unterschiede bei der Geschwindigkeit von Abfragen auf. Während CockroachDB bei einigen speziell optimierten Queries durch seinen ausgeklügelten Query-Planer schneller war, zeigte sich in der Mehrheit der produktiven Abfragen ein nachteiliger Trend. Komplexe SQL-Anfragen, die das ORM generierte, konnten vom CockroachDB-Optimierer oft nicht effizient verarbeitet werden, was zu Full-Table-Scans und entsprechend hohen Latenzen führte. Beispiele aus der Praxis offenbarten, dass Abfragen in PostgreSQL bis zu zwanzigmal schneller ausgeführt wurden.

Solche Performance-Probleme beeinträchtigen nicht nur die Backend-Prozesse, sondern wirken sich spürbar auf die Nutzererfahrung aus. Neben den technischen Einschränkungen traten auch Bedienprobleme im CockroachDB-UI auf. Die Anzeige von nicht genutzten Indizes war unklar und führte zu Verwirrung bei den Entwicklern. Die Möglichkeit, laufende Abfragen einfach abzubrechen, war ebenfalls eingeschränkt, was in kritischen Situationen zu Systeminstabilitäten führte. Eine weitere Belastung waren wiederkehrende Connectivity-Probleme, insbesondere im Zusammenspiel mit Tailscale VPN-Diensten.

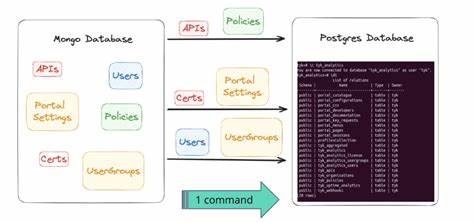

Immer wieder kam es zu temporären DNS-Fehlern oder nicht erreichbaren Datenbankservern, was die Stabilität in verschiedenen Umgebungen störte. Solche Fehler mussten oft mühsam untersucht werden und sorgten für Ausfallzeiten und Mehraufwand im Support. Die Umsetzung der Migration stellte eine erhebliche Herausforderung dar, zumal die größte Tabelle zu diesem Zeitpunkt bereits etwa 100 Millionen Datensätze enthielt. Die Standard-ETL-Tools und Connectoren waren für eine solche Größenordnung nicht ausgelegt, insbesondere beim Wechsel von einem System mit spezifischer JSON- und Array-Bytecodierung zu einem anderen. Aus diesem Grund wurde eine eigens entwickelte Lösung mit der Programmiersprache Bun implementiert.

Diese ermöglichte es, Daten sequenziell und parallelisiert aus CockroachDB auszulesen, in das passende CSV-Format zu bringen und in PostgreSQL einzuspielen. Die unterschiedliche Serialisierung von komplexen Datentypen zwischen beiden Systemen erforderte zusätzliche Anpassungen. Mit Hilfe von spezialisierten CSV-Parsing- und Transformationswerkzeugen wurde sichergestellt, dass die Datenintegrität gewahrt blieb und keine Nutzerunterschiede entstanden. Die Migration erfolgte schließlich mit einem großen virtuellen Server in der Cloud, was die Verarbeitung der Datenmengen beschleunigte. Während des nächtlichen Migrationsfensters, das bewusst großzügig geplant wurde, blieb das System für unter einer Stunde im Wartungsmodus.

In dieser Zeit gelang der vollständige Transfer ohne Datenverlust und mit nur minimaler Downtime. Im Anschluss konnten alle Services stufenweise wieder hochgefahren werden. Erste Messungen zeigten eine unmittelbare Verbesserung bei der Antwortzeit von Anfragen – eine verbesserte Performance von rund 33 Prozent war deutlich spürbar. Neben der unmittelbaren Effizienzsteigerung bot der Umstieg auf PostgreSQL weitere Vorteile. Dank der großen und aktiven Community konnten viele bislang unoptimierte Abfragen schnell identifiziert und angepasst werden.

Tools wie PGAnalyze ermöglichten eine systematische Analyse und Optimierung der Datenbankperformance, welche den Betrieb auch langfristig stabilisierte. Ebenfalls hatte die günstigere Infrastruktur direkten Einfluss auf die Kostensituation, sodass der Umstieg mittelfristig mehrere Hunderttausend Euro an Einsparungen ermöglichte. Die Migration zeigt exemplarisch, wie wichtig die Wahl der passenden Datenbanktechnologie im Kontext individuellen Wachstums ist. Verteilte Systeme wie CockroachDB sind in vielen Szenarien mächtig und unverzichtbar, doch die Praxis beweist, dass es neben theoretischer Skalierung auch auf den Aufwand für Betrieb, Wartung und Support ankommt. Eine traditionelle relationale Datenbank wie PostgreSQL kann oftmals die bessere Wahl sein, wenn der Einsatzfall primär aus transaktionalen Anfragen in einer Region besteht und Kostenbewusstsein im Vordergrund steht.

Unternehmen, die eine Migration planen oder sich in einer ähnlichen Situation befinden, können von den hier beschriebenen Erfahrungen profitieren. Eine sorgfältige Testphase, bedarfsgerechte Werkzeuge zur Datenmigration und ein gut durchdachtes Ausfallmanagement sind unverzichtbar für einen reibungslosen Umstieg. Gleichzeitig ist es wichtig, neben technischer Machbarkeit auch die Betriebskosten und das gesamte Ecosystem in die Entscheidung mit einzubeziehen. Die vorgestellte Migration von CockroachDB zu PostgreSQL ist nicht nur eine technische Erfolgsgeschichte, sondern verdeutlicht auch, wie durch pragmatische Entscheidungen und innovative Lösungen betriebliche Effizienz gesteigert werden kann. Im Zusammenspiel mit einer aktiven Entwicklercommunity erlaubt PostgreSQL eine nachhaltige Skalierung und bleibt damit ein essenzieller Baustein moderner Backend-Architekturen.

Für Unternehmen, die ähnliche Herausforderungen meistern möchten, sind kontinuierliche Innovation und flexible Anpassung der Schlüssel zum Erfolg. Denn nicht jede Technologie passt dauerhaft zu einem wachsenden Produkt oder einer sich weiterentwickelnden Infrastruktur. Die Fähigkeit, den passenden Technologie-Mix zu finden – und bei Bedarf zu wechseln – entscheidet oft maßgeblich über Wettbewerbsfähigkeit und Zukunftsfähigkeit.