In der heutigen Zeit, in der Informationen aus wissenschaftlichen Studien ständig auf uns einprasseln, ist es essentiell, kritische Fähigkeiten im Umgang mit solchen Daten zu entwickeln. Insbesondere das Verständnis von Warnzeichen in der Gestaltung und Interpretation von Experimenten spielt eine zentrale Rolle, um Erkenntnisse richtig einordnen und bewerten zu können. Die Aussage „Die Gruppe mit Behandlung X zeigte signifikant weniger Krankheitsfälle (p=1%)“ wird oft fälschlicherweise als 99% Wahrscheinlichkeit für die Wirksamkeit der Behandlung interpretiert. Eine solche Gleichsetzung ist jedoch trügerisch und führt häufig zu irreführenden Einschätzungen. Es gibt unterschiedliche Möglichkeiten, warum ein Experiment solch scheinbar eindeutige Ergebnisse bringen kann: Die Behandlung kann tatsächlich wirken, sie könnte nur für eine Untergruppe wirksam sein oder der beobachtete Effekt ist auf Zufall, systematische Fehler oder Fehlinterpretationen zurückzuführen.

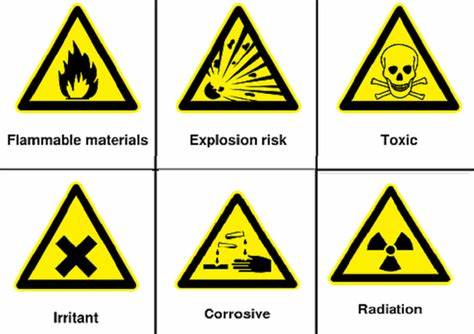

Deshalb ist es wichtig, bestimmte Warnsignale zu erkennen, die die Zuverlässigkeit und Aussagekraft eines Experiments beeinflussen. Zu den grundlegendsten Kriterien einer validen Untersuchung gehört die Durchführung einer randomisierten kontrollierten Studie. Hierbei werden die Probanden per Zufall in eine Behandlungs- und Kontrollgruppe eingeteilt. Nur so ist ein fairer Vergleich möglich, da alle Störvariablen gleichmäßig verteilt werden und der Effekt der Intervention isoliert betrachtet werden kann. Der Verzicht auf diese Praxis, sofern möglich, ist ein klares Warnsignal.

Problematisch wird es, wenn historische Vergleichswerte oder unbalancierte Stichprobenherkünfte statt echter Kontrollgruppen verwendet werden. Die Versuchspersonen sollten möglichst repräsentativ ausgewählt und zufällig zugeordnet werden, um Verzerrungen durch experimentelle Voreingenommenheit und bewusste oder unbewusste Beeinflussung der Gruppenzuweisung zu vermeiden. Ein weiteres essentielles Element ist die Doppelblindstudie. Weder die Teilnehmenden noch die Forschenden sollen wissen, wer die Behandlung oder das Placebo erhält. Dies verhindert psychologische Effekte wie den Placeboeffekt, bei dem die Erwartung auf eine Wirkung bereits Verbesserungen bewirken kann.

Ebenso existiert die Gefahr, dass Forschende, wenn sie die Gruppenzugehörigkeit kennen, Probanden unterschiedlich behandeln oder Ergebnisse verzerrt interpretieren. Studien ohne Blindversuch laufen daher Gefahr, Ergebnisse falsch zu deuten oder zu überschätzen. Auch die Anzahl der Probanden hat großen Einfluss auf die Studienergebnisse. Zu wenige Teilnehmende können zu zufälligen Verzerrungen führen, die fälschlicherweise als signifikante Effekte gewertet werden. Andererseits kann ein Übermaß an Probanden ineffizient sein, wenn es darum geht, erste Hinweise zu generieren.

Für valide Ergebnisse sollten die Studiengröße und Methodik sorgfältig aufeinander abgestimmt sein, um sowohl systematische als auch zufällige Fehlerquellen zu minimieren. Die Auswahl der Versuchspersonen ist ein weiterer kritischer Punkt. Ein Mangel an Repräsentativität kann die Übertragbarkeit der Studienergebnisse stark einschränken. Ein klassisches Beispiel liefert die Wahl von Freiwilligen aus enger Altersgruppe oder Bildungsschicht, etwa Studierende, die nicht pauschal auf die Gesamtbevölkerung übertragen werden können. Ähnlich irreführend sind Meinungsumfragen, die nur bestimmte Bevölkerungsgruppen erreichen und so verzerrte Resultate produzieren können.

Nicht weniger wichtig sind die gestellten Forschungsfragen. Forscher können unbeabsichtigt oder absichtlich Fragestellungen formulieren, die nur einen Teilaspekt beleuchten, Messgrößen unzureichend wählen oder Umweltbedingungen schaffen, die wenig mit der Realität übereinstimmen. Dies führt zu Studien, die zwar methodisch korrekt sind, aber kaum praktische Relevanz besitzen. Die Auswahl falscher oder ungeeigneter Metriken trägt ebenso zur Unbrauchbarkeit bei. Die Auswahl und Anwendung statistischer Verfahren ist ein weiterer oft unterschätzter Faktor.

Versteht man die Verteilung der Daten nicht richtig, berücksichtigt man keine Ausreißer oder tritt eine Verletzung von Unabhängigkeitsannahmen auf, können Ergebnisse leicht verfälscht werden. Die Wahl der falschen statistischen Methode oder die Interpretation des p-Werts ohne Berücksichtigung anderer Fehlerquellen führt häufig zu überschätzten oder sogar falschen Aussagen. Das Vermeiden von „Data Mining“ oder dem „fishing for significance“ zählt ebenfalls zu den zentralen Prinzipien guter Forschung. Hypothesen sollten vor der Datensammlung definiert werden, da nachträgliches Finden signifikant erscheinender Ergebnisse bei einer Vielzahl von Variablen durch zufällige Schwankungen entstehen kann. Ohne beständige Wiederholungen und ohne unabhängige Bestätigung durch weitere Studien sind solche Erkenntnisse wenig belastbar.

Die Theorie, auf der eine Studie basiert, ist ebenfalls von Bedeutung. Daten ohne zumindest eine grundlegende theoretische Einordnung sind schwer zu interpretieren. Theorien helfen, Variablen zu identifizieren, die kontrolliert werden müssen und setzen den Rahmen, um spezifische Fragestellungen zielgerichtet zu untersuchen. Ohne ein solches Gerüst können alternative Erklärungen und zufällige Korrelationen kaum ausgeschlossen werden. Die Interpretation von Studienergebnissen erfordert besondere Sorgfalt.

Wiederholbarkeit und Reproduzierbarkeit sind entscheidende Merkmale, damit ein Ergebnis als belastbar gilt. Ebenso muss man der Veröffentlichungswahrscheinlichkeit negativer Ergebnisse sowie anderen Biasquellen Rechnung tragen. Publikationsbias sorgt dafür, dass erfolgreiche Studien mit signifikanten Resultaten eher publiziert werden als solche ohne Befund, was die Wahrnehmung des tatsächlichen Forschungsstandes verzerrt. Ein häufiger Fehler liegt im Missverständnis des p-Werts. Dieser gibt lediglich an, wie wahrscheinlich ein Ergebnis unter der Annahme ist, dass die Nullhypothese wahr ist, aber nicht wie wahrscheinlich die Hypothese selbst bei vorliegendem Ergebnis ist.

Trotzdem wird der p-Wert häufig fälschlicherweise als Maß für die Wahrscheinlichkeit der Wirksamkeit einer Behandlung interpretiert, was zu Fehleinschätzungen führt. Zudem hängt das notwendige p-Niveau davon ab, wie außergewöhnlich oder plausibel eine Behauptung ist. Für seltene oder außergewöhnliche Ergebnisse sind strengere Kriterien angemessen. Auch die berühmte Verwechslung von Korrelation und Kausalität ist eine der größten Fallstricke. Nur weil zwei Merkmale zusammen auftreten, heißt das nicht, dass eines das andere verursacht.

Gerade in epidemiologischen Studien ist dies essenziell zu beachten, da Störfaktoren oder reiner Zufall zu scheinbaren Zusammenhängen führen können. Um von Korrelation auf Kausalität zu schließen, braucht es kontrollierte Eingriffe oder sehr gute theoretische Begründungen. Schließlich spielt auch das Vertrauen in die Glaubwürdigkeit der Forschenden eine Rolle. Ereignisse, bei denen Studien durch Täuschung entlarvt wurden, zeigen die Notwendigkeit strenger wissenschaftlicher Methoden und kritischer Prüfung. Dennoch kann zu viel Skepsis gegenüber kreativen oder unerwarteten Forschungsergebnissen ebenfalls hinderlich sein.

Wichtig ist ein vernünftiger Mittelweg, bei dem solide Beweise verlangt werden, aber auch Offenheit für neue Erkenntnisse besteht. In der Summe lässt sich sagen, dass Wissenschaft nicht nur aus dem Sammeln von Daten und Auswerten von Statistiken besteht, sondern aus dem sorgfältigen Planen von Experimenten, der kritischen Durchführung, der angemessenen Interpretation und der transparenten Kommunikation. Indem man Risikofaktoren wie fehlende Randomisierung, mangelnde Kontrollgruppen, kleine Stichproben, ungeeignete Statistik, fehlende Wiederholbarkeit und voreilige Schlussfolgerungen erkennt, kann man sich vor Fehlinformationen schützen und echte Fortschritte in der Forschung fördern. Nur so gelingt es, zwischen fundierten und fragwürdigen Studien zu unterscheiden und bessere Entscheidungen in Medizin, Technik und Alltag zu treffen.