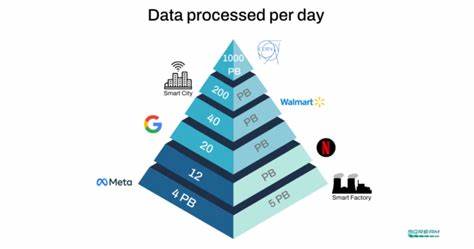

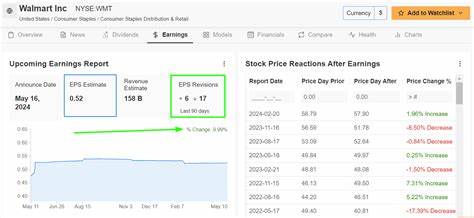

In der heutigen datengetriebenen Welt gewinnt die effiziente Verarbeitung großer Log-Datenmengen zunehmend an Bedeutung. Systeme wie Loki haben sich als leistungsfähige Lösungen für Log-Management etabliert, doch die Herausforderung besteht darin, diese Tools für extrem skalierbare Anforderungen, wie Petabyte-große Log-Abfragen, zu optimieren. In diesem Beitrag teile ich meine Erfahrungen und technischen Einblicke, wie ich Loki so erweitert und angepasst habe, dass es nun Petabyte-Skalen bewältigen kann – eine Leistungssteigerung, die wegweisend für große Unternehmen und datenintensive Anwendungen ist. Loki ist ursprünglich für Effizienz und Skalierbarkeit bei der Speicherung und Abfrage von Log-Daten konzipiert. Es besticht durch eine Architektur, die Log-Daten nahezu kosteneffizient speichert und durch Label-basierte Abfragen für schnelle Filterung sorgt.

Dennoch stößt auch Loki bei extrem großen Datenmengen auf Performance- und Speicherengpässe. Die Skalierung auf Petabyte-Ebene erfordert tiefgreifende Verbesserungen sowohl auf architektonischer als auch auf systemtechnischer Ebene. Eine der zentralen Herausforderungen bei der Skalierung auf derartige Datenvolumen betrifft die Indexierung. Während Loki klassischerweise auf eine minimale Indexierung setzt, um Speicherplatz zu sparen, reicht diese bei Petabyte-Daten nicht mehr aus, um schnelle Abfragen zu gewährleisten. Deshalb war es notwendig, das Indexierungsmodell maßgeblich zu erweitern.

Durch die Einführung adaptiver Indexpunkte, die dynamisch und kontextsensitiv erstellt werden, ließ sich die Abfragezeit bei sehr umfangreichen Datensätzen deutlich reduzieren. Diese adaptive Indexierung kombiniert klassische Inverted-Index-Strukturen mit probabilistischen Datenstrukturen wie Bloom-Filtern, die schnell Unwahrscheinlichkeiten bei Suchanfragen ausschließen können. Das Speichermanagement war ein weiterer kritischer Aspekt. Bei Petabyte-Daten ist der Einsatz von herkömmlichen Festplatten nicht mehr wirtschaftlich und performant genug. Daher integrierte ich eine hybride Speicherstrategie, die schnelle NVMe-SSDs für aktive Daten und hochkapazitive, kostengünstigere Cloud-Speicherlösungen für Langzeitarchivierung nutzt.

Ein intelligentes Datenverschiebungs- und Kompressionssystem sorgt dabei dafür, dass selten abgefragte Daten effizient archiviert und bei Bedarf schnell abgerufen werden können. Die Kompressionstechniken wurden speziell auf Log-Daten angepasst, wobei Mustererkennung und delta-codierte Speicherung eine wichtige Rolle spielen. Zur Bewältigung der enormen Datenmengen mussten auch die Abfrageprozesse optimiert werden. Die Implementierung eines verteilten Query-Engines, das parallel auf mehreren Knoten arbeitet, ermöglichte es, komplexe Filteroperationen auf Petabyte-Datensätzen innerhalb akzeptabler Latenzzeiten durchzuführen. Die Query-Engine ist zudem in der Lage, Abfragen dynamisch zu optimieren, indem sie Teilergebnisse intelligent zusammenführt und redundante Abfragen eliminiert.

Ein entscheidender Punkt ist die Skalierbarkeit der Infrastruktur. Um die Verfügbarkeit und Performance zu garantieren, wurde Loki in einem containerisierten Umfeld mit orchestrierter Verwaltung mittels Kubernetes betrieben. Hierbei wurde der Fokus auf eine elastische Skalierung gelegt, bei der Systemressourcen bei steigender Last automatisch erweitert und bei sinkendem Bedarf wieder reduziert werden. Diese Skalierbarkeit wird durch ein robustes Monitoring unterstützt, das nicht nur die Systemgesundheit überwacht, sondern auch Prognosen über zukünftige Lasten erstellt und frühzeitig Engpässe erkennt. Zusätzlich spielte die Integration von Machine-Learning-Ansätzen eine Rolle, um Anomalien und Muster in den riesigen Log-Daten zu identifizieren.

Mit speziell trainierten Modellen lassen sich Abweichungen und potenzielle Fehlerquellen automatisch herausfiltern, was die Effizienz der Analyse enorm erhöht. Diese Modelle sind Teil der erweiterten Loki-Architektur und ergänzen die klassische Syntax-basierte Abfragelogik durch intelligente Mustererkennung. Nicht zu vernachlässigen sind die Sicherheitsaspekte bei so einer großskaligen Log-Verwaltung. Um sensible Daten zu schützen, wurden Verschlüsselungsmechanismen sowohl bei der Speicherung als auch bei der Übertragung der Logs implementiert. Zudem kommt eine rollenbasierte Zugriffskontrolle zum Einsatz, die sicherstellt, dass nur autorisierte Nutzer bestimmte Logbereiche einsehen oder abfragen können.

Dies ist besonders in regulierten Branchen mit strengen Datenschutzanforderungen essenziell. Ein weiterer Verbesserungsbereich war die Benutzerfreundlichkeit bei der Abfragegestaltung und Visualisierung. Das erweiterte Loki bietet robuste APIs und flexible Schnittstellen, die sowohl Entwicklern als auch Analysten eine komfortable Bedienung erlauben. Durch Dashboards und Grafana-Integrationen können Erkenntnisse aus den Petabyte-Datenmengen intuitiv dargestellt werden, was die Entscheidungsfindung im Unternehmenskontext maßgeblich unterstützt. Die Weiterentwicklung von Loki in Richtung Unterstützung von Petabyte-Skalen ist ein spannendes Beispiel für die Herausforderungen moderner Big-Data-Systeme.