Die Cloud-Technologie ist heute eine zentrale Säule der digitalen Infrastruktur und ermöglicht Unternehmen aller Größenordnungen, ihre IT-Ressourcen flexibel und skalierbar zu nutzen. Doch mit dem explosionsartigen Wachstum von Cloud-Diensten steigen auch die Anforderungen an Effizienz und Zuverlässigkeit. Die Frage, wie Cloud-Anbieter ihre Ressourcen optimal verwalten können, ohne dabei an Performance oder Verfügbarkeit einzubüßen, rückt immer mehr in den Fokus. Ein Schlüssel zur Lösung dieser Herausforderung liegt im genauen Verständnis der Workload-Charakteristika, also der Eigenschaften und Anforderungen, die verschiedene Anwendungen und Kundenlasten mit sich bringen. Moderne Cloud-Anbieter setzen zahlreiche Techniken ein, um ihre Infrastruktur effizienter zu gestalten.

Dazu gehören Spot- und Harvest-VMs, Oversubscription, Auto-Scaling sowie vielfältige Optimierungsmethoden zur Lastverteilung und Ressourcenreservierung. Spot-VMs sind beispielsweise virtuelle Maschinen, die zu günstigeren Preisen angeboten werden, aber bei Bedarf des Anbieters mit kurzer Vorwarnzeit zurückgenommen werden können. Harvest-VMs nutzen Ressourcen, die temporär nicht beansprucht werden, um sie anderen Aufgaben verfügbar zu machen. Oversubscription beschreibt die Praxis, mehr Ressourcen zu vergeben, als physisch vorhanden sind, unter der Annahme, dass nicht alle Nutzer ihre Kapazitäten maximal auslasten. Auto-Scaling erlaubt es, Ressourcen automatisch an die aktuelle Last anzupassen.

Die Herausforderung besteht jedoch darin, diese Mechanismen zielgerichtet und intelligent einzusetzen. Ein Weg dorthin ist die detaillierte Charakterisierung der Workloads. Verschiedene Cloud-Anwendungen unterscheiden sich stark in Bezug auf ihre Ressourcenanforderungen, zeitliche Auslastungsmuster, Sensibilität gegenüber Störungen und Skalierbarkeit. Beispielsweise können Batch-Jobs stark rechenintensiv und tolerant gegenüber Unterbrechungen sein, während interaktive Webanwendungen niedrige Latenzzeiten und hohe Verfügbarkeit benötigen. Diese Variabilität erfordert ein flexibles und feingranulares Verständnis der Workload-Eigenschaften.

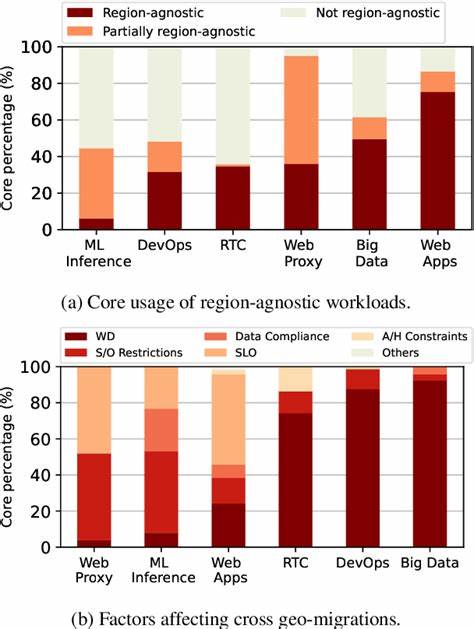

In einer groß angelegten empirischen Studie wurden über Microsofts interne Cloud-Workloads hinweg verschiedene Parameter analysiert, um diese Vielfalt besser zu begreifen. Ziel war es, die wichtigsten Kennzahlen zu identifizieren, die die Effizienz und Zuverlässigkeit in der Cloud beeinflussen. Gleichzeitig sollte ergründet werden, wie sich diese Merkmale zwischen unterschiedlichen Arten von Workloads unterscheiden. Dabei wurde versucht, Verfahren zu entwickeln, um Workloads automatisiert und skalierbar zu klassifizieren, sodass Cloud-Plattformen diese Erkenntnisse für die effiziente Ressourcenzuweisung nutzen können. Das Ergebnis war ein tiefersehendes Bild der Cloud-Nutzung aus erster Hand.

Es zeigte sich, dass bestimmte charakteristische Muster und Metriken wie CPU- und Speicherbedarf, I/O-Last, Laufzeitverhalten, Unterbrechungstoleranz und Skalierbarkeit je nach Anwendungstyp stark variieren. So sind beispielsweise interaktive Services häufig durch kurze, wiederkehrende Spitzen gekennzeichnet, während Batch-Anwendungen oft kontinuierliche, langandauernde Rechenaufgaben umfassen. Cloud-Plattformen können diese Differenzierung nutzen, um beispielsweise Spot-VMs gezielt für unterbrechungstolerante Aufgaben einzusetzen und damit Kosten zu senken, ohne kritische Anwendungen zu gefährden. Automatisierte Klassifikationen und maschinelle Lernmodelle spielen in der Analyse eine zunehmend wichtige Rolle. Sie ermöglichen es, anhand von Metriken und Telemetriedaten Workloads frühzeitig einzuordnen und entsprechende Optimierungen vorzuschlagen.

Eine solche datengetriebene Herangehensweise unterstützt Anbieter dabei, Ressourcenzuweisungen dynamisch anzupassen und die Cloud-Auslastung zu maximieren, während gleichzeitig Service-Level-Agreements (SLAs) eingehalten werden. Ein weiterer wichtiger Aspekt der Studie war das Bewusstsein für Zuverlässigkeit. Cloud-Anwendungen haben sehr verschiedene Anforderungen an Verfügbarkeit und Fehlertoleranz. Eine differenzierte Einordnung dieser Bedürfnisse erlaubt es der Infrastruktur, gezielt über Reservierungen oder spezielle VM-Typen wie hochverfügbare Ressourcen zu entscheiden. Gleichzeitig können weniger kritische Anwendungen von kostengünstigeren, aber potenziell unterbrechbaren Kapazitäten profitieren.

Somit lassen sich die teuren Premium-Ressourcen genau dort einsetzen, wo sie den größten Nutzen bringen. Die Studie betont zudem die Relevanz der Skalierung. Cloud-Workloads skalieren nicht nur in den Ressourcenanforderungen, sondern auch zeitlich sehr unterschiedlich. Während manche Anwendungen kontinuierlich hohe Ressourcen benötigen, zeigen andere Spitzen zur Tageszeit oder während bestimmter Ereignisse. Durch Workload-Bewusstsein lässt sich insbesondere mit Auto-Scaling und Lastverteilung besser auf solche Schwankungen reagierten und somit Effizienzgewinne realisieren.

Ausblickend bietet diese Forschung auch Ansatzpunkte für weiterführende Entwicklungen. Beispielsweise könnten Cloud-Anbieter künftig noch stärker kontextsensitive Optimierungen vornehmen, bei denen neben der reinen Workload-Charakteristik auch externe Faktoren wie Energieverbrauch, Umweltbedingungen oder Netzwerkzustand einbezogen werden. Auch das Zusammenspiel von Workload-Merkmalen mit energieeffizientem Ressourcenmanagement wird ein entscheidendes Thema sein, um nachhaltige Cloud-Plattformen zu gestalten. Insgesamt zeigt die empirische Analyse, dass eine differenzierte Betrachtung der Cloud-Workloads essenziell für den erfolgreichen Betrieb moderner Cloud-Systeme ist. Nur wer die Anforderungen und Eigenschaften der Anwendungen genau kennt und automatisiert auswertet, kann die komplexen Mechanismen wie Spot-VMs, Oversubscription und Auto-Scaling effektiv nutzen.

Die daraus resultierenden Effizienzsteigerungen bringen nicht nur wirtschaftliche Vorteile, sondern verbessern auch die Nutzererfahrung durch höhere Zuverlässigkeit und Flexibilität. Die Studie liefert daher wertvolle Einblicke für Cloud-Anbieter, Entwickler von Cloud-Anwendungen und Forschungsteams, die sich mit Cloud-Optimierung beschäftigen. Sie unterstreicht die Notwendigkeit, Workload-Daten systematisch zu erfassen und auszuwerten, um daraus zielgerichtete Strategien zu entwickeln. Mit der steigenden Verbreitung von Cloud Computing und der wachsenden Vielfalt an Workloads wird diese Arbeit zunehmend an Bedeutung gewinnen und die Grundlage für innovative Cloud-Dienste bilden, die sowohl effizient als auch zuverlässig sind.