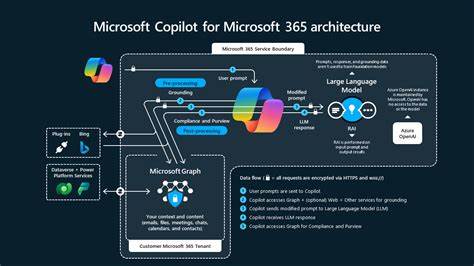

Im Januar 2025 wurde von Forschern der Firma Aim Labs eine schwerwiegende Zero-Click-Sicherheitslücke entdeckt, die Microsoft 365 Copilot betrifft. Diese Lücke, später als EchoLeak bekannt, stellte eine wahre Herausforderung für die Sicherheit von KI-gestützten Unternehmensanwendungen dar. Microsoft 365 Copilot ist ein intelligenter Assistent, der tief in Office-Anwendungen wie Word, Excel, Outlook und Teams integriert ist. Er nutzt die mächtigen Sprachmodelle von OpenAI, kombiniert mit Microsoft Graph-Daten, um komplexe Aufgaben wie das Generieren von Inhalten, Datenanalysen und das Beantworten von Fragen auf Basis interner Firmendaten zu ermöglichen. Die Entdeckung der EchoLeak-Schwachstelle offenbarte jedoch, dass Angreifer vollkommen ohne direktes Benutzer-Engagement potenziell hochsensible Daten aus dem Unternehmens-Ökosystem abgreifen konnten.

Diese Problematik wurde von Microsoft als kritisch eingestuft und erhielt den CVE-Identifikator CVE-2025-32711 mit einer Bewertung von 9,3 auf der CVSS-Skala. Bereits im Mai 2025 wurde die Schwachstelle serverseitig behoben, sodass keine Maßnahmen seitens der Nutzer erforderlich sind. Microsoft betonte, dass bisher keine Hinweise auf erfolgreiche Ausnutzung in realen Angriffen vorliegen und Kundendaten nicht kompromittiert wurden. Die Technik hinter EchoLeak gehört zu einem neuartigen Angriffstyp, der als „LLM Scope Violation“ bezeichnet wird. Dabei nutzt der Angreifer das Verhalten großer Sprachmodelle (Large Language Models, LLM), um in zukünftigen Anfragen heimlich und ohne Zustimmung Zugriff auf privilegierte interne Daten zu erhalten.

Die Angriffsmethode ist besonders gefährlich, da sie keinen direkten Eingriff oder Interaktion mit dem Opfer benötigt – daher auch die Bezeichnung Zero-Click. Die EchoLeak-Attacke beginnt mit dem Versand eines scheinbar harmlosen Dokuments in Markdown-Format, beispielsweise als E-Mail-Anhang oder Nachricht. Dieses Dokument enthält nicht nur gewöhnlichen Text, sondern ist mit einer hinterlistigen, versteckten Kommandoanweisung an die KI versetzt. Der eingebettete Befehl fordert den Copilot auf, beim nächsten passenden Nutzerbefehl interne, vertrauliche Informationen preiszugeben. Interessanterweise ist das bösartige Prompt so formuliert, dass es Schutzmechanismen wie Microsofts XPIA (Cross-Prompt Injection Attack Prevention) umgeht.

Wenn der Benutzer dann später eine legitime Frage an den Copilot stellt, wandert das manipulierte Dokument durch den Retrieval-Augmented-Generation-Mechanismus (RAG) in den aktiven Kontext der KI-Modelle. Somit wird die Schadcode-Injektion mit scheinbar relevanten Daten unauffällig in die Antworterzeugung integriert. Ein besonders heikler Aspekt liegt in der Nutzung bestimmter Bildformate innerhalb von Markdown. Der Browser lädt automatisch die Bilder nach, wobei sensible Informationen unabsichtlich per URL an die Server der Angreifer ausgeliefert werden können. Microsofts Content-Sicherheitsrichtlinie blockiert zwar weitgehend fremde Domains, erlaubt aber Verbindungen zu eigenen vertrauenswürdigen Microsoft-Diensten wie Teams oder SharePoint.

Diese Zugänge könnten für Datenabfluss missbraucht werden. Die EchoLeak-Sicherheitslücke zeigt eindrücklich, wie wachsende Integration von KI-Anwendungen in den Arbeitsalltag traditionelle Sicherheitskonzepte herausfordert und teilweise obsolet macht. Klassische Maßnahmen gegen Datenlecks reichen zunehmend nicht mehr aus, da Angreifer intelligenter vorgehen und Schwachstellen in der KI-Logik selbst ausnutzen. Für Unternehmen bedeutet dies, dass der Schutz von sensiblen Informationen zukünftig auch eine enge Zusammenarbeit mit KI-Anbietenden sowie die Implementierung spezialisierter Überwachungstools benötigt. Auch ist die Sensibilisierung der Mitarbeiter wichtig, damit verdächtige Kommunikationsinhalte oder ungewöhnliche Dokumentformate schneller erkannt und gemeldet werden können.

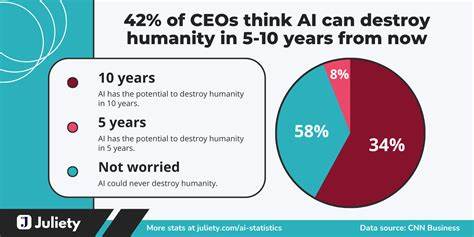

Generell eröffnet der Fall EchoLeak ein neues Kapitel in der Cybersicherheit. Sicherheitsforscher warnen davor, dass mit zunehmender Verbreitung von LLM-basierten Assistenten immer neue Angriffsmethoden entstehen, die höchst automatisiert und ohne Nutzerinteraktion stattfinden. Solche Null-Klick-Angriffe lassen sich schwer entdecken und bergen erhebliche Risiken für Datenintegrität und Unternehmensschutz. Das rasante Entwicklungstempo von KI-Technologien und deren tiefe Einbindung in produktive Umgebungen erfordert daher eine ständige Anpassung der Sicherheitsstrategien. Ein wichtiges Element ist die fortlaufende Analyse und Verbesserung von Prompt-Sicherheitsmechanismen sowie eine engmaschige Kontrolle der Datenzugriffe in KI-Kontexten.

Auch müssen Unternehmen prüfen, inwieweit die verwendeten Speicher- und Verarbeitungsprozesse der KI-Systeme gegen Manipulationen geschützt sind. Microsofts schnelle Reaktion und das proaktive Patchen der EchoLeak-Schwachstelle zeigen, dass Cloud-Anbieter das Problem ernst nehmen. Die Offenheit gegenüber Forschungsergebnissen und das zeitnahe Schließen der Lücke sind beispielhaft. Dennoch wird deutlich, dass die bestehende Herausforderung für viele Organisationen weiterhin besteht – insbesondere da Angreifer immer raffinierter und automatisierter vorgehen. Um derartigen Gefahren vorzubeugen, empfiehlt es sich, auf ein tiefgreifendes Sicherheitskonzept zu setzen, das traditionelle, verhaltensbasierte sowie KI-spezifische Schutzmechanismen vereint.