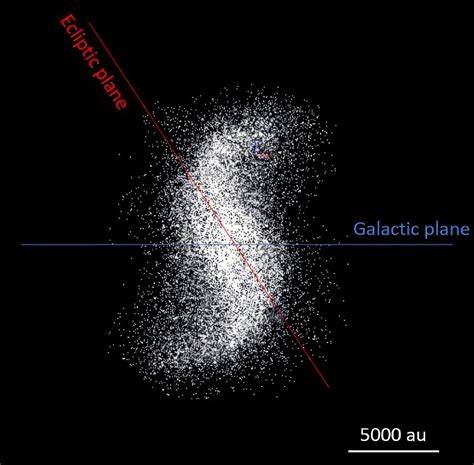

In den letzten Jahren zeichnet sich eine besorgniserregende Entwicklung in der wissenschaftlichen Publikationslandschaft ab: Die Zahl minderwertiger Forschungsarbeiten steigt deutlich an, wobei vor allem öffentlich zugängliche Datensätze und moderne künstliche Intelligenz (KI) eine Schlüsselrolle spielen. Diese Tendenz bildet nicht nur eine Bedrohung für die Qualität der wissenschaftlichen Literatur, sondern untergräbt auch das Vertrauen in Forschungsprozesse und Ergebnisse. Eine besonders auffällige Quelle für diese Flut an schlechten Studien ist der National Health and Nutrition Examination Survey (NHANES), ein umfassender, öffentlicher Datensatz aus den USA. NHANES sammelt seit Jahrzehnten Gesundheits- und Ernährungsdaten von mehr als 130.000 Menschen, um Erkenntnisse über Zusammenhänge zwischen Umweltfaktoren, physiologischen Bedingungen und gesundheitlichen Outcomes zu generieren.

Trotz der ohnehin komplexen Herausforderungen bei der Interpretation solcher Daten hat sich gezeigt, dass dieser Datensatz in den letzten Jahren verstärkt von sogenannter „Low-Quality“-Forschung zweckentfremdet wird. Der Ursprung dieses Problems liegt in einer Art „Forschungsspielzeug“, das sich immer größerer Beliebtheit bei Paper Mills, also unseriösen Unternehmen, die gegen Bezahlung wissenschaftliche Artikel erstellen, erfreut. Sie nutzen NHANES als Fundus, um nach standardisierten Mustern simplifizierte Assoziationsstudien zu erstellen. Dazu wählen sie einfach einen Gesundheitsfaktor, eine potenzielle Einflussgröße und eine Zielpopulation aus und präsentieren diese Kombination als vermeintlich neue Erkenntnis. Aufgrund der schieren Größe und Vielschichtigkeit des Datensatzes ist es möglich, zahllose Varianten solcher Studien durchzuführen, was eine enorme Menge an Veröffentlichungen ermöglicht – häufig mit fragwürdigem wissenschaftlichen Mehrwert.

Ein weiterer Treiber dieser Entwicklung ist der Siegeszug von KI-Sprachmodellen wie ChatGPT. Diese Tools erleichtern es, wissenschaftliche Texte schnell und scheinbar kohärent zu formulieren. Die Folge ist eine Flut von Studien, die sprachlich professionell wirken, jedoch inhaltlich oft repetitiv oder sogar hohl sind. Durch variierte Formulierungen können Autoren zudem Plagiatserkennungssoftware umgehen, was es besonders Paper Mills erleichtert, solche Manuskripte massenhaft zu erstellen. Die Explosion der Veröffentlichungen mit NHANES-Daten trat besonders seit 2022 ein.

Während der jährliche Output zwischen 2014 und 2021 im Durchschnitt nur bei wenigen Artikeln lag, stieg die Zahl der Studien, die einfache Assoziationen analysieren, innerhalb kürzester Zeit exponentiell an. Auffallend ist zudem, dass der Großteil dieser Arbeiten seit 2021 von Autoren mit chinesischer Institutionenzugehörigkeit stammt. Experten vermuten, dass der hohe Publikationsdruck und die Belohnungsmechanismen im akademischen System Chinas den Einsatz von Paper Mills begünstigen. Neben der Quantität haben sich auch Qualitätsprobleme manifestiert. Viele Studien weisen eine selektive Auswahl von Daten vor, indem sie etwa nur bestimmte Erhebungsjahre oder Altersgruppen analysieren, ohne eine wissenschaftlich fundierte Begründung dafür zu liefern.

Diese „Datenschöpferei“ wird häufig eingesetzt, um statistisch signifikante Ergebnisse zu erzielen – ein klassisches Beispiel für sogenanntes „P-Hacking“. Solche Vorgehensweisen erhöhen das Risiko von Fehlinterpretationen und falschen Entdeckungen, die dem wissenschaftlichen Fortschritt eher schaden als nützen. Insbesondere bei sensiblen Themen wie psychischen Erkrankungen treten diese Fehler deutlich hervor. Untersuchungen zeigten, dass viele veröffentlichte Studien, die Zusammenhänge zwischen Vitamin D oder Zahngesundheit mit Depressionen oder Diabetes untersuchten, ihre Ergebnisse ohne adäquate statistische Korrekturen präsentierten. Nach Berücksichtigung solcher Korrekturen blieb die Aussagekraft vieler Befunde gering, was Zweifel an ihrer Validität aufkommen lässt.

Für wissenschaftliche Verlage und Fachjournalisten entsteht hierdurch eine enorme Herausforderung. Springer Nature und die BMJ Group, die einige der betroffenen Publikationsorgane herausgeben, haben bereits mit Rücknahmen von problematischen Artikeln reagiert und stärken intern die Prüfung und Sensibilisierung ihrer Gutachter und Redakteure. Dennoch zeigt die Problematik, dass das bestehende System der Qualitätssicherung – insbesondere bei Open-Access-Journalen, die Autorengebühren erheben – an seine Grenzen stößt und noch mehr Aufmerksamkeit und Weiterentwicklung benötigt. Ein Grundproblem ist jedoch das grundlegende Anreizsystem in der akademischen Forschung: Forscher werden nach der Anzahl ihrer Publikationen bewertet und belohnt, weniger nach der tatsächlichen wissenschaftlichen Relevanz oder Reproduzierbarkeit ihrer Arbeiten. Dies schafft einen Markt für „schnelle“ Veröffentlichungen, auch wenn deren Inhalt nur oberflächlich ist oder gar keinen echten Beitrag liefert.

Solange diese Dynamik anhält, können neue Technologien wie KI und zugängliche Datenquellen ganz bewusst oder unbewusst missbraucht werden. Die technische Seite zeigt, wie leicht zugänglich und automatisierbar die Datenverarbeitung geworden ist. Dank leistungsfähiger Programmiersprachen wie Python oder R kann man große Datensätze schnell auslesen und systematisch kombinieren, was ideal für „datengestützte“ Massenstudien ist. Ohne fundierte Analyse und kritische Auswertung kann dies jedoch zur bloßen Datenmüllproduktion führen. Neben NHANES sind weitere große Gesundheitsdatensätze wie der Global Burden of Disease oder die National Inpatient Sample ebenfalls potenziell betroffen.

Diese Datenbanken bieten Wissenschaftlern und Politikern unverzichtbare Informationen, doch die Gefahr der Überflutung mit unzuverlässigen Studien erfordert Maßnahmen zur besseren Kontrolle und besseren Wissenschaftskommunikation. Für die wissenschaftliche Gemeinschaft ist es wichtig, Bewusstsein für diese Problematik zu schaffen und neue Standards für Datennutzung sowie Transparenz bei Forschungsdesign und Methodik zu etablieren. Förderinstitutionen und Universitäten sollten Anreizsysteme überdenken, um Qualität über Quantität zu stellen. Gleichzeitig sind Journalredaktionen gefragt, kritischer und tiefgehender bei der Begutachtung zu sein, insbesondere wenn Studien aus öffentlichen Datenquellen stammen und breite Assoziationen analysieren. Darüber hinaus könnten automatisierte Tools entwickelt werden, die Redundanzen und auffällige Muster in Manuskripten erkennen, um potenzielle Paper-Mill-Arbeiten früh zu identifizieren.

Ein koordiniertes Vorgehen zwischen Verlagen, Datenanbietern und Forschergemeinschaften ist notwendig, um die Integrität der wissenschaftlichen Literatur zu bewahren. Innovative Ansätze, etwa die verstärkte Nutzung von Open-Data-Prinzipien kombiniert mit offenen Peer-Review-Verfahren und der Veröffentlichung von Rohdaten und Quellcode, können Transparenz schaffen und Vertrauensbildung fördern. Eine stärkere Integration von statistischer Beratung bei der Datenanalyse sowie Schulungen zum verantwortungsvollen Umgang mit großen Datensätzen sind weitere Schlüsselelemente. Die zunehmende Verfügbarkeit von KI-Technologien bietet gleichzeitig Chancen und Risiken. Künftig sollten KI-Systeme gezielt darauf programmiert werden, nicht nur sprachlich ansprechende Texte zu erstellen, sondern auch die wissenschaftliche Rigorosität zu unterstützen – zum Beispiel durch Unterstützung bei der Datenvalidierung oder der Erkennung von halbautomatischem P-Hacking.

Insgesamt erfordert die wachsende Flut minderwertiger Forschungsartikel durch die Kombination von öffentlichen Datensätzen und KI eine ganzheitliche Reaktion vom individuellen Forscher bis hin zur globalen Forschungsinfrastruktur. Nur durch gemeinsame Anstrengungen können Wissenschaft, Politik und Gesellschaft sicherstellen, dass wertvolle Daten für echte Erkenntnisse genutzt werden und die Wissenschaftsgemeinschaft ihre Glaubwürdigkeit behält. Die Zukunft der Forschung hängt entscheidend davon ab, wie schnell und effektiv diese Herausforderungen angenommen und bewältigt werden, um eine Wissenschaft zu fördern, die transparent, verlässlich und aussagekräftig ist – frei von Massen an nutzlosen oder irreführenden Studien.