Sprachmodelle haben in den letzten Jahren enormes Interesse und Aufmerksamkeit auf sich gezogen, nicht zuletzt aufgrund ihrer beeindruckenden Fähigkeiten im Verstehen, Verarbeiten und Erzeugen von natürlicher Sprache. Hinter diesen Fähigkeiten steckt jedoch komplexe Technologie und ausgeklügelte Mechanismen, die oft im Hintergrund arbeiten. Einer dieser entscheidenden Mechanismen ist der sogenannte Gather-and-Aggregate-Mechanismus, der eine Schlüsselrolle bei der Kontextverarbeitung innerhalb von Sprachmodellen einnimmt. Im Kern beschreibt er einen zweistufigen Prozess, bei dem relevante Informationen aus einem gegebenen Kontext extrahiert und anschließend zu einer kompakten, interpretierbaren Repräsentation zusammengeführt werden. Während Transformers und State-Space-Modelle (SSMs) oft als konkurrierende Architekturen betrachtet werden, zeigt die Untersuchung dieses Mechanismus, dass beide ähnliche Strategien verfolgen.

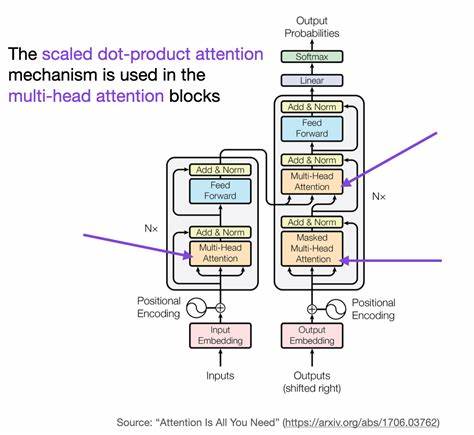

Die Bedeutung des Gather-and-Aggregate-Mechanismus wird vor allem im Umgang mit langen oder komplexen Eingabesequenzen sichtbar. Sprachmodelle stehen vor der Herausforderung, relevante Informationen aus großen Kontextfenstern zu identifizieren, um präzise Vorhersagen oder Antworten zu generieren. Dies ist besonders wichtig, wenn das Modell algorithmische Aufgaben oder Wissensabfragen lösen soll, bei denen exakte Informationen aus der Vergangenheit oder dem Kontext wieder abgerufen werden müssen. Hier zeigt sich, dass die Fähigkeit, Informationen effektiv zu sammeln (Gather) und anschließend zu verdichten (Aggregate), entscheidend für die Leistungsfähigkeit der Modelle ist. Transformer-Modelle sind bekannt für ihre Aufmerksamkeitsschichten, die es ermöglichen, unterschiedliche Teile des Eingabekontexts dynamisch zu gewichten.

Innerhalb dieser Aufmerksamkeitsschichten konzentriert sich der Gather-and-Aggregate-Mechanismus auf bestimmte Köpfe, die als 'Gather Heads' und 'Aggregate Heads' bezeichnet werden. Diese Köpfe sind speziell dafür verantwortlich, relevante Tokens zu identifizieren und die herausgefilterten Informationen zu einer kompakten Repräsentation zusammenzuführen, welche dann für die nächsten Verarbeitungsschritte genutzt wird. Studien haben gezeigt, dass diese Köpfe als kritische Engpässe fungieren können. Das bedeutet, wenn einer dieser Köpfe deaktiviert wird, verschlechtert sich die Leistung des Modells dramatisch. Beispielsweise konnte bei einem pruned Llama-3.

1-8B Modell durch das Deaktivieren eines einzigen Gather- oder Aggregate-Kopfes die Genauigkeit bei der MMLU-Bewertung (Massive Multitask Language Understanding) von 66% auf das Niveau von reinem Zufall (25%) sinken. Dies unterstreicht, wie essenziell diese Köpfe für präzises Abrufen von Wissen sind. Bei State-Space-Modellen, die als effiziente Alternative zu Transformers für die Verarbeitung besonders langer Sequenzen gelten, gibt es ebenfalls eine ähnliche Struktur. Obwohl SSMs einen fixierten, recurrenten Zustand verwenden, stoßen sie an Grenzen bei Aufgaben, die ein exaktes Wiederfinden von Kontextinformationen erfordern. Hier zeigen sich im Gather-and-Aggregate-Mechanismus Unterschiede in der Ausprägung der Aufmerksamkeitsmuster.

Während Transformer-Modelle scharfe und klare Übergänge zwischen Tokens realisieren, neigen SSMs dazu, glattere und allgemeinere Aufmerksamkeitsmuster zu entwickeln. Diese weniger fokussierten Muster erschweren die präzise Informationsbeschaffung, was wiederum erklärt, warum SSMs bei bestimmten Benchmark-Aufgaben wie GSM8K (mathematische Problemstellungen), BBH (Benchmarking für komplexe Fähigkeiten) und Dialogverständnis oft hinter Transformern zurückbleiben. Die Erkenntnis, dass die Transformation und Aggregation von Informationen auf eine kleine Anzahl von Köpfen konzentriert ist, eröffnet neue Dimensionen für das Modell-Design. Ein wichtiges Resultat ist die Entwicklung von hybriden Modellen, die die Stärken beider Architekturen vereinen. Indem man in ein vortrainiertes SSM einige Aufmerksamkeitsschichten integriert und so die Rolle der Aggregate Heads teilweise durch Aufmerksamkeit übernimmt, lassen sich signifikante Verbesserungen bei der Kontextwiederherstellung und Aufgabenleistung erzielen.

Ebenso zeigt sich, dass das Ersetzen einzelner Gather-and-Aggregate-Köpfe in SSM durch Varianten mit Aufmerksamkeit die Retrieval-Fähigkeiten des Modells steigert und somit Leistungswerte in Benchmarks erhöht. Diese Forschungsergebnisse werfen auch ein neues Licht darauf, wie Wissensabruf innerhalb von Sprachmodellen eigentlich funktioniert. Oft wird angenommen, dass die Fähigkeit eines Modells stark von der Größe seiner Parameterbasis oder seinem Training auf riesigen Korpora abhängt. Doch zeigt sich durch die Analyse der Gather-and-Aggregate-Köpfe, dass es gerade diese fokussierten Informationsengpässe sind, die den entscheidenden Unterschied machen. Das bedeutet, dass nicht das gesamte Modell gleichmäßig zur Informationsverarbeitung beiträgt, sondern wenige spezialisierte Komponenten den Kern der inhaltlichen Verarbeitung bilden.

Weiterhin eröffnet das Verständnis dieses Mechanismus auch Chancen, bestehende Modelle effizienter und skalierbarer zu gestalten. Da Gather- und Aggregate-Köpfe wie Flaschenhälse wirken, kann die gezielte Optimierung oder Modifikation dieser Komponenten dazu führen, dass Modelle mit geringerer Gesamtkomplexität dieselbe oder sogar eine bessere Leistung erzielen. Dies ist besonders relevant, wenn es darum geht, Modelle für spezialisierte Einsatzzwecke oder ressourcenbegrenzte Umgebungen zu optimieren. Neben der architektonischen Bedeutung hat der Gather-and-Aggregate-Mechanismus auch Implikationen für die Interpretierbarkeit von Sprachmodellen. Da diese Köpfe klar identifizierbar sind und exakt definierte Aufgaben im Kontextmanagement übernehmen, können Forscher und Entwickler besser nachvollziehen, wie und warum Modelle bestimmte Kontextinformationen priorisieren oder vernachlässigen.

Dieses Wissen kann wiederum genutzt werden, um unerwartetes Verhalten oder Fehlerquellen im Modell gezielt zu adressieren. Zudem lässt die Fokussierung auf wenige Köpfe auch neue Ansätze für Modellentdeckung und -analyse zu. Beispielsweise können Techniken zur Pruning oder zum gezielten Fine-Tuning an den Gather- und Aggregate-Köpfen angewandt werden, um Modelle leichter an unterschiedliche Aufgabenprofile anzupassen, ohne zeitaufwändige Kompletttrainings durchlaufen zu müssen. Die Flexibilität entsteht daraus, dass diese Köpfe als zentrale Informations-Engpässe fungieren und somit minimalen Anpassungsaufwand mit maximalem Effekt ermöglichen. Abschließend zeigt die Erforschung des Gather-and-Aggregate-Mechanismus, dass er eine fundamentale Rolle für das Verständnis, die Leistungssteigerung und die Weiterentwicklung von Sprachmodellen spielt.

Dieses Verhältnis zwischen relevanter Informationsselektion und deren Integration in eine kohärente Repräsentation ist die Grundlage für erfolgreichen Kontextabruf und präzise Sprachverarbeitung. Angesichts der zunehmenden Bedeutung von KI-Systemen in vielen Lebensbereichen ist das Vertiefen unseres Verständnisses dieser Mechanismen nicht nur aus wissenschaftlicher Perspektive, sondern auch für praktische Anwendungen elementar. Die Zukunft der Sprachmodellentwicklung wird wohl stark davon beeinflusst sein, wie effektiv Gather-and-Aggregate-Mechanismen implementiert und optimiert werden. Durch hybride Ansätze, die die Vorteile von Transformer-Aufmerksamkeit mit der Effizienz von State-Space-Modellen kombinieren, könnten neue Generationen von Modellen entstehen, die sowohl leistungsfähig als auch ressourceneffizient sind. So könnten diese Innovationen dazu beitragen, KI-Technologien zugänglicher und praktischer für unterschiedlichste Anwendungsfälle zu machen, von der Kundenbetreuung über medizinische Diagnosen bis hin zur wissenschaftlichen Forschung.

Insgesamt bildet der Gather-and-Aggregate-Mechanismus ein zentrales Element moderner Sprachmodellarchitekturen, dessen tiefere Erforschung nicht nur aktuelle Leistungsgrenzen überwindet, sondern auch den Weg für zukünftige Durchbrüche in der natürlichen Sprachverarbeitung ebnet.