Die rasante Entwicklung im Bereich der Künstlichen Intelligenz hat die Welt des Programmierens maßgeblich verändert. Künstliche Intelligenzen übernehmen immer mehr Aufgaben, von simplen Code-Snippets bis hin zu komplexen Spiel-Engines. In diesem Kontext stehen drei große Namen im Fokus: Claude 4 Opus von Anthropic, Gemini 2.5 Pro von Google DeepMind und OpenAI o3. Diese Modelle gelten als die Flaggschiffe der heutigen Generation und konkurrieren direkt um die Vorherrschaft in der KI-gestützten Programmierung.

Aber welches Modell überzeugt wirklich in der Praxis, insbesondere wenn es um anspruchsvolle Coding-Aufgaben geht? Claude 4 Opus, das jüngste Modell aus dem Hause Anthropic, hat in den letzten Monaten viel Aufmerksamkeit erhalten. Es gilt als das leistungsstärkste Modell im Bereich des Codings. Anthropic beschreibt Opus als eine KI, die kontinuierlich etwa sieben Stunden lang auf dem Niveau eines erfahrenen Softwareentwicklers programmieren kann. Zudem bietet es einen Kontextfenster von rund 200.000 Token, was für die meisten Programmieraufgaben mehr als ausreichend ist.

Im SWE-Benchmark erzielt Claude 4 Opus eine beeindruckende Punktzahl von 72,5 Prozent, die mit Paralleltest-Optimierungen sogar auf bis zu 79,4 Prozent steigen kann. Bemerkenswert ist auch der um 65 Prozent geringere Anteil an „Hacky“- oder Abkürzungsmethoden, die oft zu qualitativ minderwertigem Code führen. Opus punktet nicht nur mit technischer Exzellenz, sondern auch mit einer angenehm „menschlichen“ Persönlichkeit, was die Zusammenarbeit mit dem Modell besonders macht. Im Gegensatz dazu hat Gemini 2.5 Pro als Google-DeepMind-Modell seinen eigenen Ansatz und zeichnet sich vor allem durch ein überzeugendes Preis-Leistungs-Verhältnis aus.

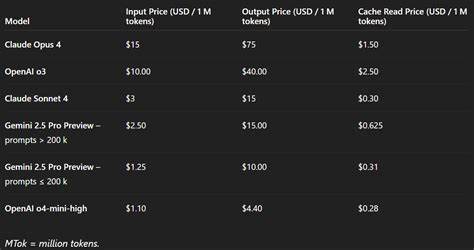

Die Preise von Gemini sind deutlich niedriger als die von Claude Opus, wodurch es für Unternehmen attraktiv erscheint, die eine kostengünstige Lösung mit guter Performance suchen. Im SWE-Benchmark erzielt Gemini 2.5 Pro eine solide Punktzahl von 63,2 Prozent, was zwar weniger als opulent erscheint, jedoch für viele Aufgaben weiterhin eine ausreichende Qualität darstellt. Gemini zeigt eine starke Kosteneffizienz, gerade wenn es um Input-Token in kleineren Mengen geht, und ist damit eine attraktive Option für Entwickler mit begrenztem Budget oder eher routinemäßigen Programmieraufgaben. OpenAI o3 bewegt sich preislich und in Sachen Performance in einer mittleren Liga.

Die Schwäche zeigt sich besonders bei komplexeren Coding-Problemen, bei denen die Ergebnisse teils nicht so überzeugend ausfallen wie bei den Konkurrenten. Im SWE-Benchmark liegt o3 bei etwa 69,1 Prozent und damit zwischen Gemini 2.5 Pro und Claude 4 Opus. Trotzdem ist die Flexibilität des Modells ein Vorteil, da es für eine Vielzahl von Aufgaben eingesetzt werden kann, nicht nur im Programmieren. Preislich ist das Modell im Vergleich zu Gemini eher hoch angesiedelt, bietet aber keine ähnlich herausragende Leistung wie Opus.

Eine spannende Möglichkeit, die Stärken und Schwächen der drei Modelle zu illustrieren, sind praktische Tests anhand herausfordernder Projekte. Eines davon war die Umsetzung einer komplexen GPU-beschleunigten Partikelsimulation mit Three.js und WebGL, bei der mehrere Morph-Targets in Echtzeit animiert werden sollten. Claude Opus zeigte dabei eine außerordentlich hochwertige Umsetzung, die nicht nur die gestellten Anforderungen erfüllte, sondern auch ästhetisch und funktional überzeugte. Die Morphs waren fließend und die gesamte UI-Kontrolle intuitiv.

Gemini 2.5 Pro konnte zwar eine funktionierende Simulation liefern, scheiterte jedoch an der Feinheit der Details, etwa bei der Formgenauigkeit der Morphs und der visuellen Aufbereitung. OpenAI o3 blieb in diesem Testumfeld klar zurück: Die Morphs verliefen nicht wie gewünscht und wirkten wenig durchdacht, die Nutzererfahrung war limitiert. Bei der Entwicklung eines Super-Mario-inspirierten 2D-Plattformspiels überzeugte Claude Opus erneut durch seine Fähigkeit, innerhalb kurzer Zeit eine voll funktionsfähige und ansprechende Anwendung zu erstellen. Das Spiel besaß flüssige Bewegungen, realistische Physik und eine ansprechende Optik, die zusammen einen nostalgischen und dennoch frischen Eindruck hinterließen.

Gemini 2.5 Pro lieferte eine funktionsfähige, aber deutlich minimalistischere Version, die zudem kleinere Fehler aufwies und daher weniger spielerisch wirkte. Beim OpenAI o3 hingegen zeigte sich deutlich, dass es eher auf Prototyp-Level blieb, das Spiel war kaum spielbar, voller Bugs und ohne echte Spielmechanik, was enttäuschend war. Ein weiterer Vergleichspunkt war ein vollwertiges Tetris-Spiel, umgesetzt in einem einzigen HTML-Dokument mit HTML5-Canvas und Vanilla JavaScript. Claude Opus überzeugte hier mit einer nahezu makellosen Realisierung, inklusive moderner Features wie Ghost-Piece, Highscore-Speicherung und sogar Hintergrundmusik.

Gemini 2.5 Pro lieferte eine ebenso solide Funktionalität ab und überraschte mit einem sehr ähnlichen Qualitätsniveau, was zeigt, dass Gemini im Bereich anspruchsvoller Single-Page-Anwendungen durchaus mithalten kann. OpenAI o3 zeigte sich auch bei Tetris eher in der Mittelklasse, mit funktionaler, aber weniger polierter Version. Der wohl beeindruckendste Test war die Entwicklung eines vollständigen Schachspiels ohne externe Bibliotheken, komplett in einem einzigen HTML-Dokument. Hier zeigte Claude Opus seine wahre Stärke, indem es eine vollständig funktionale Schach-Engine mit vollumfänglicher Zugslogik lieferte, die zwar einzelne Sonderzüge nicht abdeckte, aber insgesamt ein rundes Spielerlebnis bot.

Gemini 2.5 Pro versuchte ebenfalls, den Schachspielcode allein zu schreiben, scheiterte jedoch an der Spielestimmung: Die Figuren bewegten sich kaum, sodass das Spielerlebnis unbefriedigend war. OpenAI o3 entschied sich, auf externe Bibliotheken wie Chess.js zurückzugreifen, was grundsätzlich ein validen Ansatz ist; allerdings funktionierten diese Implementierungen nicht fehlerfrei, da die Einbindung externer Objekte fehlschlug. Aus diesen Vergleichen ergibt sich ein eindeutiges Bild: Claude 4 Opus ist der unangefochtene Spitzenreiter in puncto Qualität, Raffinesse und Zuverlässigkeit.

Es besitzt neben technischen Vorteilen auch eine charakterliche Komponente, die den Umgang mit der KI angenehm und produktiv macht. Gemini 2.5 Pro ist eine exzellente Wahl, wenn das Budget eine Rolle spielt und dennoch eine hohe Codierungsqualität erwünscht ist. OpenAI o3 wirkt im Vergleich etwas durchschnittlicher und zeichnet sich durch eine solide Allround-Performance aus, die aber bei spezifischen, komplexen Aufgaben nicht immer ausreicht. Dabei darf man nicht vergessen, dass die Preise eine wesentliche Rolle spielen.

Claude Opus ist deutlich teurer als die Alternativen, was Unternehmen mit großem Budget einen echten Vorteil verschaffen kann, aber für kleinere Projekte oder Einzelentwickler möglicherweise nicht rentabel ist. Gemini punktet durch seine günstigeren Tarife, was insbesondere bei häufigen Anfragen und großen Tokenmengen die Kosten niedrig hält. OpenAI o3 steckt preislich und in der Leistung ungefähr in der Mitte. Für Entwickler und Unternehmen, die auf der Suche nach der besten KI-Unterstützung beim Programmieren sind, zeigt sich damit das folgende Bild: Wenn Geld keine Rolle spielt und Spitzenqualität gefragt ist, ist Claude 4 Opus die erste Wahl. Wer eine kostenbewusste, aber qualitativ hochwertige Lösung sucht, sollte Gemini 2.

5 Pro in Betracht ziehen. Und wer ein vielseitiges Modell mit anständiger Leistung sucht, das auch für andere KI-Anwendungen nützlich ist, kann den Kompromiss mit OpenAI o3 eingehen. Neben den reinen Coding-Fähigkeiten spielen auch Faktoren wie Integrationsmöglichkeiten, Benutzerfreundlichkeit und Weiterentwicklung eine Rolle. Claude Opus bietet etwa eine GitHub Actions-Integration, die es erlaubt, KI-gestützte Code-Reviews und automatische Anpassungen direkt in den Entwicklungsprozess einzubauen. Solche Features erhöhen den Wert des Modells weit über die reine Codegenerierung hinaus und fördern eine engere Zusammenarbeit zwischen Mensch und Maschine.

Insgesamt zeigt der Vergleich, wie sehr sich KI-Modelle im Bereich Softwareentwicklung dramatisch weiterentwickelt haben. Während vor wenigen Jahren noch simple Automatisierungen im Vordergrund standen, bieten heutige Modelle nahezu ganze Entwicklerworkflows in sich und schaffen dabei nicht nur funktionierende, sondern auch geschmackvolle und durchdachte Lösungen. Ein schneller Blick in die Zukunft lässt vermuten, dass die Differenzierung zwischen menschlichen und KI-entwickelten Programmen zunehmend verschwimmen wird und die Zusammenarbeit noch produktiver und kreativer wird. Abschließend gilt es für Nutzer, die für sich passende KI-Lösung gemäß den eigenen Anforderungen und dem vorhandenen Budget auszuwählen. Die Innovationskraft und Qualität von Claude 4 Opus ist beispielhaft, doch auch Gemini 2.

5 Pro bietet eine beeindruckende Leistung zu vernünftigen Preisen. OpenAI o3 bleibt als flexible, solide Alternative für eine breite Palette von Anwenderfällen relevant, auch wenn es in High-End-Coding-Tests nicht an der Spitze steht. Die Entscheidung für ein Modell sollte daher nicht nur anhand der reinen Benchmarkwerte getroffen werden, sondern auch basierend auf Anwendungsfall, Kostenkalkulation und gewünschten Funktionen.