Die Welt der künstlichen Intelligenz erlebt einen bedeutenden Wandel, wenn es darum geht, große Datenmengen für das Training und die Weiterentwicklung von Sprachmodellen zu erzeugen. In jüngster Zeit dominieren große Large Language Models (LLMs) mit Milliarden von Parametern die Forschung und Anwendung, nicht zuletzt wegen ihrer beeindruckenden Fähigkeit, qualitativ hochwertige Daten zu erzeugen. Allerdings bringen solche gigantischen Modelle enorme Kosten, Umweltbelastungen und die Gefahr mit sich, Verzerrungen und Einseitigkeiten unkritisch zu übernehmen. Angesichts dieser Herausforderungen rückt eine neue Forschungsarbeit in den Fokus, die ein Koordinationsframework kleinerer LLMs vorstellt, das mit den großen Modellen in Sachen Datensynthese mithalten kann. Dieses innovative Konzept kann die Entwicklung nachhaltigerer und zugänglicherer künstlicher Intelligenz entscheidend vorantreiben.

Traditionell gelten große LLMs als unangefochten in der Datenproduktion. Sie sind jedoch ressourcenintensiv in puncto Rechenleistung und Energieverbrauch. Zudem besteht die Gefahr, dass sie die inhärenten Vorurteile ihrer Trainingsdaten unbemerkt reproduzieren, da große monolithische Modelle oft keine strukturierten Mechanismen zur Fehlerkontrolle besitzen. Im Gegensatz dazu sind kleine LLMs leichter zugänglich und schonender für die Umwelt, weisen aber einzelne Schwächen auf, wenn es um Vielfalt, Qualität und Zuverlässigkeit der generierten Daten geht. Die Forscher Xin Gao, Qizhi Pei und ihre Kollegen haben daher eine Methode entwickelt, die das Beste aus beiden Welten vereint: Sie nutzen mehrere kleine LLMs, die unterschiedliche spezialisierte Rollen übernehmen, um gemeinsam eine qualitativ hochwertige Datensynthese zu erreichen.

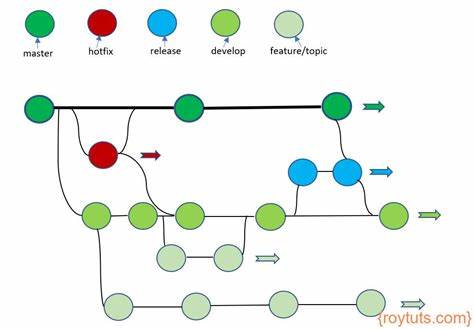

Inspiriert von menschlichen kollaborativen Prozessen wie dem Peer-Review-Verfahren in der Wissenschaft bedient sich das Framework namens GRA (Generator, Reviewer, Adjudicator) einer Arbeitsteilung, die die einzelnen Modelle in verschiedene Rollen aufteilt. Der Generator erzeugt erste Datensamples, die Reviewer bewerten diese hinsichtlich Qualität und Vielfalt, während der Adjudicator bei Konflikten entscheidet und den finalen Output bestimmt. Diese Aufteilung der Aufgaben ist ein grundlegendes Novum, da bisherige Ansätze meist auf ein einziges großes Modell setzen, das alle Schritte eigenständig ausführt. Das kombinierte Vorgehen ermöglicht es, Schwächen einzelner kleiner Modelle durch gegenseitige Kontrolle auszugleichen und so eine Effizienzsteigerung zu erzielen. Das Framework unterstreicht die Leistungsfähigkeit der Teamarbeit zwischen KI-Agenten, was teilweise mit dem Mechanismus einer menschlichen Redaktion vergleichbar ist, die Entwürfe erstellt, überprüft und für die endgültige Veröffentlichung freigibt.

Die Vorteile eines solchen kollaborativen Ansatzes liegen auf der Hand: Zum einen sinken die individuellen Anforderungen an Rechenressourcen, da keine einzelnen Modelle riesige Kapazitäten benötigen. Zum anderen erlaubt die modulare Struktur des Frameworks, einzelne Rollen gezielt zu optimieren oder Modelle auszutauschen, was Flexibilität und Anpassungsfähigkeit erhöht. Ein weiterer Pluspunkt ist die Transparenz und Fehlerkontrolle, die durch die Prüfungsschritte von Reviewer und Adjudicator besser gewährleistet werden kann. Im praktischen Test über verschiedene Benchmark-Datensätze konnte das GRA-Framework nicht nur an die Qualität großer LLMs wie Qwen-2.5-72B-Instruct heranreichen, sondern diese in einigen Fällen sogar übertreffen.

Das verdeutlicht, dass hochqualitative Datensynthese nicht zwangsläufig an monolithische Giganten gebunden ist. Diese Erkenntnisse haben weitreichende Auswirkungen auf die Entwicklung von KI-Systemen, insbesondere im Hinblick auf nachhaltige und ethische Praktiken. Forscher und Entwickler können nun kleinere Modelle in orchestrierter Weise einsetzen, um Ressourcen zu schonen, Kosten zu reduzieren und gleichzeitig auf hohem Niveau Daten zu generieren. Dies ist besonders relevant für akademische Einrichtungen und kleinere Unternehmen, die bislang durch die hohen Anforderungen großer LLMs eingeschränkt waren. Das GRA-Framework könnte zudem als Blaupause für weitere Multi-Agenten-Systeme dienen, die auf Zusammenarbeit und Spezialisierung setzen, anstatt auf eindimensionale, alles umfassende Lösungen.

Ein weiterer spannender Aspekt betrifft die mögliche Reduktion von Bias und Fehlinterpretationen. Durch die Prüfung der Datenentwürfe durch mehrere Modelle in unterschiedlichen Rollen wird potenziell eine bessere Qualitätssicherung und Vielfalt erreicht. Kollaborative Systeme könnten so als natürlicher Filter gegen verzerrte oder einseitige Outputs dienen. Neben der technischen Innovation zeigt das Konzept von Xin Gao und seinem Team auch ein gesellschaftliches Potenzial: Es beleuchtet Parallelen zur menschlichen Zusammenarbeit in Wissenschaft und Kreativität und setzt ein Zeichen dafür, dass künstliche Intelligenz ihr Potenzial am besten in kooperativer Teamarbeit entfaltet. Absehbar ist, dass Multi-Agenten-Koordinationen verstärkt in verschiedensten Anwendungsbereichen Einzug halten werden.

Die Datensynthese ist dabei nur ein Beispiel, in dem kleinere, mehrere aufgabenfokussierte KI-Modelle zusammengewirkt haben. Dieser Trend könnte insbesondere für das maschinelle Lernen, die natürliche Sprachverarbeitung und andere Bereiche der künstlichen Intelligenz eine neue Ära einläuten, basierend auf Dezentralisierung, Modularität und Zusammenarbeit. Darüber hinaus ist wichtig zu erwähnen, dass die Forscher ihre Datensätze, Modelle und den Code öffentlich verfügbar machen. Diese Offenheit erleichtert den Zugang zur Technologie und ermöglicht eine breitere wissenschaftliche und praktische Nutzung sowie Weiterentwicklung. Damit wird eine mögliche Barriere für kleinere Forschungsteams reduziert und der Weg für innovative Anwendungen geebnet.

Insgesamt stellt das Forschungswerk eine bedeutende Herausforderung der bisherigen Dominanz großer LLMs dar und öffnet den Blick für nachhaltigere, flexibel skalierbare und qualitativ hochwertige Alternativen. Die Kombination von spezialisierten kleinen Modellen in einem durchdachten Koordinationsframework könnte künftig das Rückgrat der Entwicklung künstlicher Intelligenz bilden und zu einer demokratischeren Verteilung der technologischen Möglichkeiten führen. Die Zukunft der KI-gestützten Datensynthese liegt möglicherweise weniger in immer größeren Modellen, sondern verstärkt in koordinierten Kollaborationen kleinerer Agenten, die sich gegenseitig ergänzen und gemeinsam zu besseren Ergebnissen gelangen. Diese innovativen Ansätze sind ein vielversprechender Schritt auf dem Weg zu umweltfreundlicheren, effizienteren und ethisch verantwortungsvolleren KI-Systemen.