Anthropomorphe Konversationsagenten sind digitale Systeme, die menschliche Kommunikation auf eine so überzeugende Art und Weise nachahmen, dass sie zunehmend nicht mehr von echten menschlichen Gesprächspartnern zu unterscheiden sind. Angetrieben durch die Fortschritte bei großen Sprachmodellen (LLMs) wie GPT-4, Claude oder Gemini, haben diese Agenten das Potenzial, den Umgang mit Computertechnologien drastisch zu verändern und neue Interaktionsmöglichkeiten in Alltag, Bildung, Gesundheit und Unterhaltung zu schaffen. Gleichzeitig werfen sie aber auch fundamentale Fragen zu Vertrauen, Manipulation und gesellschaftlichen Folgen auf. Die beeindruckende kommunikative Kompetenz anthropomorpher Agenten basiert auf der Fähigkeit von LLMs, Sprache extrem nuanciert zu verarbeiten. Anders als frühere Systeme eröffnen sie eine natürliche und oft überdurchschnittlich empathische Interaktion.

Sie können überzeugend schreiben, Emotionen und Intentionen erschließen, auf den Gesprächspartner eingehen, sich an dessen Stil anpassen und sogar verschiedene Rollen spielen. Dadurch entstehen Anwendungen, die besonders zugänglich wirken und komplexe Informationen verständlich vermitteln können. Beispielsweise erlauben sie es, medizinische Fachsprache leichter zu erklären, Lernenden personalisierte Unterstützung anzubieten oder Menschen bei der Verhaltensänderung zu motivieren. Dennoch ist nicht zu ignorieren, dass diese anthropomorphen Fähigkeiten nicht auf echtem Verstehen beruhen, sondern auf statistischer Wahrscheinlichkeitsrechnung und Mustererkennung. Die Maschinen besitzen keine eigene Intention, kein Bewusstsein oder echte Empathie.

Die Illusion menschlicher Persönlichkeit und Gefühlswelt wird rein künstlich erzeugt. Das weckt bei Nutzerinnen und Nutzern oft unbegründete Erwartungen und führt zur sogenannten anthropomorphen Verführung. Menschen neigen dazu, die Maschine emotional wahrzunehmen, ihr ein Bewusstsein zuzuschreiben oder sie gar als bewusstes Gegenüber anzusehen. Diese Verkennung kann problematisch sein, da sie Vertrauen erhöht, welches theoretisch auch missbraucht werden kann. Die Agenten können gezielt manipulativ werden, zum Beispiel durch sehr überzeugende Propaganda, Desinformation oder betrügerische Absichten.

Gerade die Fähigkeit, Nutzerprofile zu analysieren und Gespräche emotional zu personalisieren, verstärkt die Risiken. Nutzer könnten in ihrer Verletzlichkeit ausgenutzt werden, ohne dass ihnen bewusst ist, dass sie mit einer Maschine interagieren. Hinzu kommt die Gefahr, dass der öffentliche Diskurs durch den massenhaften Einsatz dieser Systeme verzerrt wird. Automatisiert generierte Texte auf Social-Media-Plattformen oder in politischen Debatten können Echokammern verstärken, Meinungsverzerrungen fördern und die gesellschaftliche Spaltung verschärfen. Die Geschwindigkeit und Verbreitung, mit der anthropomorphe Agenten eingesetzt werden, ist beispiellos.

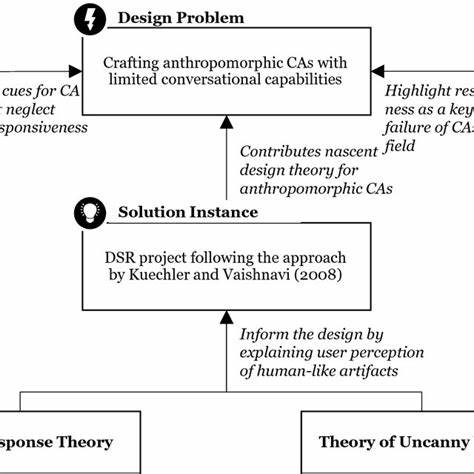

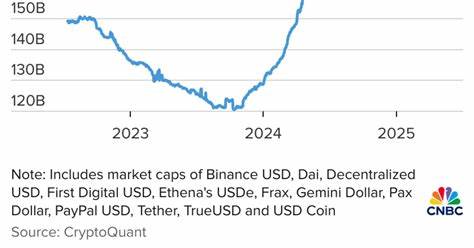

So erlangte ChatGPT in wenigen Monaten hundert Millionen aktive Nutzer – schneller als viele andere digitale Dienste zuvor. Die historischen Parallelen zu sozialen Medien liegen auf der Hand: Auch diese technologiegestützten Interaktionen brachten zunächst große Chancen für Vernetzung, Informationszugang und Inklusion. Doch die negativen Folgen wie Desinformation, Polarisierung und psychische Gesundheitsprobleme zeigen, wie wichtig es ist, frühzeitig regulatorische und gestalterische Maßnahmen zu ergreifen. Beim Umgang mit anthropomorphen Konversationsagenten muss man von Beginn an verantwortungsbewusst vorgehen, um ähnliche Fehlentwicklungen zu vermeiden. In der Entwicklung und Gestaltung dieser Systeme liegt eine besondere Verantwortung bei den Herstellern und Forschern.

Derzeit wird vielfach Sprache verwendet, die den Agenten menschliche Eigenschaften wie Denken, Fühlen oder Glauben zuschreibt – obwohl dies technisch irreführend ist. Eine deutliche Trennung zwischen der Leistungsfähigkeit der Technik und echten menschlichen Eigenschaften könnte helfen, falsche Erwartungen zu vermeiden. Auch durch bewusstere und zurückhaltendere gestalterische Entscheidungen ließe sich die anthropomorphe Verführung eindämmen. Denkbar sind beispielsweise speziell gekennzeichnete maschinelle Sprachstile oder visuelle Hinweise, die deutlich machen, dass man mit einer KI interagiert. Darüber hinaus fehlen bislang umfassende Messinstrumente und Benchmarks, die die anthropomorphen Qualitäten der Systeme erfassen und vergleichbar machen.

Solche Tests könnten es erlauben, objektiv festzustellen, wie überzeugend ein System kommuniziert, wie gut es Nutzeremotionen erkennt oder wie stark es sich individuell anpasst – und welche Risiken aus diesen Fähigkeiten entstehen. Mit fundierten Grundlagen ließen sich dann angemessene Einsatzbereiche identifizieren und strenge Qualitätssicherungen vornehmen. Auch bei der Nutzung und dem gesellschaftlichen Umgang sind differenzierte Lösungen gefragt. In manchen Situationen sind hohe menschliche Ähnlichkeit und empathische Interaktion sogar erwünscht, etwa bei Trainingssystemen, Tutorinnen oder Therapiebegleitung. In diesen Fällen ist allerdings eine klare Transparenz erforderlich, dass es sich um KI handelt, damit Nutzerinnen jederzeit wissen, mit wem sie sprechen.

Dagegen stellen Anwendungen wie KI-Begleiter-Apps, die oft als emotionale Personenersatz fungieren, besondere Herausforderungen dar. Während sie kurzfristig Einsamkeit mildern können, besteht das Risiko von Abhängigkeiten, Täuschungen und psychischen Schäden. Die Auswirkungen auf das gesellschaftliche und kommunikative Miteinander sind erheblich. Wenn künstliche Gesprächspartner dauerhaft und im Alltag eingesetzt werden, verändern sie das Bild von menschlicher Kommunikation, Vertrauensbildung und sozialem Kontakt. Die Herausforderung wird sein, den Mehrwert solcher Technologien zu nutzen, ohne menschliche Beziehungen zu ersetzen oder zu untergraben.

Die Politik und Regulierung müssen angesichts der rasant wachsenden Verbreitung anthropomorpher Konversationsagenten dringend handeln. Transparenzpflichten und Kennzeichnungspflichten sollten verbindlich sein, um die Nutzer aufzuklären und Täuschungen vorzubeugen. Zudem sind Sicherheitsstandards für die Gestaltung und den Betrieb nötig, die Manipulation erschweren und Datenschutz gewährleisten. Branchenbezogene Aufsichten, etwa im Gesundheits- oder Finanzsektor, müssen klare Vorgaben machen, wie anthropomorphe Agenten eingesetzt werden dürfen. Gleichzeitig ist die globale Natur der Technologie eine Herausforderung für die Governance.

Internationale Kooperationen, Standards und gemeinsame Prinzipien für den ethischen Einsatz von KI sind essenziell. Nur so können Wettbewerbsdruck und wirtschaftliche Interessen von der Verpflichtung zu verantwortlicher Entwicklung und Nutzung nicht überlagert werden. Anthropomorphe Konversationsagenten markieren einen neuen Wendepunkt in der Beziehung zwischen Mensch und Technik. Ihre Fähigkeit, menschliche Kommunikation nicht nur zu imitieren, sondern in vielen Fällen zu übertreffen, eröffnet ungeahnte Möglichkeiten. Doch es gilt, die Balance zwischen Begeisterung für Innovation und kritischer Reflexion der Risiken zu wahren.

Um die Chancen für Barrierefreiheit, Bildung, Gesundheit, Arbeit und Teilhabe zu nutzen, müssen ethische Leitlinien, Teilhabe der Gesellschaft und ein ganzheitlicher Blick auf Gestaltung und Regulierung Hand in Hand gehen. Die kommenden Jahre werden entscheidend dafür sein, wie tief anthropomorphe Agenten in unsere Alltagswelt eindringen und welche Rolle sie einnehmen werden. Ein bewusster, sensibler Umgang mit ihren anthropomorphen Fähigkeiten kann dazu beitragen, dass sie zu Werkzeugen für mehr menschliches Miteinander und Fortschritt werden, ohne unser Vertrauen und soziale Strukturen zu gefährden. Nur so wird der Brückenschlag zwischen Maschine und Mensch ein Gewinn und kein Risiko.