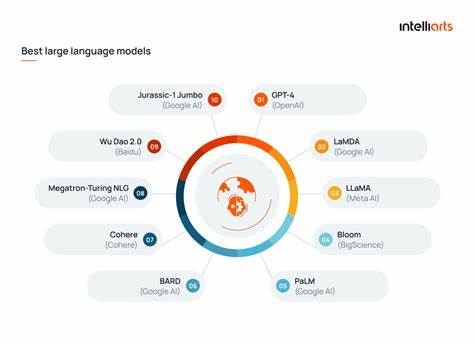

Die moderne Künstliche Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht, besonders durch die Entwicklung großer Sprachmodelle, die auf maschinellem Lernen basieren. Diese sogenannten Large Language Models (LLMs) sind darauf trainiert, menschliche Sprache zu verstehen, zu generieren und auf komplexe Weise darauf zu reagieren. Trotz ihrer Leistungsfähigkeit zeigen sie allerdings auch Fehlverhalten, das überraschende Parallelen zum menschlichen Wahrnehmungsphänomen der Pareidolie aufweist. Pareidolie bezeichnet die Neigung, in zufälligen Mustern eine bedeutungsvolle Form zu erkennen – häufig ein Gesicht. Dieses Phänomen ist seit langem Teil der menschlichen Wahrnehmung und Evolution.

Ebenso scheint es, als würden LLMs eigene Formen der Pareidolie im Umgang mit Sprache entwickeln. Menschen sind evolutionär darauf programmiert, Gesichter zu erkennen, auch wenn sie gar nicht vorhanden sind. Wenn wir in Wolken, Baumrinde oder sogar in Schatten Gesichter sehen, erlebt unser Gehirn eine Art Fehlinterpretation von optischen Signalen. Doch diese Fehlinterpretation bringt einen enormen Vorteil mit sich: Die schnelle Erkennung von Gesichtern war für das Überleben und die soziale Interaktion unverzichtbar, auch wenn man zwischendurch einige Fehlalarme hinnahm. KI-Systeme, einschließlich Fotofunktionen und Gesichtserkennung, zeigen eine ähnliche Herausforderung.

In einigen Fällen erzeugen sie „Geistergesichter“, die keine realen Gesichter sind, weil sie Teile von Bildern als solche interpretieren. Doch wie sieht das bei großen Sprachmodellen aus? Anders als Menschen analysieren LLMs nicht Bilder direkt, sondern verarbeiten Zeichenketten aus Text. Ihre Kernfunktion ist das Vorhersagen von wahrscheinlichen Folgewörtern auf Basis riesiger Texteingaben, auf denen sie trainiert wurden. Dabei entsteht eine gewisse Ähnlichkeit zu Pareidolie: Sprachmodelle neigen dazu, im Text „Sinn“ oder kohärente Muster zu erkennen oder zu generieren, selbst wenn die zugrundeliegende Information faktisch falsch oder unsinnig ist. Dies führt dazu, dass sie Aussagen produzieren können, die syntaktisch und grammatikalisch korrekt, aber inhaltlich bedeutungslos oder sogar falsch sind.

Dies wird häufig als die LLM-Form der Pareidolie beschrieben. Ein klassisches Beispiel für diese Fehlleistung ist die Antwort von Sprachmodellen auf simple Fragen wie „Wie viele i sind im Wort team?“ Menschliche Nutzer wissen, dass das Wort „team“ kein „i“ enthält. Dennoch können LLMs widersprüchliche Antworten geben, die auf der statistischen Verteilung von Texten basieren, in denen versucht wird, das sprichwörtliche „Ich im Team“ metaphorisch oder humorvoll zu erklären. Diese Interpretation ist ein Resultat des Trainings auf menschlich erzeugtem Text, der Ironie, Satire und umgangssprachliche Redewendungen beinhaltet. Die Modelle verstehen diese Nuancen jedoch oft nicht wirklich, sondern stellen lediglich Wahrscheinlichkeiten dar.

Das Problem liegt darin, dass LLMs keine echten Verstehensmechanismen besitzen, sondern rein datengetriebene Mustererkennung durchführen. Daraus folgt, dass Fehlinformationen und Ungenauigkeiten leichter durch das Modell reproduziert werden können. Menschen tendieren dazu, diese Fehler zu ignorieren oder zu korrigieren, während KI-Modelle in der Form der Pareidolie gefangen bleiben und beispielsweise erfundene Fakten, falsche Zusammenhänge oder Unsinn als plausibel erscheinen lassen. Darüber hinaus ist es bemerkenswert, wie Unternehmen wie Google versuchen, ihre KI-Technologien zwangsweise in bestehende Services zu integrieren, wie etwa bei „Gemini“. Durch das Fehlen einer wirksamen Abschaltmöglichkeit für solche KI-Funktionen fühlen sich viele Nutzer unwohl mit der Zuverlässigkeit und Genauigkeit der ausgegebenen Informationen.

Die wiederholten Fehlfunktionen erzeugen eine Vertrauenskrise gegenüber KI insgesamt. Der Vergleich mit einem Praktikanten, der bei der Zubereitung eines Tees etwas grundlegend falsch macht, verdeutlicht diese Problematik anschaulich. Es wird deutlich, dass sowohl Machine Learning als auch LLM-basierte KI noch weit davon entfernt sind, eigenständig verlässliche Resultate ohne menschliche Überprüfung zu liefern. Die menschliche Kontrolle bleibt ein unverzichtbarer Faktor, um Fehler im Output zu erkennen und zu korrigieren. KI bleibt in gewisser Weise eine leistungsfähige, wenn auch fehleranfällige Assistenztechnologie, die nur im Zusammenspiel mit dem menschlichen Urteil wirklich sinnvoll eingesetzt werden kann.

Die Offenlegung und Diskussion solcher Fehlmechanismen, wie der LLM-bedingten Pareidolie, helfen dabei, den eingeschränkten Nutzen aktueller KI-Systeme kritisch zu verstehen und nicht blind deren Ausgaben zu vertrauen. Gleichzeitig stellen sie ein Mahnmal dar, dass das Ziel echter künstlicher Intelligenz, also einer Maschine mit echtem Verständnis und rationaler Urteilskraft, noch in weiter Ferne liegt. Die Forschung und Entwicklung im Bereich der KI muss verstärkt darauf fokussieren, diese „Fehlinterpretionen“ zu minimieren, etwa durch bessere Trainingsdaten, robustere Algorithmen und multimodale Ansätze, die Text mit Kontext aus Bildern oder anderen Quellen verknüpfen. Nur so werden KI-Systeme vertrauenswürdiger werden und ein zuverlässiger Bestandteil unseres Alltags, von der Recherche bis zur kreativen Arbeit. Schlussendlich sind große Sprachmodelle beeindruckende Werkzeugmaschinen, aber eben keine allwissenden Orakel.

Das Verständnis ihrer Grenzen – allen voran der Tendenz zur Pareidolie – ist entscheidend für den verantwortungsvollen Umgang mit KI. Indem wir Mensch und Maschine partnerschaftlich kombinieren, können wir die Stärken beider Seiten nutzen, um nachhaltige, innovative und verlässliche Lösungen zu schaffen. Die Herausforderung in den kommenden Jahren wird sein, die Kluft zwischen beeindruckender Sprachverarbeitung und tatsächlichem Verstehen zu überwinden. Nur dann wird künstliche Intelligenz ihr volles Potenzial entfalten können.

![TDD, AI agents and coding with Kent Beck [video]](/images/E4EE9E66-73AC-4557-823A-749F9F60F1F3)