In der Welt der Künstlichen Intelligenz hat Azure OpenAI in den letzten Jahren große Aufmerksamkeit erlangt. Als Verbindung zwischen Microsofts Cloud-Computing-Diensten und OpenAI's leistungsstarken Modellen bietet die Plattform Entwicklern und Unternehmen eine breite Palette an Möglichkeiten, intelligente Anwendungen zu entwickeln und zu skalieren. Doch trotz der vielfältigen Vorteile treten immer wieder Herausforderungen auf, insbesondere in Bezug auf Performance und Zuverlässigkeit. Jüngste Berichte aus der Entwickler-Community weisen auf Latenzprobleme und zeitweise Ausfälle hin, die viele Nutzer vor größere Hürden stellen. Im Folgenden betrachten wir die Ursachen, Auswirkungen und mögliche Lösungsansätze für diese Probleme.

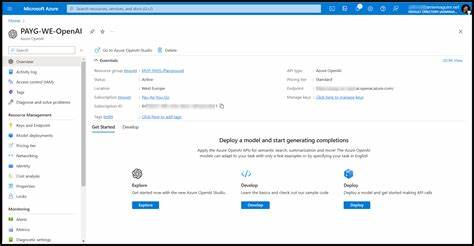

Zudem analysieren wir die Bedeutung solider Infrastruktur und API-Integration für den Erfolg von Anwendungen, die auf Azure OpenAI basieren. Azure OpenAI als zentrale Plattform für KI-Dienste ist darauf ausgelegt, skalierbare und leistungsstarke KI-Modelle über eine Cloud-Infrastruktur bereitzustellen. Besonders bei der Nutzung von fortschrittlichen Modellen wie GPT-4 und GPT-4o entstehen jedoch komplexe Anforderungen an die Backend-Systeme und die Netzwerkstabilität. Die jüngsten Meldungen über Verzögerungen und Timeouts, speziell bei GPT-4o-Modellen, verdeutlichen, dass die Plattform trotz hoher Verfügbarkeit teilweise mit Kapazitätsengpässen und Lastspitzen zu kämpfen hat. Dabei wurden Fälle dokumentiert, in denen die Statusseite des Dienstes keine Auffälligkeiten anzeigte, gleichzeitig aber Anwendungen in mehreren Abonnements und unterschiedlichen Systemen deutlich erhöhte Antwortzeiten erlebten und vereinzelt komplett ausfielen.

Die Ursachen für diese Latenzprobleme liegen häufig in einem Zusammenspiel verschiedener Faktoren. Ein wesentlicher Aspekt ist die stark gestiegene Nutzung von KI-Diensten in den letzten Monaten. Immer mehr Unternehmen setzen auf automatisierte Prozesse und intelligente Chatbots, wodurch das Anfragevolumen bei Azure OpenAI exponentiell wächst. Diese Lastspitzen können zu Überlastungen der zugrundeliegenden Infrastruktur führen, insbesondere wenn die Verteilung von Ressourcen nicht optimal erfolgt. Zudem spielt die geografische Verteilung der Rechenzentren eine Rolle – je weiter der Nutzer vom nächsten Azure-Rechenzentrum entfernt ist, desto höher ist in der Regel die Latenzzeit, mitunter verstärkt durch Netzwerkausfälle oder schlechte Routingbedingungen.

Ein weiterer kritischer Faktor betrifft die Software-Architektur und API-Gestaltung. Anfragen an Modelle wie GPT-4o sind häufig sehr komplex und benötigen erhebliche Rechenleistung. Wenn darüber hinaus mehrere Anwendungen in einem Unternehmen gleichzeitig mehrere parallele Aufrufe tätigen, steigt die Wahrscheinlichkeit von Timeouts und Verzögerungen. Gleichzeitig stellt das Pricing-Modell bei Azure OpenAI für viele Nutzer eine Herausforderung dar, da höher frequentierte API-Zugriffe zu erheblichen Kosten führen können. Dies führt zu einem Spagat zwischen Performance-Optimierung und wirtschaftlicher Nutzung der Ressourcen.

Aus Entwicklerperspektive ist eine effektive Fehlerbehandlung und Monitoring essenziell, um Ausfälle und Performance-Einbrüche frühzeitig zu erkennen und zu mitigieren. Die Implementierung eines robusten Retries-Mechanismus, gepaart mit intelligenter Lastverteilung, kann die Nutzererfahrung wesentlich verbessern. Dabei hilft es, asynchrone Anfragen und Caching-Strategien zu nutzen, um die Belastung des Systems zu reduzieren und wiederholte Abfragen effizienter zu gestalten. Ferner sollten Entwickler und DevOps-Teams eng mit dem Azure-Support zusammenarbeiten, um aktuelle Statusangelegenheiten der Plattform schnell zu klären und auf neue Updates oder Wartungen angemessen zu reagieren. Neben den technischen Herausforderungen rückt auch das Thema Datenschutz und Compliance stärker in den Fokus.

Da KI-Anwendungen häufig sensible Daten verarbeiten, ist ein stabiler und sicherer Betrieb der OpenAI-Schnittstellen für Unternehmen unerlässlich. Azure bietet hier mit seinem internationalen Compliance-Portfolio und vielfältigen Sicherheitszertifizierungen eine solide Grundlage. Nichtsdestotrotz gilt es für Organisationen, die Konfiguration ihrer KI-Anwendungen kontinuierlich zu überprüfen und Schwachstellen im Datenhandling zu beseitigen. Innovationen im Bereich der KI und Cloud-Dienste schreiten unaufhaltsam voran. Umso wichtiger ist eine vorausschauende Planung und kontinuierliche Optimierung bei der Nutzung von Plattformen wie Azure OpenAI.

Das Thema Latenz und zeitliche Verfügbarkeit von Diensten wird in den kommenden Jahren weiter an Bedeutung gewinnen, da die Ansprüche an Echtzeitverarbeitung und Nutzerfreundlichkeit steigen. Hersteller und Dienstleister sind somit gefordert, Skalierbarkeit, Transparenz und Supportstrukturen weiter auszubauen. Nutzer wiederum profitieren von stetig verbesserten Software-Tools, besseren Analyseinstrumenten und engeren Partnerschaften innerhalb der Developer-Community. Zusammenfassend lässt sich sagen, dass Azure OpenAI eine mächtige Ressource darstellt, die jedoch nicht ohne Herausforderungen ist. Latency-Probleme und Timeouts sind aktuell ein signifikantes Thema, das sowohl technische Ursachen als auch organisatorische Lösungen erfordert.

Entwickler sind gut beraten, ihre Infrastruktur und API-Nutzung kontinuierlich zu überwachen, gut mit dem Anbieter zu kommunizieren und intelligente Programmierpraktiken anzuwenden. Gleichzeitig zeigt die Situation, wie essenziell die Investition in robuste Cloud-Architekturen und KI-Entwicklung ist, um den steigenden Anforderungen gerecht zu werden. So lässt sich das volle Potenzial von Azure OpenAI nachhaltig und effektiv ausschöpfen.